Text2Tex:开创性的文本驱动3D纹理合成技术

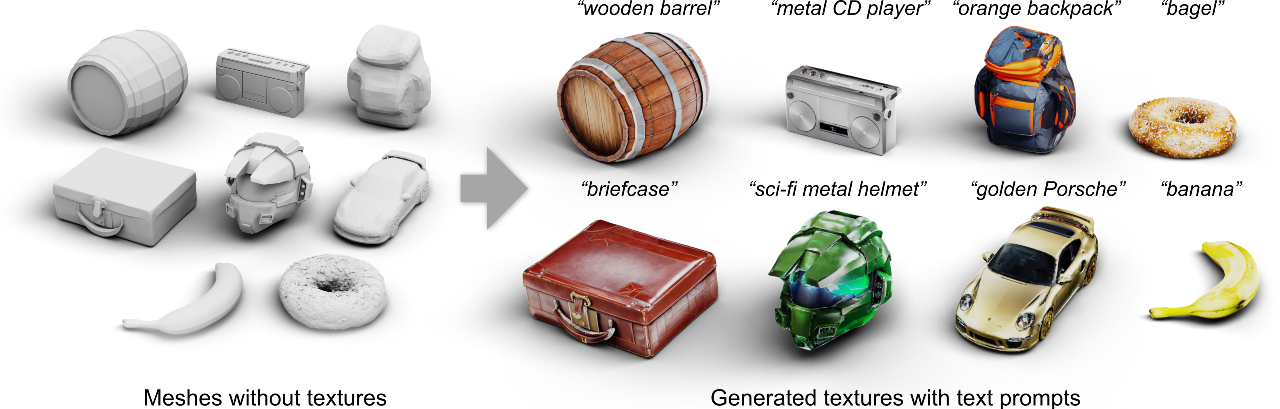

在计算机图形学和计算机视觉领域,为3D模型生成逼真的纹理一直是一个具有挑战性的任务。传统方法通常需要大量的人工干预和专业知识,难以实现高效和灵活的纹理创作。近日,来自慕尼黑工业大学和Snap研究院的研究团队提出了一种名为Text2Tex的创新方法,可以仅通过文本描述就为3D网格生成高质量纹理,为3D内容创作开辟了新的可能性。

Text2Tex的核心思想与技术创新

Text2Tex的核心思想是将文本引导的图像生成技术与3D纹理合成相结合。具体而言,该方法将修复(inpainting)技术融入预训练的深度感知图像扩散模型中,从多个视角逐步合成高分辨率的局部纹理。

为了避免跨视图累积不一致和拉伸的伪影,研究团队提出了一种动态分割渲染视图的创新方法。他们引入了"生成掩码"的概念,用于表示每个可见纹素的生成状态。这种分区视图表示可以指导深度感知的修复模型为相应区域生成和更新局部纹理。

此外,Text2Tex还提出了一种自动视图序列生成方案,用于确定更新局部纹理的最佳下一视图。这种方法可以有效地覆盖3D模型的所有表面,确保生成的纹理在整个模型上保持一致性和连贯性。

图1: Text2Tex生成的各种食物和饮料3D模型纹理示例

Text2Tex的工作流程

Text2Tex的工作流程可以概括为以下几个主要步骤:

- 输入3D网格模型和文本描述

- 从多个视角渲染3D模型

- 使用深度感知的扩散模型生成初始局部纹理

- 动态更新生成掩码,指导后续纹理生成

- 自动选择最佳下一视图进行纹理更新

- 迭代生成过程直至覆盖整个模型表面

- 后处理优化最终纹理结果

整个过程是端到端的,无需人工干预即可完成高质量纹理的生成。这大大提高了3D内容创作的效率和灵活性。

Text2Tex的实际应用效果

研究团队在多个数据集上进行了广泛的实验,以验证Text2Tex的有效性。结果表明,该方法在纹理质量、一致性和文本对齐度等方面都显著优于现有的文本驱动方法和基于GAN的方法。

图2: Text2Tex为背包3D模型生成的纹理效果

如图2所示,Text2Tex可以根据简单的文本描述(如"一个蓝色帆布背包")生成逼真而细致的纹理。生成的纹理不仅颜色和材质符合描述,还在背包的各个部位(如口袋、拉链等)呈现出合理的细节变化。这充分体现了该方法在理解文本语义和将其映射到3D几何结构上的强大能力。

Text2Tex的技术实现与环境配置

Text2Tex的代码已在GitHub上开源(https://github.com/daveredrum/Text2Tex),感兴趣的读者可以尝试复现和使用。该项目基于PyTorch实现,主要依赖包括:

- PyTorch 1.12.1

- PyTorch3D

- xformers

- ControlNet

研究团队建议使用conda创建虚拟环境,并提供了详细的环境配置说明。值得注意的是,运行Text2Tex需要至少12GB显存的NVIDIA GPU(如GeForce 2080 Ti)。

Text2Tex的应用前景与局限性

Text2Tex为3D内容创作开辟了新的可能性,其潜在的应用场景包括但不限于:

- 游戏和虚拟现实中的快速资产创建

- 电影和动画制作中的概念设计

- 产品设计和可视化

- 建筑和室内设计的材质生成

然而,Text2Tex也存在一些局限性。首先,生成的纹理质量在一定程度上依赖于输入文本的详细程度和准确性。其次,对于某些复杂的几何结构或特殊材质,可能需要进一步的人工调整才能达到理想效果。最后,该方法的计算开销相对较大,可能不适合实时应用场景。

结语

Text2Tex代表了人工智能驱动的3D内容创作的最新进展。通过将自然语言处理、计算机视觉和计算机图形学技术相结合,它为创作者提供了一种直观而强大的工具,可以将想象中的纹理快速转化为现实。尽管仍有改进空间,但Text2Tex无疑为3D内容创作的未来指明了一个充满希望的方向。

随着这类技术的不断发展和完善,我们可以期待在不久的将来,创作精美的3D内容将变得像写一段文字描述一样简单。这不仅会提高内容创作的效率,还可能激发出更多创新的应用和表现形式。对于研究人员、开发者和内容创作者来说,跟进和探索这一领域的最新进展将是非常有价值的。