Text2Video:让文本-图像扩散模型成为零样本视频生成器

Text2Video是一个令人兴奋的AI项目,它可以将文本描述直接转换为视频。本文将为大家介绍Text2Video的相关学习资料,帮助感兴趣的读者快速入门。

项目简介

Text2Video提出了一种新的零样本文本到视频生成任务,并提出了一种低成本方法(无需任何训练或优化),利用现有的文本到图像合成方法(如Stable Diffusion)使其适用于视频领域。该方法的关键修改包括:

- 用运动动力学丰富生成帧的潜在编码,以保持全局场景和背景时间一致。

- 使用每一帧在第一帧上的新的跨帧注意力来重新编程帧级自注意力,以保持前景对象的上下文、外观和身份。

实验表明,这种方法开销低,但视频生成质量高且一致性很好。

学习资源

-

GitHub代码仓库: Text2Video-Zero

这里有完整的项目代码,以及详细的使用说明。

-

论文: Text2Video-Zero: Text-to-Image Diffusion Models are Zero-Shot Video Generators

详细介绍了Text2Video的技术原理和实验结果。

-

Hugging Face在线Demo: Text2Video-Zero

可以在线体验Text2Video的效果。

-

视频演示: YouTube

直观展示了Text2Video的各种应用效果。

使用方法

Text2Video支持以下几种使用方式:

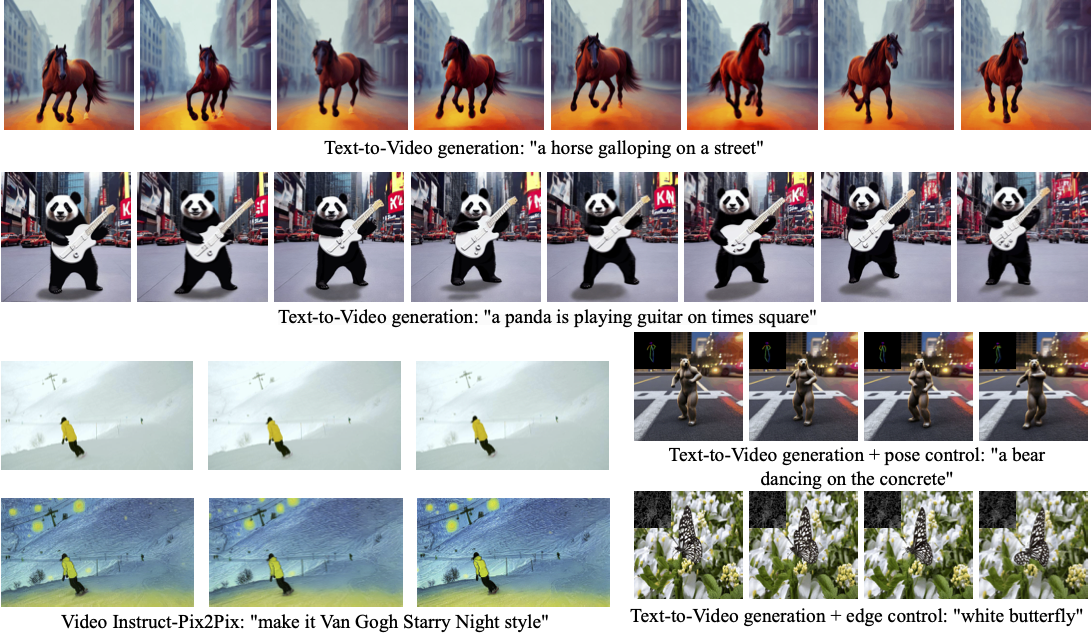

- 纯文本到视频生成

- 文本+姿势条件的视频生成

- 文本+边缘条件的视频生成

- Video Instruct-Pix2Pix(视频编辑)

具体的使用方法可以参考GitHub仓库中的说明文档。

相关项目

- Stable Diffusion: Text2Video基于的文本到图像模型

- ControlNet: 用于条件控制的扩散模型

- InstructPix2Pix: 用于图像编辑的指令跟随模型

总结

Text2Video为AI视频生成开辟了新的方向,相信随着技术的进一步发展,未来会有更多令人惊叹的应用出现。欢迎感兴趣的读者深入探索,为这个激动人心的领域贡献自己的力量!

🚀 如果您对Text2Video有任何问题或想法,欢迎在评论区留言讨论!