Torch-Conv-KAN:开创卷积神经网络的新范式

在深度学习领域,卷积神经网络(CNN)一直是图像处理和计算机视觉任务的主力军。然而,随着研究的深入,传统CNN的局限性也逐渐显现。为了突破这些限制,研究人员不断探索新的网络架构。在这一背景下,Torch-Conv-KAN项目应运而生,为卷积神经网络的发展开辟了一条新的道路。

Kolmogorov-Arnold网络:理论基础

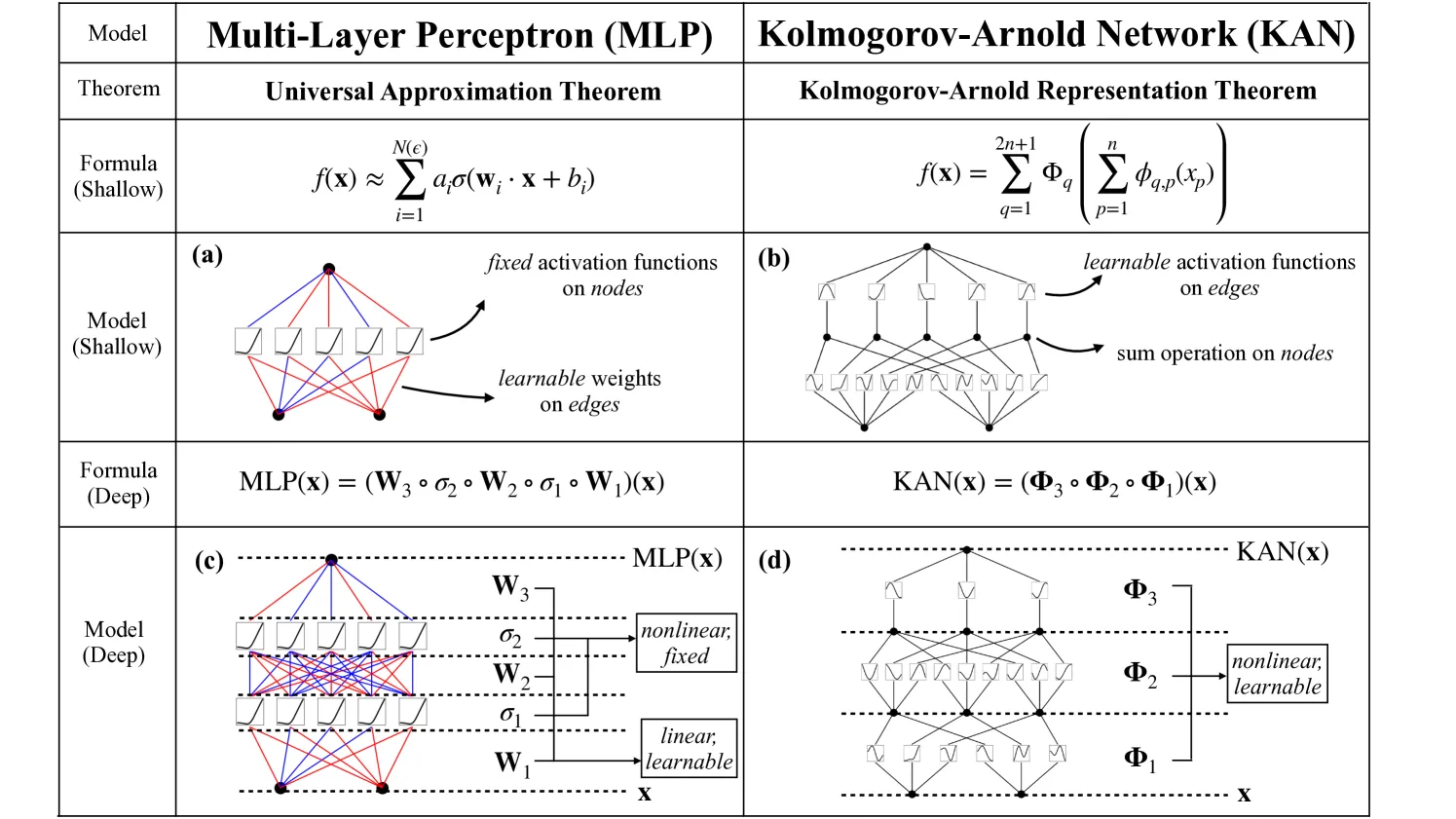

Torch-Conv-KAN项目的核心思想源自Kolmogorov-Arnold表示定理。这个定理指出,任何连续多元函数都可以表示为单变量函数的有限组合。基于这一理论,研究人员提出了Kolmogorov-Arnold网络(KAN),一种新型的神经网络架构。

KAN的独特之处在于其网络结构:在边上应用可学习的激活函数,而在节点上进行求和操作。这与传统多层感知机(MLP)形成鲜明对比,后者在节点上应用固定的非线性函数,在边上进行可学习的线性投影。

卷积KAN:创新的架构设计

Torch-Conv-KAN项目将KAN的思想引入卷积神经网络,创造出一种全新的卷积层设计。在传统卷积中,卷积核是一个权重矩阵。而在Kolmogorov-Arnold卷积(KA卷积)中,卷积核由一组单变量非线性函数组成。这种设计带来了更强的表达能力和灵活性。

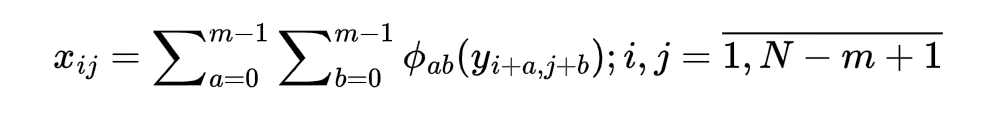

KA卷积的数学表达式如下:

其中,每个φ是一个可学习的单变量非线性函数。这些函数可以采用多种形式,如B样条、多项式、径向基函数(RBF)或小波等。

丰富的KAN卷积变体

Torch-Conv-KAN项目实现了多种KAN卷积变体,以适应不同的应用场景:

- KANConv: 基础的KAN卷积层,使用B样条作为非线性函数。

- KALNConv: 基于Legendre多项式的KAN卷积。

- FastKANConv: 一种计算效率更高的KAN卷积实现。

- KACNConv: 使用Chebyshev多项式替代B样条的KAN卷积。

- KAGNConv: 采用Gram多项式的KAN卷积。

- WavKANConv: 基于小波的KAN卷积。

- KAJNConv: 使用Jacobi多项式的KAN卷积。

- KABNConv: 基于Bernstein多项式的KAN卷积。

- ReLUKANConv: 使用ReLU作为激活函数的KAN卷积。

这些变体为研究人员提供了丰富的选择,可以根据具体任务和数据特性选择最合适的KAN卷积类型。

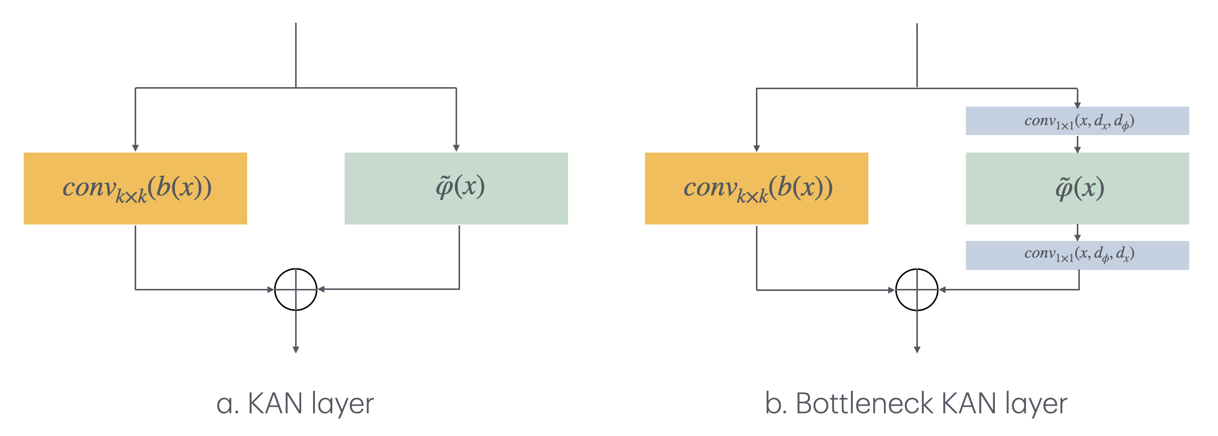

瓶颈KAN卷积:提高效率的创新

为了解决KAN卷积在处理高维数据时参数量剧增的问题,Torch-Conv-KAN项目引入了瓶颈KAN卷积层设计。这种设计借鉴了ResNet中的瓶颈结构,通过1x1卷积进行通道数的压缩和扩展,大大减少了模型参数量,同时保持了KAN卷积的优势。

多样化的网络架构

Torch-Conv-KAN项目不仅提供了各种KAN卷积层,还基于这些卷积层设计了多种网络架构:

- ResKANet: 类似ResNet的KAN卷积网络。

- DenseKANet: 类似DenseNet的KAN卷积网络。

- VGGKAN: 基于VGG架构的KAN卷积网络。

- UKANet和U2KANet: 类似U-Net和U2-Net的KAN卷积网络。

这些网络架构为研究人员提供了丰富的选择,可以在不同的任务中进行实验和比较。

实验结果与性能分析

Torch-Conv-KAN项目在多个数据集上进行了广泛的实验,包括MNIST、CIFAR-10、CIFAR-100和Tiny ImageNet等。实验结果显示,KAN卷积网络在某些任务上表现出色,特别是在MNIST数据集上。例如,8层SimpleKAGNConv模型在MNIST上达到了99.68%的准确率。

然而,在CIFAR-10和CIFAR-100等更复杂的数据集上,KAN卷积网络的性能仍有提升空间。研究人员正在积极探索如何优化KAN卷积网络的架构,以在这些更具挑战性的数据集上取得突破。

在ImageNet1k数据集上,VGG KAGN BN 11v4模型展现了令人鼓舞的性能,达到了68.5%的Top-1准确率和88.46%的Top-5准确率,同时仅使用了7.25M参数。这一结果表明,KAN卷积网络在大规模图像分类任务中也具有潜力。

代码实现与使用指南

Torch-Conv-KAN项目提供了完整的PyTorch实现,并配备了详细的使用说明。研究人员可以轻松地将KAN卷积层集成到自己的模型中,或者直接使用项目提供的预定义网络架构。以下是一个简单的KAN卷积网络示例:

import torch

import torch.nn as nn

from kan_convs import KANConv2DLayer

class SimpleConvKAN(nn.Module):

def __init__(self,

layer_sizes,

num_classes: int = 10,

input_channels: int = 1,

spline_order: int = 3,

groups: int = 1):

super(SimpleConvKAN, self).__init__()

self.layers = nn.Sequential(

KANConv2DLayer(input_channels, layer_sizes[0], spline_order, kernel_size=3, groups=1, padding=1, stride=1,

dilation=1),

KANConv2DLayer(layer_sizes[0], layer_sizes[1], spline_order, kernel_size=3, groups=groups, padding=1,

stride=2, dilation=1),

KANConv2DLayer(layer_sizes[1], layer_sizes[2], spline_order, kernel_size=3, groups=groups, padding=1,

stride=2, dilation=1),

KANConv2DLayer(layer_sizes[2], layer_sizes[3], spline_order, kernel_size=3, groups=groups, padding=1,

stride=1, dilation=1),

nn.AdaptiveAvgPool2d((1, 1))

)

self.output = nn.Linear(layer_sizes[3], num_classes)

self.drop = nn.Dropout(p=0.25)

def forward(self, x):

x = self.layers(x)

x = torch.flatten(x, 1)

x = self.drop(x)

x = self.output(x)

return x

项目还提供了基于Accelerate库的训练脚本,支持多GPU训练和分布式训练,并集成了Weights & Biases (wandb)用于实验监控和可视化。

未来展望与研究方向

尽管Torch-Conv-KAN项目已经取得了一些令人鼓舞的成果,但研究人员认识到还有很长的路要走。以下是一些值得进一步探索的方向:

- 架构优化: 寻找更适合KAN卷积的网络架构,特别是针对CIFAR-10/100等复杂数据集。

- 大规模数据集实验: 继续在ImageNet等大规模数据集上进行实验,探索KAN卷积网络的扩展性。

- 理论分析: 深入研究KAN卷积的理论基础,理解其优势和局限性。

- 应用探索: 将KAN卷积网络应用于更多领域,如目标检测、语义分割等任务。

- 效率提升: 进一步优化KAN卷积的计算效率,使其更适合实际应用。

结语

Torch-Conv-KAN项目为卷积神经网络的发展提供了一个全新的视角。通过将Kolmogorov-Arnold网络的思想引入卷积操作,该项目开创了一种新型的卷积神经网络范式。虽然目前KAN卷积网络在某些任务上的性能还不及传统CNN,但其独特的设计和潜力已经引起了研究界的广泛关注。

随着研究的深入和技术的不断优化,KAN卷积网络有望在未来发挥更大的作用,为深度学习领域带来新的突破。Torch-Conv-KAN项目为探索这一新兴领域提供了宝贵的工具和资源,相信会有更多研究者加入到这一激动人心的研究中来。

开源创新是推动技术进步的重要力量。Torch-Conv-KAN项目的开放性为研究者们提供了一个实验和创新的平台。无论你是深度学习研究者、学生还是行业从业者,都可以通过这个项目探索KAN卷积的奥秘,为神经网络的未来发展贡献自己的力量。让我们共同期待KAN卷积网络在未来能够绽放出更加灿烂的光芒!