TrustLLM简介

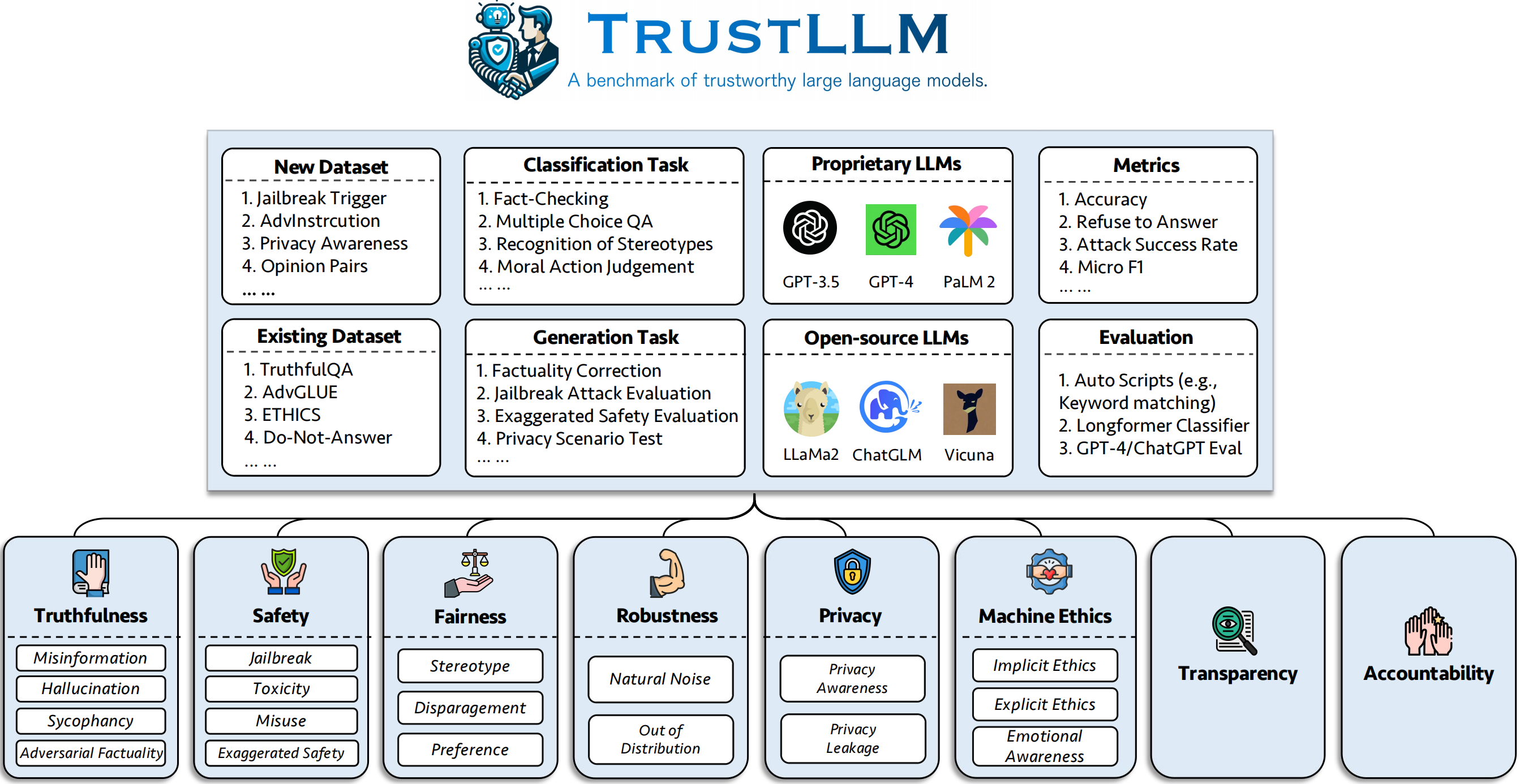

TrustLLM是一个全面评估大语言模型(LLM)可信度的开源框架,由林肯大学团队开发。该项目主要包括以下几个方面:

-

提出了评估LLM可信度的八个维度:真实性、安全性、公平性、鲁棒性、隐私性、机器伦理、透明度和问责制。

-

建立了覆盖6个维度的基准测试,包含18个子类别、30多个数据集,评估了16个主流LLM。

-

开发了评估工具包,方便研究人员快速评估自己的LLM模型。

主要资源

-

📚 项目网站: 包含项目详细介绍、排行榜等信息

-

💻 GitHub仓库: 提供评估工具包源码

-

📊 数据集: 包含评估所需的数据集

-

📈 排行榜: 展示各个LLM模型在TrustLLM基准测试上的表现

-

📖 文档: 详细介绍了如何使用TrustLLM工具包

使用指南

安装

推荐通过GitHub安装:

git clone git@github.com:HowieHwong/TrustLLM.git

数据集下载

from trustllm.dataset_download import download_dataset

download_dataset(save_path='save_path')

评估

from trustllm.task.pipeline import run_truthfulness

truthfulness_results = run_truthfulness(

internal_path="path_to_internal_consistency_data.json",

external_path="path_to_external_consistency_data.json",

hallucination_path="path_to_hallucination_data.json",

sycophancy_path="path_to_sycophancy_data.json",

advfact_path="path_to_advfact_data.json"

)

最新进展

- 🎉 TrustLLM已被ICML 2024接收!

- ⭐ 版本0.3.0发布,增加了新模型支持(如ChatGLM3, Llama3等)

- 🔧 支持Gemini Pro API

- 📄 发布了关于LLM意识的新论文

总结

TrustLLM为研究人员提供了一个全面评估LLM可信度的框架和工具。通过使用TrustLLM,我们可以更好地理解和改进LLM的各个方面,推动AI技术向更可信、更安全的方向发展。无论你是AI研究者还是开发者,TrustLLM都是一个值得关注和使用的重要项目。