VGen:开源视频生成生态系统的革新之作

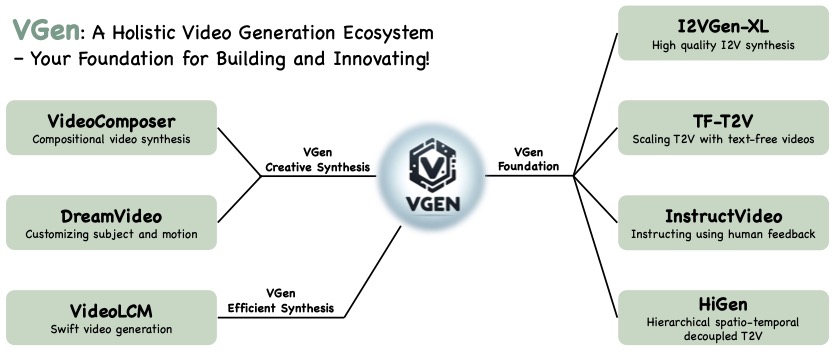

在人工智能和计算机视觉领域,视频生成技术正在经历快速的发展。近日,阿里巴巴达摩院推出了一个名为VGen的开源视频生成生态系统,为该领域带来了新的突破。VGen集成了多种最新的视频生成模型和技术,为研究人员和开发者提供了一个强大而灵活的工具包。

VGen的主要特点

VGen具有以下几个主要特点:

-

扩展性强:VGen的设计理念是让用户能够方便地管理自己的实验。它提供了灵活的配置系统,使用户可以轻松地定制和扩展模型。

-

功能完备:VGen包含了视频生成所需的所有常见组件,从数据处理到模型训练再到推理生成,提供了一站式的解决方案。

-

性能卓越:VGen集成了多个在各种视频生成任务中表现出色的预训练模型,能够生成高质量的视频内容。

-

开源免费:作为一个开源项目,VGen向所有人开放,研究人员和开发者可以自由使用和贡献代码。

VGen支持的主要方法

VGen目前支持以下几种先进的视频生成方法:

- I2VGen-xl:基于级联扩散模型的高质量图像到视频合成

- VideoComposer:具有运动可控性的组合视频合成

- HiGen:用于文本到视频生成的分层时空解耦

- TF-T2V:使用无文本视频扩展文本到视频生成

- InstructVideo:通过人类反馈指导视频扩散模型

- DreamVideo:使用自定义主体和运动合成梦想视频

- VideoLCM:视频潜在一致性模型

这些方法涵盖了图像到视频、文本到视频等多种视频生成任务,代表了该领域的最新进展。

使用VGen生成视频

使用VGen生成视频非常简单。以下是使用I2VGen-XL模型从图像生成视频的基本步骤:

- 安装VGen及其依赖:

pip install -r requirements.txt

- 下载预训练模型:

from modelscope.hub.snapshot_download import snapshot_download

model_dir = snapshot_download('damo/I2VGen-XL', cache_dir='models/', revision='v1.0.0')

-

准备输入图像和对应的文本描述,可以参考

data/test_list_for_i2vgen.txt的格式。 -

运行推理脚本:

python inference.py --cfg configs/i2vgen_xl_infer.yaml

- 生成的视频将保存在

workspace/experiments/test_list_for_i2vgen目录下。

使用其他模型的流程也类似,只需要下载相应的模型权重并修改配置文件即可。

VGen的应用前景

VGen作为一个综合性的视频生成工具包,有着广阔的应用前景:

-

研究与开发:研究人员可以基于VGen快速实现和验证新的视频生成算法。

-

内容创作:创作者可以利用VGen生成各种创意视频内容,如动画、特效等。

-

视频编辑:VGen可以用于视频编辑和后期处理,如风格迁移、运动控制等。

-

虚拟现实:在VR/AR领域,VGen可以用于生成虚拟场景和角色动画。

-

教育培训:VGen可以用于生成教学视频或模拟训练场景。

未来展望

VGen团队表示,他们将继续完善和扩展VGen的功能。未来的计划包括:

- 发布能够生成1280x720分辨率视频的代码和预训练模型

- 发布针对人体和人脸优化的模型

- 改进身份保持和大幅度精确运动捕捉的能力

- 集成更多视频生成方法和相应模型

随着这些新功能的加入,VGen将为视频生成领域带来更多可能性。

总的来说,VGen作为一个综合性的开源视频生成生态系统,不仅集成了多种先进的视频生成技术,还提供了灵活易用的工具包。它的出现无疑将推动视频生成技术的发展和应用,为研究人员、开发者和创作者提供更多可能性。我们期待看到更多基于VGen的创新应用出现,为视频内容创作带来新的革命。