基于大语言模型的视频理解技术研究进展

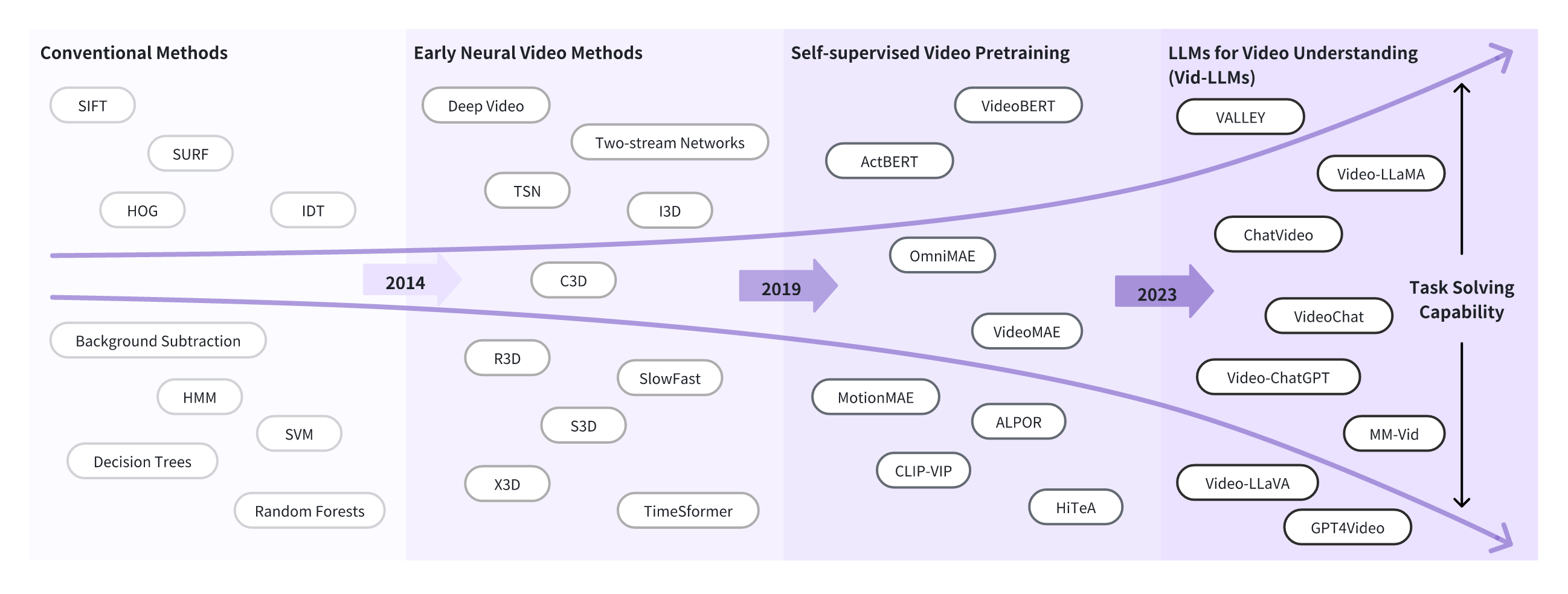

近年来,随着大语言模型(Large Language Models, LLMs)在自然语言处理领域取得突破性进展,研究人员开始探索将LLMs的强大能力扩展到视频理解任务中。本文综述了基于大语言模型的视频理解(Video Understanding with Large Language Models, Vid-LLMs)的最新研究进展。

为什么需要Vid-LLMs?

传统的视频理解方法主要关注短时间尺度的分析,如单帧的动作识别、物体检测等。然而,现实世界中的视频往往包含长时间、复杂的事件和交互。Vid-LLMs的出现为解决这些挑战提供了新的可能:

- LLMs具有强大的语言理解和生成能力,可以更好地捕捉视频中的语义信息。

- LLMs的大规模预训练使其具有丰富的世界知识,有助于理解视频中的高级语义概念。

- LLMs的推理能力可以帮助分析视频中的因果关系和时序依赖。

Vid-LLMs模型分类

根据模型架构和训练策略,Vid-LLMs可以分为以下几类:

-

LLM-based Video Agents: 利用现有LLMs作为推理引擎,结合视频特征提取器进行视频理解。代表工作有Socratic Models、Video ChatCaptioner等。

-

Vid-LLM Pretraining: 从头预训练视频-语言模型。如LaViLa、Vid2Seq等。

-

Vid-LLM Instruction Tuning: 在预训练LLMs基础上进行指令微调。根据视觉特征融合方式可分为:

- Connective Adapters: 如Video-LLaMA、VALLEY等

- Insertive Adapters: 如Otter、VideoLLM等

- Hybrid Adapters: 如VTimeLLM、GPT4Video等

-

Hybrid Methods: 结合多种技术的混合方法,如VideoChat、PG-Video-LLaVA等。

主要任务与数据集

Vid-LLMs的主要任务包括:

-

识别与预测: 如动作识别、事件边界检测等。相关数据集有Charades、YouTube8M、ActivityNet等。

-

描述与摘要: 如视频描述、视频字幕生成等。相关数据集有MSVD、MSR-VTT、YouCook2等。

-

定位与检索: 如时空定位、视频检索等。相关数据集有ActivityNet Captions、DiDeMo等。

-

问答: 如视频问答、视觉对话等。相关数据集有TVQA、How2QA等。

-

指令跟随: 旨在提高模型对复杂指令的理解和执行能力。相关数据集有Video-ChatGPT、InstructVideo等。

评测基准

为了全面评估Vid-LLMs的性能,研究人员提出了一些综合性评测基准,如:

- VALSE: 评估Vid-LLMs在视频-语言理解任务中的能力。

- MME: 评估多模态LLMs在图像和视频理解任务中的表现。

- M3IT: 评估多模态LLMs在跨模态和跨任务场景下的泛化能力。

这些基准涵盖了多个维度,包括视频理解的准确性、鲁棒性、泛化能力等。

未来研究方向

尽管Vid-LLMs取得了显著进展,但仍存在一些挑战和值得探索的方向:

- 长视频理解: 如何有效处理长时间、复杂的视频内容仍是一个挑战。

- 多模态融合: 进一步提升视觉、音频、文本等多模态信息的融合效果。

- 推理能力: 增强Vid-LLMs的因果推理和常识推理能力。

- 效率优化: 降低Vid-LLMs的计算资源需求,提高推理速度。

- 伦理与安全: 关注Vid-LLMs可能带来的偏见、隐私等问题。

结论

Vid-LLMs为视频理解领域带来了新的研究范式和技术突破。随着相关研究的深入,Vid-LLMs有望在智能监控、内容分析、人机交互等领域发挥重要作用,推动人工智能向更高层次发展。然而,我们也需要关注Vid-LLMs的局限性和潜在风险,在技术创新的同时兼顾伦理和社会影响。

图1: Vid-LLMs研究里程碑