VideoComposer:开启视频创作新纪元

在人工智能和计算机视觉领域,视频生成一直是一个充满挑战的研究方向。近日,阿里巴巴达摩院视觉实验室(Ali-ViLab)推出了一项名为VideoComposer的创新技术,为可控视频合成开辟了新的可能性。这项技术不仅能够生成高质量的视频内容,还允许用户对生成过程进行多方位的精确控制,为视频创作带来了前所未有的灵活性和创造力。

VideoComposer的核心理念

VideoComposer是一种可控的视频扩散模型,其核心理念是允许用户灵活控制合成视频的空间和时间模式。用户可以通过多种形式来指导视频的生成过程,包括:

- 文本描述

- 草图序列

- 参考视频

- 手工制作的动作

- 手绘图像

这种多模态的输入方式为视频创作提供了巨大的灵活性,使得用户能够更精准地表达他们的创意构想。

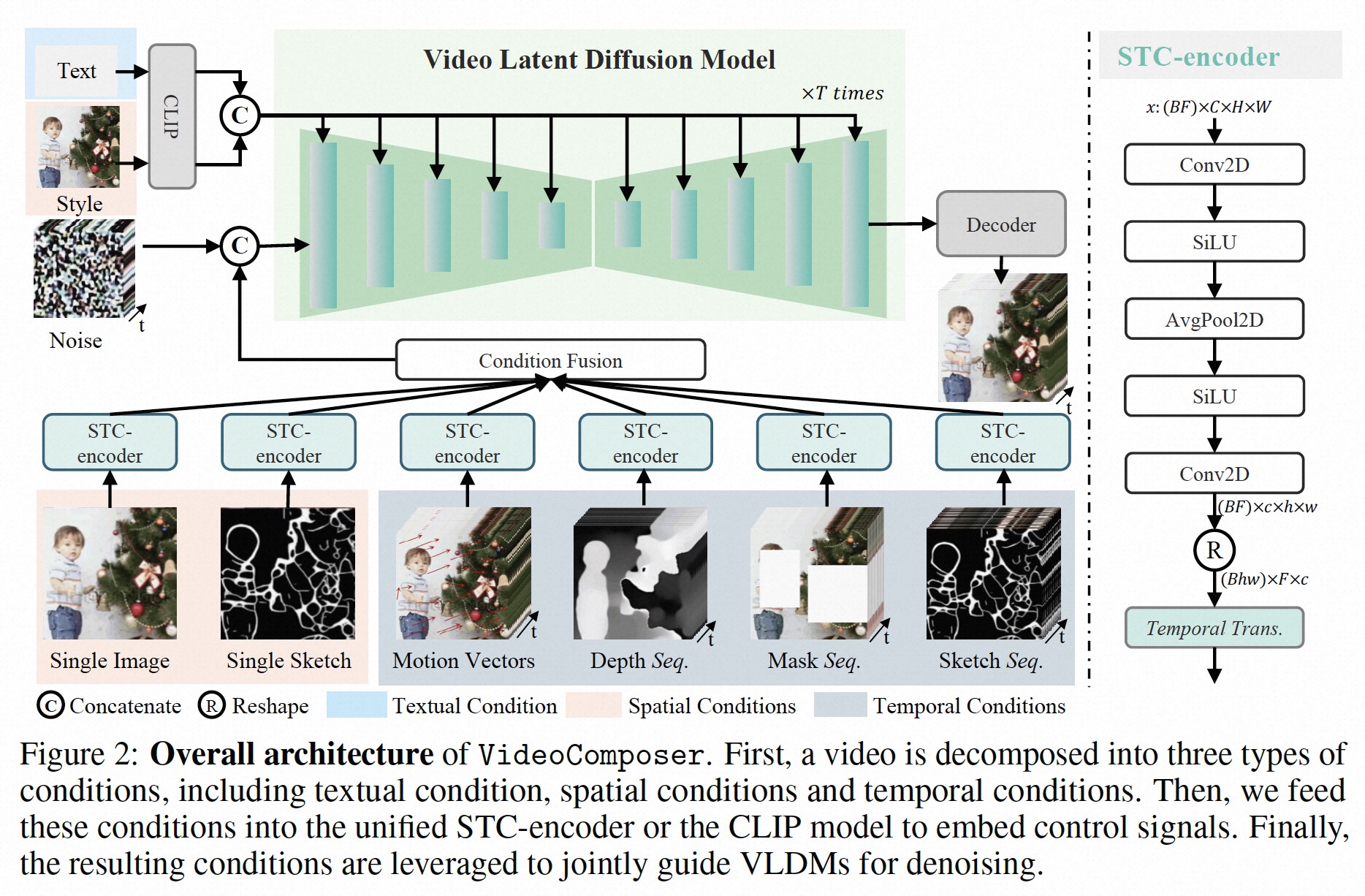

技术原理与创新

VideoComposer采用了扩散模型作为其核心架构。扩散模型是近年来在生成领域取得重大突破的技术,它通过逐步去噪的方式生成高质量的样本。VideoComposer在此基础上进行了创新,引入了多种条件控制机制,使得模型能够同时处理空间和时间维度的信息。

主要的技术创新点包括:

-

多模态条件融合: 模型能够同时处理文本、图像、视频等多种模态的输入信息。

-

时空一致性控制: 通过精心设计的架构,确保生成的视频在时间和空间上保持连贯性。

-

运动可控性: 用户可以通过简单的草图或参考视频来控制生成视频中的运动模式。

-

风格迁移: 能够将静态图像的风格应用到动态视频中,实现风格的时空一致转换。

应用场景与示例

VideoComposer的应用场景非常广泛,以下是几个典型的使用案例:

- 运动迁移

用户可以提供一个参考视频的运动模式,并将其应用到一张静态图像上,生成具有相似运动特征的新视频。例如:

python run_net.py \

--cfg configs/exp02_motion_transfer.yaml \

--seed 9999 \

--input_video "demo_video/motion_transfer.mp4" \

--image_path "demo_video/moon_on_water.jpg" \

--input_text_desc "A beautiful big moon on the water at night"

这个命令将会生成一个夜晚水面上大月亮的动态视频,其运动模式来自输入的参考视频。

- 草图到视频的转换

用户可以提供一个简单的草图,VideoComposer将其转换为动态的视频内容。例如:

python run_net.py \

--cfg configs/exp04_sketch2video_wo_style.yaml \

--seed 144 \

--sketch_path "demo_video/src_single_sketch.png" \

--input_text_desc "A Red-backed Shrike lanius collurio is on the branch"

这个命令会将一个简单的鸟类草图转换为栖息在树枝上的红背伯劳的动态视频。

- 文本引导的视频生成

仅通过文本描述,VideoComposer就能生成符合描述的视频内容。例如:

python run_net.py \

--cfg configs/exp05_text_depths_wo_style.yaml \

--seed 9999 \

--input_video demo_video/video_8800.mp4 \

--input_text_desc "A glittering and translucent fish swimming in a small glass bowl with multicolored piece of stone, like a glass fish"

这个命令会生成一个闪闪发光的透明鱼在彩色石头点缀的小玻璃碗中游动的视频。

最新进展与未来展望

VideoComposer项目正在快速发展中,研究团队不断推出新的功能和改进:

- 2023年10月: 发布了高质量的I2VGen-XL模型,进一步提升了视频生成的质量。

- 2023年8月: 在ModelScope平台上发布了Gradio UI演示,使得更多用户能够便捷地体验这项技术。

- 2023年7月: 发布了无水印的预训练模型,为研究人员提供了更多可能性。

未来,VideoComposer团队计划:

- 发布技术论文和项目网页,分享更多技术细节。

- 开源代码和预训练模型,推动社区共同发展。

- 在Hugging Face上发布Gradio UI,让全球开发者更容易接触到这项技术。

- 发布能够生成8秒无水印视频的预训练模型。

使用指南

对于想要尝试VideoComposer的开发者,以下是基本的使用步骤:

- 环境配置

首先需要安装必要的依赖,主要包括Python 3.8、PyTorch 1.12.0、CUDA 11.3等。可以使用以下命令创建所需环境:

conda env create -f environment.yaml

- 下载模型权重

可以通过ModelScope平台下载所需的模型权重:

!pip install modelscope

from modelscope.hub.snapshot_download import snapshot_download

model_dir = snapshot_download('damo/VideoComposer', cache_dir='model_weights/', revision='v1.0.0')

- 运行示例

选择合适的配置文件,并提供必要的输入(如参考视频、图像、文本描述等),即可生成视频:

python run_net.py \

--cfg configs/exp01_vidcomposer_full.yaml \

--input_video "demo_video/blackswan.mp4" \

--input_text_desc "A black swan swam in the water" \

--seed 9999

结语

VideoComposer代表了视频生成技术的一个重要里程碑。它不仅展示了AI在创意领域的巨大潜力,也为未来的视频创作、影视制作、虚拟现实等领域带来了无限可能。随着技术的不断发展和完善,我们可以期待看到更多令人惊叹的应用场景和创新成果。

尽管如此,我们也应该意识到这项技术可能带来的伦理和社会影响。开发团队特别强调,该模型仅供研究和非商业用途,这反映了他们对技术负责任使用的重视。未来,如何平衡技术创新与社会责任,将是整个AI社区需要共同面对的重要课题。

VideoComposer的开源不仅是技术的分享,更是一种开放和协作的精神。它邀请全球的研究者和开发者共同参与,推动这项技术的进步,为人工智能驱动的视频创作开辟更广阔的未来。