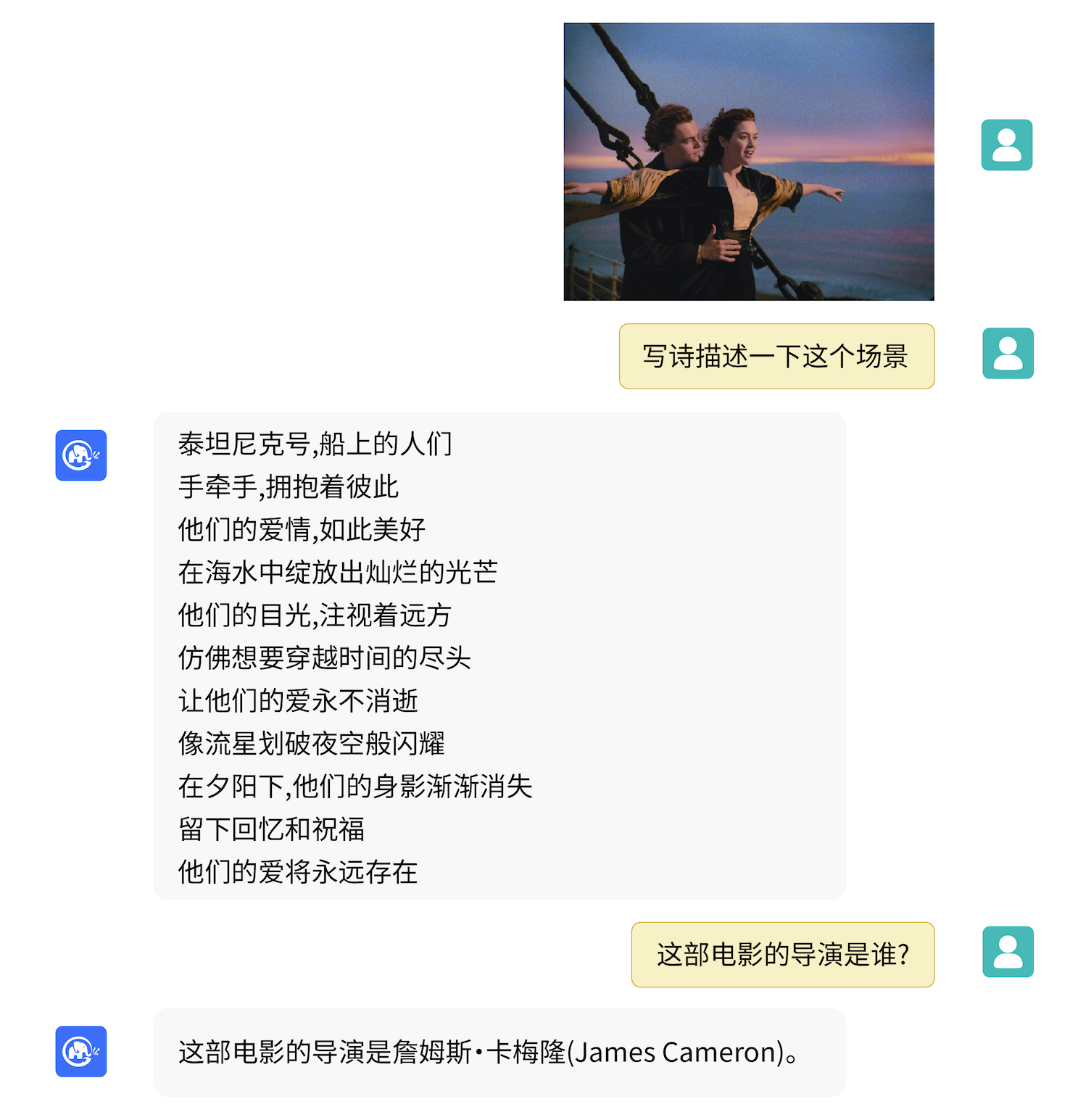

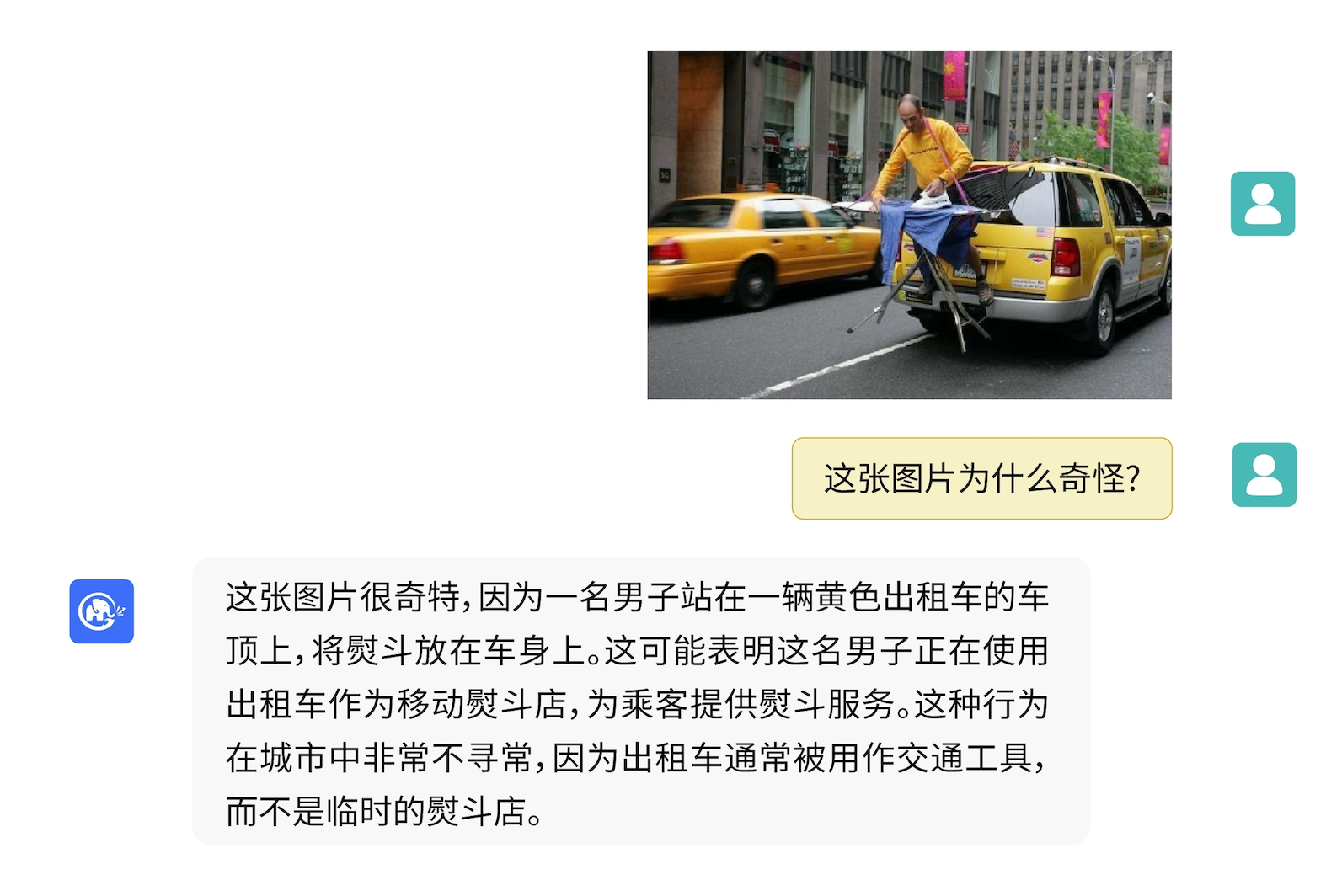

VisualGLM-6B:开启多模态AI对话新纪元

在人工智能快速发展的今天,多模态对话模型正成为研究的热点。近日,清华大学知识工程实验室(THUDM)推出了一款名为VisualGLM-6B的开源多模态对话语言模型,引起了广泛关注。本文将深入介绍VisualGLM-6B的特点、使用方法、局限性等内容,帮助读者全面了解这一创新模型。

模型概述

VisualGLM-6B是一个开源的、支持图像、中文和英文的多模态对话语言模型。该模型的语言部分基于ChatGLM-6B,拥有62亿参数;图像部分则通过训练BLIP2-Qformer构建了视觉模型与语言模型之间的桥梁,整体模型共有78亿参数。

VisualGLM-6B在训练过程中使用了来自CogView数据集的3000万高质量中文图文对,以及3亿经过筛选的英文图文对,中英文权重相同。这种训练方式很好地将视觉信息对齐到了ChatGLM的语义空间。在后续的微调阶段,模型还在长视觉问答数据上进行了训练,以生成更符合人类偏好的答案。

主要特点

-

多模态支持:VisualGLM-6B不仅支持文本输入,还能处理图像信息,实现图文结合的对话交互。

-

双语能力:模型同时支持中文和英文,满足不同语言背景用户的需求。

-

开源可用:项目代码和模型权重均已开源,方便研究者和开发者使用和改进。

-

轻量级部署:通过模型量化技术,用户可以在消费级显卡上进行本地部署,最低只需6.3G显存。

-

灵活性强:模型基于SwissArmyTransformer库训练,支持Lora、P-tuning等参数高效微调方法。

使用方法

VisualGLM-6B提供了多种使用方式,包括命令行demo、网页版demo和API部署等。以下是使用Hugging Face transformers库调用模型的示例代码:

from transformers import AutoTokenizer, AutoModel

tokenizer = AutoTokenizer.from_pretrained("THUDM/visualglm-6b", trust_remote_code=True)

model = AutoModel.from_pretrained("THUDM/visualglm-6b", trust_remote_code=True).half().cuda()

image_path = "your image path"

response, history = model.chat(tokenizer, image_path, "描述这张图片。", history=[])

print(response)

除了基本的使用外,VisualGLM-6B还支持模型量化和微调。用户可以根据自己的硬件条件选择不同的量化级别,也可以通过提供的微调脚本对模型进行定制化训练。

应用场景

VisualGLM-6B的多模态特性使其在多个领域具有广阔的应用前景:

-

智能客服:能够理解用户上传的图片,提供更精准的问题解答。

-

教育辅助:可以解释教材插图,帮助学生更好地理解课程内容。

-

医疗诊断:辅助医生分析医学影像,提供初步诊断建议。

-

设计创作:为设计师提供图像描述和创意建议。

-

视觉障碍辅助:帮助视障人士理解周围环境。

局限性

尽管VisualGLM-6B展现了强大的能力,但研发团队也坦诚地指出了当前版本存在的一些局限性:

-

图像描述的事实性问题:在生成长描述时,可能会出现模型幻觉,生成图像中不存在的内容。

-

属性错配:在多物体场景中,某些物体的属性可能被错误地安插到其他物体上。

-

分辨率限制:当前使用224*224的分辨率,对于更细粒度的理解可能不足。

-

OCR能力不足:目前模型不具备中文OCR能力,英文OCR能力也有限。

研发团队表示,将在后续版本中着力解决这些问题,进一步提升模型性能。

开源协议与致谢

VisualGLM-6B的代码采用Apache-2.0协议开源,模型权重则需遵循专门的Model License。项目团队也对MiniGPT-4、LLAVA等项目表示了感谢,这些项目的部分数据在VisualGLM-6B的指令微调阶段发挥了重要作用。

结语

VisualGLM-6B的推出,为多模态AI对话领域带来了新的可能。虽然目前还存在一些局限性,但其开源特性无疑将推动整个领域的快速发展。研究者和开发者可以基于这一模型进行进一步的优化和应用探索,共同推动人工智能技术向着更加智能、更加人性化的方向迈进。

随着技术的不断进步,我们有理由相信,像VisualGLM-6B这样的多模态对话模型将在未来发挥越来越重要的作用,为人类的工作和生活带来更多便利和可能性。让我们共同期待VisualGLM-6B的后续发展,见证人工智能的又一次飞跃。