WebGLM简介

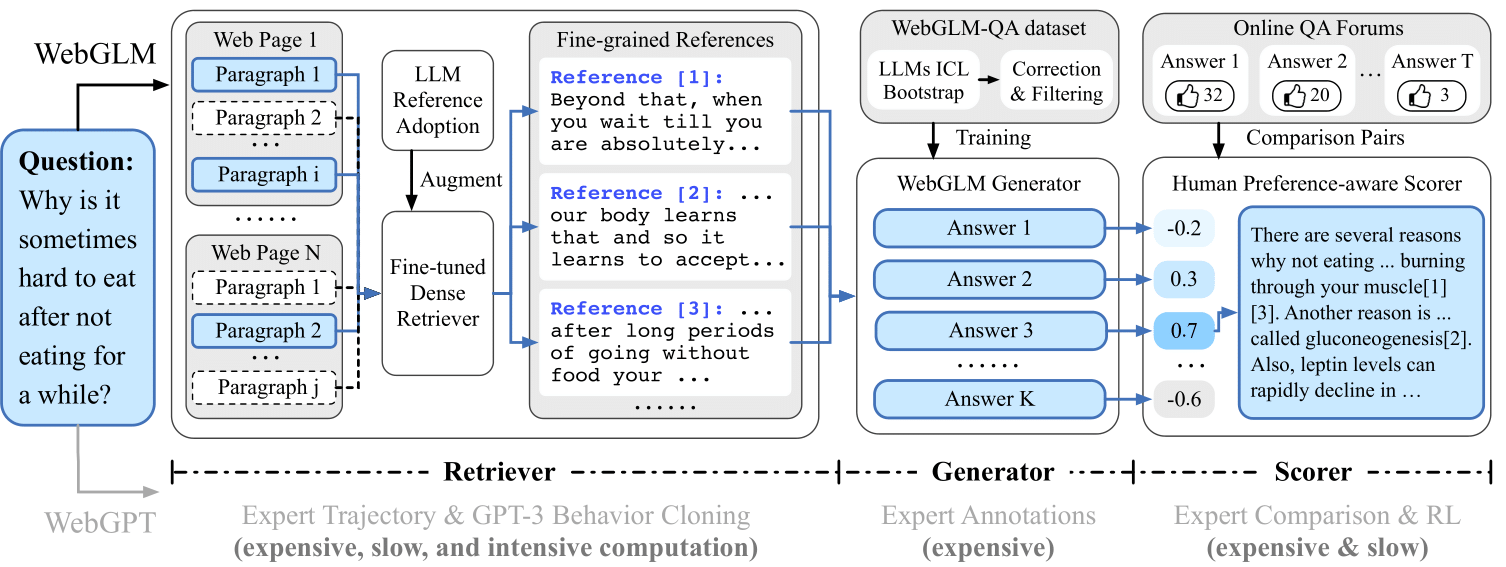

WebGLM是由清华大学开发的一个基于网络增强的问答系统。它的目标是将大规模预训练语言模型(LLM)与网络搜索和检索能力相结合,以提供高效、准确的问答服务。WebGLM基于100亿参数的通用语言模型(GLM),通过整合网络搜索和检索功能,大大提升了模型在实际应用中的表现。

WebGLM的主要特点

WebGLM具有以下三个核心特点:

-

LLM增强的检索器: 通过大规模语言模型增强网络内容的检索能力,更准确地找到相关信息以回答问题。

-

自举式生成器: 利用GLM的强大能力生成类人的回答,提供精炼的答案。

-

考虑人类偏好的评分器: 通过优先考虑人类偏好来评估生成回答的质量,确保系统产生有用且引人入胜的内容。

这些特点使WebGLM能够在保持高效率的同时,提供更加准确和人性化的回答。

WebGLM的技术创新

WebGLM在技术上有多项创新,主要包括:

-

性能提升: WebGLM-2B和WebGLM-10B两个版本都经过了全面升级。它们采用了GLM的混合目标函数,并经过了14亿双语标记的预训练和人类偏好对齐训练。评估结果显示,与第一代模型相比,WebGLM在多个数据集上都取得了显著的性能提升。

-

更长的上下文: 基于FlashAttention技术,WebGLM将基础模型的上下文长度从2K扩展到了32K,并在对话对齐过程中使用了8K的上下文长度训练,这使得系统能够处理更多轮次的对话。

-

更高效的推理: 基于Multi-Query Attention技术,WebGLM的推理速度更快,GPU内存使用更低。在官方实现下,推理速度比第一代提高了42%;在INT4量化下,6G GPU内存支持的对话长度从1K增加到了8K。

WebGLM的应用场景

WebGLM在多个实际应用场景中展现出了优秀的表现。以下是一些典型的应用案例:

-

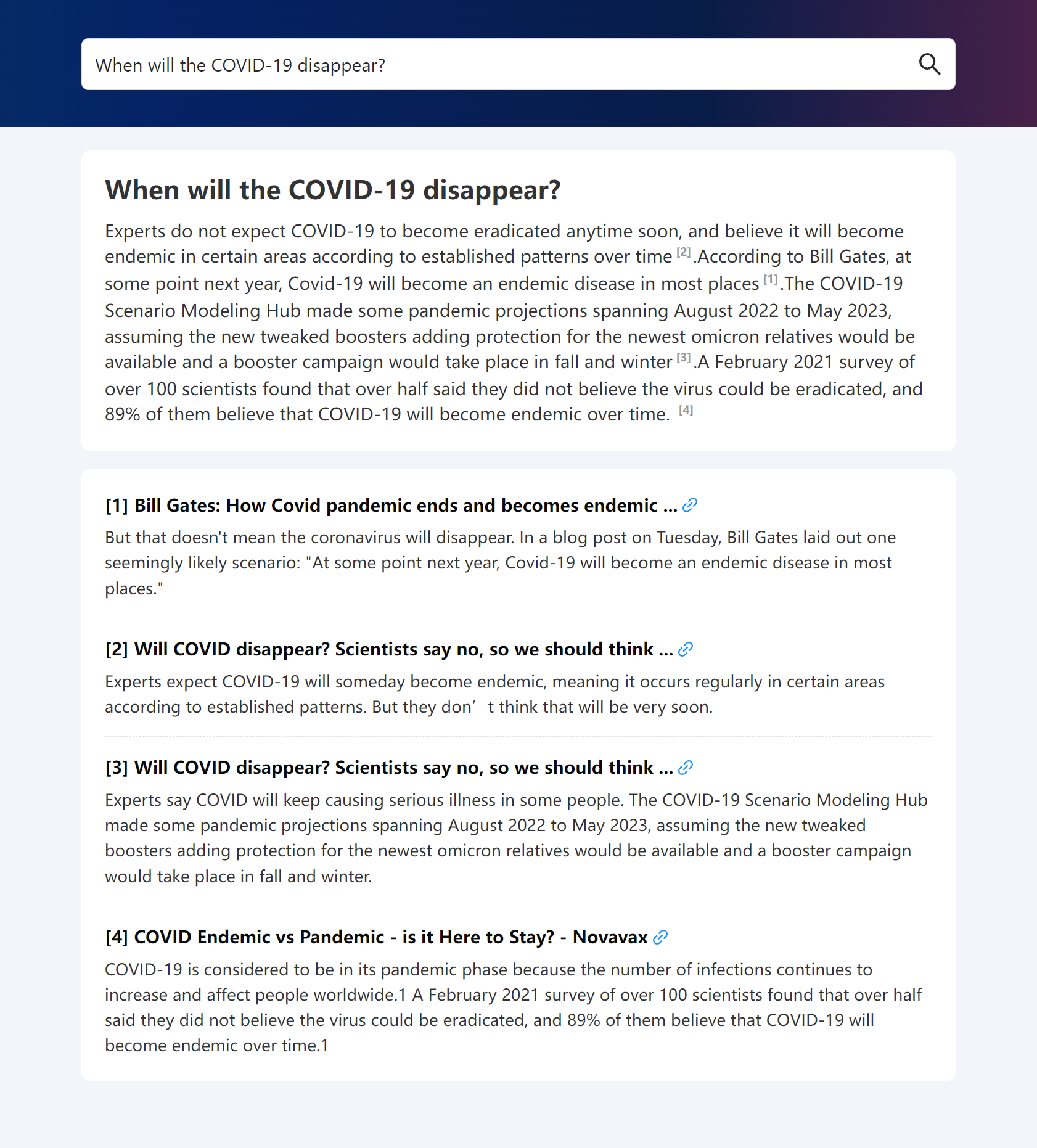

复杂问题解答: 对于"COVID-19何时会消失?"这类复杂问题,WebGLM能够综合多方面信息,给出全面而客观的回答。

-

生活建议: 在回答"如何平衡事业和爱好?"等问题时,WebGLM能够提供个性化的建议,考虑到不同人的具体情况。

-

技术比较: 对于"FL Studio和Cubase哪个更好?"这类专业问题,WebGLM能够提供详细的比较分析,帮助用户做出选择。

-

学术讨论: 在回答"注意力机制是否比CNN更好?"等学术问题时,WebGLM能够给出深入的分析和见解。

-

实时热点: 对于"你如何看待原神3.5版本?"这类与时事相关的问题,WebGLM能够提供最新的信息和分析。

这些应用案例展示了WebGLM在处理各种类型问题时的versatility和准确性。

WebGLM的使用方法

WebGLM提供了多种使用方式,包括命令行界面和Web服务。用户可以通过以下步骤尝试WebGLM:

- 克隆WebGLM的GitHub仓库并安装所需的Python依赖。

- 准备SerpAPI密钥或选择使用Bing搜索。

- 下载预训练的检索器检查点。

- 设置必要的环境变量。

- 运行命令行演示或Web服务。

例如,要使用WebGLM-2B模型并通过Bing搜索,可以运行以下命令:

python cli_demo.py -w THUDM/WebGLM-2B --searcher bing

WebGLM的未来发展

作为一个开源项目,WebGLM正在不断发展和改进。未来的发展方向可能包括:

- 进一步提升模型性能,特别是在处理超长文档方面。

- 扩展支持的语言和领域。

- 优化系统的效率,使其能在更多设备上运行。

- 增强模型的可解释性和安全性。

研究者和开发者可以通过GitHub参与到WebGLM的开发中来,为这个创新的问答系统贡献自己的力量。

结论

WebGLM代表了问答系统的一个重要进步。通过结合大规模语言模型和网络搜索能力,WebGLM展示了如何构建一个既高效又准确的问答系统。它不仅在技术上有创新,在实际应用中也表现出色。随着进一步的发展和完善,WebGLM有潜力成为各种场景下的重要工具,为用户提供更智能、更人性化的问答服务。

WebGLM的开源性质也为研究者和开发者提供了一个宝贵的平台,让他们能够深入研究和改进这一技术。我们期待看到WebGLM在未来带来更多令人兴奋的应用和突破。