Bench简介

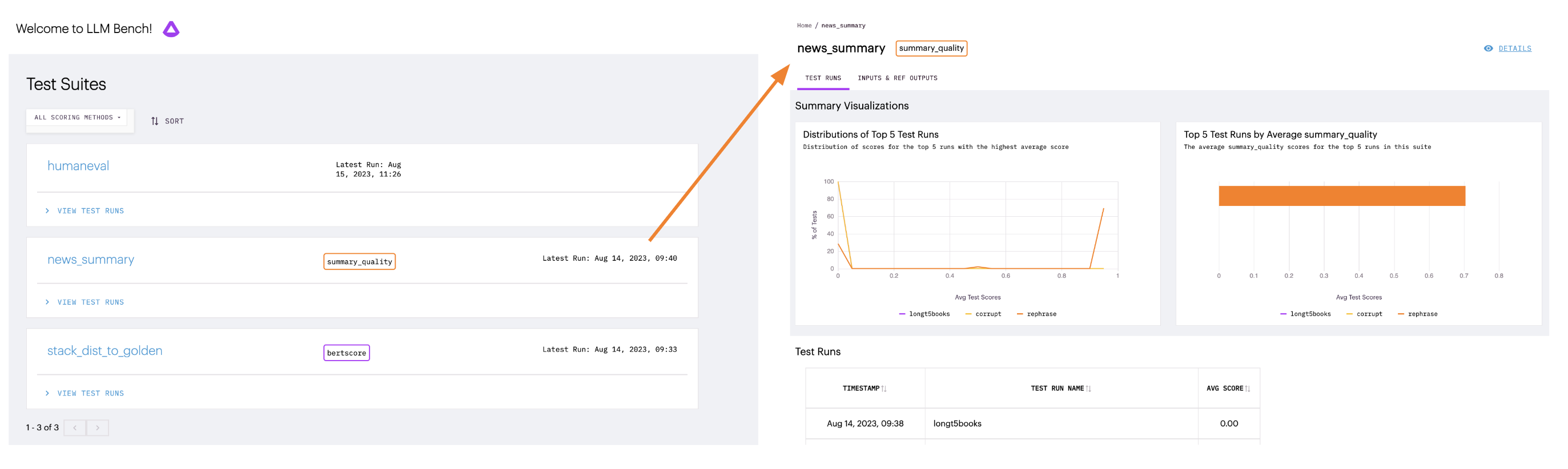

Bench是一个专门用于评估大语言模型(LLM)生产应用场景的工具。无论是比较不同的LLM,考虑不同的提示词,还是测试生成超参数(如temperature和token数),Bench都为所有LLM性能评估提供了一个统一的接口。

如果你在LLM工作中遇到以下需求,Bench可以帮助你进行评估:

- 标准化LLM评估工作流程,为不同任务和用例提供通用接口

- 测试开源LLM是否可以在特定数据上达到顶级闭源LLM API提供商的水平

- 将LLM排行榜和基准测试的排名转化为实际用例中你关心的分数

主要学习资源

-

这是Bench的官方文档网站,包含了详细的使用说明和API参考。

-

Bench的源代码仓库,可以查看最新的开发进展。

-

详细介绍了如何安装Bench及其依赖。

-

通过实例快速上手使用Bench的主要功能。

-

学习如何创建自定义的LLM评估测试套件。

安装Bench

推荐安装带有本地结果展示功能的完整版:

pip install 'arthur-bench[server]'

或者安装最小依赖版本:

pip install arthur-bench

使用示例

以下是一个简单的使用示例:

from arthur_bench.run.testsuite import TestSuite

suite = TestSuite(

"bench_quickstart",

"exact_match",

input_text_list=["What year was FDR elected?", "What is the opposite of down?"],

reference_output_list=["1932", "up"]

)

suite.run("quickstart_run", candidate_output_list=["1932", "up is the opposite of down"])

运行后,可以通过以下命令在本地查看结果:

bench

社区支持

如果在使用过程中遇到问题,可以通过以下方式获取帮助:

- 加入Discord社区

- 在GitHub仓库提交Issue

通过这些学习资源,你可以快速掌握Bench的使用方法,开始评估和优化你的LLM应用。Bench为LLM的性能评估提供了一个强大而灵活的工具,值得深入学习和使用。