DigiRL:突破性的自主强化学习设备控制代理

在人工智能领域,如何让智能代理能够自主学习并控制现实世界中的设备一直是一个巨大的挑战。近日,来自加州大学伯克利分校、伊利诺伊大学厄巴纳-香槟分校和Google DeepMind的研究团队提出了一种名为DigiRL的创新方法,为解决这一难题带来了突破性进展。

DigiRL的核心理念

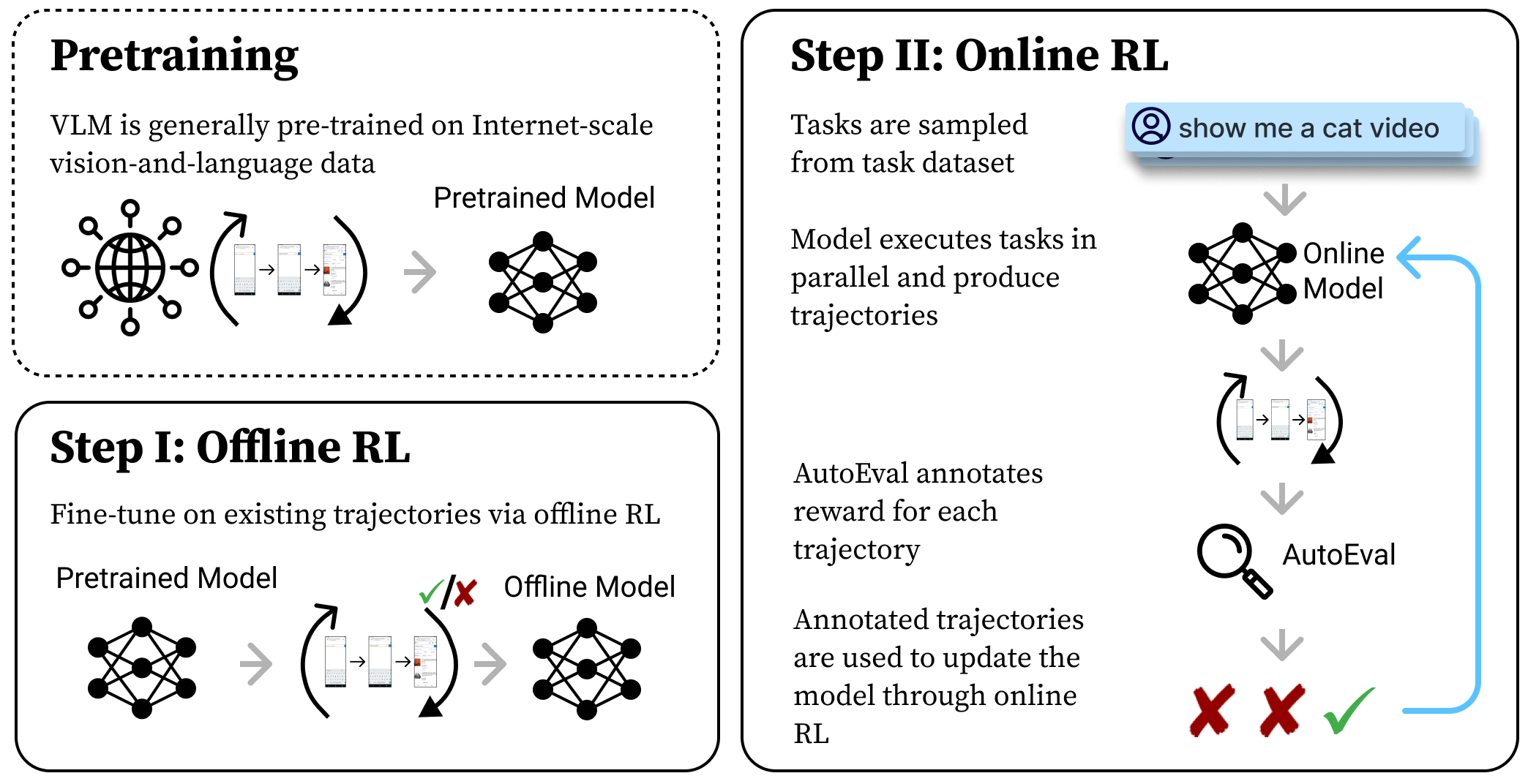

DigiRL(Digital Reinforcement Learning)是一种自主强化学习方法,旨在训练能够在现实世界中控制设备的智能代理。它的核心理念是让代理通过与真实设备的交互来学习控制策略,而不是在模拟环境中学习。这种方法可以让代理直接适应真实世界的复杂性和不确定性,从而获得更强的泛化能力。

DigiRL的主要特点

-

自适应错误处理:DigiRL具有自动适应性错误处理支持,能够应对现实世界中可能出现的各种意外情况。

-

多机器并行仿真:支持多台机器同时进行仿真,大大提高了训练效率。

-

断点续训:支持从检查点恢复训练,避免长时间训练中断带来的损失。

-

轨迹视频记录:能够记录代理的交互轨迹视频,方便分析和改进。

-

多种训练模式:

- 纯离线训练:使用预先收集的次优轨迹进行训练。

- 纯在线训练:代理边与环境交互边学习。

- 离线到在线训练:先用离线数据学习,再进行在线学习,最大化利用数据。

-

支持多种代理:

- AutoUI:支持训练和评估。

- CogAgent:目前仅支持评估。

-

多GPU分布式训练:支持使用多GPU进行分布式训练,提高大规模模型的训练速度。

DigiRL在Android设备控制中的应用

研究团队将DigiRL应用于Android-in-the-Wild(AitW)任务集,这是一个真实世界的Android设备交互任务集。他们设计了两个子任务集:

- AitW General:包含一般性的浏览和打开应用等任务。

- AitW Web Shopping:涉及在流行购物网站上进行购物的任务。

在这些任务中,DigiRL展现出了优异的性能。以下是部分实验结果:

| 任务集 | 算法 | 测试集得分 |

|---|---|---|

| AitW General | DigiRL | 70.8 |

| AitW General | Filtered BC | 59.4 |

| AitW Web Shopping | DigiRL | 75.0 |

| AitW Web Shopping | Filtered BC | 55.2 |

这些结果表明,DigiRL在真实世界的设备控制任务中具有显著优势。

快速上手DigiRL

对于想要尝试DigiRL的研究者和开发者,项目团队提供了详细的使用指南:

-

环境配置:

conda create -n digirl python==3.10 conda activate digirl git clone https://github.com/DigiRL-agent/digirl.git cd digirl pip install -e . -

Android环境设置:按照环境设置指南配置Android环境。

-

下载模型检查点和数据集:

-

修改配置:根据需要修改

scripts/config/main/default.yaml中的配置。 -

运行实验:

cd scripts python run.py --config-path config/main --config-name digirl_online

DigiRL的未来发展

DigiRL为设备控制代理的训练开辟了新的道路,但仍有很多值得探索的方向:

- 支持更多算法:如PPO等其他强化学习算法。

- 扩展到其他基础模型:如LLaVA等多模态模型。

- 应用于更多任务集:如WebArena等其他真实世界任务。

- 优化实现:进一步提高训练效率和代理性能。

研究团队欢迎开源社区为DigiRL项目做出贡献,共同推动设备控制AI的发展。

结语

DigiRL代表了设备控制AI领域的一个重要突破。它展示了如何通过自主强化学习来训练能在真实世界中有效运作的智能代理。随着技术的不断发展和完善,我们可以期待看到DigiRL在更多领域发挥作用,为人工智能与现实世界的深度融合铺平道路。

👉 访问DigiRL官方网站了解更多详情 👉 查看DigiRL论文深入研究技术细节

DigiRL的出现无疑为AI代理控制现实世界设备开启了新的可能性。让我们共同期待这项技术在未来带来的更多惊喜和突破!