EcoAssistant: 让LLM助手更经济实惠且准确 🚀

在人工智能和自然语言处理领域,大型语言模型(LLM)助手已经成为解决各种查询和任务的强大工具。然而,随着这些模型的规模和复杂性不断增加,使用它们的成本也在上升。此外,在某些特定任务中,如代码驱动的问答,LLM助手的准确性仍有提升空间。为了解决这些挑战,研究人员开发了EcoAssistant框架,旨在让LLM助手更加经济实惠和准确。

EcoAssistant简介

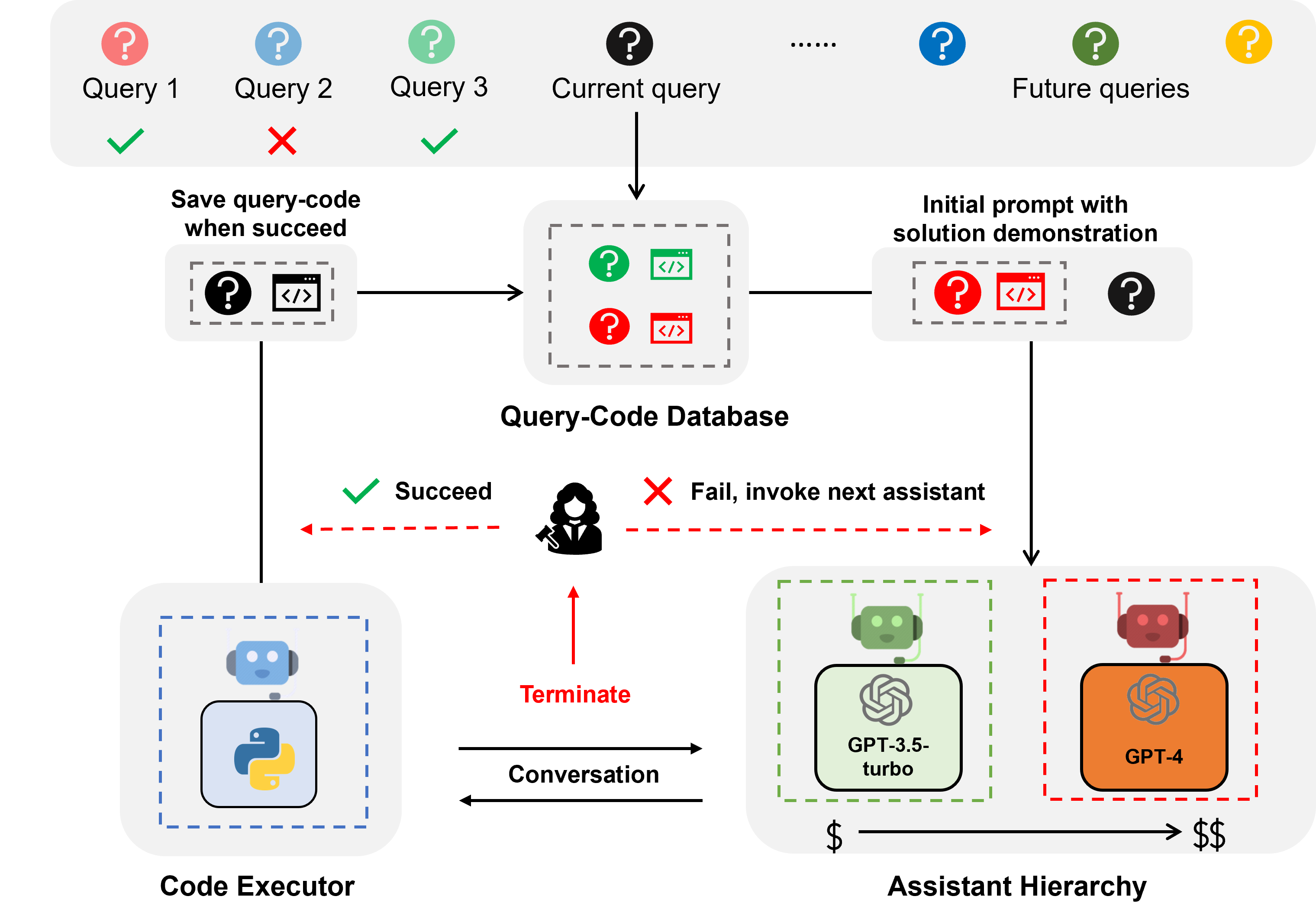

EcoAssistant是一个建立在AutoGen之上的框架,专门用于提高代码驱动问答任务中LLM助手的性能。它的核心理念基于两个关键概念:助手层级和解决方案演示。这种创新的方法不仅能够降低使用LLM的成本,还能显著提高回答的准确性。

LLM助手与代码驱动问答

在深入了解EcoAssistant之前,我们需要理解什么是LLM助手以及代码驱动问答。

LLM助手是由对话型大语言模型(如ChatGPT和GPT-4)支持的助手代理,能够在对话中处理用户查询。这些助手具有强大的自然语言理解和生成能力,可以处理各种复杂的任务和问题。

代码驱动问答是一种特殊的任务类型,要求LLM助手编写代码来调用外部API以回答问题。例如,当被问及"未来5天X城市的平均温度是多少?"时,助手需要编写代码来通过特定的API获取天气信息,并计算X城市未来5天的平均温度。

这种类型的问答任务通常需要迭代编码,因为LLM和人类一样,很难在第一次尝试就写出正确的代码。因此,助手需要与用户交互,获取反馈并反复修改代码,直到代码正确为止。EcoAssistant基于双代理对话框架构建,其中LLM助手与一个代码执行代理配对,后者可以自动执行代码并将输出返回给LLM助手。

EcoAssistant的核心组件

EcoAssistant框架的强大之处在于其两个核心组件:助手层级和解决方案演示。让我们深入了解这两个概念。

助手层级

助手层级是一种按成本排序的LLM助手层次结构(例如,GPT-3.5-turbo -> GPT-4)。当处理用户查询时,EcoAssistant首先让最便宜的助手尝试回答查询。只有在失败的情况下,才会调用更昂贵的助手。这种设计旨在通过减少昂贵助手的使用来节省成本。

具体来说,助手层级的工作流程如下:

- 用户提出查询

- 系统首先调用最经济的LLM助手(如GPT-3.5-turbo)

- 如果该助手无法成功解决问题,系统会逐步调用更高级(通常也更昂贵)的助手

- 直到问题被解决或所有可用助手都已尝试

这种方法确保了只有在必要时才会使用更昂贵的模型,从而优化了成本效益。

解决方案演示

解决方案演示是一种利用过去成功的查询-代码对来帮助解决未来查询的技术。每当一个查询被成功解决,系统就会将查询-代码对保存到数据库中。当新的查询出现时,系统会从数据库中检索最相似的查询,然后使用该查询及其相关代码作为上下文演示。

这种方法的工作流程如下:

- 系统成功解决一个查询,并将查询-代码对存储在数据库中

- 新的查询到来时,系统在数据库中搜索最相似的历史查询

- 系统将找到的相似查询及其解决方案作为示例,提供给LLM助手

- LLM助手基于这个示例,更准确地生成新查询的解决方案

解决方案演示旨在通过利用过去成功的查询-代码对来提高准确性。这种方法特别有效,因为它允许系统从过去的经验中学习,并将这些知识应用到新的、相似的问题上。

EcoAssistant的协同效应

助手层级和解决方案演示的结合产生了强大的协同效应,进一步放大了各自的优势。这是因为高性能模型的解决方案自然而然地被用来指导性能较弱的模型,而无需特殊设计。

例如,当一个复杂的查询首先由高级模型(如GPT-4)成功解决时,这个解决方案会被存储在数据库中。之后,当类似的查询出现时,即使是较低级的模型(如GPT-3.5-turbo)也可以利用这个存储的解决方案作为参考,从而提高其回答准确性。这种机制不仅提高了整体系统的性能,还减少了对昂贵模型的依赖。

EcoAssistant的实际应用优势

EcoAssistant在实际应用中展现出了显著的优势,特别是在处理与天气、股票和地点相关的查询时。根据研究结果,EcoAssistant在成功率上超过了单独的GPT-4助手10个百分点,同时成本不到GPT-4的50%。这意味着EcoAssistant不仅能提供更准确的回答,还能大幅降低运营成本。

以下是EcoAssistant在不同类型查询中的应用示例:

-

天气查询:

- 用户问题:"未来一周东京的最高温度是多少?"

- EcoAssistant可以高效地调用天气API,获取数据并准确计算结果。

-

股票信息:

- 用户问题:"过去一个月苹果公司的股票平均价格是多少?"

- 系统能够快速访问股票API,获取历史数据并进行计算。

-

地点信息:

- 用户问题:"巴黎最受欢迎的五个旅游景点是哪些?"

- EcoAssistant可以利用地点API获取信息,并根据评分或访问量排序。

在这些场景中,EcoAssistant不仅能提供准确的答案,还能通过智能选择最合适的LLM助手来优化成本。

如何使用EcoAssistant

对于希望使用EcoAssistant的开发者和研究人员,以下是一些基本的使用步骤:

-

环境准备:

- 确保您的系统安装了Python 3.10或更高版本。

- 克隆EcoAssistant的GitHub仓库。

-

安装依赖:

pip3 install -r requirements.txt -

配置API密钥:

- 在

keys.json文件中设置您的API密钥。

- 在

-

运行示例:

- EcoAssistant提供了多种运行模式,以下是一些示例命令:

运行GPT-3.5-turbo助手:

python3 run.py --data mixed_100 --seed 0 --api --model gpt-3.5-turbo运行完整的EcoAssistant(助手层级 + 解决方案演示):

python3 run.py --data mixed_100 --seed 0 --api --solution_demonstration --model gpt-3.5-turbo,gpt-4 -

分析结果:

- 运行结果将保存在

results文件夹中,您可以分析这些结果来评估EcoAssistant的性能。

- 运行结果将保存在

EcoAssistant的未来展望

虽然EcoAssistant已经展现出了显著的优势,但它仍有巨大的发展潜力。以下是一些可能的未来发展方向:

-

模型适应性:进一步提高EcoAssistant与不同LLM模型的兼容性,使其能够更灵活地适应新的语言模型。

-

领域扩展:除了当前擅长的天气、股票和地点查询外,探索将EcoAssistant应用到更多领域,如科学计算、数据分析等。

-

自动化优化:开发更智能的算法来自动调整助手层级和解决方案演示的参数,以适应不同类型的查询和用户需求。

-

多模态支持:扩展EcoAssistant的能力,使其能够处理包含图像、音频等多模态信息的查询。

-

隐私和安全增强:随着AI应用的普及,加强EcoAssistant在处理敏感信息时的隐私保护和安全措施将变得越来越重要。

结论

EcoAssistant代表了LLM助手技术的一个重要进步。通过巧妙地结合助手层级和解决方案演示,它成功地平衡了成本效益和回答准确性这两个关键因素。对于需要频繁使用LLM助手进行代码驱动问答的组织和个人来说,EcoAssistant提供了一个极具吸引力的解决方案。

随着AI技术的不断发展,我们可以期待看到更多像EcoAssistant这样的创新框架出现,它们将继续推动LLM应用的边界,使AI技术更加经济、高效和准确。对于开发者和研究人员来说,EcoAssistant不仅是一个强大的工具,也是一个激发进一步创新的源泉。

通过采用EcoAssistant,我们可以更好地利用LLM的力量,同时控制成本,这对于AI技术的广泛应用和可持续发展至关重要。随着更多人开始使用和贡献到这个开源项目,我们可以期待看到EcoAssistant在未来变得更加强大和多样化,为AI驱动的问答系统开辟新的可能性。