大型语言模型的效率优化:一项全面调查

近年来,大型语言模型(LLMs)在自然语言处理领域取得了突破性进展,展现出令人瞩目的能力。然而,这些模型的规模和复杂度也带来了巨大的计算和存储开销,严重限制了它们的广泛应用。因此,如何提高LLMs的效率成为了学术界和工业界共同关注的热点问题。本文对LLMs效率优化的最新研究进行了全面而系统的综述,旨在为研究人员和实践者提供一个有价值的参考资源。

1. 研究背景与意义

大型语言模型凭借其强大的自然语言理解和生成能力,在多个领域展现出巨大的应用潜力。然而,这些模型通常包含数十亿甚至数千亿个参数,训练和推理过程都需要消耗大量的计算资源和能源。例如,GPT-3模型包含1750亿个参数,其训练成本据估计高达数百万美元。这种高昂的资源需求不仅限制了LLMs在资源受限场景下的应用,也带来了严重的环境和经济问题。

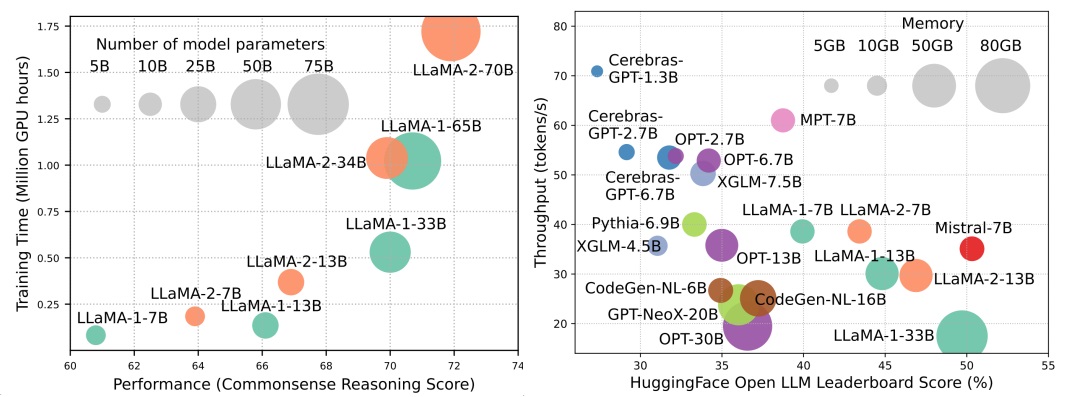

上图展示了LLMs模型规模与性能之间的关系。我们可以看到,随着模型参数量的增加,性能确实得到了提升,但同时训练时间(以GPU小时计)呈指数级增长。这凸显了提高LLMs效率的重要性和迫切性。

2. 效率优化的主要方向

本文将LLMs效率优化的研究分为三个主要方向:模型中心方法、数据中心方法和框架中心方法。

2.1 模型中心方法

模型中心方法主要关注如何优化模型本身的结构和参数,以减少计算和存储开销。这类方法包括:

-

模型压缩: 通过量化、剪枝、低秩近似等技术减少模型参数量和计算复杂度。

-

高效预训练: 采用混合精度训练、模型逐步扩展等策略提高预训练效率。

-

高效微调: 使用参数高效微调(PEFT)等技术,仅更新部分参数来适应下游任务。

-

高效推理: 通过并行解码、推测解码等方法加速模型推理过程。

-

高效架构: 设计更高效的注意力机制、混合专家模型等新型架构。

2.2 数据中心方法

数据中心方法聚焦于如何更高效地利用训练数据,主要包括:

-

数据选择: 通过智能筛选和采样,选择最有价值的数据进行训练。

-

提示工程: 设计高效的提示模板,提高模型在少样本学习场景下的表现。

2.3 框架中心方法

框架中心方法致力于优化LLMs的训练和部署系统,包括:

-

系统级优化: 针对预训练、推理服务等场景进行系统层面的优化。

-

算法-硬件协同设计: 结合特定硬件特性对算法进行定制优化。

-

LLM框架: 开发专门用于LLMs训练和部署的高效框架。

3. 关键技术详解

接下来,我们将对一些关键的效率优化技术进行更深入的讨论。

3.1 模型量化

模型量化是一种重要的模型压缩技术,它通过降低模型参数和激活值的数值精度来减少存储和计算开销。近年来,针对LLMs的量化技术取得了显著进展。

**后训练量化(PTQ)**是一种无需重新训练即可实现模型压缩的技术。例如,GPTQ(Accurate Quantization for Generative Pre-trained Transformers)提出了一种基于Hessian矩阵的量化方法,可以将LLMs量化到4位精度而几乎不损失性能。另一个代表性工作AWQ(Activation-aware Weight Quantization)则考虑了激活值的分布特征,提出了一种自适应的权重量化策略。

**量化感知训练(QAT)**则在训练过程中引入量化操作,使模型能够更好地适应低精度表示。例如,LLM-QAT提出了一种无需额外数据的量化感知训练方法,可以将LLMs量化到8位甚至更低的精度。

3.2 参数高效微调(PEFT)

参数高效微调技术旨在通过仅更新模型的一小部分参数来适应下游任务,从而大大降低微调的计算和存储成本。

**LoRA(Low-Rank Adaptation)**是一种广受欢迎的PEFT方法。它通过在原始权重矩阵旁边添加低秩矩阵来实现参数更新,既保持了模型的大部分知识,又具有很高的参数效率。例如,对于一个65B参数的模型,LoRA可以仅使用0.01%的可训练参数就达到与全参数微调相当的性能。

Prefix Tuning是另一种有效的PEFT方法。它在输入序列的前面添加一段可训练的前缀,通过优化这些前缀来适应下游任务。这种方法不仅参数高效,还表现出了良好的任务泛化性。

3.3 高效注意力机制

注意力机制是Transformer模型的核心组件,但其计算复杂度随序列长度的平方增长,成为LLMs效率的一个主要瓶颈。因此,设计高效的注意力机制成为了研究热点。

FlashAttention是一个突破性的工作,它通过优化GPU内存访问模式,实现了更快、更节省内存的注意力计算。在不改变模型结构的情况下,FlashAttention可以显著提高训练和推理速度。

Sparse Attention是另一类重要的优化方向。例如,BigBird提出了一种稀疏注意力模式,将注意力限制在局部窗口、随机连接和全局令牌上,从而将复杂度从O(n^2)降低到O(n)。这种方法不仅提高了效率,还使模型能够处理更长的序列。

4. 未来研究方向

尽管LLMs效率优化领域已经取得了显著进展,但仍然存在许多挑战和机遇:

-

模型压缩与性能权衡: 如何在保持模型性能的同时实现更极致的压缩比仍是一个开放问题。

-

长序列建模: 随着应用场景的扩展,如何高效处理更长的输入序列成为一个重要课题。

-

动态适应: 设计能够根据输入和任务动态调整计算资源的模型架构。

-

绿色AI: 开发更节能环保的训练和推理方法,减少AI对环境的影响。

-

硬件协同优化: 深入研究算法与新型AI芯片的协同设计,充分发挥硬件潜力。

5. 结论

本文对LLMs效率优化的研究进行了全面综述,涵盖了模型、数据和框架三个层面的优化技术。我们看到,通过量化、剪枝、高效微调、注意力优化等多种方法,LLMs的效率已经得到了显著提升。这些进展不仅降低了LLMs的使用门槛,也为其在更广泛场景下的应用铺平了道路。

然而,随着AI技术的不断发展和应用需求的日益多样化,LLMs的效率优化仍面临诸多挑战。未来的研究需要在保持模型能力的同事,进一步提高其计算效率、内存效率和能源效率。同时,如何设计更加灵活、可扩展的模型架构,以及如何更好地利用新型硬件,都是值得深入探索的方向。

我们相信,随着学术界和工业界的持续努力,未来必将涌现出更多创新的效率优化技术,推动LLMs在各个领域发挥更大的价值,为人工智能的发展做出重要贡献。