Torchattacks:功能强大的PyTorch对抗性攻击库

在深度学习和计算机视觉领域,对抗性攻击已经成为一个备受关注的研究方向。对抗性样本是经过精心设计的输入,旨在欺骗机器学习模型,导致错误的预测结果。Torchattacks作为一个专门用于生成对抗性样本的PyTorch库,为研究人员和开发者提供了强大的工具支持。本文将全面介绍Torchattacks的特性、使用方法以及支持的各种攻击算法。

Torchattacks简介

Torchattacks是一个专门为PyTorch用户设计的对抗性攻击库。它提供了PyTorch风格的接口和函数,使得实现各种对抗性攻击变得简单易用。以下是Torchattacks的一个简单使用示例:

import torchattacks

atk = torchattacks.PGD(model, eps=8/255, alpha=2/255, steps=4)

# 如果输入已经被归一化,则需要设置

# atk.set_normalization_used(mean=[...], std=[...])

adv_images = atk(images, labels)

主要特性

-

丰富的攻击算法: Torchattacks支持多种常用的对抗性攻击方法,如FGSM、PGD、CW等。

-

易用的接口: 库提供了统一的接口,使得不同攻击方法的使用方式保持一致。

-

灵活的配置: 用户可以轻松调整攻击参数,如扰动大小、迭代次数等。

-

目标攻击支持: 可以设置随机目标标签、最不可能的标签等多种目标攻击模式。

-

数据保存和加载: 提供了保存和加载对抗性样本的功能。

-

多重攻击: 支持组合多种攻击方法,形成更强大的攻击策略。

安装和要求

Torchattacks的安装非常简单,可以通过pip直接安装:

pip install torchattacks

使用Torchattacks需要满足以下要求:

- PyTorch版本 >= 1.4.0

- Python版本 >= 3.6

支持的攻击方法

Torchattacks支持多种对抗性攻击方法,以下是一些主要的攻击算法:

-

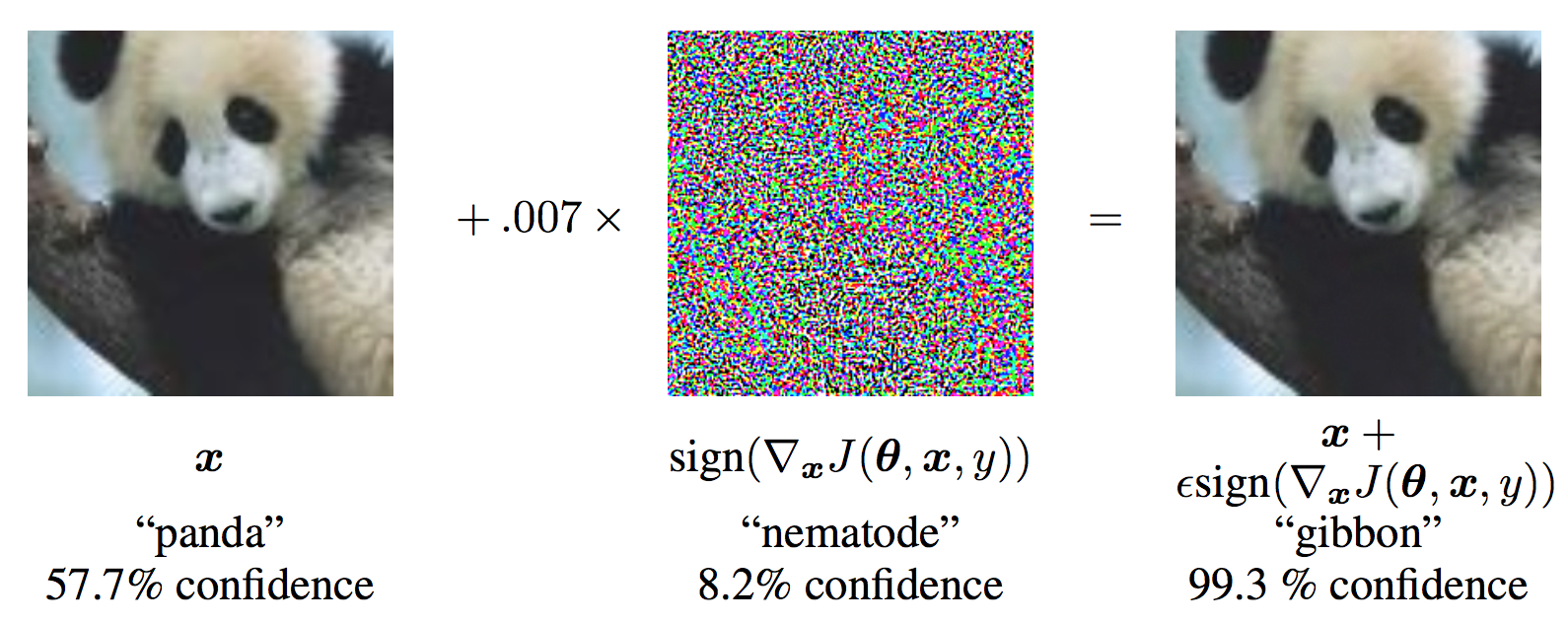

FGSM (Fast Gradient Sign Method)

- 论文: Explaining and Harnessing Adversarial Examples (Goodfellow et al., 2014)

- 特点: 快速生成对抗样本的基础方法

-

PGD (Projected Gradient Descent)

- 论文: Towards Deep Learning Models Resistant to Adversarial Attacks (Madry et al., 2017)

- 特点: 迭代式攻击,被认为是最强的一阶攻击方法之一

-

CW (Carlini & Wagner Attack)

- 论文: Towards Evaluating the Robustness of Neural Networks (Carlini et al., 2016)

- 特点: 强大的优化based攻击,可以生成高质量的对抗样本

-

DeepFool

- 论文: DeepFool: A Simple and Accurate Method to Fool Deep Neural Networks (Moosavi-Dezfooli et al., 2016)

- 特点: 生成最小扰动的对抗样本

-

AutoAttack

- 论文: Reliable Evaluation of Adversarial Robustness with an Ensemble of Diverse Parameter-free Attacks (Croce et al., 2020)

- 特点: 集成了多种无参数攻击方法,用于可靠的鲁棒性评估

图1: FGSM攻击示例,展示了原始图像、扰动和生成的对抗样本

使用指南

-

基本用法

import torchattacks atk = torchattacks.PGD(model, eps=8/255, alpha=2/255, steps=4) adv_images = atk(images, labels) -

设置目标攻击模式

# 随机目标标签 atk.set_mode_targeted_random() # 最不可能的标签 atk.set_mode_targeted_least_likely(kth_min) # 自定义目标函数 atk.set_mode_targeted_by_function(target_map_function=lambda images, labels:(labels+1)%10) -

保存和加载对抗样本

# 保存 atk.save(data_loader, save_path="./data.pt", verbose=True) # 加载 adv_loader = atk.load(load_path="./data.pt") -

多重攻击

atk1 = torchattacks.FGSM(model, eps=8/255) atk2 = torchattacks.PGD(model, eps=8/255, alpha=2/255, iters=40, random_start=True) atk = torchattacks.MultiAttack([atk1, atk2])

性能对比

Torchattacks在性能方面表现优异。与其他常用的对抗性攻击库(如Foolbox和ART)相比,Torchattacks在多种攻击方法上展现出更快的速度和更高的成功率。以下是在CIFAR10数据集上的部分性能对比结果:

| 攻击方法 | 包 | 标准模型 | Wong2020Fast | Rice2020Overfitting |

|---|---|---|---|---|

| FGSM | Torchattacks | 34% (54ms) | 48% (5ms) | 62% (82ms) |

| PGD | Torchattacks | 0% (174ms) | 44% (52ms) | 58% (1348ms) |

| CW | Torchattacks | 0% / 0.40 (2596ms) | 14% / 0.61 (3795ms) | 22% / 0.56 (43484ms) |

结论

Torchattacks为PyTorch用户提供了一个强大、灵活且易用的对抗性攻击工具库。它支持多种先进的攻击方法,并在性能和易用性方面都表现出色。无论是进行对抗性攻击研究,还是评估模型的鲁棒性,Torchattacks都是一个值得考虑的选择。

随着深度学习模型在各个领域的广泛应用,对模型安全性和鲁棒性的研究变得越来越重要。Torchattacks为这一研究方向提供了宝贵的工具支持,相信它将在未来的对抗性机器学习研究中发挥重要作用。

参考资源

- Torchattacks GitHub仓库: https://github.com/Harry24k/adversarial-attacks-pytorch

- Torchattacks文档: https://adversarial-attacks-pytorch.readthedocs.io/

通过深入了解和使用Torchattacks,研究人员和开发者可以更好地探索对抗性攻击的世界,为构建更安全、更鲁棒的机器学习模型贡献力量。