FlowFormer:光流估计的变革者

近年来,Transformer架构在计算机视觉领域取得了巨大成功。然而,传统Transformer的注意力机制计算复杂度为二次方,这极大地限制了其在处理长序列和大规模模型方面的应用。为了追求线性复杂度和通用性,研究人员提出了FlowFormer,这是一种专门用于光流估计的创新Transformer架构。

FlowFormer的核心创新

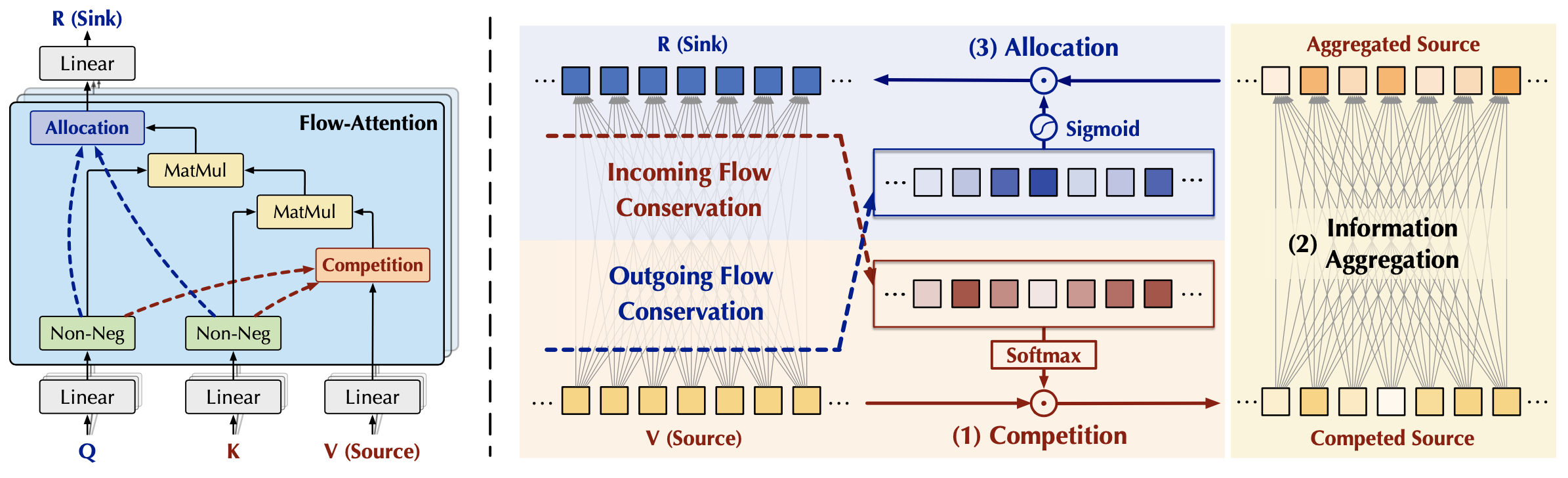

FlowFormer的核心创新在于其独特的注意力机制设计。研究人员将注意力机制重新构想为一个流网络,信息从源(值)流向汇(结果),流量由学习得到的流容量(注意力)控制。通过在源和汇两个方面引入守恒机制,FlowFormer巧妙地在注意力设计中引入了竞争,避免了平凡的注意力分布。

这种基于流网络理论的设计具有以下几个显著优势:

-

线性复杂度:相对于序列长度,FlowFormer实现了线性计算复杂度,能够处理超过4000个token的极长序列。

-

无特定归纳偏置:FlowFormer的设计纯粹源于流网络理论,没有引入特定的归纳偏置。

-

任务通用性:FlowFormer在长序列建模、计算机视觉、自然语言处理、时间序列分析和强化学习等多个领域都表现出色。

FlowFormer的架构设计

FlowFormer采用了编码器-解码器架构来处理代价体信息:

-

代价体编码器:将4D代价体嵌入到潜在代价空间,并在该空间中充分编码代价信息。

-

递归代价解码器:从编码后的潜在代价特征中估计光流,通过迭代细化来提高精度。

与之前的工作相比,FlowFormer的主要特点是采用了经过改进的Transformer架构来有效处理代价体,这是光流估计领域广泛使用的紧凑而丰富的表示。

FlowFormer的卓越性能

在Sintel基准测试中,FlowFormer取得了令人瞩目的成绩:

- 在Sintel clean pass上,平均端点误差(AEPE)为1.159,比此前最佳结果(1.388)减少了16.5%的误差。

- 在Sintel final pass上,AEPE为2.088,比此前最佳结果(2.47)减少了15.5%的误差。

更值得注意的是,FlowFormer展现出了强大的泛化能力。在未经Sintel数据集训练的情况下:

- 在Sintel clean pass训练集上,FlowFormer达到了0.64 AEPE,比此前最佳结果(1.29)减少了50.4%的误差。

- 在Sintel final pass训练集上,FlowFormer达到了1.50 AEPE,比此前最佳结果减少了45.3%的误差。

这些结果充分证明了FlowFormer在光流估计任务上的卓越性能和强大泛化能力。

FlowFormer的广泛应用

除了在光流估计任务上的出色表现,FlowFormer还在多个领域展现出了强大的通用性:

-

长序列建模:在LRA基准测试中,FlowFormer平均准确率达到56.48%,远超Performer(51.41%)和Reformer(50.67%)。

-

计算机视觉:在ImageNet-1K图像识别任务中,FlowFormer的Top-1准确率达到80.6%,超过了Performer(78.1%)和vanilla Transformer(78.7%)。

-

自然语言处理:在WikiText-103语言建模任务中,FlowFormer的困惑度降低到30.8,优于Performer(37.5)和vanilla Transformer(33.0)。

-

时间序列分析:在UEA时间序列分类任务中,FlowFormer的平均准确率达到73.0%,高于Performer(71.5%)和Reformer(71.9%)。

-

强化学习:在D4RL离线强化学习任务中,FlowFormer的平均奖励达到73.5±2.9,显著优于Performer(63.8±7.6)和Reformer(63.9±2.9)。

这些跨领域的出色表现充分证明了FlowFormer作为一种通用架构的潜力。

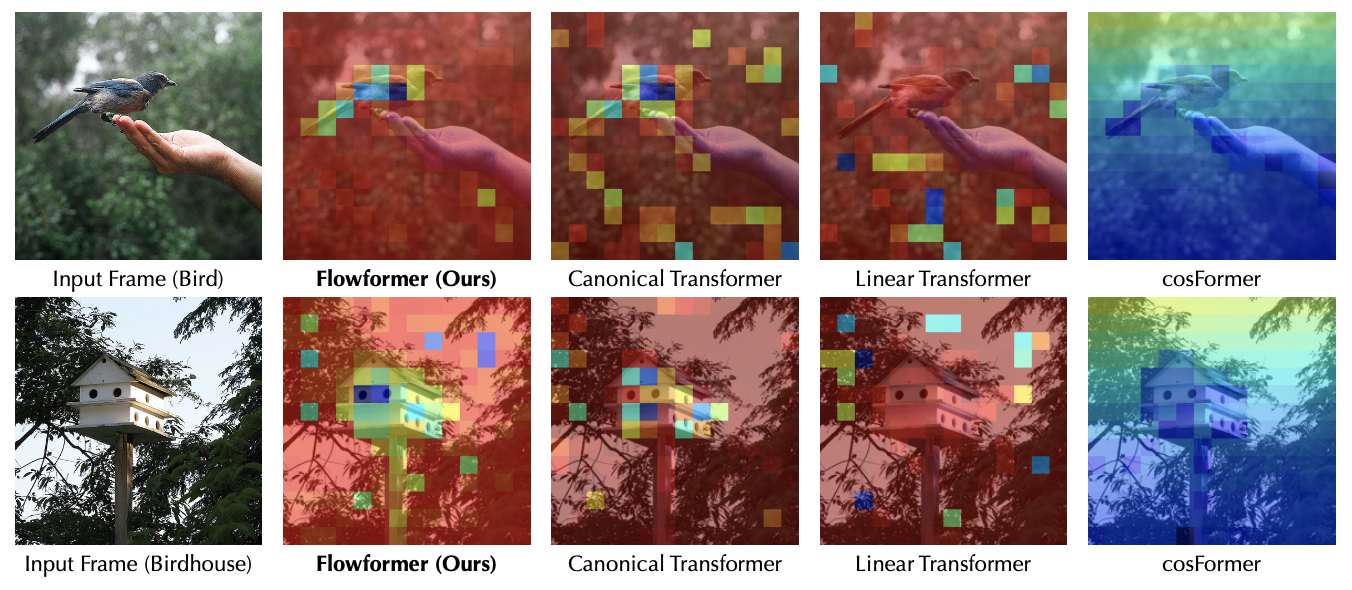

注意力可视化

为了更直观地理解FlowFormer的工作原理,研究人员对其注意力机制进行了可视化:

从可视化结果可以看出,FlowFormer能够成功捕捉图像中的关键部分,这对于准确估计光流至关重要。

FlowFormer的未来发展

鉴于FlowFormer在光流估计和其他领域展现出的巨大潜力,研究人员正在积极探索其进一步的应用和优化:

-

移动设备适配:最近发表在ICML 2024的Mobile-Attention是FlowFormer为移动设备量身定制的版本。通过将原有的注意力机制替换为Mobile-Attention,研究人员成功获得了更快速的模型。

-

CUDA加速:为了进一步提高FlowFormer的计算效率,研究团队正在开发CUDA加速版本,以充分利用GPU的并行计算能力。

-

跨领域应用:考虑到FlowFormer在多个领域的出色表现,研究人员正在探索将其应用于更多的任务和场景,如视频处理、医学图像分析等。

-

模型压缩:为了使FlowFormer更适合在资源受限的环境中部署,研究团队正在研究各种模型压缩技术,包括知识蒸馏、量化和剪枝等。

结语

FlowFormer作为一种创新的Transformer架构,不仅在光流估计任务上取得了突破性进展,还展现出了强大的跨领域应用潜力。它的成功不仅推动了光流估计技术的发展,也为Transformer在计算机视觉领域的应用开辟了新的方向。随着研究的深入和技术的不断优化,我们有理由相信FlowFormer将在更多领域发挥重要作用,为人工智能的发展做出更大贡献。