GaLore: 突破大型语言模型训练的内存瓶颈

在人工智能领域,大型语言模型(Large Language Models, LLMs)的训练一直面临着巨大的计算资源挑战,特别是在内存使用方面。随着模型规模的不断扩大,如何在有限的硬件资源下高效训练LLMs成为了研究人员和工程师们关注的焦点。近期,一项名为GaLore (Gradient Low-Rank Projection)的创新技术引起了广泛关注,它有望为这一难题提供突破性的解决方案。

GaLore技术简介

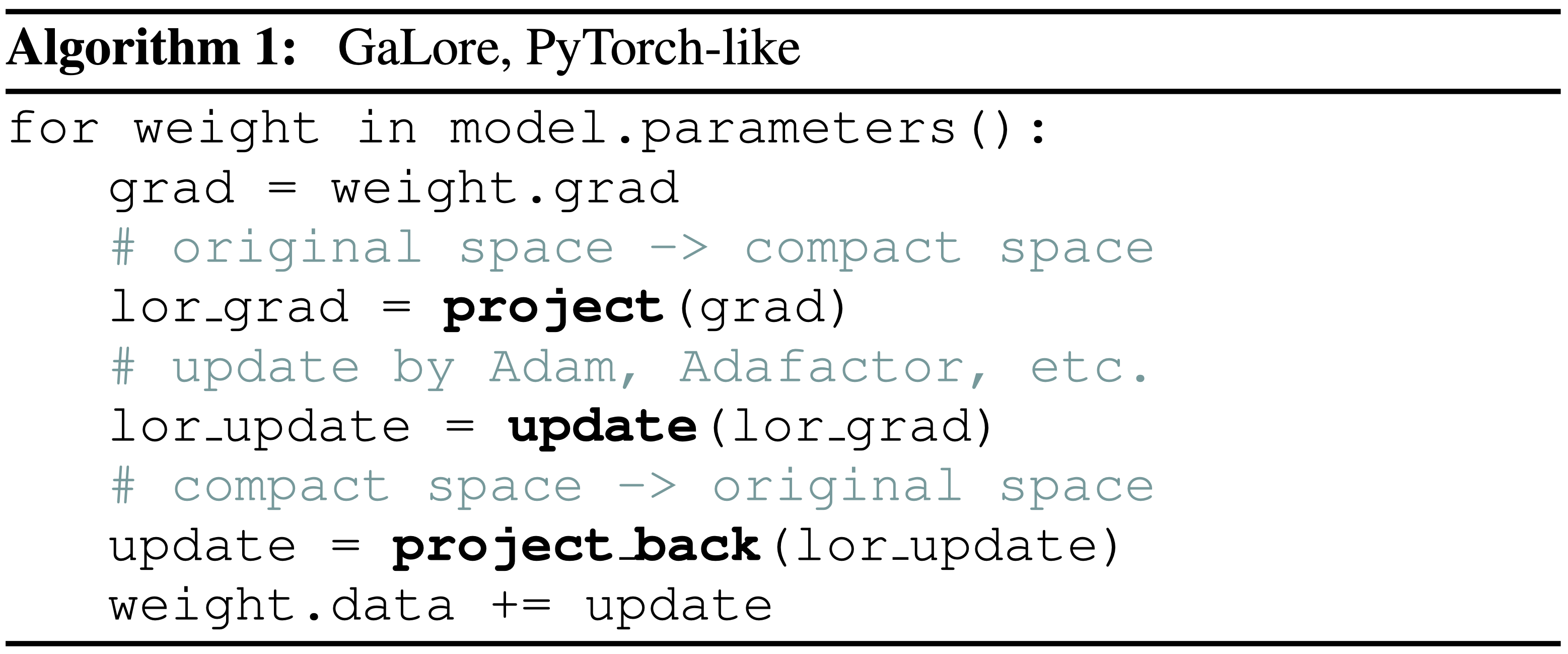

GaLore是由研究人员提出的一种新型内存高效低秩训练策略。与常见的低秩适应方法(如LoRA)相比,GaLore允许进行全参数学习,同时具有更高的内存效率。作为一种梯度投影方法,GaLore的一个显著优势是它独立于优化器的选择,可以轻松地集成到现有的优化器中,仅需添加两行代码即可实现。

上图展示了GaLore算法的核心实现,其简洁性和易用性令人印象深刻。这种设计使得GaLore能够快速地被集成到各种深度学习框架和项目中,大大降低了采用门槛。

GaLore的工作原理

GaLore的核心思想是通过梯度的低秩投影来减少内存使用。具体来说,它包含以下几个关键步骤:

-

梯度计算: 首先,像常规训练一样计算模型参数的梯度。

-

低秩投影: 将高维梯度投影到一个低维空间中,这一步显著减少了需要存储的数据量。

-

梯度更新: 使用投影后的低维梯度来更新模型参数。

-

周期性重构: 每隔一定的迭代次数,重新构建投影矩阵,以确保捕获梯度的主要信息。

这种方法允许在保持全参数学习能力的同时,大幅减少内存占用,从而使得在有限的硬件资源下训练更大规模的模型成为可能。

GaLore的优势

-

内存效率: 相比传统方法,GaLore能显著降低训练过程中的内存使用,使得在单个GPU上训练大型模型成为可能。

-

全参数学习: 与其他参数高效微调方法不同,GaLore允许对模型的所有参数进行学习,潜在地提供更好的性能。

-

优化器兼容性: GaLore可以与各种现有的优化器无缝集成,无需对优化算法进行大幅修改。

-

易于实现: 只需添加几行代码就可以将GaLore集成到现有的训练流程中。

-

灵活性: GaLore提供了多个可调节的超参数,允许用户根据具体任务和资源限制进行优化。

实际应用案例

为了展示GaLore的实际效果,研究人员进行了一系列实验。其中最引人注目的是在单个24GB显存的GPU上训练7B参数的LLaMA模型。

# LLaMA-7B, 8-bit GaLore-Adam, single GPU, activation checkpointing

# bsz=16, 22.8G,

torchrun --standalone --nproc_per_node 1 torchrun_main.py \

--model_config configs/llama_7b.json \

--lr 0.005 \

--galore_scale 0.25 \

--rank 1024 \

--update_proj_gap 500 \

--batch_size 16 \

--total_batch_size 512 \

--activation_checkpointing \

--num_training_steps 150000 \

--warmup_steps 15000 \

--weight_decay 0 \

--grad_clipping 1.0 \

--dtype bfloat16 \

--eval_every 1000 \

--single_gpu \

--optimizer galore_adamw8bit_per_layer

这个实验证明,通过使用GaLore技术,即使是配备NVIDIA RTX 4090这样的消费级GPU,也能够支持大型语言模型的训练,这对于个人研究者和小型团队来说是一个巨大的突破。

GaLore的未来发展

目前,GaLore团队正在积极开发该技术的官方发布版本。未来的版本将包括以下重要特性:

- 多GPU训练支持(DDP和FSDP)的每层权重更新。

- 内存高效的低秩梯度累积。

- 优化的

GaLoreAdamW8bit实现。

这些改进将进一步提升GaLore的性能和适用性,使其能够在更广泛的场景中发挥作用。

社区参与和讨论

GaLore项目已经在GitHub上开源,并得到了广泛的关注。研究人员和开发者们正积极地将GaLore集成到各种平台中,包括HuggingFace、LLaMA-Factory和Axolotl等。

为了促进交流和协作,GaLore团队创建了一个名为GaLore-Social的Slack工作空间。在这里,研究者、开发者和用户可以直接与GaLore的创建者和其他社区成员进行讨论,分享经验,提出问题,并获得支持。

性能评估

为了全面评估GaLore的性能,研究团队设计了两个主要的基准测试:

-

在C4数据集上预训练LLaMA模型: 这个测试旨在评估GaLore在大规模语言模型预训练中的表现。研究人员提供了一系列脚本,用于训练从60M到7B参数不等的模型。

-

在GLUE任务上微调RoBERTa模型: 这个测试主要关注GaLore在下游任务微调中的效果。研究者们提供了详细的脚本,展示了如何将GaLore应用于常见的NLP任务。

这些基准测试不仅展示了GaLore的强大性能,还为其他研究者提供了可复现的实验设置,有助于进一步的研究和改进。

结语

GaLore技术的出现无疑为大型语言模型的训练带来了新的可能性。它不仅大大降低了硬件门槛,还保持了模型的全参数学习能力,为AI研究和应用开辟了新的道路。随着GaLore的不断发展和完善,我们有理由相信,它将在未来的AI领域发挥越来越重要的作用,推动大型语言模型的普及和应用。

对于有兴趣深入了解或尝试GaLore的读者,可以访问GaLore的GitHub仓库获取更多信息和代码实现。无论你是研究人员、开发者还是AI爱好者,GaLore都为你提供了一个探索大型语言模型训练新方法的绝佳机会。让我们共同期待GaLore带来的更多突破和创新! 🚀🧠💡