Gollama: 您的终端中的离线AI助手

在人工智能和机器学习快速发展的今天,管理和使用各种AI模型已经成为许多开发者和研究人员的日常工作。然而,如何高效地管理这些模型一直是一个挑战。为了解决这个问题,一款名为Gollama的创新工具应运而生,它为Ollama模型管理提供了一个简洁而强大的解决方案。

Gollama简介

Gollama是一个专为macOS和Linux设计的Ollama模型管理工具。它提供了一个文本用户界面(TUI),让用户可以方便地列出、检查、删除、复制和推送Ollama模型。此外,Gollama还支持将模型链接到LM Studio,为用户提供了更多的灵活性和选择。

这个项目最初是作者Sam McLeod对他之前的llamalink项目的重写,但随着开发的深入,Sam决定扩展其功能,使其成为一个更加用户友好和功能丰富的工具。

Gollama的主要特性

Gollama提供了一系列强大的功能,使得模型管理变得简单而高效:

-

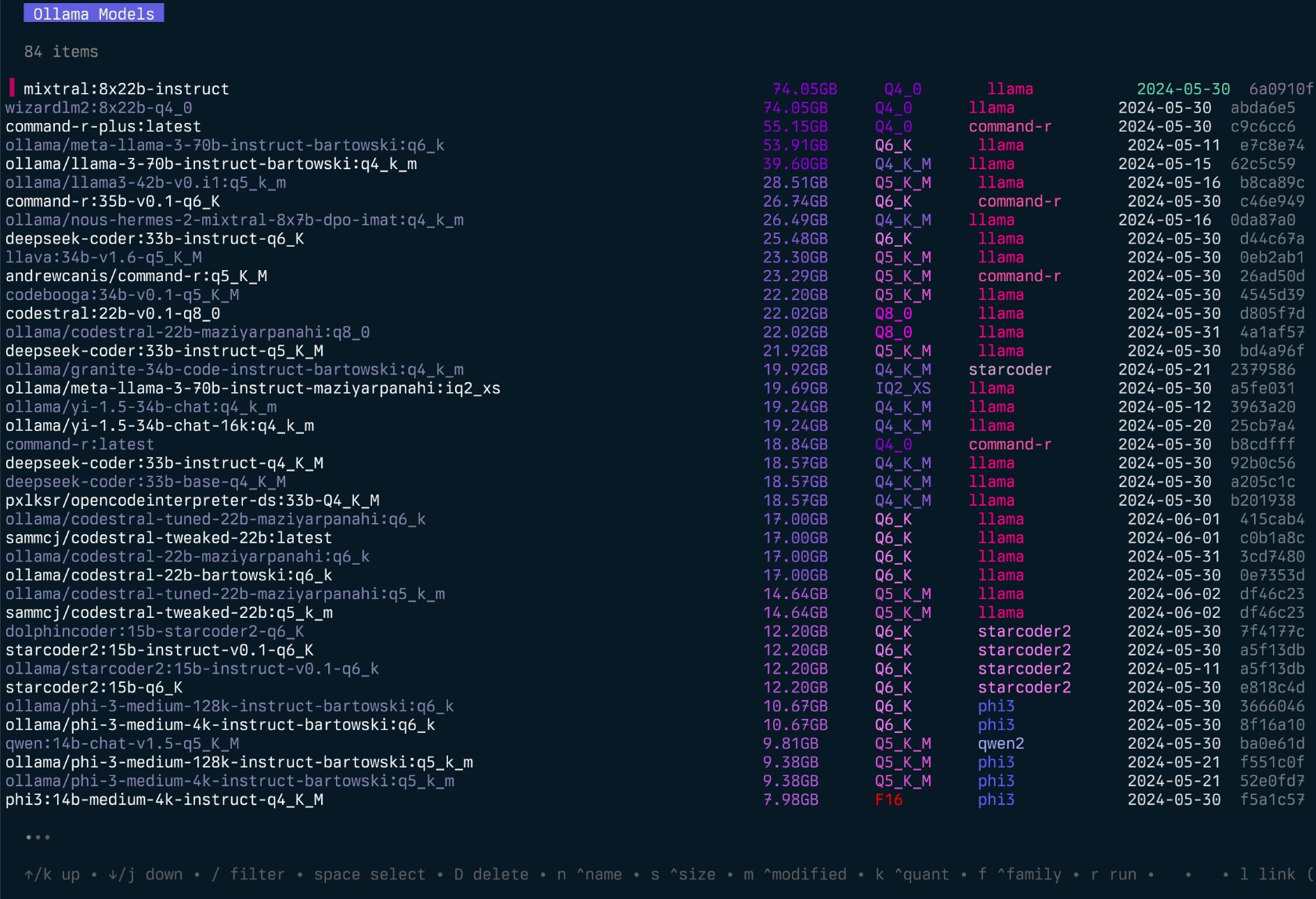

模型列表和元数据显示: 用户可以轻松查看可用的模型列表,并显示诸如大小、量化级别、模型系列和修改日期等重要元数据。

-

模型文件编辑: 支持编辑和更新模型的Modelfile,为用户提供了灵活的定制选项。

-

多维度排序: 可以根据名称、大小、修改日期、量化级别和系列等多个维度对模型进行排序。

-

模型操作: 支持选择和删除模型,运行和卸载模型,以及检查模型的详细信息。

-

vRAM使用估算: 能够计算模型的大致vRAM使用情况,帮助用户合理分配资源。

-

LM Studio集成: 支持将模型链接到LM Studio,增加了工具的实用性。

-

模型复制和重命名: 提供了模型复制和重命名的功能,方便用户管理不同版本的模型。

-

模型推送: 支持将模型推送到注册表,便于模型的分享和部署。

-

运行模型显示: 可以显示当前正在运行的模型,方便监控和管理。

安装和使用

Gollama的安装非常简单。用户可以通过Go或者直接从GitHub下载最新的发布版本来安装。

通过Go安装:

go install github.com/sammcj/gollama@HEAD

从GitHub安装:

- 访问Gollama的发布页面

- 下载最新版本

- 解压并将二进制文件移动到PATH目录中

例如:

unzip gollama*.zip && mv gollama /usr/local/bin

安装完成后,只需在终端中输入gollama即可启动应用程序。为了更方便地访问,你可以为Gollama创建一个别名:

echo "alias g=gollama" >> ~/.zshrc

Gollama的使用界面

Gollama提供了一个直观的文本用户界面,使用一系列快捷键来执行各种操作:

Space: 选择模型Enter: 运行模型(Ollama run)i: 检查模型详情t: 显示正在运行的模型D: 删除模型e: 编辑模型c: 复制模型U: 卸载所有模型p: 拉取现有模型g: 拉取(获取)新模型P: 推送模型n: 按名称排序s: 按大小排序m: 按修改日期排序k: 按量化级别排序f: 按系列排序l: 将模型链接到LM StudioL: 将所有模型链接到LM Studior: 重命名模型(正在开发中)q: 退出

vRAM估算功能

Gollama的一个特别强大的功能是其vRAM估算工具。这个功能可以帮助用户:

- 计算已拉取的Ollama模型或Hugging Face模型ID的vRAM使用情况

- 确定给定vRAM约束下的最大上下文长度

- 找到给定vRAM和上下文约束下的最佳量化设置

- 显示不同k/v缓存量化选项(fp16, q8_0, q4_0)的估算结果

要使用vRAM估算功能,只需在命令行中输入:

gollama --vram <model_name>

例如:

gollama --vram llama3.1:8b-instruct-q6_K

这将显示一个表格,展示不同量化类型和上下文大小的vRAM使用情况。

配置和自定义

Gollama使用位于~/.config/gollama/config.json的JSON配置文件。用户可以通过这个文件来自定义排序选项、显示列、API密钥、日志级别等设置。

一个典型的配置文件可能如下所示:

{

"default_sort": "modified",

"columns": [

"Name",

"Size",

"Quant",

"Family",

"Modified",

"ID"

],

"ollama_api_key": "",

"ollama_api_url": "http://localhost:11434",

"lm_studio_file_paths": "",

"log_level": "info",

"log_file_path": "/Users/username/.config/gollama/gollama.log",

"sort_order": "Size",

"strip_string": "my-private-registry.internal/",

"editor": "",

"docker_container": ""

}

这些配置选项让用户可以根据自己的需求来定制Gollama的行为和外观。

社区和贡献

Gollama是一个开源项目,欢迎社区成员的贡献。如果你发现了bug或者有新的功能建议,可以在GitHub上提出issue或者提交pull request。项目的维护者Sam McLeod非常欢迎社区的参与和反馈。

总结

Gollama为AI模型管理提供了一个强大而简洁的解决方案。无论你是AI研究人员、开发者还是爱好者,Gollama都能帮助你更高效地管理和使用Ollama模型。通过其直观的界面和丰富的功能,Gollama大大简化了模型管理的过程,让用户可以将更多的精力集中在模型的应用和开发上。

随着AI技术的不断发展,像Gollama这样的工具将在未来扮演越来越重要的角色。它不仅提高了工作效率,也为AI生态系统的发展做出了贡献。如果你正在寻找一个可靠的Ollama模型管理工具,Gollama绝对值得一试。

相关链接

通过使用Gollama,你可以更轻松地探索和利用AI模型的力量,推动你的项目和研究更上一层楼。无论你是刚开始接触AI,还是已经是经验丰富的专家,Gollama都能为你的工作流程带来显著的改善。让我们一起拥抱AI的未来,用Gollama来管理我们的模型之旅吧!