H-Transformer-1D: 突破性的层次化注意力机制

在自然语言处理和序列学习领域,Transformer架构已经成为主流模型之一。然而,传统Transformer在处理长序列时面临着计算复杂度过高的挑战。近期,研究人员提出了一种创新的模型 - H-Transformer-1D,通过巧妙的层次化注意力机制,成功将复杂度从二次降低到线性,为长序列处理开辟了新的可能性。

创新的层次化注意力设计

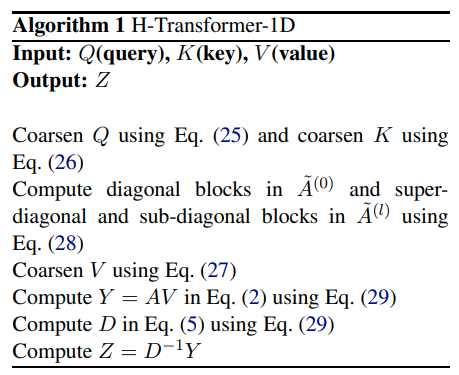

H-Transformer-1D的核心创新在于其层次化的注意力计算方法。该模型借鉴了数值分析中的层次矩阵(H-Matrix)结构,将输入序列划分为多个块,并在不同层次上进行注意力计算。这种设计不仅降低了计算复杂度,还能有效捕捉序列中的长距离依赖关系。

如上图所示,H-Transformer-1D将输入序列分为多个块,并通过多层次的注意力计算来处理序列内的信息交互。这种层次化的结构使得模型能够在保持高效计算的同时,不损失对全局信息的感知能力。

卓越的性能表现

在长序列处理的基准测试Long Range Arena上,H-Transformer-1D的编码器版本(非自回归)展现出了优异的性能,目前保持着该基准测试的最佳记录。这一成就充分证明了H-Transformer-1D在处理长序列任务时的强大能力。

此外,H-Transformer-1D在One-Billion Word数据集上的测试困惑度也创造了新的记录,而且仅使用了之前最佳Transformer模型五分之一的参数量。这不仅展示了模型的高效性,也体现了其在大规模语言建模任务上的潜力。

技术细节与实现

H-Transformer-1D的实现相对简单,但蕴含了深刻的技术洞见。以下是模型的一些关键特性:

-

线性复杂度: 通过巧妙的层次化设计,H-Transformer-1D将注意力计算的时间和内存复杂度从O(n^2)降低到O(n),其中n为序列长度。

-

可逆网络: 模型支持使用可逆网络技术,这允许在增加模型深度的同时节省内存使用。

-

灵活的序列长度: H-Transformer-1D能够处理可变长度的输入序列,自动进行填充和层次化注意力计算。

-

实验性功能: 模型引入了token shifting技术,通过在序列维度上移动一半的特征空间,加速模型收敛。

以下是使用PyTorch实现H-Transformer-1D的示例代码:

import torch

from h_transformer_1d import HTransformer1D

model = HTransformer1D(

num_tokens = 256, # 词汇表大小

dim = 512, # 模型维度

depth = 12, # 层数

causal = False, # 是否为因果模型

max_seq_len = 8192, # 最大序列长度

heads = 8, # 注意力头数

dim_head = 64, # 每个头的维度

block_size = 128, # 块大小

reversible = True, # 是否使用可逆网络

shift_tokens = True # 是否使用token shifting

)

# 生成随机输入

x = torch.randint(0, 256, (1, 8000)) # 可变序列长度

mask = torch.ones((1, 8000)).bool() # 可变掩码长度

# 前向传播

logits = model(x, mask = mask) # 输出形状: (1, 8000, 256)

这段代码展示了如何初始化H-Transformer-1D模型并进行前向传播。模型能够自动处理不同长度的输入序列,并进行必要的填充和层次化注意力计算。

广泛的应用前景

H-Transformer-1D的创新设计为长序列处理开辟了新的可能性,其潜在应用领域包括但不限于:

-

长文本理解: 能够处理更长的文档,如学术论文、法律文书等。

-

时间序列分析: 在金融、气象等领域分析长时间跨度的数据。

-

基因组学: 分析长基因序列,助力生物信息学研究。

-

音频处理: 处理长音频片段,如语音识别和音乐分析。

-

视频分析: 理解长视频序列中的时空依赖关系。

结论与展望

H-Transformer-1D的出现无疑为序列学习领域注入了新的活力。通过巧妙的层次化设计,该模型成功突破了传统Transformer的计算瓶颈,为处理超长序列提供了高效可行的解决方案。

未来,我们可以期待看到H-Transformer-1D在更多领域的应用和优化。研究人员可能会进一步探索如何将这种层次化思想扩展到其他类型的神经网络中,或者结合其他先进技术来进一步提升模型性能。

H-Transformer-1D的成功也启发我们思考:在深度学习领域,突破性的进展往往来自于对基础结构的创新思考。通过结合跨学科的知识和洞见,我们有可能发现更多高效、强大的神经网络架构,推动人工智能技术的不断进步。

随着H-Transformer-1D等创新模型的不断涌现,我们正在逐步接近能够理解和处理真实世界中复杂、长序列数据的智能系统。这不仅将推动自然语言处理等领域的发展,也将为人工智能在更广泛领域的应用铺平道路。

参考资料

-

Zhu, Z., & Soricut, R. (2021). H-Transformer-1D: Fast One-Dimensional Hierarchical Attention for Sequences. arXiv preprint arXiv:2107.11906.