MLPerf基准测试:AI性能评估的黄金标准

在人工智能和机器学习快速发展的今天,如何客观公正地评估不同AI系统的性能成为了一个关键问题。MLPerf基准测试应运而生,成为了业界公认的AI性能评估标准。本文将深入解析MLPerf基准测试的最新结果,探讨其对AI硬件和软件创新的深远影响。

MLPerf基准测试简介

MLPerf是由MLCommons组织开发和维护的一套开源基准测试套件,旨在以架构中立、具有代表性和可重复的方式对机器学习系统的性能进行基准测试。它涵盖了从数据中心到边缘设备的各种部署场景,测量硬件系统运行AI和机器学习模型的速度。

MLPerf基准测试的主要特点包括:

- 开源和同行评审:确保测试的公平性和透明度

- 涵盖多种场景:包括数据中心和边缘计算

- 实际应用为导向:使用实际场景和数据集进行测试

- 跨平台比较:支持不同设备、操作系统和处理器架构之间的比较

MLPerf Inference v4.1最新结果解析

MLCommons最近发布了MLPerf Inference v4.1基准测试的最新结果。这次发布包含了964个性能结果,来自22个提交组织,展示了业界的广泛参与。以下是一些关键亮点:

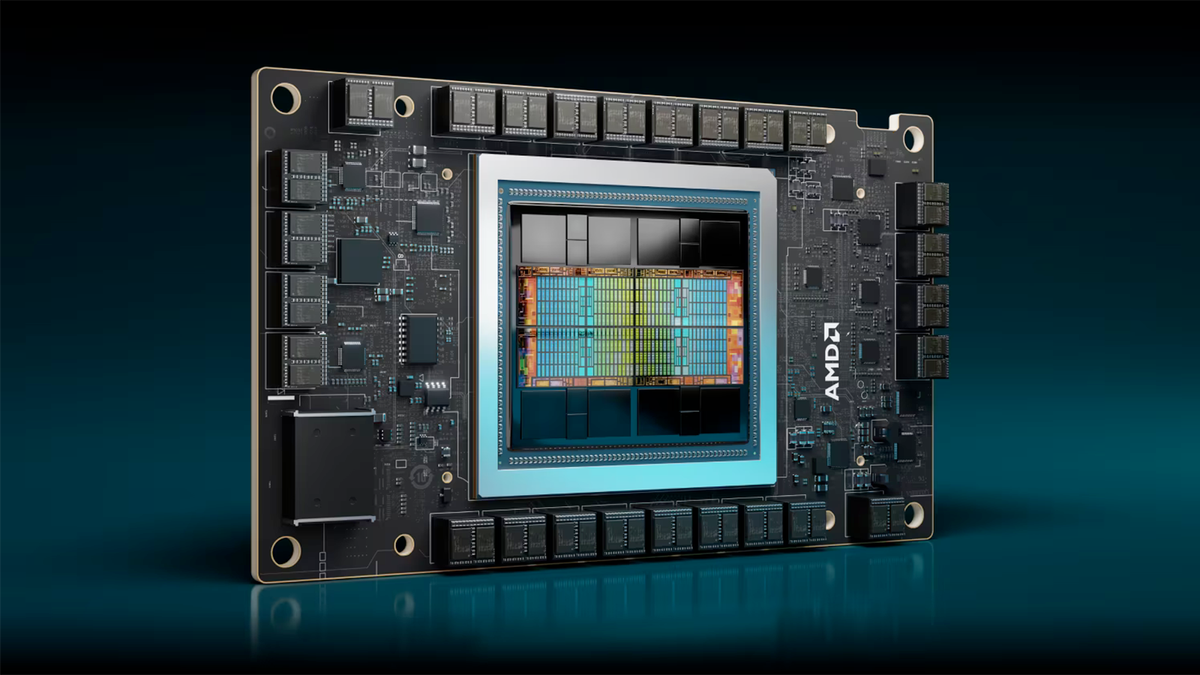

- 新处理器首秀:包括AMD MI300x加速器、Google "Trillium" TPUv6e加速器、NVIDIA "Blackwell" B200加速器等6款新处理器首次亮相。

- 混合专家(MoE)模型基准测试:首次引入基于MoE架构的基准测试,使用开源Mixtral 8x7B模型作为参考实现。

- 功耗测试:包含31个功耗消耗测试结果,反映了业界对AI系统能效的关注。

- 性能提升:新一代处理器展现出显著的性能提升,如NVIDIA的B200相比前代H100在某些测试中快了4倍。

MLPerf推动AI硬件和软件创新

MLPerf基准测试不仅仅是一个评估工具,更是推动整个AI产业创新的重要力量。通过设立统一的性能标准,MLPerf激励了硬件厂商和软件开发者不断优化their产品:

- 硬件创新:芯片厂商针对MLPerf测试场景优化硬件设计,如增加内存带宽、提升计算能力等。

- 软件优化:软件栈的优化对性能提升至关重要,如NVIDIA的软件优化使其在Llama 2 70B模型上表现出色。

- 新架构探索:MoE基准测试的引入推动了业界对新型AI模型架构的研究。

- 能效提升:功耗测试促使厂商在提升性能的同时关注能源效率。

MLPerf对AI行业的影响

MLPerf基准测试对AI行业产生了深远影响:

- 公平竞争:为不同厂商的产品提供了一个公平的比较平台。

- 技术透明:帮助客户了解AI系统的真实性能,做出明智的采购决策。

- 创新驱动:通过定期更新测试标准,推动整个行业不断创新。

- 跨平台对比:使得不同平台间的性能对比成为可能,如AMD和NVIDIA产品的直接对比。

- 行业合作:促进了行业内的合作,如多家公司共同参与基准测试的制定和优化。

未来展望

随着AI技术的快速发展,MLPerf基准测试也在不断演进:

- 新模型支持:未来可能会加入更多新兴AI模型的测试,如大型语言模型(LLM)。

- 更全面的评估:除了性能,可能会加入更多维度的评估,如模型精度、训练时间等。

- 边缘AI重视:随着边缘计算的兴起,针对边缘设备的测试可能会得到更多关注。

- 实际应用场景:未来可能会加入更多贴近实际应用的测试场景。

结语

MLPerf基准测试作为AI性能评估的行业标准,正在推动整个AI生态系统的快速发展。它不仅为硬件和软件创新提供了方向,也为用户选择AI系统提供了可靠的参考。随着AI技术的不断进步,MLPerf也将继续演进,为AI行业的健康发展保驾护航。

无论您是AI研究人员、开发者,还是企业决策者,关注MLPerf基准测试结果都将帮助您更好地把握AI技术的发展趋势,做出更明智的技术选择和投资决策。让我们共同期待AI技术在MLPerf的推动下,为人类社会带来更多惊喜和价值。