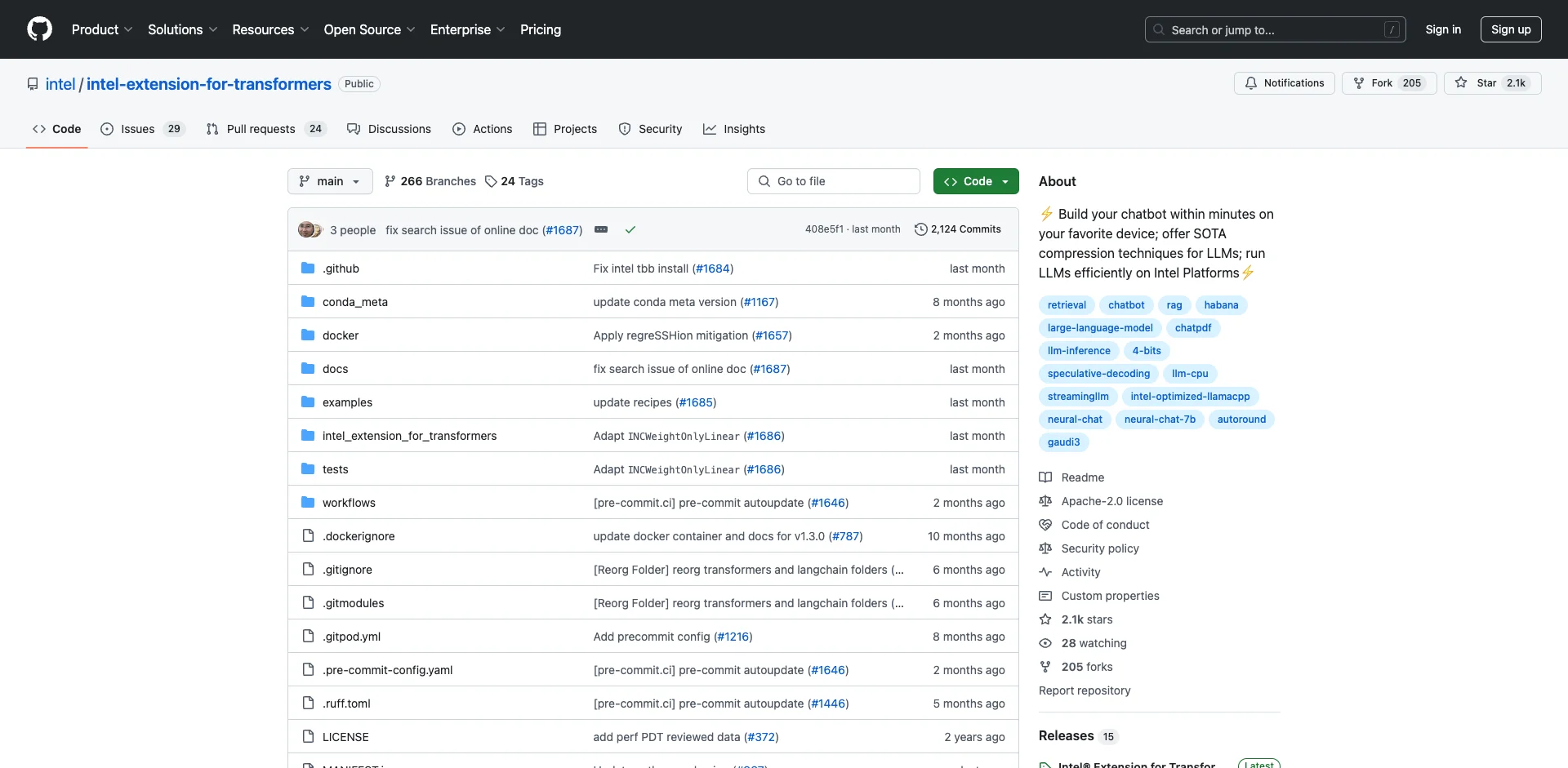

Intel Extension for Transformers简介

Intel Extension for Transformers是Intel开发的一个创新工具包,旨在优化Intel平台(包括Gaudi2、CPU和GPU)上Transformer模型的性能。它提供了一系列功能来加速生成式AI和大型语言模型(LLM)的部署。

主要特性

-

模型压缩:通过扩展Hugging Face transformers API和利用Intel Neural Compressor,提供无缝的模型压缩体验。

-

软件优化:提供先进的软件优化和独特的压缩感知运行时。

-

预优化模型包:包括Stable Diffusion、GPT-J-6B、BLOOM-176B等多个优化过的Transformer模型。

-

NeuralChat:一个可定制的聊天机器人框架,可以在几分钟内创建自己的聊天机器人。

-

高效推理:支持在Intel CPU和GPU上进行LLM的纯C/C++推理,支持多种模型。

快速入门

安装

pip install intel-extension-for-transformers

创建聊天机器人示例

from intel_extension_for_transformers.neural_chat import build_chatbot

chatbot = build_chatbot()

response = chatbot.predict("Tell me about Intel Xeon Scalable Processors.")

INT4量化推理示例 (CPU)

from transformers import AutoTokenizer

from intel_extension_for_transformers.transformers import AutoModelForCausalLM

model_name = "Intel/neural-chat-7b-v3-1"

prompt = "Once upon a time, there existed a little girl,"

tokenizer = AutoTokenizer.from_pretrained(model_name, trust_remote_code=True)

inputs = tokenizer(prompt, return_tensors="pt").input_ids

model = AutoModelForCausalLM.from_pretrained(model_name, load_in_4bit=True)

outputs = model.generate(inputs)

学习资源

总结

Intel Extension for Transformers为在Intel平台上优化和部署Transformer模型提供了强大的工具和资源。通过本文的介绍和提供的资源链接,读者可以快速上手使用该工具包,加速自己的AI模型开发和部署过程。