jetson-inference:在NVIDIA Jetson上部署深度学习推理网络的指南

jetson-inference是一个开源项目,为NVIDIA Jetson设备提供了深度学习推理和实时视觉的DNN库。这个项目使用TensorRT在GPU上运行优化的网络,支持C++和Python编程,并使用PyTorch进行模型训练。

项目概述

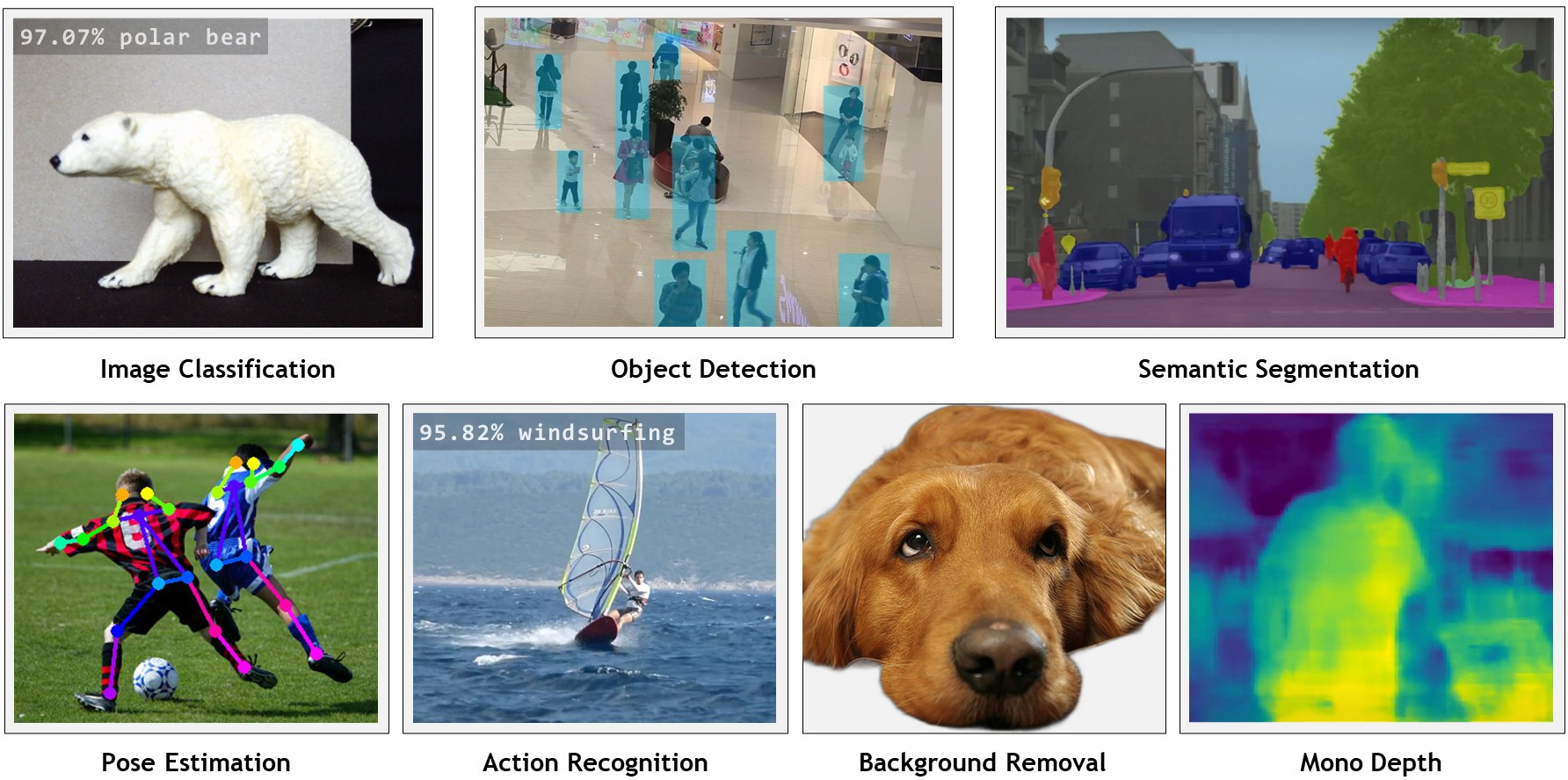

jetson-inference项目的主要目标是为开发者提供一个易于使用的深度学习推理框架,特别针对NVIDIA Jetson系列设备进行了优化。它支持多种常见的计算机视觉任务,包括:

- 图像分类 (imageNet)

- 目标检测 (detectNet)

- 语义分割 (segNet)

- 姿态估计 (poseNet)

- 动作识别 (actionNet)

除了这些核心功能外,该项目还提供了丰富的示例代码、预训练模型以及详细的文档,方便开发者快速上手和部署自己的应用。

主要特性

-

优化的推理性能: 利用TensorRT引擎,在Jetson设备上实现高效的深度学习推理。

-

多语言支持: 提供C++和Python API,满足不同开发者的需求。

-

预训练模型: 包含多个常用视觉任务的预训练模型,可直接使用。

-

易于扩展: 支持用户训练和部署自定义模型。

-

实时处理: 支持从摄像头实时流处理图像和视频。

-

WebRTC支持: 可以创建基于Web的实时视觉应用。

-

ROS/ROS2集成: 提供与机器人操作系统(ROS)的集成支持。

入门指南

要开始使用jetson-inference,您需要按照以下步骤进行:

-

系统设置:

- 使用JetPack设置您的Jetson设备

- 运行Docker容器或从源代码构建项目

-

推理入门:

- 尝试图像分类、目标检测等基本任务

- 学习如何使用Python或C++编写自己的推理程序

-

模型训练:

- 学习使用PyTorch进行迁移学习

- 收集和准备自己的数据集

- 训练自定义的分类或检测模型

-

高级应用:

- 探索语义分割、姿态估计等高级视觉任务

- 尝试使用WebRTC创建Web应用

- 将深度学习模型集成到ROS项目中

代码示例

jetson-inference提供了丰富的代码示例,涵盖了各种视觉任务。以下是一些核心功能的Python示例代码片段:

# 图像分类

import jetson.inference

import jetson.utils

net = jetson.inference.imageNet("googlenet")

img = jetson.utils.loadImage("object.jpg")

class_id, confidence = net.Classify(img)

print(f"Image is recognized as {net.GetClassDesc(class_id)} with {confidence*100:.2f}% confidence")

# 目标检测

detector = jetson.inference.detectNet("ssd-mobilenet-v2")

detections = detector.Detect(img)

for detection in detections:

print(f"Detected {detection.ClassID} - {detection.Confidence}")

# 语义分割

segnet = jetson.inference.segNet("fcn-resnet18-cityscapes-512x256")

segmentation = segnet.Process(img)

这些示例展示了如何使用jetson-inference库进行基本的视觉任务。开发者可以基于这些示例,根据自己的需求进行扩展和定制。

预训练模型

jetson-inference项目提供了多种预训练模型,涵盖了不同的视觉任务和网络架构。以下是一些可用的预训练模型:

-

图像分类模型:

- AlexNet, GoogleNet, ResNet (多个版本), VGG, Inception-v4等

-

目标检测模型:

- SSD-Mobilenet (v1和v2), SSD-Inception-v2

- 专门的检测模型如PeopleNet, DashCamNet, FaceDetect等

-

语义分割模型:

- 基于FCN-ResNet18的多个模型,适用于不同数据集(如Cityscapes, Pascal VOC等)

-

姿态估计模型:

- 用于人体和手部姿态估计的ResNet和DenseNet模型

-

动作识别模型:

- 基于Kinetics数据集的ResNet模型

这些预训练模型使得开发者可以快速开始实验和部署,而无需从头训练模型。

性能优化

jetson-inference项目特别注重在Jetson设备上的性能优化。通过使用TensorRT,模型可以在Jetson的GPU上高效运行。例如,某些分割模型在Jetson Nano上可以达到48 FPS,在Jetson Xavier上甚至可以达到480 FPS。

社区和支持

作为一个开源项目,jetson-inference拥有活跃的开发者社区。NVIDIA还提供了额外的学习资源,如Jetson AI认证课程和视频教程,帮助开发者更好地理解和使用这个框架。

结论

jetson-inference为在NVIDIA Jetson设备上开发和部署深度学习应用提供了一个强大而灵活的框架。无论是初学者还是经验丰富的开发者,都可以利用这个项目快速构建高性能的计算机视觉应用。随着AI边缘计算的不断发展,jetson-inference将继续在嵌入式AI领域发挥重要作用。

通过jetson-inference,开发者可以轻松地将先进的计算机视觉技术集成到各种应用中,从智能监控系统到自动驾驶汽车,再到工业机器人,可能性是无限的。随着项目的不断发展和社区的贡献,我们可以期待看到更多创新和令人兴奋的应用在Jetson平台上实现。