Knowledge Distillation Toolkit简介

Knowledge Distillation Toolkit是一个强大的知识蒸馏工具包,旨在帮助研究人员和开发者高效地压缩机器学习模型。该工具包基于PyTorch和PyTorch Lightning构建,提供了一套完整的知识蒸馏流程,使用户能够轻松地将大型复杂的教师模型的知识转移到更小的学生模型中,从而在保持模型性能的同时显著减小模型体积。

主要特性

- 基于PyTorch和PyTorch Lightning,兼容性强

- 支持多种知识蒸馏方法

- 提供完整的训练和推理流程

- 灵活的配置选项

- 详细的文档和示例

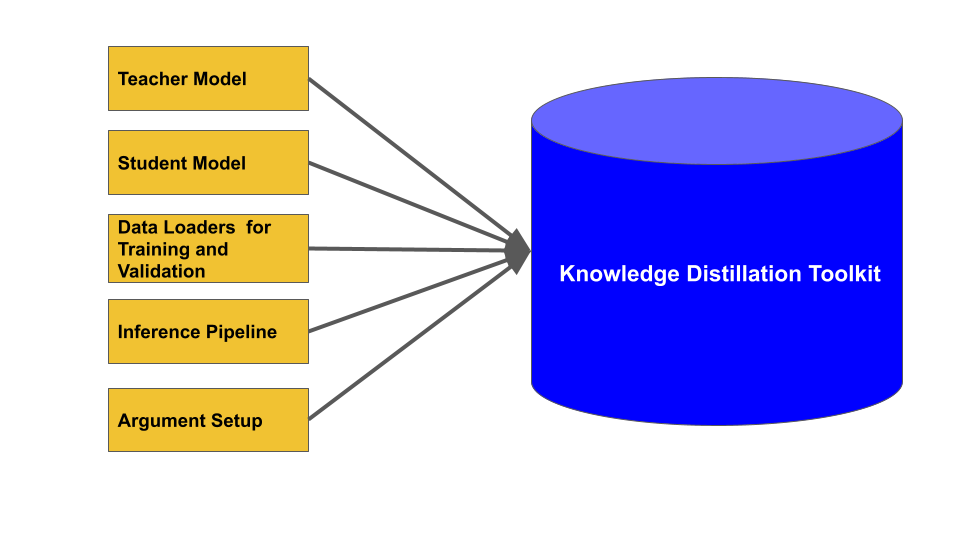

工具包使用流程

使用Knowledge Distillation Toolkit进行模型压缩的一般流程如下:

- 准备教师模型和学生模型

- 定义推理管道

- 准备训练和验证数据加载器

- 配置知识蒸馏训练参数

- 实例化KnowledgeDistillationTraining类

- 开始知识蒸馏训练

准备模型

首先,用户需要准备一个预训练好的教师模型和一个待训练的学生模型。这两个模型都需要是PyTorch的nn.Module子类。例如:

import torch.nn as nn

class TeacherModel(nn.Module):

def forward(self, x):

# 教师模型的前向传播逻辑

pass

class StudentModel(nn.Module):

def forward(self, x):

# 学生模型的前向传播逻辑

pass

teacher_model = TeacherModel()

student_model = StudentModel()

定义推理管道

接下来,需要定义一个推理管道类,用于在验证数据集上评估模型性能:

class InferencePipeline:

def __init__(self):

# 初始化设置

pass

def run_inference_pipeline(self, model, data_loader):

# 在验证数据集上评估模型性能

accuracy = 0

# 计算准确率的逻辑

return {"inference_result": accuracy}

准备数据加载器

为训练和验证准备PyTorch的DataLoader:

train_data_loader = torch.utils.data.DataLoader(train_dataset)

val_data_loaders = {"validation": torch.utils.data.DataLoader(val_dataset)}

配置训练参数

设置知识蒸馏训练的各项参数:

training_config = {

"num_gpu_used": 1,

"max_epoch": 100,

"temperature": 2,

"optimize_method": "adam",

"scheduler_method": "cosine_anneal",

"learning_rate": 0.001,

"num_lr_warm_up_epoch": 5,

"final_loss_coeff_dict": {"kd_loss": 0.5, "ce_loss": 0.5},

# 其他参数...

}

实例化训练类并开始训练

最后,实例化KnowledgeDistillationTraining类并开始训练:

kd_training = KnowledgeDistillationTraining(

train_data_loader=train_data_loader,

val_data_loaders=val_data_loaders,

inference_pipeline=InferencePipeline(),

student_model=student_model,

teacher_model=teacher_model,

**training_config

)

kd_training.start_kd_training()

深入理解知识蒸馏原理

知识蒸馏是一种模型压缩技术,其核心思想是利用一个大型的、性能优秀的教师模型来指导一个更小的学生模型的学习。这个过程不仅传递了教师模型对正确类别的预测,还传递了对其他类别的软预测,这些软预测包含了教师模型学到的丰富知识。

温度缩放

在知识蒸馏中,温度(Temperature)是一个重要的超参数。它用于"软化"模型的输出概率分布:

def soften_probabilities(logits, temperature):

return torch.softmax(logits / temperature, dim=-1)

较高的温度会使概率分布更加平滑,有助于传递更多的知识。

损失函数

Knowledge Distillation Toolkit的损失函数通常包含两部分:

- 蒸馏损失(KL散度):衡量学生模型和教师模型输出分布的差异

- 学生损失:通常是交叉熵损失,确保学生模型能够正确分类

kd_loss = F.kl_div(student_log_prob, teacher_prob, reduction='batchmean') * (temperature**2)

ce_loss = F.cross_entropy(student_logits, labels)

total_loss = alpha * kd_loss + (1 - alpha) * ce_loss

其中alpha是一个平衡系数,用于调节两种损失的权重。

高级使用技巧

多GPU训练

Knowledge Distillation Toolkit支持多GPU训练,可以通过设置num_gpu_used参数来启用:

training_config["num_gpu_used"] = 4 # 使用4个GPU

学习率调度

工具包提供了多种学习率调度策略,如线性衰减和余弦退火:

training_config["scheduler_method"] = "cosine_anneal"

梯度累积

对于大型模型或小批量大小,可以使用梯度累积来模拟更大的批量:

training_config["accumulate_grad_batches"] = 4

实验日志

通过集成Comet.ml,可以方便地记录和可视化实验结果:

training_config["log_to_comet"] = True

training_config["comet_info_path"] = "path/to/comet_info.txt"

案例研究:压缩ResNet模型

为了展示Knowledge Distillation Toolkit的实际应用,我们来看一个压缩ResNet模型的例子。在这个案例中,我们将使用预训练的ResNet50作为教师模型,ResNet18作为学生模型。

准备模型

首先,我们导入预训练的ResNet模型:

import torchvision.models as models

teacher_model = models.resnet50(pretrained=True)

student_model = models.resnet18(pretrained=False)

定义推理管道

接下来,我们定义一个简单的推理管道来评估模型在ImageNet验证集上的性能:

class ImageNetInferencePipeline:

def __init__(self):

self.device = torch.device("cuda" if torch.cuda.is_available() else "cpu")

def run_inference_pipeline(self, model, data_loader):

model.eval()

correct = 0

total = 0

with torch.no_grad():

for images, labels in data_loader:

images, labels = images.to(self.device), labels.to(self.device)

outputs = model(images)

_, predicted = outputs.max(1)

total += labels.size(0)

correct += predicted.eq(labels).sum().item()

accuracy = correct / total

return {"inference_result": accuracy}

配置训练参数

我们设置知识蒸馏训练的参数:

training_config = {

"num_gpu_used": 1,

"max_epoch": 100,

"temperature": 4,

"optimize_method": "adam",

"scheduler_method": "cosine_anneal",

"learning_rate": 0.001,

"num_lr_warm_up_epoch": 5,

"final_loss_coeff_dict": {"kd_loss": 0.7, "ce_loss": 0.3},

"log_to_comet": True,

"comet_exp_name": "ResNet50_to_ResNet18_distillation"

}

开始训练

最后,我们实例化KnowledgeDistillationTraining类并开始训练:

kd_training = KnowledgeDistillationTraining(

train_data_loader=train_loader,

val_data_loaders={"imagenet_val": val_loader},

inference_pipeline=ImageNetInferencePipeline(),

student_model=student_model,

teacher_model=teacher_model,

**training_config

)

kd_training.start_kd_training()

通过这个过程,我们可以将ResNet50的知识成功蒸馏到ResNet18中,得到一个更小但性能接近的模型。

结论

Knowledge Distillation Toolkit为模型压缩和知识蒸馏提供了一个强大而灵活的解决方案。通过使用这个工具包,研究人员和开发者可以轻松地将大型模型的知识转移到更小的模型中,实现模型的高效部署。

尽管该项目目前已被标记为废弃,但其中的核心思想和实现方法仍然具有重要的参考价值。研究人员和开发者可以基于这个工具包的设计理念,开发自己的知识蒸馏框架,或者探索更先进的模型压缩技术。

随着深度学习模型规模的不断增长,模型压缩技术将在未来扮演越来越重要的角色。Knowledge Distillation Toolkit为我们提供了一个很好的起点,让我们能够更好地理解和应用知识蒸馏技术,为构建高效、轻量级的AI模型贡献力量。