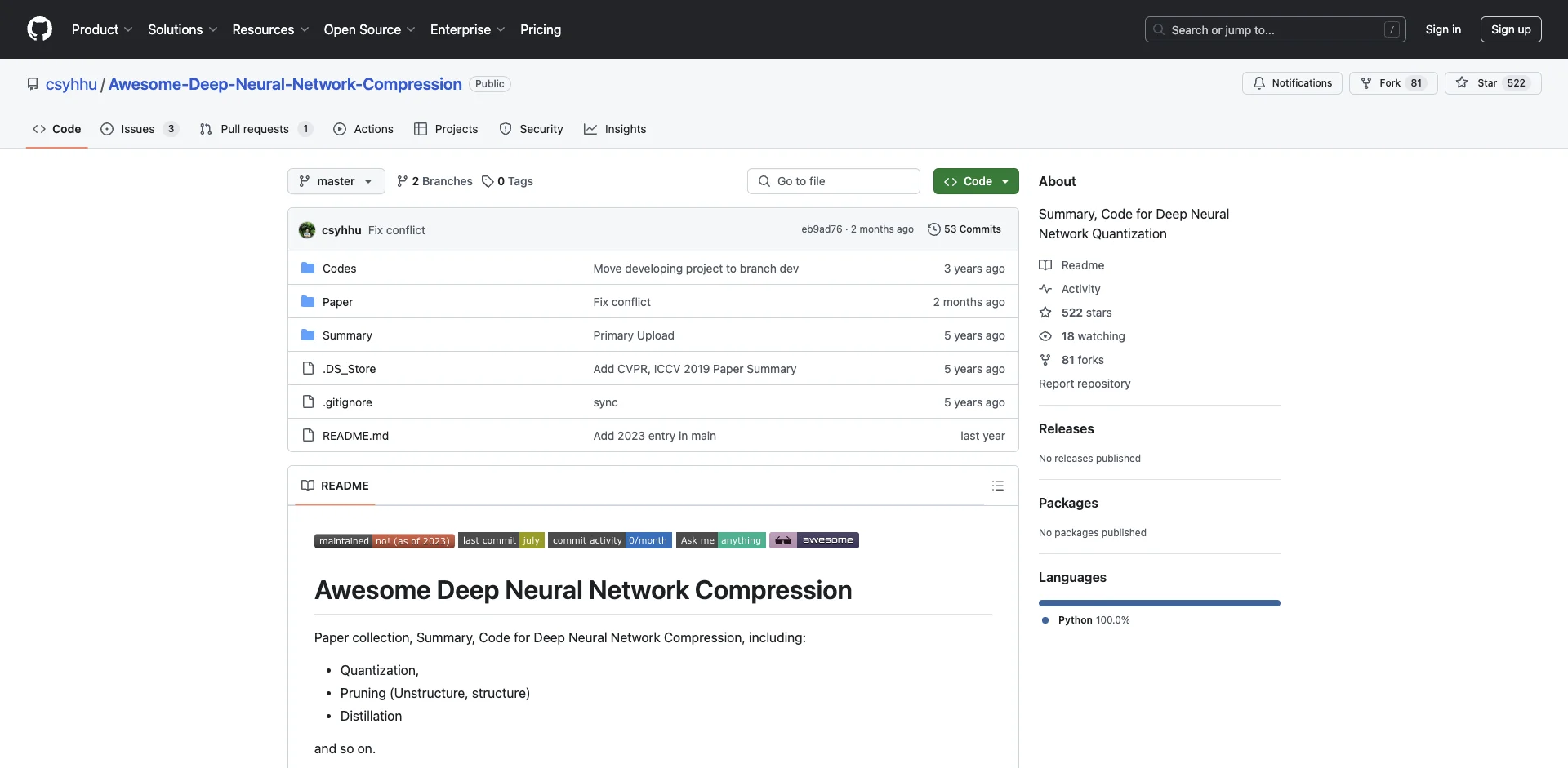

深度神经网络压缩技术综述与最新进展

随着深度学习技术的快速发展,神经网络模型规模越来越大,对计算资源和存储空间的需求也不断增加。为了将深度学习模型部署到资源受限的终端设备上,深度神经网络压缩技术应运而生,并成为学术界和工业界关注的热点研究方向。本文将全面介绍深度神经网络压缩的主要方法、最新进展和未来发展趋势。

1. 深度神经网络压缩概述

深度神经网络压缩的目标是在保持模型性能的前提下,减小模型大小、降低计算复杂度和内存占用。主要的压缩方法包括:

- 量化(Quantization):将网络参数和激活值从浮点数转换为低比特定点数表示

- 剪枝(Pruning):移除网络中冗余或不重要的连接和神经元

- 知识蒸馏(Knowledge Distillation):将大模型(教师模型)的知识转移到小模型(学生模型)

- 低秩分解(Low-rank Factorization):利用矩阵分解降低参数冗余

- 轻量级网络设计:从头设计计算高效的网络结构

这些方法各有优缺点,在实际应用中通常需要结合使用以达到最佳压缩效果。

2. 量化技术

量化是一种广泛使用的模型压缩方法,其核心思想是用低比特表示替代原始的32位浮点数,从而大幅降低模型size和计算复杂度。

2.1 量化方法分类

根据量化过程是否需要重新训练,量化方法可分为:

- 训练后量化(Post-training Quantization):直接将预训练模型的参数量化,无需重新训练

- 量化感知训练(Quantization-aware Training):在训练过程中模拟量化效果,使网络适应量化误差

根据量化精度,又可分为:

- 8比特量化:工业界最常用的量化方案,精度损失很小

- 4/2比特量化:更激进的低比特量化方案

- 二值网络/三值网络:将权重约束为{-1,+1}或{-1,0,+1}

2.2 量化关键技术

量化过程面临的主要挑战是如何降低量化带来的精度损失。一些关键技术包括:

- 非均匀量化:根据参数分布特点采用非线性量化

- 混合精度量化:对不同层采用不同的量化比特数

- 量化校准:通过少量校准数据优化量化参数

- 知识蒸馏辅助:利用教师模型指导量化模型训练

2.3 最新进展

量化技术近年来取得了显著进展:

- 8比特INT8量化已经在工业界广泛应用,精度接近FP32

- 4比特甚至2比特量化在某些任务上也能达到可用精度

- 二值网络在准确率方面逐步接近全精度网络

- 无需重训练的后量化技术不断突破,如数据自由量化等

3. 剪枝技术

网络剪枝通过移除冗余或不重要的连接和神经元来压缩模型。剪枝可以显著降低模型参数量和计算复杂度,是一种有效的压缩方法。

3.1 剪枝方法分类

根据剪枝粒度,可分为:

- 非结构化剪枝:以单个权重为粒度进行剪枝

- 结构化剪枝:以通道、滤波器等为粒度进行剪枝

根据剪枝策略,可分为:

- 一次性剪枝:一次性移除大比例权重

- 迭代式剪枝:多轮交替进行剪枝和微调

3.2 剪枝关键技术

剪枝的关键在于如何评估参数重要性以及如何保持模型精度。主要技术包括:

- 重要性评估:基于权重大小、梯度、激活值等指标

- 敏感性分析:分析不同层对剪枝的敏感程度

- 知识保持:通过知识蒸馏等方法保留原始模型知识

- 动态剪枝:根据输入动态调整剪枝策略

3.3 最新进展

剪枝技术的最新进展主要体现在:

- 结构化剪枝方法不断涌现,如MetaPruning、EagleEye等

- 与NAS结合的可微分剪枝方法,如DARTS-Pruning

- 动态剪枝在视觉任务中取得突破性进展

- 大规模预训练模型的高效剪枝方法

4. 知识蒸馏

知识蒸馏是一种模型压缩与加速方法,其核心思想是将训练好的大型复杂模型(教师模型)的知识迁移到小型简单模型(学生模型)中。

4.1 蒸馏方法分类

根据迁移的知识类型,可分为:

- 响应蒸馏:迁移softmax输出

- 特征蒸馏:迁移中间层特征

- 关系蒸馏:迁移样本间的关系知识

根据教师模型数量,可分为:

- 单教师蒸馏

- 多教师蒸馏

- 自蒸馏

4.2 蒸馏关键技术

知识蒸馏的关键在于如何有效地提取和迁移知识。主要技术包括:

- 温度调节:调整softmax温度参数

- 注意力迁移:迁移注意力图等高阶知识

- 在线蒸馏:训练过程中动态更新教师模型

- 对抗蒸馏:引入对抗学习提升蒸馏效果

4.3 最新进展

知识蒸馏近年来的主要进展包括:

- 引入互信息等信息论工具指导知识迁移

- 结合NAS自动搜索最优的学生模型结构

- 大规模预训练模型的高效蒸馏方法

- 跨模态知识迁移,如视觉-语言模型间的蒸馏

5. 高效网络设计

除了对已有模型进行压缩,直接设计高效的网络结构也是一种重要的研究方向。

5.1 设计策略

高效网络的主要设计策略包括:

- 深度可分离卷积:如MobileNet系列

- 通道shuffle:如ShuffleNet

- 特征重用:如DenseNet

- 神经架构搜索(NAS):自动搜索高效结构

5.2 代表性工作

一些有影响力的高效网络包括:

- MobileNetV1/V2/V3系列

- ShuffleNetV1/V2

- EfficientNet系列

- RegNet

这些网络在ImageNet等任务上取得了接近大型网络的精度,同时具有显著更低的计算量。

5.3 最新进展

高效网络设计的最新进展主要体现在:

- 引入动态卷积等自适应机制

- 探索新的激活函数如GELU、Swish等

- 结合NAS自动搜索最优网络结构

- 针对特定硬件平台的定制化设计

6. 压缩技术在预训练大模型中的应用

近年来以BERT、GPT为代表的大规模预训练模型在NLP等领域取得了突破性进展。然而这些模型通常包含数亿甚至数百亿参数,给实际部署带来了巨大挑战。因此,如何压缩预训练大模型成为研究热点。

6.1 主要压缩方法

针对预训练大模型的主要压缩方法包括:

- 模块化剪枝:如结构化剪枝、LayerDrop等

- 知识蒸馏:如DistilBERT、TinyBERT等

- 量化:如Q-BERT等

- 参数共享:如ALBERT等

- 动态推理:如FastBERT等

6.2 技术难点

与传统CNN相比,压缩预训练大模型面临一些特殊挑战:

- 模型规模巨大,传统方法难以扩展

- 预训练-微调范式下如何保持通用性

- 自注意力结构给剪枝带来困难

- 语言模型对精度更敏感

6.3 最新进展

近期在压缩预训练大模型方面的一些重要进展:

- 提出更适合Transformer的结构化剪枝方法

- 探索预训练阶段引入稀疏性的方法

- 结合模型并行等分布式技术的压缩方案

- 针对下游任务的自适应压缩方法

7. 压缩技术在实际部署中的挑战与解决方案

虽然模型压缩技术在学术界取得了显著进展,但在工业界大规模应用仍面临一些挑战。

7.1 主要挑战

- 通用性:压缩后模型在不同任务上的表现不一致

- 鲁棒性:压缩可能降低模型对对抗样本等的鲁棒性

- 可解释性:压缩过程影响模型的可解释性

- 部署友好性:学术界方法可能不适合实际硬件

- 版权问题:知识蒸馏等方法面临法律风险

7.2 解决方案

针对这些挑战,一些可能的解决方案包括:

- 探索任务无关的通用压缩方法

- 将对抗训练等技术与压缩相结合

- 发展可解释的压缩方法

- 考虑硬件特性的协同设计

- 发展数据自由、模型自由的压缩技术

8. 未来趋势与展望

展望未来,深度神经网络压缩技术可能的发展趋势包括:

-

与神经架构搜索(NAS)更紧密结合,自动搜索最优压缩策略

-

探索端到端的可微分压缩方法,实现压缩过程的自动化

-

发展适用于新兴AI任务(如多模态学习)的压缩技术

-

结合联邦学习等隐私保护技术的分布式模型压缩

-

针对新型计算硬件(如类脑芯片)的定制化压缩方案

-

探索模型压缩的理论基础,如信息瓶颈理论等

-

将压缩技术与模型并行、流水线并行等大模型训练技术结合

总的来说,随着AI技术向更复杂、更智能的方向发展,模型压缩将继续发挥重要作用,使先进的AI算法能够真正走入日常生活的方方面面。未来还有很多值得探索的方向,需要学术界和工业界的持续努力。

参考文献

-

Han, S., Pool, J., Tran, J., & Dally, W. (2015). Learning both weights and connections for efficient neural network. Advances in neural information processing systems, 28.

-

Howard, A. G., Zhu, M., Chen, B., Kalenichenko, D., Wang, W., Weyand, T., ... & Adam, H. (2017). Mobilenets: Efficient convolutional neural networks for mobile vision applications. arXiv preprint arXiv:1704.04861.

-

Hinton, G., Vinyals, O., & Dean, J. (2015). Distilling the knowledge in a neural network. arXiv preprint arXiv:1503.02531.

-

Wang, K., Liu, Z., Lin, Y., Lin, J., & Han, S. (2019). Haq: Hardware-aware automated quantization with mixed precision. In Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition (pp. 8612-8620).

-

Liu, Z., Sun, M., Zhou, T., Huang, G., & Darrell, T. (2019). Rethinking the value of network pruning. arXiv preprint arXiv:1810.05270.

-

Tan, M., & Le, Q. (2019). Efficientnet: Rethinking model scaling for convolutional neural networks. In International Conference on Machine Learning (pp. 6105-6114). PMLR.

-

Sanh, V., Debut, L., Chaumond, J., & Wolf, T. (2019). DistilBERT, a distilled version of BERT: smaller, faster, cheaper and lighter