KoboldCpp:为大语言模型应用带来革命性变化

在人工智能和自然语言处理领域,大语言模型(LLMs)正在快速发展,为各种应用带来新的可能性。然而,如何高效地运行和管理这些庞大的模型一直是一个挑战。KoboldCpp应运而生,作为一款革命性的工具,它正在改变我们使用和部署大语言模型的方式。

KoboldCpp简介

KoboldCpp是一款专为GGML和GGUF模型设计的AI文本生成软件。它的灵感来自原始的KoboldAI项目,但在功能和性能上有了显著的提升。KoboldCpp由Concedo开发,基于llama.cpp构建,为用户提供了一个功能丰富且易于使用的平台,使大语言模型的应用变得前所未有的简单。

主要特性

-

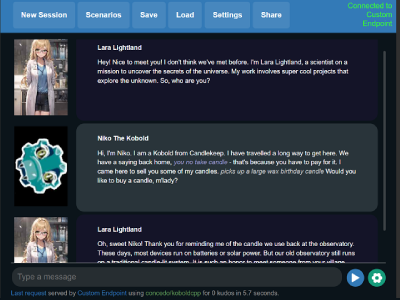

易用性:KoboldCpp提供了一个直观的图形用户界面(GUI),使得即使是新手用户也能轻松上手。

-

强大的GPU加速:通过利用GPU的计算能力,KoboldCpp能够显著提高模型的运行速度。用户可以根据自己的硬件配置选择使用CUDA(NVIDIA GPU)、ROCm(AMD GPU)或Vulkan(通用GPU支持)。

-

多模型支持:KoboldCpp支持широкий范围的GGUF模型,包括Llama、Mistral、GPT-NeoX、GPT-J等众多流行模型。

-

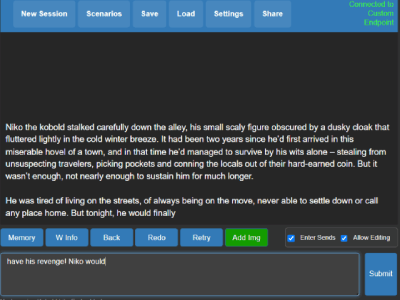

丰富的文本生成选项:用户可以通过调整各种参数来控制文本生成的过程,如上下文大小、生成长度、采样方法等。

-

集成的Stable Diffusion图像生成:KoboldCpp不仅限于文本生成,还集成了Stable Diffusion功能,允许用户生成与文本相关的图像。

-

API支持:KoboldCpp提供了兼容KoboldAI API的端点,使得开发者可以轻松地将其集成到自己的应用中。

使用KoboldCpp

使用KoboldCpp非常简单。对于Windows用户,只需下载预编译的koboldcpp.exe文件并运行即可。Linux和MacOS用户也可以使用预编译的二进制文件或从源代码编译。

以下是一个基本的使用流程:

- 下载KoboldCpp executable文件。

- 准备一个GGUF格式的语言模型文件。

- 运行KoboldCpp,选择模型文件并配置参数。

- 通过Web界面(默认为http://localhost:5001)开始使用。

性能优化

KoboldCpp提供了多种方法来优化性能:

- GPU加速:使用

--usecublas(NVIDIA GPU)或--usevulkan(通用GPU)选项启用GPU加速。 - GPU层卸载:通过

--gpulayers选项将模型层卸载到GPU,提高处理速度。 - 上下文大小调整:使用

--contextsize选项增加上下文大小,允许模型处理更多文本。

社区和支持

KoboldCpp拥有一个活跃的社区,用户可以在KoboldAI Discord上寻求帮助和分享经验。此外,项目的GitHub Wiki提供了丰富的文档和常见问题解答。

未来展望

KoboldCpp的发展前景令人兴奋。随着硬件技术的进步和AI模型的不断演进,我们可以期待:

-

更高的性能:随着GPU技术的发展,KoboldCpp将能够处理更大的模型,提供更快的文本生成速度。

-

更多的模型支持:随着新的语言模型不断涌现,KoboldCpp将继续扩展其支持的模型范围。

-

增强的AI功能:除了文本生成,我们可能会看到更多AI功能的集成,如更高级的图像生成、语音合成等。

-

更好的跨平台支持:虽然KoboldCpp已经支持主要的操作系统,但未来可能会看到更无缝的跨平台体验。

结语

KoboldCpp代表了大语言模型应用工具的一个重要里程碑。它不仅使得强大的AI模型变得易于使用,还为开发者和研究者提供了一个灵活的平台来探索和应用这些模型。无论您是AI爱好者、研究人员还是开发者,KoboldCpp都为您打开了一扇通向AI文本生成世界的大门。

随着技术的不断进步和社区的持续贡献,KoboldCpp的未来充满了无限可能。它不仅仅是一个工具,更是推动大语言模型民主化和普及化的重要力量。通过简化复杂的AI技术,KoboldCpp正在帮助更多的人发掘和利用大语言模型的潜力,为创新和创造力注入新的活力。

要开始使用KoboldCpp,请访问GitHub项目页面下载最新版本。无论您是想要探索AI写作、开发聊天机器人,还是进行语言研究,KoboldCpp都将是您强大而可靠的助手。让我们一起踏上这个激动人心的AI之旅,探索语言的无限可能性!