Lang-Segment-Anything: 融合语言与视觉的新型图像分割工具

在计算机视觉领域,图像分割和对象检测一直是研究的热点。随着深度学习技术的不断发展,这些任务的准确性和效率都得到了显著提升。近期,一个名为Lang-Segment-Anything的开源项目引起了广泛关注,它巧妙地将语言理解与图像分割相结合,为这一领域带来了新的可能性。

项目概述

Lang-Segment-Anything是由GitHub用户luca-medeiros开发的一个创新项目。该项目的核心思想是将实例分割与文本提示相结合,以生成图像中特定对象的掩码。它基于Meta AI最新发布的Segment Anything Model (SAM)和GroundingDINO检测模型构建而成,为用户提供了一个易用且高效的对象检测和图像分割工具。

技术特点

-

零样本文本到边界框方法:

Lang-Segment-Anything采用了零样本学习的思路,允许用户通过文本描述来定位图像中的对象,而无需事先训练特定类别的模型。这大大提高了系统的灵活性和通用性。 -

GroundingDINO检测模型集成:

项目集成了GroundingDINO检测模型,该模型能够将自然语言查询与视觉内容对齐,从而实现更精确的对象定位。 -

Lightning AI应用平台支持:

Lang-Segment-Anything支持使用Lightning AI应用平台进行部署,这使得模型的部署和扩展变得更加简单和高效。 -

可自定义文本提示:

用户可以通过自定义文本提示来精确控制对象分割的结果,这为不同应用场景提供了极大的灵活性。

工作原理

Lang-Segment-Anything的工作流程主要包括以下步骤:

-

文本输入: 用户提供一个描述目标对象的文本提示。

-

对象检测: GroundingDINO模型利用文本提示在图像中定位相关对象,生成边界框。

-

实例分割: SAM模型使用生成的边界框作为输入,生成精确的对象掩码。

-

结果输出: 系统返回分割后的图像,其中包含标记的对象及其对应的掩码。

这种方法的优势在于它结合了语言理解和视觉分割的优点,使得用户可以通过自然语言来精确控制分割过程,而不需要复杂的手动标注或专门的训练数据。

应用示例

为了展示Lang-Segment-Anything的强大功能,我们来看几个具体的应用示例:

-

车辆部件识别: 用户可以输入"wheel"作为文本提示,系统会自动在图像中定位并分割出车轮。这对于自动驾驶或车辆检测系统具有重要意义。

-

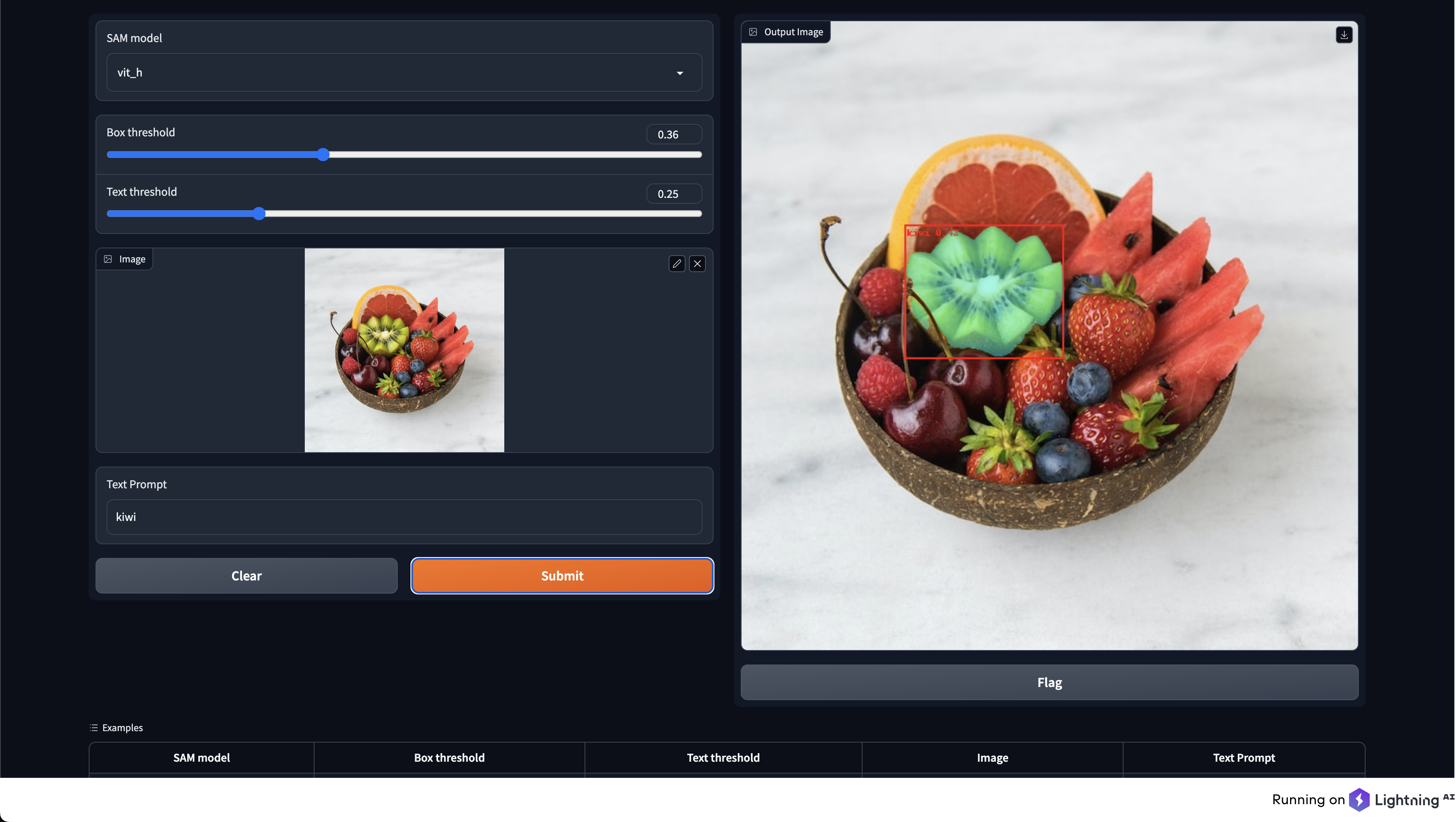

水果分割: 通过输入"kiwi"作为提示,系统可以准确地在图像中识别并分割出猕猴桃。这种功能在农业自动化或食品行业质量控制中有广泛应用。

-

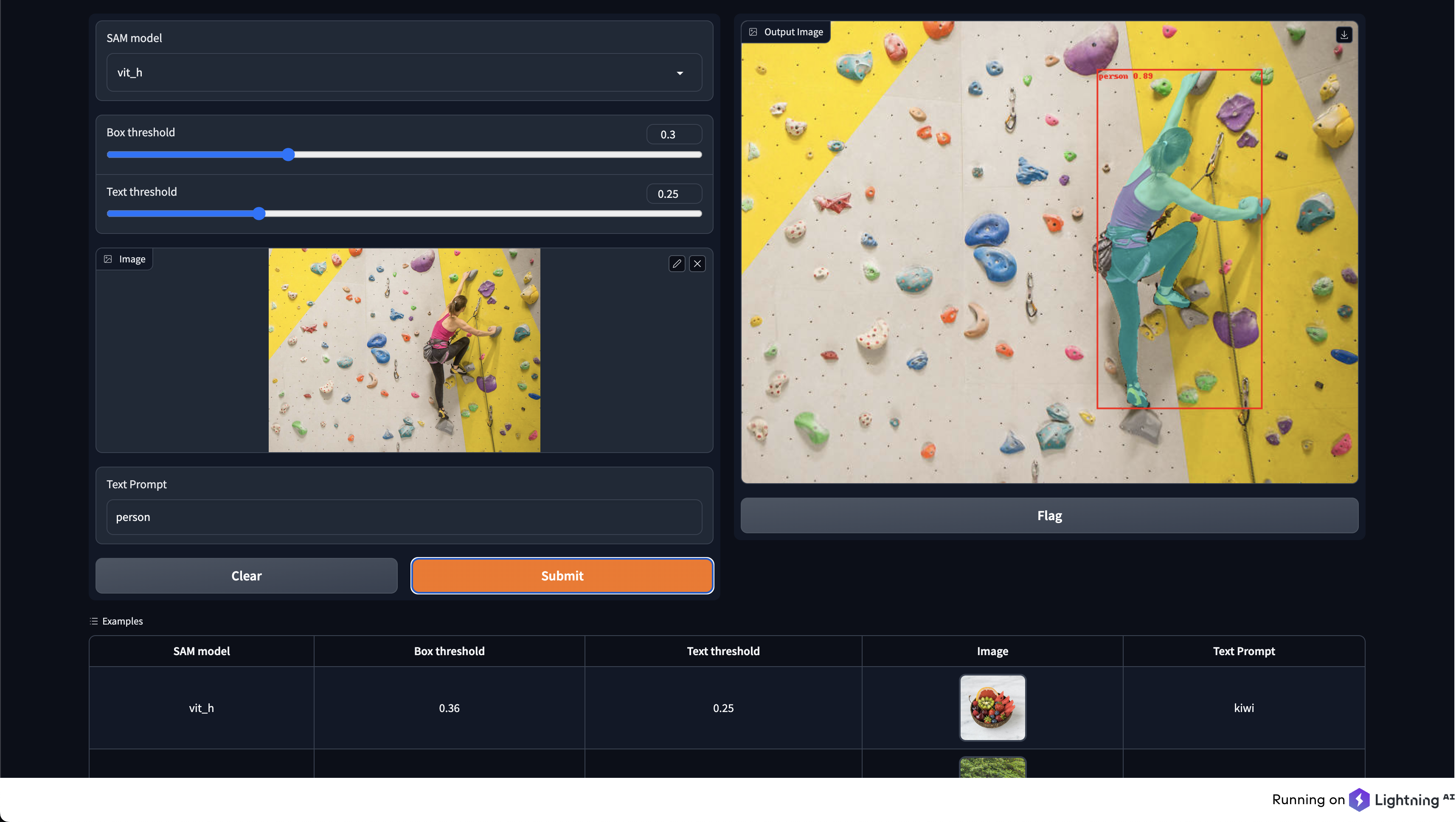

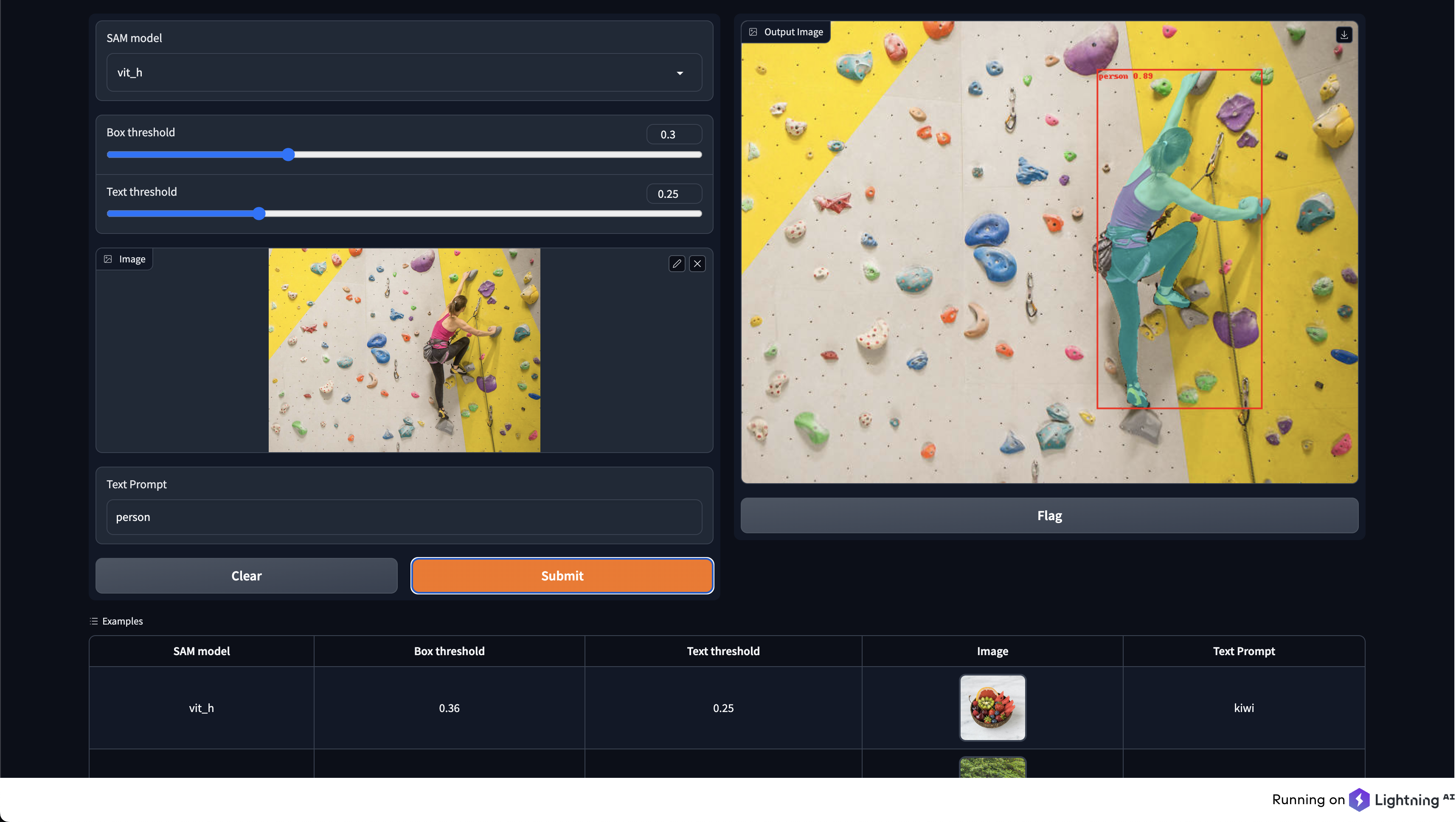

人物识别: 输入"person"作为提示,系统能够在复杂背景中准确定位并分割出人物轮廓。这在安防监控、人机交互等领域有重要应用。

这些例子展示了Lang-Segment-Anything在不同场景下的versatility和准确性。无论是日常物品、生物还是人物,系统都能通过简单的文本提示实现精确的对象分割。

安装与使用

Lang-Segment-Anything的安装过程相对简单,主要有以下几种方式:

- 直接安装:

pip install torch torchvision

pip install -U git+https://github.com/luca-medeiros/lang-segment-anything.git

- 克隆仓库安装:

git clone https://github.com/luca-medeiros/lang-segment-anything && cd lang-segment-anything

pip install torch torchvision

pip install -e .

- 使用Conda环境:

conda env create -f environment.yml

conda activate lsa

- Docker安装:

docker build --tag lang-segment-anything:latest .

docker run --gpus all -it lang-segment-anything:latest

使用方法同样简单直观。以下是一个基本的使用示例:

from PIL import Image

from lang_sam import LangSAM

model = LangSAM()

image_pil = Image.open("./assets/car.jpeg").convert("RGB")

text_prompt = "wheel"

masks, boxes, phrases, logits = model.predict(image_pil, text_prompt)

未来发展方向

Lang-Segment-Anything项目的开发团队对未来有着明确的规划:

-

FastAPI集成: 计划添加FastAPI代码,使模型的部署和交互更加streamline。

-

标注流程pipeline: 开发一个标注pipeline,允许用户输入文本提示和图像,并获得标记好的实例分割输出。这将大大提高数据处理和分析的效率。

-

CLIP模型集成: 考虑集成OpenAI的CLIP模型,以增强语言理解能力,potentially提高实例分割的效果。

这些计划显示了项目团队致力于不断改进和扩展Lang-Segment-Anything的功能,以满足更多样化的应用需求。

结语

Lang-Segment-Anything代表了计算机视觉和自然语言处理融合的一个重要方向。它不仅简化了复杂的图像分割任务,还为非技术背景的用户提供了一种直观的方式来与先进的AI模型交互。随着项目的不断发展和完善,我们可以期待看到更多创新的应用场景,从而推动计算机视觉技术在各个领域的广泛应用。

无论是在研究还是实际应用中,Lang-Segment-Anything都展现出了巨大的潜力。它为开发者和研究者提供了一个强大的工具,用于探索语言引导下的视觉理解新范式。同时,对于企业和组织来说,这项技术也可能带来新的业务机会和效率提升。

随着人工智能技术的不断进步,我们可以预见,像Lang-Segment-Anything这样的项目将继续推动计算机视觉的边界,为我们创造出更智能、更直观的人机交互方式。这不仅仅是技术的进步,更是人类认知和交互方式的一次重要革新。