LangChain.dart简介

LangChain.dart是由David Migloz开发的LangChain框架的非官方Dart移植版。它为开发者提供了一系列可用于处理语言模型的组件,以及将这些组件串联起来实现更高级用例的标准接口。这些用例包括聊天机器人、基于RAG的问答系统、智能代理、文本摘要、翻译、信息抽取、推荐系统等。

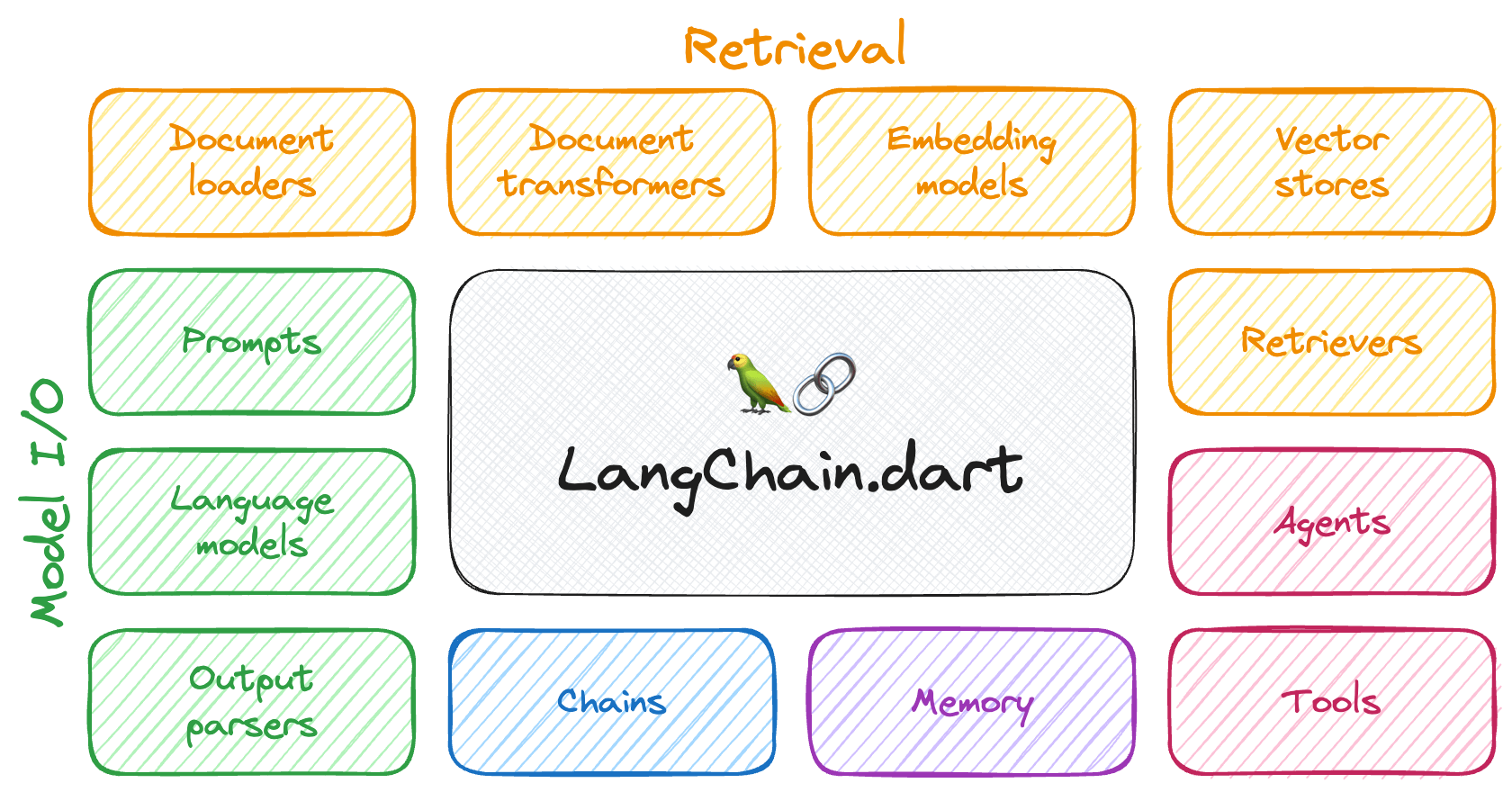

LangChain.dart的核心模块包括:

-

模型输入/输出(Model I/O): 提供与各种LLM提供商(如OpenAI、Google、Mistral、Ollama等)交互的统一API,让开发者可以轻松切换不同的模型。同时提供管理模型输入(提示模板和示例选择器)和解析模型输出(输出解析器)的工具。

-

检索(Retrieval): 协助加载用户数据(通过文档加载器)、转换数据(使用文本分割器)、提取语义(使用嵌入模型)、存储(在向量存储中)和检索数据,以便用于为模型响应提供依据(即检索增强生成或RAG)。

-

代理(Agents): 利用LLM做出明智决策的"机器人",可以使用各种可用工具(如网络搜索、计算器、数据库查询等)来完成指定任务。

这些组件可以使用LangChain表达语言(LCEL)组合在一起,构建复杂的应用。

为什么需要LangChain.dart?

大型语言模型(LLM)已经彻底改变了自然语言处理(NLP)领域,成为各种应用中不可或缺的组件,如问答系统、文本摘要、翻译和文本生成等。

LLM的广泛应用正在创造一个全新的技术栈。然而,新兴的库和工具主要是为Python和JavaScript生态系统开发的。因此,这些生态系统中利用LLM的应用数量呈指数级增长。

相比之下,Dart/Flutter生态系统并没有经历类似的增长,这可能是由于缺乏简化LLM使用复杂性的Dart和Flutter库所导致的。

LangChain.dart旨在填补这一空白,抽象化在Dart和Flutter中使用LLM的复杂性,使开发者能够有效地利用它们的组合潜力。

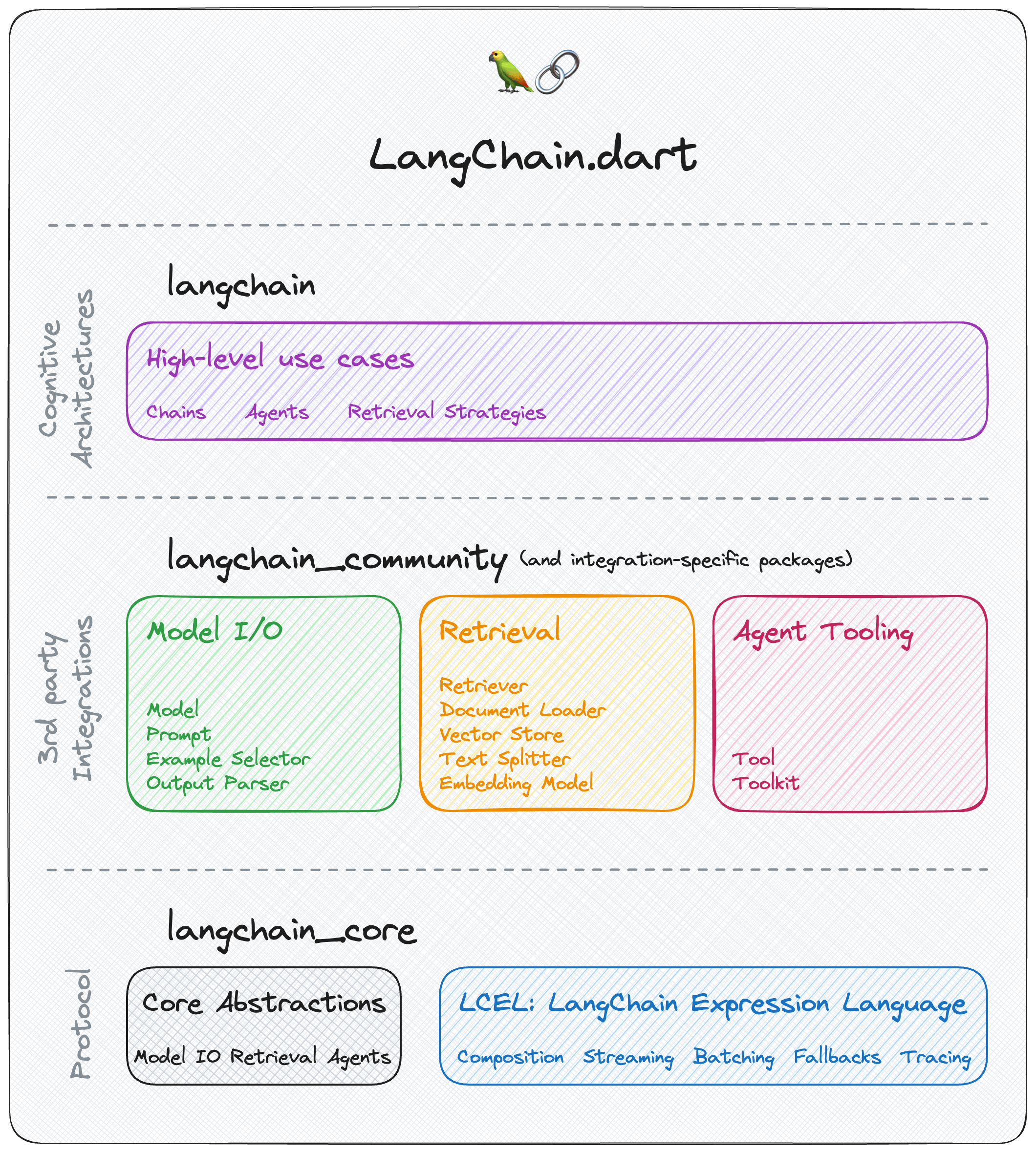

LangChain.dart包结构

LangChain.dart采用模块化设计,允许开发者只导入他们需要的组件。生态系统由几个包组成:

-

langchain_core: 只包含核心抽象和LangChain表达语言(LCEL)。用于构建基于LangChain.dart的框架或与之互操作。

-

langchain: 包含高级和特定用例的链、代理和检索算法,是应用程序认知架构的核心。用于使用LangChain.dart构建LLM应用程序。

-

langchain_community: 包含第三方集成和社区贡献的组件。

-

特定集成包: 流行的第三方集成(如langchain_openai、langchain_google、langchain_ollama等)被移至独立包中,可以单独导入而无需依赖整个langchain_community包。

LangChain.dart集成

LangChain.dart提供了广泛的集成支持,包括:

-

聊天模型: 支持Anthropic、Firebase VertexAI、Google GenerativeAI、MistralAI、Ollama、OpenAI等多种聊天模型。

-

LLM: 支持Ollama、OpenAI、VertexAI等LLM模型。

-

嵌入模型: 支持Google GenerativeAI、MistralAI、Ollama、OpenAI、VertexAI等嵌入模型。

-

向量存储: 支持Chroma、MemoryVectorStore、ObjectBox、Pinecone、Supabase、VertexAI Matching Engine等向量存储。

-

工具: 提供计算器、OpenAI DALL-E图像生成、Tavily搜索等工具。

开始使用LangChain.dart

要开始使用LangChain.dart,首先需要将langchain作为依赖项添加到pubspec.yaml文件中。同时,还需要包含特定集成所需的依赖项:

dependencies:

langchain: {version}

langchain_community: {version}

langchain_openai: {version}

langchain_google: {version}

...

LangChain.dart的最基本构建块是在某个提示上调用LLM。LangChain.dart为调用不同的LLM提供了统一的接口。例如,我们可以使用ChatGoogleGenerativeAI来调用Google的Gemini模型:

final model = ChatGoogleGenerativeAI(apiKey: googleApiKey);

final prompt = PromptValue.string('Hello world!');

final result = await model.invoke(prompt);

// Hello everyone! I'm new here and excited to be part of this community.

但LangChain.dart的强大之处在于将多个组件链接在一起以实现复杂的用例。例如,一个RAG(检索增强生成)管道,它可以接受用户查询,从向量存储中检索相关文档,使用提示模板格式化它们,调用模型,并解析输出:

// 1. 创建向量存储并添加文档

final vectorStore = MemoryVectorStore(

embeddings: OpenAIEmbeddings(apiKey: openaiApiKey),

);

await vectorStore.addDocuments(

documents: [

Document(pageContent: 'LangChain was created by Harrison'),

Document(pageContent: 'David ported LangChain to Dart in LangChain.dart'),

],

);

// 2. 定义检索链

final retriever = vectorStore.asRetriever();

final setupAndRetrieval = Runnable.fromMap<String>({

'context': retriever.pipe(

Runnable.mapInput((docs) => docs.map((d) => d.pageContent).join('\n')),

),

'question': Runnable.passthrough(),

});

// 3. 构造RAG提示模板

final promptTemplate = ChatPromptTemplate.fromTemplates([

(ChatMessageType.system, 'Answer the question based on only the following context:\n{context}'),

(ChatMessageType.human, '{question}'),

]);

// 4. 定义最终链

final model = ChatOpenAI(apiKey: openaiApiKey);

const outputParser = StringOutputParser<ChatResult>();

final chain = setupAndRetrieval

.pipe(promptTemplate)

.pipe(model)

.pipe(outputParser);

// 5. 运行管道

final res = await chain.invoke('Who created LangChain.dart?');

print(res);

// David created LangChain.dart

LangChain.dart文档和资源

LangChain.dart提供了丰富的文档和资源:

- LangChain.dart官方文档

- Code Assist AI (LangChain.dart文档聊天机器人)

- 示例应用

- LangChain.dart博客

- 项目看板

LangChain.dart社区

开发者可以加入LangChain.dart Discord服务器来了解最新动态,参与讨论,获取帮助。

贡献和许可

LangChain.dart欢迎新的贡献者。可以查看贡献者指南来了解如何开始。项目采用MIT许可证。

LangChain.dart为Dart和Flutter开发者提供了一个强大的工具集,用于构建基于大型语言模型的应用。通过抽象化复杂性并提供统一的接口,它使开发者能够专注于创建创新的AI驱动应用,而不必深入处理底层细节。无论是构建简单的聊天机器人还是复杂的智能代理系统,LangChain.dart都为开发者提供了所需的组件和灵活性。

随着LLM技术的不断发展,LangChain.dart将继续扩展其功能和集成,为Dart和Flutter开发者提供最前沿的AI开发工具。通过活跃的社区支持和持续的更新,LangChain.dart正在成为Dart/Flutter生态系统中AI应用开发的首选框架。