🦜️🔗 LangChain.dart

构建基于LLM的Dart/Flutter应用程序。

什么是LangChain.dart?

LangChain.dart是由Harrison Chase创建的流行Python框架LangChain的非官方Dart移植版。

LangChain提供了一套现成的组件用于处理语言模型,以及将它们链接在一起以构建更高级用例(如聊天机器人、基于RAG的问答系统、智能代理、摘要生成、翻译、信息提取、推荐系统等)的标准接口。

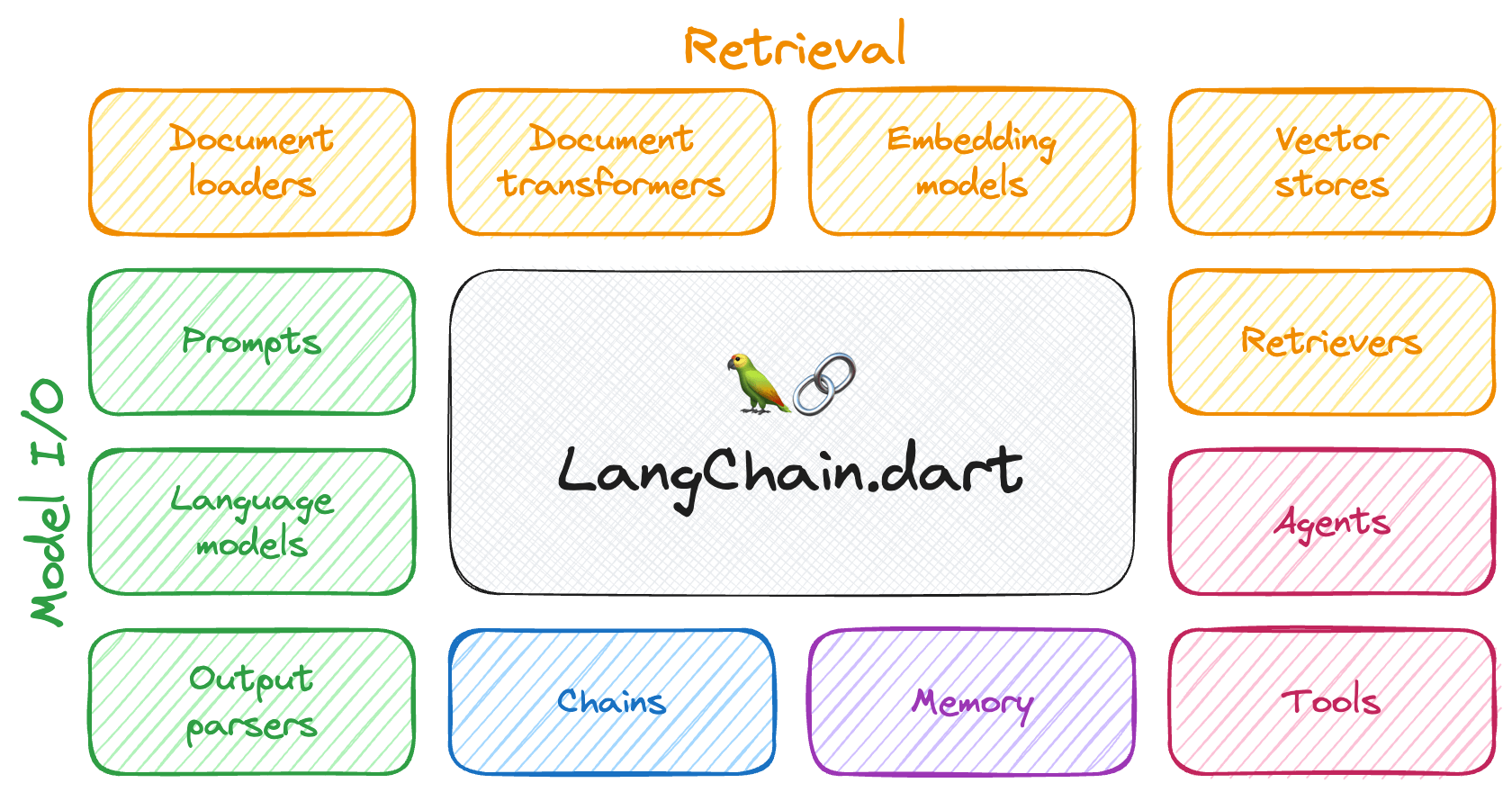

这些组件可以分为几个核心模块:

- 📃 模型输入输出: LangChain提供了一个统一的API,用于与各种LLM提供商(如OpenAI、Google、Mistral、Ollama等)进行交互,使开发者能够轻松切换它们。此外,它还提供了管理模型输入(提示模板和示例选择器)和解析模型输出(输出解析器)的工具。

- 📚 检索: 协助加载用户数据(通过文档加载器)、转换数据(使用文本分割器)、提取其含义(使用嵌入模型)、存储(在向量存储中)和检索数据(通过检索器),以便用于为模型的响应提供依据(即检索增强生成或RAG)。

- 🤖 智能代理: 利用LLM做出明智决策的"机器人",决定使用哪些可用工具(如网络搜索、计算器、数据库查询等)来完成指定任务。

不同的组件可以使用LangChain表达语言(LCEL)组合在一起。

动机

大型语言模型(LLMs)已经彻底改变了自然语言处理(NLP),成为广泛应用中的重要组成部分,如问答系统、摘要生成、翻译和文本生成。

LLMs的采用正在其后创造一个新的技术栈。然而,新兴的库和工具主要是为Python和JavaScript生态系统开发的。因此,这些生态系统中利用LLMs的应用数量呈指数级增长。

相比之下,Dart / Flutter生态系统并未经历类似的增长,这可能归因于Dart和Flutter库缺乏简化LLMs相关复杂性的工具。

LangChain.dart旨在填补这一空白,通过抽象化在Dart和Flutter中使用LLMs的复杂性,使开发者能够有效地利用它们的组合潜力。

软件包

LangChain.dart采用模块化设计,允许开发者仅导入他们需要的组件。该生态系统由几个软件包组成:

langchain_core

仅包含核心抽象以及作为组合方式的LangChain表达语言。

依赖此软件包以在LangChain.dart之上构建框架或与之互操作。

langchain

包含更高级和特定用例的链、代理和检索算法,这些是应用程序认知架构的核心。

依赖此软件包以使用LangChain.dart构建LLM应用程序。

此软件包暴露了

langchain_core,因此你不需要显式依赖它。

langchain_community

包含不属于LangChain.dart核心API的第三方集成和社区贡献的组件。

如果你想使用它提供的任何集成或组件,请依赖此软件包。

特定集成软件包

流行的第三方集成(如langchain_openai、langchain_google、langchain_ollama等)被移至它们自己的软件包中,以便可以独立导入,而无需依赖整个langchain_community软件包。

如果你想使用特定的集成,请依赖特定集成软件包。

| 软件包 | 版本 | 描述 |

|---|---|---|

| langchain_anthropic | Anthropic集成(Claude 3.5 Sonnet、Opus、Haiku、Instant等) | |

| langchain_chroma | Chroma向量数据库集成 | |

| langchain_firebase | Firebase集成(适用于Firebase的VertexAI(Gemini 1.5 Pro、Gemini 1.5 Flash等)) | |

| langchain_google | Google集成(GoogleAI、VertexAI、Gemini、PaLM 2、嵌入、向量搜索等) | |

| langchain_mistralai | Mistral AI集成(Mistral-7B、Mixtral 8x7B、Mixtral 8x22B、Mistral Small、Mistral Large、嵌入等) | |

| langchain_ollama | Ollama集成(Llama 3.1、Gemma 2、Phi-3、Mistral nemo、WizardLM-2、CodeGemma、Command R、LLaVA、DBRX、Qwen、Dolphin、DeepSeek Coder、Vicuna、Orca等) | |

| langchain_openai | OpenAI集成(GPT-3.5 Turbo、GPT-4、GPT-4o、嵌入、工具、视觉、DALL·E 3等)和OpenAI兼容服务(TogetherAI、Anyscale、OpenRouter、One API、Groq、Llamafile、GPT4All等) | |

| langchain_pinecone | Pinecone向量数据库集成 | |

| langchain_supabase | Supabase向量数据库集成 |

API客户端包

以下包由LangChain.dart维护(并在内部使用),尽管它们也可以独立使用:

如果你只想直接使用特定提供商的API而不使用LangChain.dart抽象,可以依赖一个API客户端包。

| 包 | 版本 | 描述 |

|---|---|---|

| anthropic_sdk_dart | Anthropic API客户端 | |

| chromadb | Chroma DB API客户端 | |

| googleai_dart | Google AI for Developers API客户端 | |

| mistralai_dart | Mistral AI API客户端 | |

| ollama_dart | Ollama API客户端 | |

| openai_dart | OpenAI API客户端 | |

| tavily_dart | Tavily API客户端 | |

| vertex_ai | GCP Vertex AI API客户端 |

集成

LangChain.dart中提供以下集成:

聊天模型

| 聊天模型 | 包 | 流式传输 | 多模态 | 工具调用 | 描述 |

|---|---|---|---|---|---|

| ChatAnthropic | langchain_anthropic | ✔ | ✔ | ✔ | Anthropic消息API(又称Claude API) |

| ChatFirebaseVertexAI | langchain_firebase | ✔ | ✔ | ✔ | Firebase的Vertex AI API(又称Gemini API) |

| ChatGoogleGenerativeAI | langchain_google | ✔ | ✔ | ✔ | Google AI for Developers API(又称Gemini API) |

| ChatMistralAI | langchain_mistralai | ✔ | Mistral聊天API | ||

| ChatOllama | langchain_ollama | ✔ | ✔ | ✔ | Ollama聊天API |

| ChatOpenAI | langchain_openai | ✔ | ✔ | ✔ | OpenAI聊天API和兼容OpenAI聊天API的服务(TogetherAI、Anyscale、OpenRouter、One API、Groq、Llamafile、GPT4All、FastChat等) |

| ChatVertexAI | langchain_google | GCP Vertex AI聊天API |

LLMs

注意:许多提供商已弃用LLMs,建议优先使用聊天模型。

| LLM | 包 | 流式传输 | 描述 |

|---|---|---|---|

| Ollama | langchain_ollama | ✔ | Ollama补全API |

| OpenAI | langchain_openai | ✔ | OpenAI补全API |

| VertexAI | langchain_google | GCP Vertex AI文本API |

嵌入模型

向量存储

工具

| 工具 | 包 | 描述 |

|---|---|---|

| CalculatorTool | langchain_community | 用于计算数学表达式 |

| OpenAIDallETool | langchain_openai | OpenAI 的 DALL-E 图像生成器 |

| TavilyAnswerTool | langchain_community | 使用 Tavily 搜索引擎返回查询的答案 |

| TavilySearchResultsTool | langchain_community | 使用 Tavily 搜索引擎返回查询的结果列表 |

入门

要开始使用 LangChain.dart,请将 langchain 作为依赖项添加到您的 pubspec.yaml 文件中。同时,包括您想要使用的特定集成的依赖项(例如 langchain_community、langchain_openai、langchain_google 等):

dependencies:

langchain: {版本}

langchain_community: {版本}

langchain_openai: {版本}

langchain_google: {版本}

...

LangChain.dart 最基本的构建块是在某个提示上调用 LLM。LangChain.dart 提供了一个统一的接口来调用不同的 LLM。例如,我们可以使用 ChatGoogleGenerativeAI 来调用 Google 的 Gemini 模型:

final model = ChatGoogleGenerativeAI(apiKey: googleApiKey);

final prompt = PromptValue.string('你好,世界!');

final result = await model.invoke(prompt);

// 大家好!我是新来的,很高兴能成为这个社区的一员。

但 LangChain.dart 的强大之处在于将多个组件链接在一起以实现复杂的用例。例如,一个 RAG(检索增强生成)管道,它可以接受用户查询,从向量存储中检索相关文档,使用提示模板格式化它们,调用模型,并解析输出:

// 1. 创建一个向量存储并向其添加文档

final vectorStore = MemoryVectorStore(

embeddings: OpenAIEmbeddings(apiKey: openaiApiKey),

);

await vectorStore.addDocuments(

documents: [

Document(pageContent: 'LangChain 由 Harrison 创建'),

Document(pageContent: 'David 在 LangChain.dart 中将 LangChain 移植到了 Dart'),

],

);

// 2. 定义检索链

final retriever = vectorStore.asRetriever();

final setupAndRetrieval = Runnable.fromMap<String>({

'context': retriever.pipe(

Runnable.mapInput((docs) => docs.map((d) => d.pageContent).join('\n')),

),

'question': Runnable.passthrough(),

});

// 3. 构建 RAG 提示模板

final promptTemplate = ChatPromptTemplate.fromTemplates([

(ChatMessageType.system, '仅基于以下上下文回答问题:\n{context}'),

(ChatMessageType.human, '{question}'),

]);

// 4. 定义最终链

final model = ChatOpenAI(apiKey: openaiApiKey);

const outputParser = StringOutputParser<ChatResult>();

final chain = setupAndRetrieval

.pipe(promptTemplate)

.pipe(model)

.pipe(outputParser);

// 5. 运行管道

final res = await chain.invoke('谁创建了 LangChain.dart?');

print(res);

// David 创建了 LangChain.dart

文档

社区

在官方 LangChain.dart Discord 服务器 上了解该领域的最新新闻和更新,进行精彩讨论,并获得帮助。

贡献

| 📢 寻找合作者 📢 |

|---|

| 我们正在寻找合作者加入核心维护团队。 |

欢迎新的贡献者!查看我们的贡献者指南以获取入门帮助。

加入我们的 Discord 认识其他维护者。我们将帮助您快速完成第一次贡献!

相关项目

- LangChain:原始的 Python LangChain 项目。

- LangChain.js:LangChain 的 JavaScript 移植版。

- LangChain.go:LangChain 的 Go 移植版。

- LangChain.rb:LangChain 的 Ruby 移植版。

赞助商

许可证

LangChain.dart 根据 MIT 许可证 授权。

访问官网

访问官网 Github

Github 文档

文档