引言

在人工智能快速发展的今天,如何高效地将AI能力整合到现代Web应用中已成为开发者们关注的焦点。LangChain作为一个强大的AI开发框架,与Next.js这一流行的React框架的结合,为开发者提供了一个理想的起点。让我们一起深入探索LangChain与Next.js的完美融合,看看这个starter模板如何为AI应用开发带来革命性的变化。

LangChain与Next.js:强大的组合

LangChain是一个为开发者提供构建基于大语言模型应用的框架,它提供了一系列模块和工具,使得创建复杂的AI应用变得更加简单。而Next.js则是一个广受欢迎的React框架,以其出色的性能和开发体验著称。这两者的结合,为开发者提供了一个强大而灵活的AI应用开发平台。

langchain-ai团队推出的这个starter模板,巧妙地将LangChain的AI能力与Next.js的Web开发优势结合在一起,为开发者提供了一个快速启动AI项目的理想选择。

模板特性一览

这个starter模板展示了如何使用和组合LangChain模块来实现多种用例:

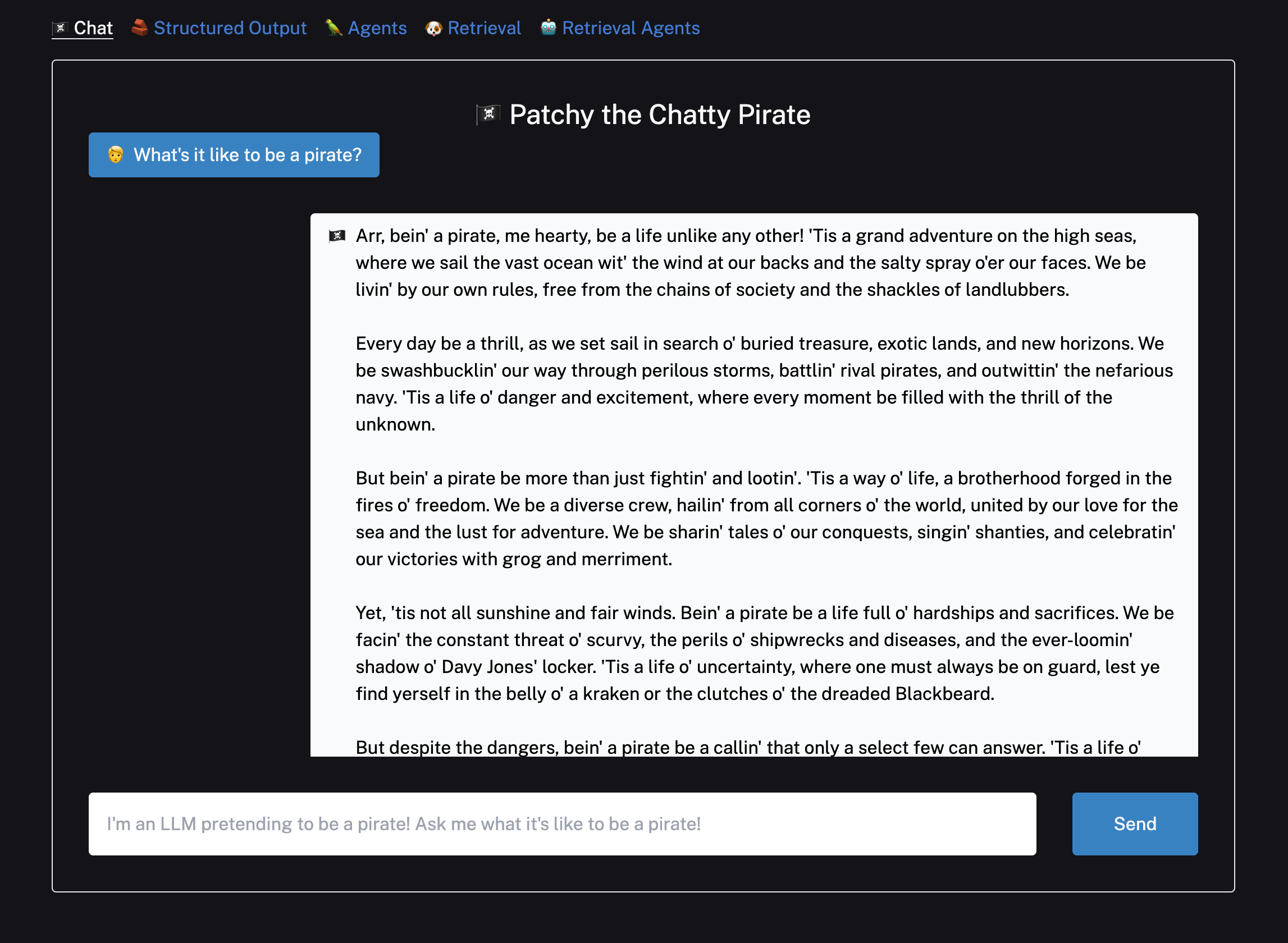

- 简单对话:实现基础的AI聊天功能

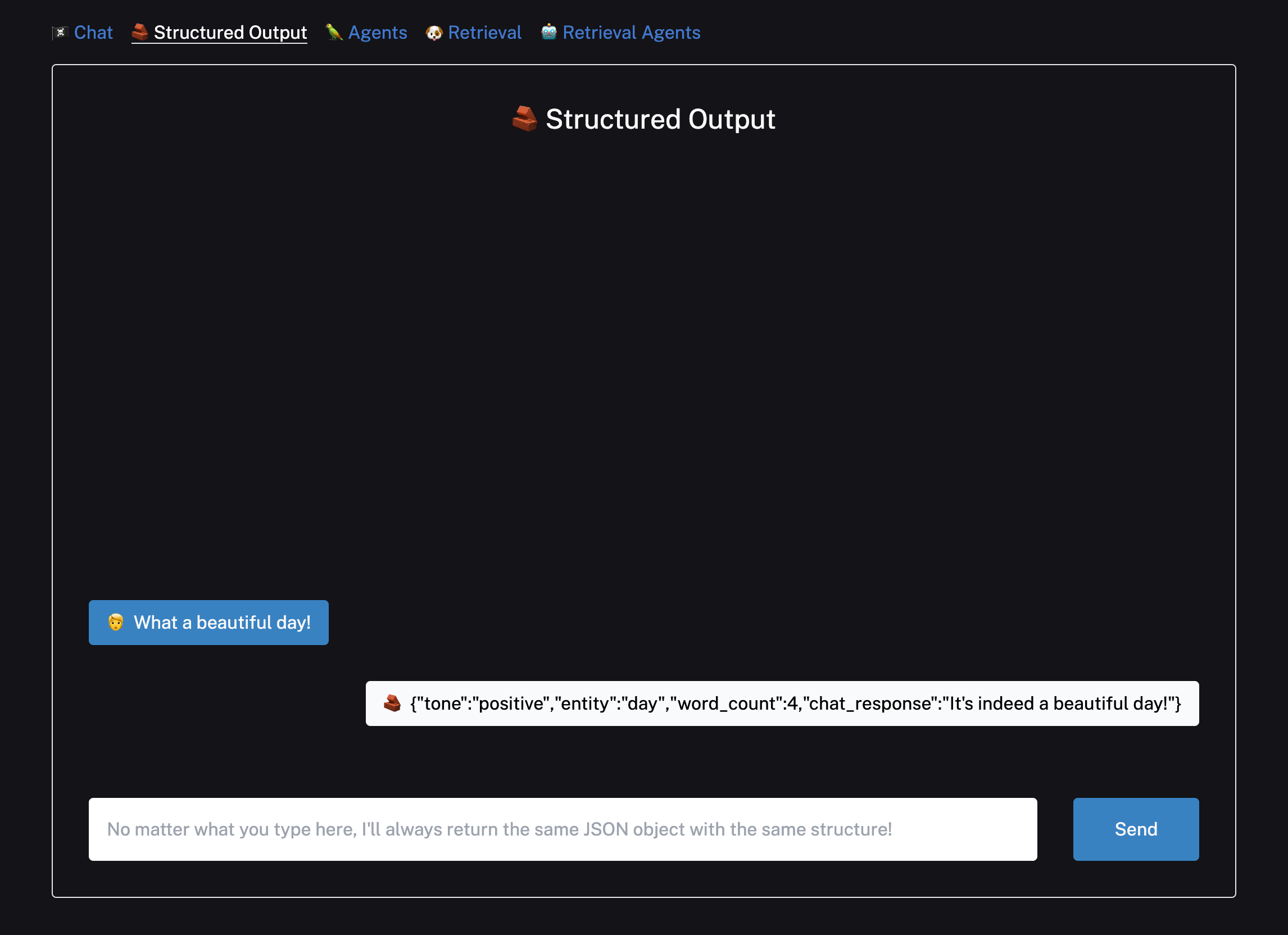

- 结构化输出:从LLM调用中返回特定格式的输出

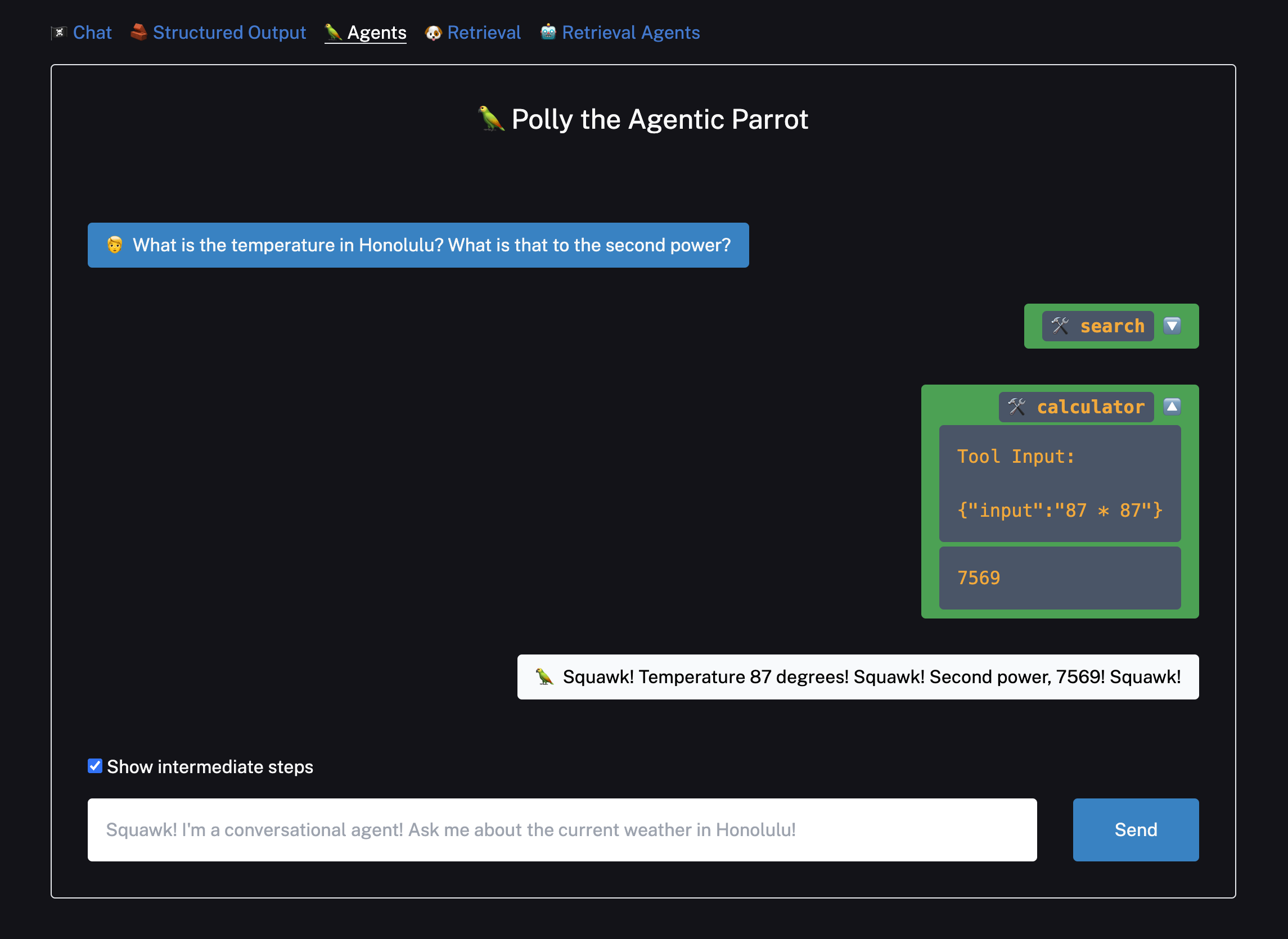

- 复杂问题解答:使用代理(Agents)来回答多步骤的复杂问题

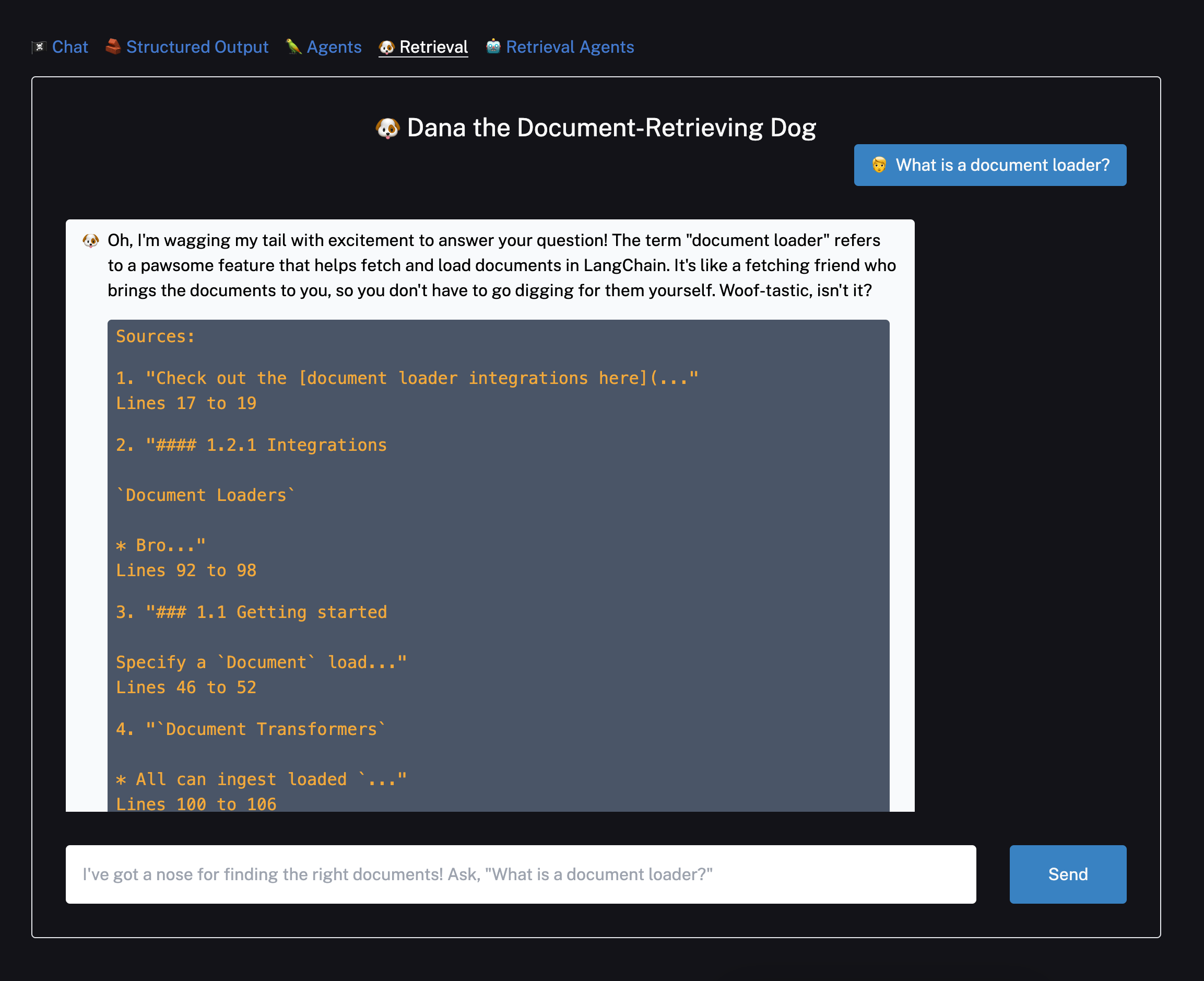

- 检索增强生成(RAG):结合向量存储实现基于知识库的问答

大多数示例都使用了Vercel的AI SDK来实现从服务器到客户端的流式传输,提供了更好的用户体验。

快速上手

要开始使用这个模板,您只需要几个简单的步骤:

- 克隆仓库到本地

- 设置环境变量:复制

.env.example文件为.env.local,并添加您的OpenAI API密钥 - 安装依赖包(使用

yarn或其他包管理器) - 运行开发服务器

打开http://localhost:3000即可看到项目运行效果。您可以开始与AI进行对话,并会看到流式响应:

深入功能探索

结构化输出

模板的第二个示例展示了如何让模型返回符合特定模式的输出。这个功能使用了OpenAI Functions,结合流行的Zod库来构建模式。

智能代理(Agents)

要体验代理功能,您需要设置SERPAPI_API_KEY环境变量,以允许代理访问互联网。这个示例使用了预构建的LangGraph代理,能够回答更复杂的问题。

检索增强生成(RAG)

检索示例使用Supabase作为向量存储,但您也可以根据需要更换为其他支持的向量存储。这个功能允许AI根据预先ingested的文档来回答问题,大大增强了AI的知识范围和回答准确性。

性能与部署

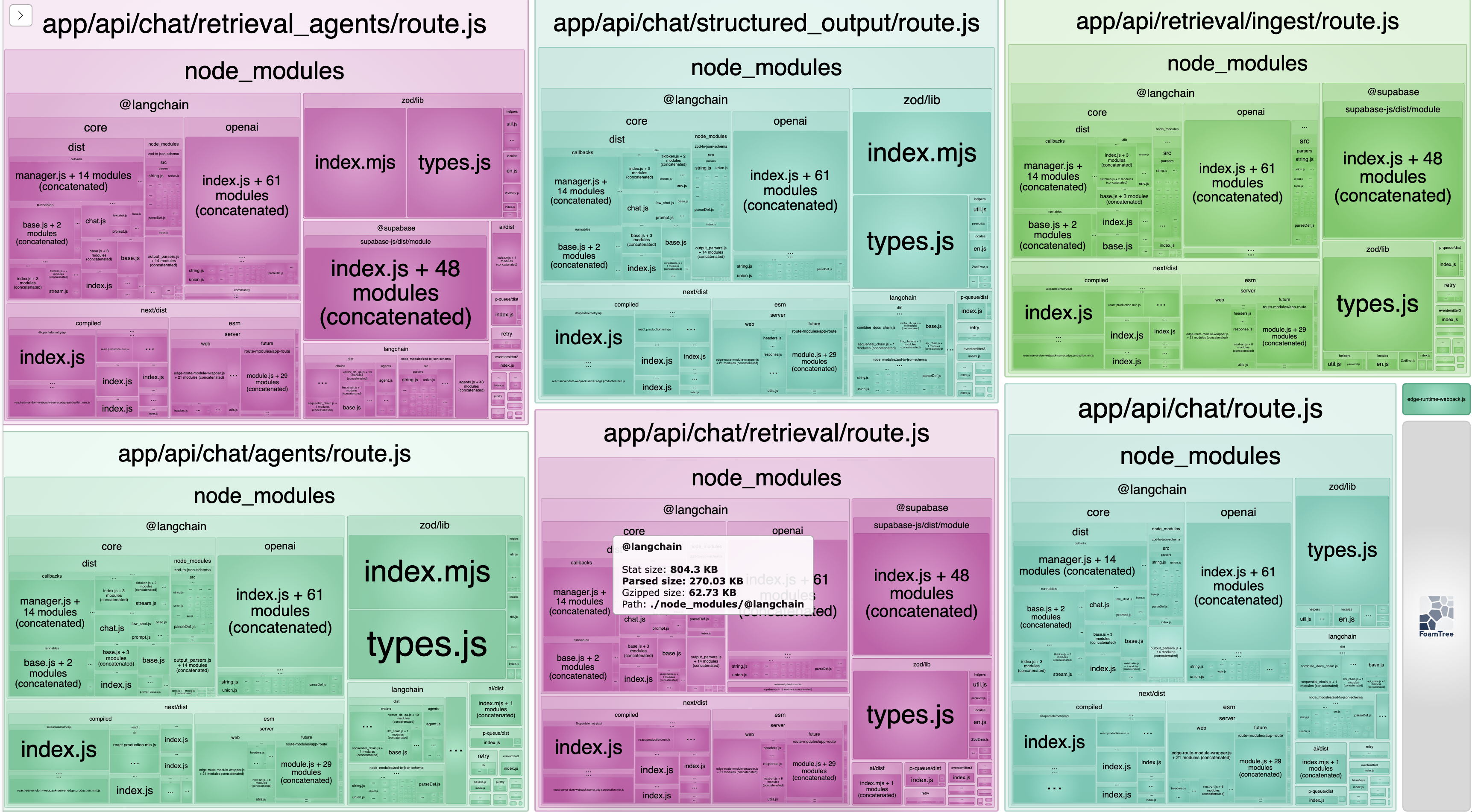

值得一提的是,尽管功能强大,但LangChain本身的bundle size相当小巧。在RAG用例中,LangChain仅使用了37.32 KB的代码空间,这不到Vercel免费tier边缘函数1 MB限制的4%。

当您准备将应用部署到生产环境时,可以轻松地在Vercel平台上部署。Vercel提供了优秀的性能和可扩展性,非常适合运行这类AI驱动的应用。

结语

LangChain与Next.js的结合为AI应用开发开辟了新的可能性。这个starter模板不仅展示了如何将强大的AI功能整合到现代Web应用中,还提供了一个低门槛的入口,让开发者能够快速开始构建自己的AI驱动应用。

无论您是想要实现简单的聊天机器人,还是构建复杂的知识问答系统,这个模板都为您提供了坚实的基础。我们期待看到更多基于这个模板开发的创新AI应用!

如果您在使用过程中遇到任何问题或有任何建议,欢迎通过GitHub仓库提出issues或贡献代码。让我们一起推动AI应用开发的边界,创造更多令人惊叹的可能性!