LionAGI:开创智能工作流自动化的新纪元

在人工智能和机器学习快速发展的今天,如何有效地将这些先进技术应用到实际业务场景中,成为了许多企业和开发者面临的一大挑战。LionAGI应运而生,为这一挑战提供了一个创新的解决方案。作为一个智能代理工作流自动化框架,LionAGI旨在简化将先进机器学习模型,特别是大型语言模型(LLM),集成到现有数据基础设施的过程。

什么是LionAGI?

LionAGI是一个开源的Python框架,其名称代表"Language InterOperable Network"(语言互操作网络)。它的核心目标是成为一个"AGentic Intelligence Operating System"(代理智能操作系统),为开发者提供一个强大而灵活的平台,用于构建和管理智能工作流。

LionAGI的主要特点包括:

- 强大的工作流自动化能力

- 与多种机器学习模型的无缝集成

- 灵活的数据操作和处理

- 支持异步和并发操作

- 内置的安全和速率限制机制

为什么选择LionAGI?

在当今的技术环境中,大型语言模型(LLM)如OpenAI的GPT系列已经展示了令人惊叹的能力。然而,将这些模型有效地应用到实际业务流程中仍然面临着诸多挑战。LionAGI正是为解决这些挑战而设计的。

以下是选择LionAGI的几个主要理由:

-

简化复杂性: LionAGI大大降低了创建智能自动化系统的门槛,使开发者能够更容易地构建和部署复杂的AI驱动工作流。

-

提高可解释性: 虽然LLM内部工作机制往往像黑盒一样难以理解,但LionAGI通过将LLM作为智能代理来使用,使得整个工作流程变得更加透明和可解释。

-

灵活性和可扩展性: LionAGI支持多种工具和数据源的集成,允许开发者根据具体需求定制和扩展系统功能。

-

优化性能: 通过内置的并发和异步处理机制,LionAGI能够高效地处理大规模数据和复杂任务。

-

安全性考虑: LionAGI提供了可配置的速率限制和其他安全机制,有助于防止API滥用和成本失控。

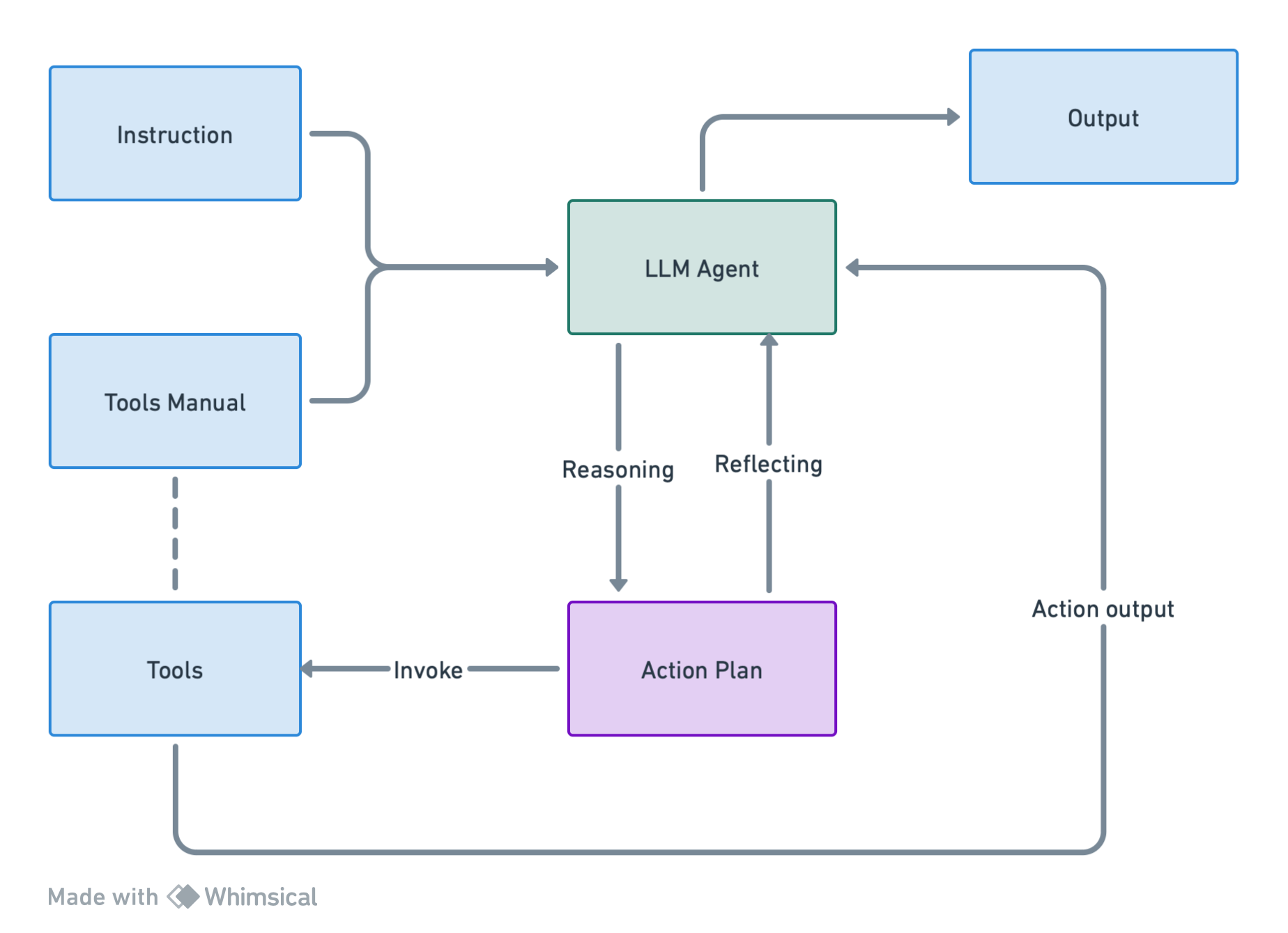

LionAGI的核心概念

要充分利用LionAGI的强大功能,理解其核心概念至关重要:

-

Session: 会话是与智能提供者(如LLM)交互的动态接口。它负责管理API调用、工具使用和多轮对话。

-

Conversation: 对话负责创建、管理和跟踪消息,维护整个交互的上下文。

-

Message: 消息是对话中最小的数据单元,包含特定的角色和内容信息。

-

特殊处理函数: LionAGI提供了一系列特殊的处理函数(如lcall, alcall, mcall等),用于高效执行各种数据操作。

快速上手LionAGI

要开始使用LionAGI,首先需要安装框架:

pip install lionagi==0.2.5

安装完成后,您可以通过以下简单的代码示例来体验LionAGI的基本功能:

import lionagi as li

# 定义系统消息、上下文和用户指令

system = "You are a helpful assistant designed to perform calculations."

instruction = {"Addition":"Add the two numbers together i.e. x+y"}

context = {"x": 10, "y": 5}

# 创建Session对象并发起交互

calculator = li.Session(system=system)

result = await calculator.initiate(

instruction=instruction, context=context, model="gpt-4-1106-preview"

)

print(f"Calculation Result: {result}")

这个简单的例子展示了如何使用LionAGI创建一个基本的计算助手。通过定义系统角色、指令和上下文,我们可以轻松地与LLM进行交互,并获得计算结果。

LionAGI的高级应用

LionAGI的真正威力在于其处理复杂工作流的能力。以下是一个更高级的应用场景,展示了如何使用LionAGI结合LlamaIndex进行自动化研究:

import lionagi as li

from llama_index import download_loader, ServiceContext, VectorStoreIndex

from llama_index.llms import OpenAI

from llama_index.node_parser import SentenceSplitter

# 设置研究主题和参数

query = 'Large Language Model Time Series Analysis'

num_papers = 20

# 下载和处理论文

ArxivReader = download_loader("ArxivReader")

loader = ArxivReader()

documents, abstracts = loader.load_papers_and_abstracts(

search_query=query, max_results=num_papers

)

# 创建向量索引

llm = OpenAI(temperature=0.1, model="gpt-4-1106-preview")

service_context = ServiceContext.from_defaults(llm=llm)

index = VectorStoreIndex(documents, include_embeddings=True, service_context=service_context)

query_engine = index.as_query_engine(include_text=False, response_mode="tree_summarize")

# 定义查询工具

def query_paper(query: str):

response = query_engine.query(query)

return str(response.response)

tools = li.func_to_tool(query_paper)

# 设置研究助手工作流

async def read_propose(context, num=5):

researcher = li.Session(system)

researcher.register_tools(tools=tools)

await researcher.chat(instruction=instruct1, context=context)

await researcher.auto_followup(instruction=instruct2, tools=True, num=num)

return researcher

# 执行研究流程

abstracts = [x.text for x in abstracts][:5]

results = await li.al_call(abstracts, read_propose)

这个例子展示了如何使用LionAGI构建一个自动化研究助手。它首先从ArXiv下载相关论文,创建一个向量索引,然后使用LionAGI的Session和工具功能来分析论文摘要并提出研究问题。

LionAGI的未来展望

作为一个活跃发展的开源项目,LionAGI正在不断进化和改进。未来的发展方向包括:

- 支持更多的LLM提供商和本地模型

- 增强工作流编排和可视化功能

- 改进数据处理和分析能力

- 加强与其他AI和数据科学工具的集成

- 提供更多预构建的智能代理模板

加入LionAGI社区

LionAGI是一个开源项目,欢迎开发者和研究者加入社区,贡献自己的想法和代码。您可以通过以下方式参与:

- 在GitHub上为项目贡献代码

- 加入Discord社区讨论和交流

- 提出新的功能建议或报告问题

- 分享您使用LionAGI的经验和案例研究

结语

LionAGI代表了智能工作流自动化的未来。通过提供一个强大、灵活且易于使用的框架,它使开发者能够充分利用最新的AI技术,创建真正智能和高效的系统。无论您是数据科学家、机器学习工程师,还是对AI应用感兴趣的开发者,LionAGI都为您开启了一个充满可能性的新世界。

随着AI技术的不断进步,LionAGI将继续发展和创新,为构建下一代智能系统提供坚实的基础。加入LionAGI社区,一起探索AI驱动的自动化未来吧!