llamafile:让AI走进每个人的电脑

在人工智能快速发展的今天,大型语言模型(LLM)正在改变我们与技术交互的方式。然而,运行这些强大的AI模型通常需要复杂的设置和强大的硬件支持。Mozilla创新团队开发的llamafile项目正是为了解决这一问题而生,它旨在让开源AI更易于访问,无论是对开发者还是普通用户而言。

llamafile的诞生与发展

llamafile项目于2023年底由Mozilla的创新团队推出。这个项目的核心理念是将运行LLM所需的所有复杂性压缩到一个单一的可执行文件中。这个文件可以在六种主要操作系统上运行,无需安装即可使用。项目一经推出就受到了开源AI开发者的热烈欢迎,迅速成为Mozilla在GitHub上最受欢迎的三大存储库之一。

llamafile的工作原理

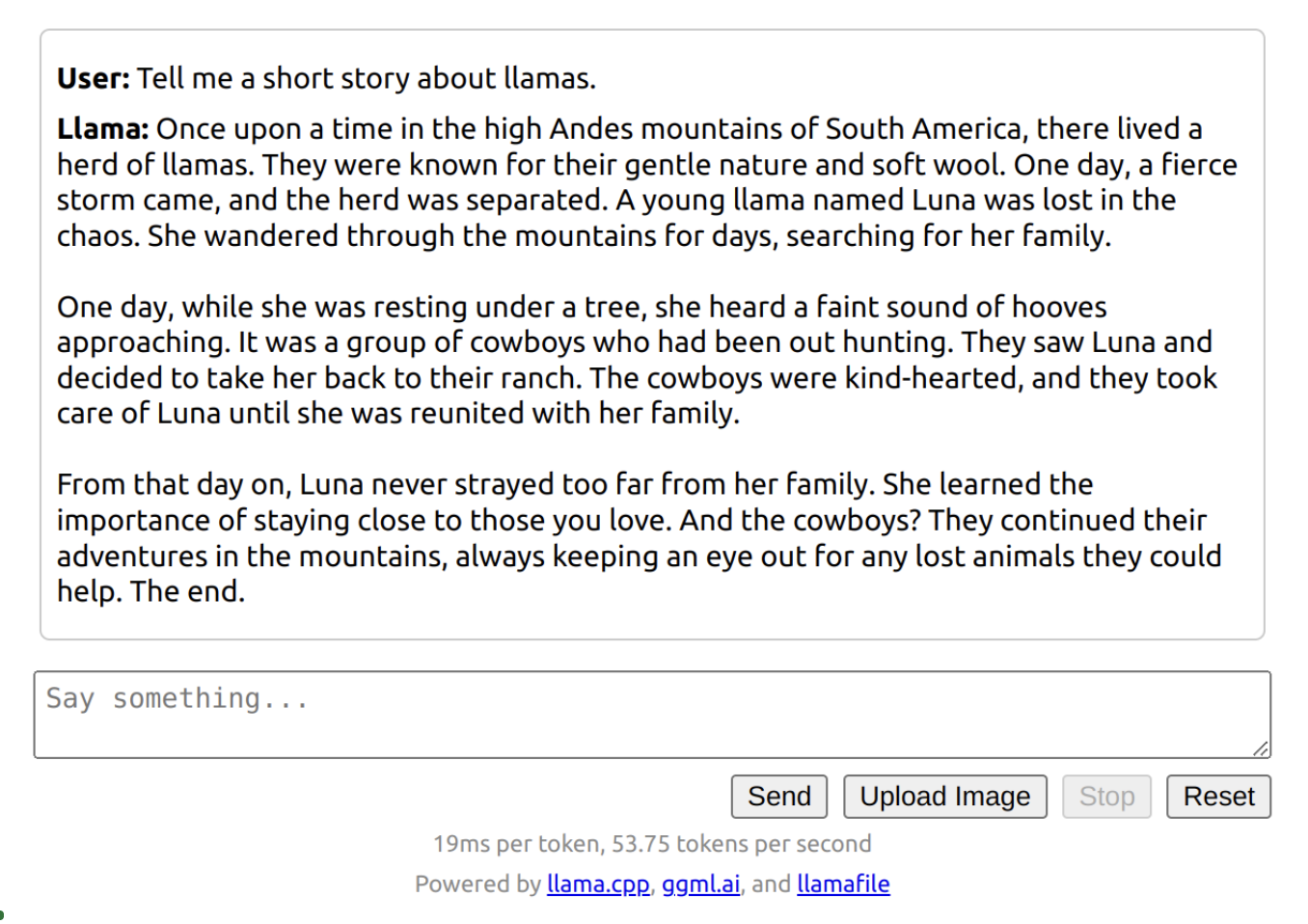

llamafile的魔力来自于它巧妙地结合了两个优秀的开源项目:llama.cpp和Cosmopolitan Libc。llama.cpp使得在普通硬件上运行LLM成为可能,而Cosmopolitan Libc则提供了跨平台兼容性。通过这种组合,llamafile实现了以下几个关键功能:

-

跨CPU微架构支持:llamafile可以在多种Intel和AMD处理器上运行,既支持最新的CPU特性,又保持对较旧计算机的兼容性。

-

跨CPU架构支持:llamafile同时支持AMD64和ARM64架构,通过一个简单的shell脚本来启动适当的版本。

-

跨操作系统支持:一个llamafile可以在macOS、Windows、Linux、FreeBSD、OpenBSD和NetBSD上运行。

-

内嵌模型权重:AI模型的权重可以直接嵌入到llamafile中,确保了模型行为的一致性和可重现性。

-

自定义llamafile创建:用户可以使用任何兼容的模型权重创建自己的llamafile,并轻松分发给他人使用。

llamafile的优势

llamafile项目带来了多方面的优势:

-

简化部署:llamafile将复杂的LLM堆栈简化为一个单一的可执行文件,极大地降低了使用门槛。

-

本地化AI:llamafile支持在用户自己的计算机上运行AI模型,无需互联网连接,保护了用户隐私。

-

跨平台兼容:一个llamafile可以在多种操作系统和硬件架构上运行,大大提高了兼容性。

-

性能优化:通过针对不同CPU和GPU的优化,llamafile在各种硬件上都能实现良好的性能。

-

开源生态:作为开源项目,llamafile积极与其他开源AI项目集成,促进了整个生态系统的发展。

llamafile的实际应用

llamafile的应用范围非常广泛。以下是一些具体的使用场景:

-

本地聊天机器人:用户可以在自己的计算机上运行类似ChatGPT的对话模型,无需担心隐私问题。

-

代码生成:开发者可以使用llamafile运行专门的代码生成模型,如WizardCoder,以获得编程辅助。

-

图像分析:通过集成LLaVA模型,llamafile可以进行图像描述和分析任务。

-

文本摘要:用户可以使用llamafile来总结长文本或网页内容。

-

创意写作:llamafile可以运行各种语言模型,辅助用户进行创意写作。

llamafile的未来发展

随着项目的不断发展,llamafile团队正在努力进一步提升性能和功能:

-

CPU性能优化:通过编写新的矩阵乘法内核,llamafile在某些情况下实现了高达10倍的性能提升。

-

GPU支持扩展:llamafile正在不断改进对NVIDIA和AMD GPU的支持,使更多用户能够利用GPU加速。

-

模型兼容性:llamafile持续跟进最新的开源模型,确保用户可以使用最先进的AI技术。

-

API兼容性:llamafile提供了与OpenAI兼容的API,使开发者能够更容易地从闭源解决方案迁移到开源方案。

-

社区合作:llamafile团队积极与其他开源AI项目合作,如LangChain和LlamaIndex,拓展其应用范围。

结语

llamafile项目代表了AI技术民主化和本地化的重要一步。它不仅使AI更加accessible,也为用户提供了更多对AI的控制权和隐私保护。随着项目的不断发展和完善,我们可以期待看到更多创新性的应用和更广泛的采用。llamafile正在为一个更开放、更分散的AI未来铺平道路,让每个人都能轻松地在自己的计算机上运行强大的AI模型。

开源AI的未来充满了可能性,而llamafile无疑是这个未来的重要组成部分。无论你是开发者、研究人员还是对AI感兴趣的普通用户,llamafile都为你提供了一个探索和利用AI技术的绝佳平台。让我们共同期待llamafile和开源AI生态系统的进一步发展,为创造一个更智能、更开放的世界贡献力量。