LLMFarm:在移动设备上释放AI语言模型的力量

在人工智能和自然语言处理快速发展的今天,大型语言模型(LLM)正在revolutionize各个领域。然而,运行这些复杂的AI模型通常需要强大的硬件和云计算资源。现在,一个名为LLMFarm的创新项目为我们带来了全新的可能性 - 在iOS和macOS设备上离线运行各种大型语言模型。

LLMFarm简介

LLMFarm是一款面向iOS和macOS平台的应用程序,允许用户在移动设备和Mac电脑上加载并运行不同的大型语言模型。该项目基于ggml和llama.cpp库开发,由Georgi Gerganov主导。LLMFarm的主要目标是让开发者和研究人员能够在iOS和macOS设备上测试各种LLM的性能,从而找到最适合自己项目的模型。

主要特性

LLMFarm拥有以下突出特性:

- 支持多种推理引擎:包括LLaMA、GPT-2、RWKV、Falcon等主流大型语言模型。

- 丰富的采样方法:温度采样、Top-K采样、Top-p (nucleus)采样等。

- Metal GPU加速:在支持的设备上利用Metal框架进行GPU加速(注意:不支持Intel Mac)。

- 模型设置模板:方便用户快速配置不同模型的参数。

- LoRA适配器支持:允许使用LoRA技术对模型进行微调。

- 上下文状态保存与恢复:可以保存对话上下文,方便继续之前的对话。

- Apple快捷指令集成:支持通过Siri快捷指令调用LLMFarm功能。

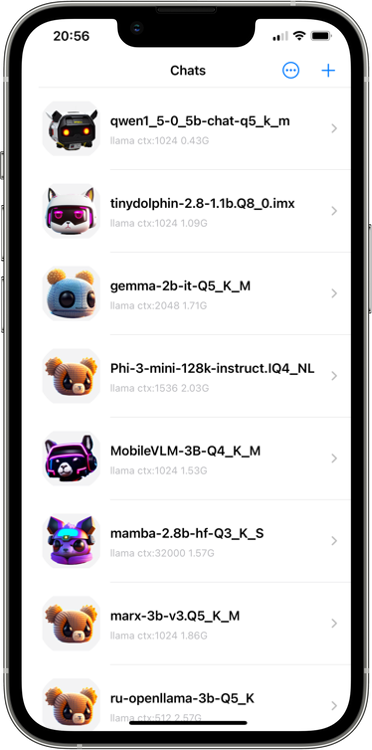

支持的模型

LLMFarm支持众多主流的大型语言模型,包括但不限于:

- LLaMA系列(1/2/3)

- GPT-2和GPT-NeoX

- Falcon

- RWKV

- Bloom

- StableLM

- Qwen

- Phi

- Mamba

- Mixtral MoE

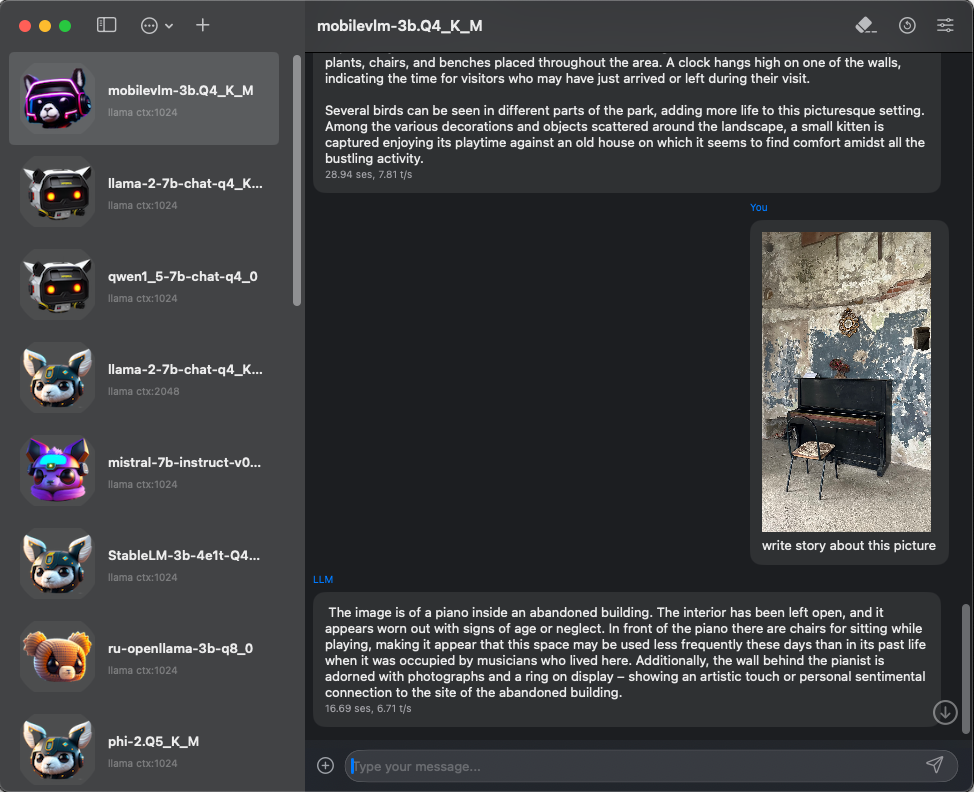

此外,LLMFarm还支持一些多模态模型,如LLaVA、BakLLaVA、Obsidian等,能够处理图像和文本的多模态任务。

技术实现

LLMFarm主要基于Swift语言开发,核心功能被封装在llmfarm_core库中。项目利用GGML库将各种大型语言模型转换为适合在移动设备上运行的格式。通过Metal框架,LLMFarm能够在支持的设备上实现GPU加速,大幅提升模型推理速度。

对于开发者来说,LLMFarm提供了灵活的API和丰富的配置选项。用户可以通过JSON文件自定义推理参数,实现对模型行为的精细控制。项目还支持LoRA技术,允许用户在有限的计算资源下对模型进行微调和定制。

使用指南

要开始使用LLMFarm,用户可以通过以下步骤:

- 从App Store下载LLMFarm应用或通过TestFlight安装最新测试版。

- 下载所需的模型文件,LLMFarm支持

.bin(GGJTv3格式)和.gguf格式的模型。 - 在应用中创建新的聊天,选择要使用的模型和相关参数。

- 开始与AI模型进行对话交互!

对于遇到的常见问题,LLMFarm的FAQ部分提供了详细的解答。如果遇到模型加载错误,请确保选择了正确的推理引擎,并检查模型格式是否兼容。

开发者相关

对于想要参与LLMFarm开发或基于其构建自己项目的开发者,项目提供了完整的源代码。要克隆仓库并构建项目,可以使用以下命令:

git clone --recurse-submodules https://github.com/guinmoon/LLMFarm

项目使用MIT许可证,鼓励开发者自由使用、修改和分发代码。

未来展望

随着移动设备算力的不断提升,在本地运行大型AI模型将成为可能。LLMFarm为这一趋势提供了有力支持,让开发者能够更便捷地在移动平台上开发和测试AI应用。未来,我们可以期待看到更多基于LLMFarm的创新应用,如智能助手、实时翻译、代码生成等。

LLMFarm项目正在积极发展中,欢迎开发者和研究人员参与贡献,共同推动移动AI技术的进步。无论您是AI爱好者、移动开发者还是NLP研究者,LLMFarm都为您提供了一个强大的工具,让您能够在iOS和macOS设备上探索大型语言模型的无限可能。

结语

LLMFarm为在移动设备上运行大型语言模型开辟了新的可能性。通过将复杂的AI能力带到用户的掌中,它不仅为开发者和研究人员提供了宝贵的工具,也为未来更智能、更个性化的移动应用铺平了道路。随着项目的不断发展和完善,我们有理由期待LLMFarm能够在推动移动AI技术发展方面发挥越来越重要的作用。

如果您对LLMFarm感兴趣,不妨立即下载试用,感受AI大模型的魅力。同时也欢迎您为这个开源项目贡献自己的力量,一起推动移动AI技术的进步!