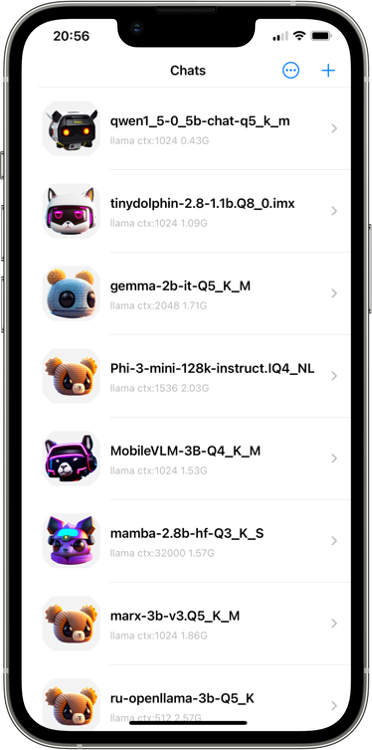

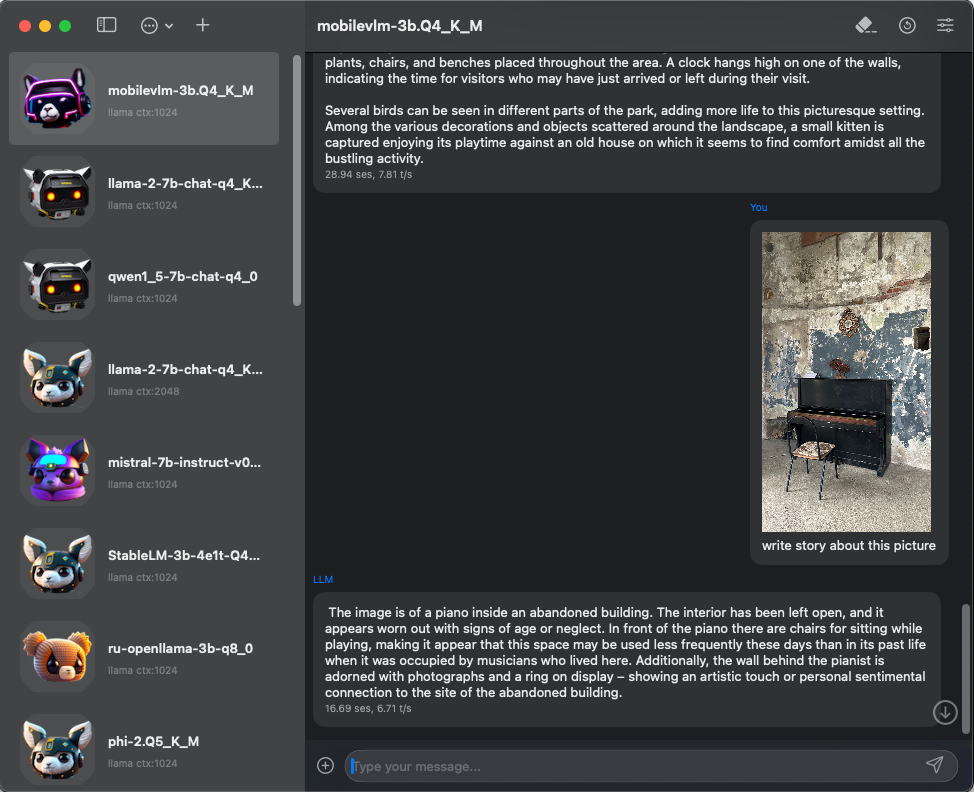

LLMFarm

LLMFarm是一款用于处理大型语言模型(LLM)的iOS和MacOS应用。它允许您使用特定参数加载不同的LLM。通过LLMFarm,您可以在iOS和macOS上测试不同LLM的性能,并为您的项目找到最合适的模型。

基于Georgi Gerganov开发的ggml和llama.cpp。

还使用了以下来源的代码:

功能特性

- MacOS(13+)

- iOS(16+)

- 多种推理方式

- 多种采样方法

- Metal(在Intel Mac上不工作)

- 模型设置模板

- 支持LoRA适配器

- 支持LoRA微调

- 支持将LoRA导出为模型

- 恢复上下文状态

- Apple快捷指令

推理方式

-

LLaMA 1,2,3

LLaMA 1,2,3 -

Gemma

Gemma -

Phi 模型

Phi 模型 -

GPT2 + Cerebras

GPT2 + Cerebras -

Starcoder(Santacoder)

Starcoder(Santacoder) -

Falcon

Falcon -

MPT

MPT -

Bloom

Bloom -

StableLM-3b-4e1t

StableLM-3b-4e1t -

Qwen

Qwen -

Yi 模型

Yi 模型 -

Deepseek 模型

Deepseek 模型 -

Mixtral MoE

Mixtral MoE -

PLaMo-13B

PLaMo-13B -

Mamba

Mamba - RWKV (20B 分词器)

- GPTNeoX

- Replit

多模态

注意:对于 Falcon, Alpaca, GPT4All, 中文 LLaMA / Alpaca 和中文 LLaMA-2 / Alpaca-2, Vigogne (法语), Vicuna, Koala, OpenBuddy (多语言), Pygmalion/Metharme, WizardLM, Baichuan 1 & 2 及其衍生版本, Aquila 1 & 2, Mistral AI v0.1, Refact, Persimmon 8B, MPT, Bloom,请在模型设置中选择 llama inferece。

采样方法

- 温度采样 (温度, top-k, top-p)

- 无尾采样 (TFS)

- 局部典型采样

- Mirostat

- 贪婪采样

- 语法采样 (不适用于 GPTNeoX, GPT-2, RWKV)

- 无分类器引导

入门指南

您可以在 FAQ 部分 找到一些问题的答案。

推理选项

创建聊天时,会生成一个 JSON 文件,您可以在其中指定额外的推理选项。聊天文件位于 "chats" 目录中。您可以在这里查看所有推理选项。

模型

您可以在这里下载一些支持的模型。

开发

llmfarm_core 已移至单独的仓库。要构建 llmfarm,您需要递归克隆此仓库:

git clone --recurse-submodules https://github.com/guinmoon/LLMFarm

访问官网

访问官网 Github

Github Huggingface

Huggingface 文档

文档 论文

论文