LLM-Finetuning入门学习资料汇总 - 大模型微调技术实践指南

大语言模型(LLM)的微调技术是当前自然语言处理领域的一个热门研究方向。通过对预训练模型进行微调,可以让模型在特定任务上获得更好的表现。本文整理了GitHub上一个优秀的LLM微调项目LLM-Finetuning的相关学习资源,帮助读者快速入门大模型微调技术。

项目简介

LLM-Finetuning是一个集合了多种大语言模型微调技术实践的开源项目,包含了20多个Jupyter Notebook,涵盖了LoRA、QLoRA、PEFT等主流微调方法在各种模型上的应用示例。该项目旨在帮助开发者学习和实践最新的LLM微调技术。

主要内容

项目中包含的主要Notebook及其内容如下:

- 使用LoRA和Hugging Face高效训练大语言模型

- 在Colab中微调自己的Llama 2模型

- 基于LLaMA-7B模型的Guanaco聊天机器人演示

- 使用PEFT微调Bloom-560m标注器

- 使用PEFT和bnb微调Meta OPT-6-1b模型

- 使用BNB自监督训练微调Falcon-7b

- 使用QLoRA方法微调Llama 2 7B模型

- 在Colab中微调Vicuna 13B 8-bit模型

- 使用bfloat16精度训练GPT-NeoX-20B模型

- MPT-Instruct-30B模型训练

- 对任意LLM模型进行RLHF训练

- 在自定义数据集上微调Microsoft Phi-1.5B模型

- 微调OpenAI GPT-3.5 Turbo

- 使用AutoTrain微调Mistral-7B

- 使用LangChain实现RAG

- 使用Neo4j和LangChain增强问答能力

- 使用OpenAI函数构建知识图谱

- 使用LangChain和OpenAI将文档转换为知识图谱

- 使用HQQ框架进行1-bit量化训练

- 使用Unsloth加速Gemma2 9B模型微调

- 使用MLflow评估RAG pipeline

- 使用MLflow评估Hugging Face LLM

学习资源

-

项目GitHub地址: LLM-Finetuning

-

在线运行环境: 所有Notebook都可以直接在Google Colab中打开和运行,方便读者快速上手实践。

-

相关文档:

- 推荐阅读:

总结

LLM-Finetuning项目提供了丰富的大模型微调实践示例,涵盖了当前主流的微调技术和模型。通过学习该项目,读者可以快速掌握LLM微调的基本方法,并在此基础上进行更深入的研究和应用。无论是NLP研究人员还是工程师,都可以从中获得宝贵的学习资源。

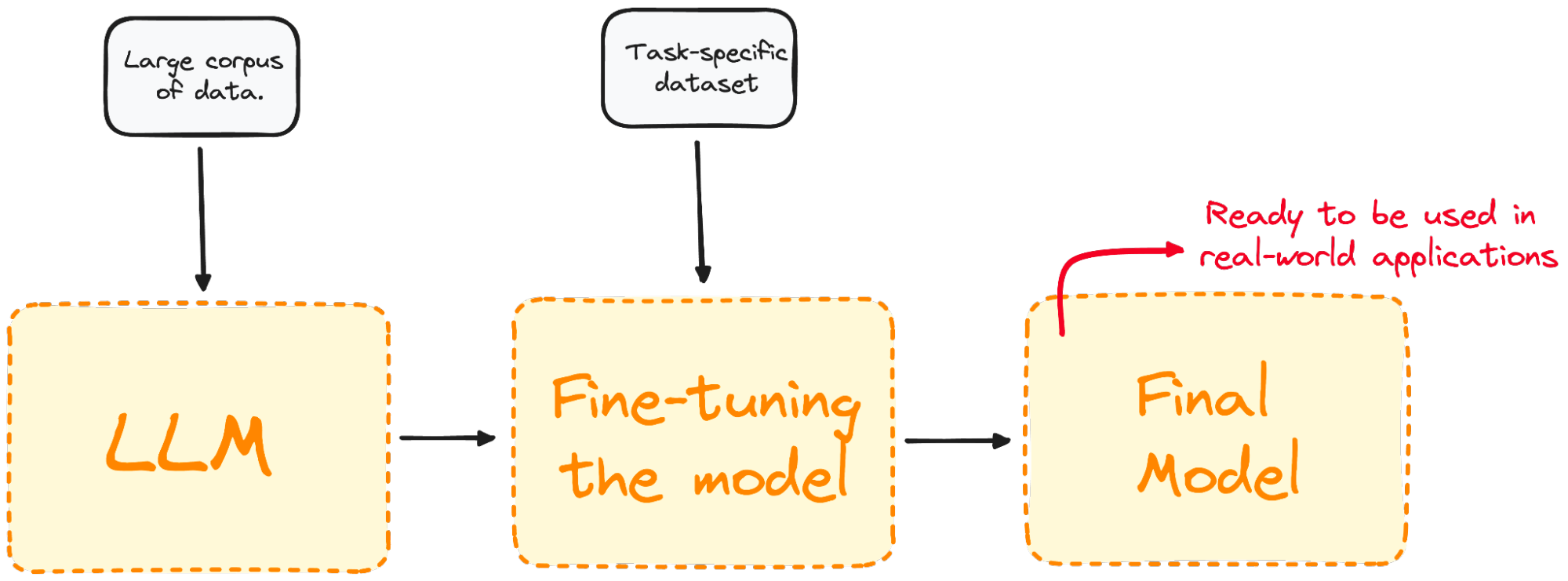

LLM微调技术概览图

希望本文对大家学习LLM微调技术有所帮助。如果想深入学习,建议clone该项目到本地,并结合相关论文和文档进行实践。在掌握基本原理后,可以尝试在自己的任务和数据上应用这些技术。LLM微调是一个rapidly evolving的领域,保持持续学习很重要。