LongBench: 开创性的长文本理解评估基准

在人工智能和自然语言处理领域,大语言模型(LLMs)的出现无疑是一场革命。这些模型在各种语言任务中展现出惊人的能力,但它们也面临着一个共同的挑战 - 长文本理解。大多数LLMs只能处理几千个token的输入,这严重限制了它们在处理长篇文档、报告或代码库等场景中的应用。为了推动长文本理解技术的发展,清华大学知识工程实验室(THUDM)团队开发了一个创新性的评估基准 - LongBench。

LongBench的独特之处

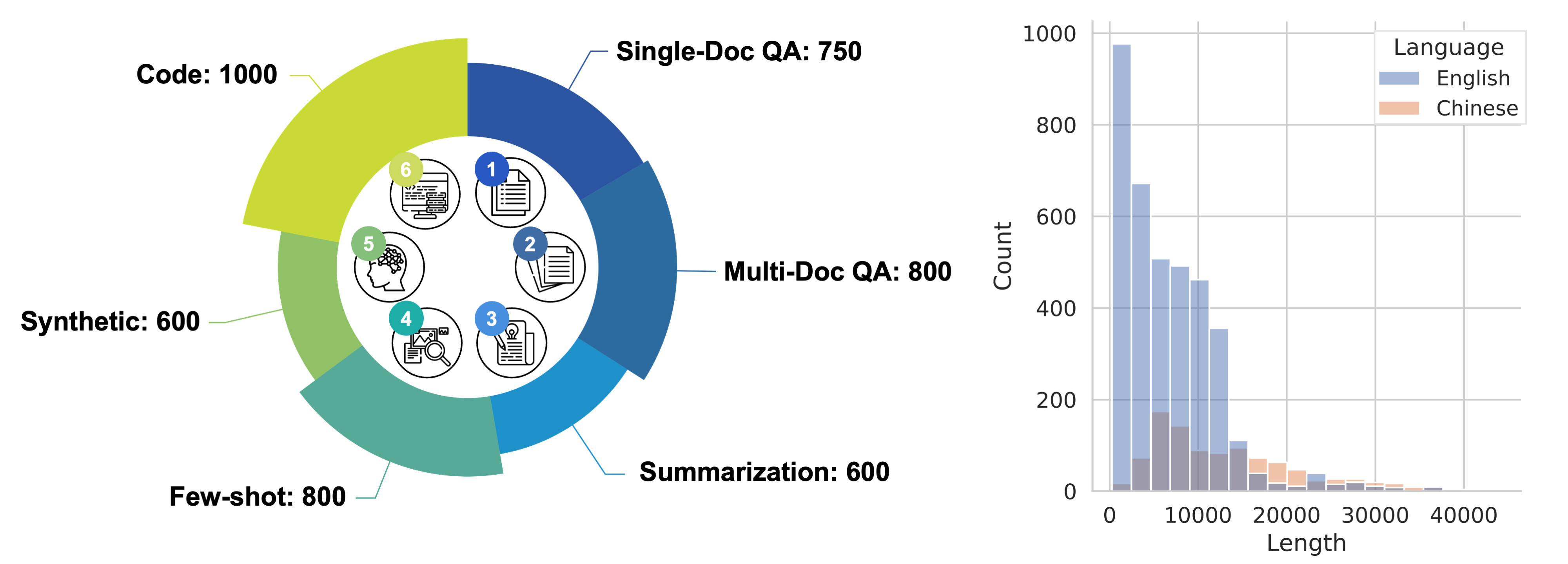

LongBench是首个专门针对大语言模型长文本理解能力的双语多任务综合评估基准。它具有以下几个显著特点:

-

双语评估: LongBench同时包含中文和英文任务,这使得它能够全面评估模型在不同语言长文本上的表现。

-

多任务覆盖: 该基准包含6大类21个不同任务,涵盖了长文本应用的关键场景,如单文档问答、多文档问答、摘要生成、少样本学习、合成任务和代码补全等。

-

长文本挑战: LongBench中大多数任务的平均长度在5000到15000词之间,充分测试模型处理长文本的能力。

-

自动化评估: 考虑到长文本评估可能涉及高昂的人工标注或API调用成本,LongBench采用了完全自动化的评估方法,以最低成本衡量模型的长文本理解能力。

LongBench的构成

LongBench包含以下任务类型:

- 多文档问答(3个英文任务,1个中文任务)

- 单文档问答(3个英文任务,1个中文任务)

- 摘要生成(3个英文任务,1个中文任务)

- 少样本学习(3个英文任务,1个中文任务)

- 合成任务(2个英文任务,1个中文任务)

- 代码补全(2个任务)

总计14个英文任务,5个中文任务和2个代码任务,共4,750条测试数据。这种多样化的任务设置确保了对模型长文本处理能力的全面评估。

LongBench-E: 更均匀的长度分布

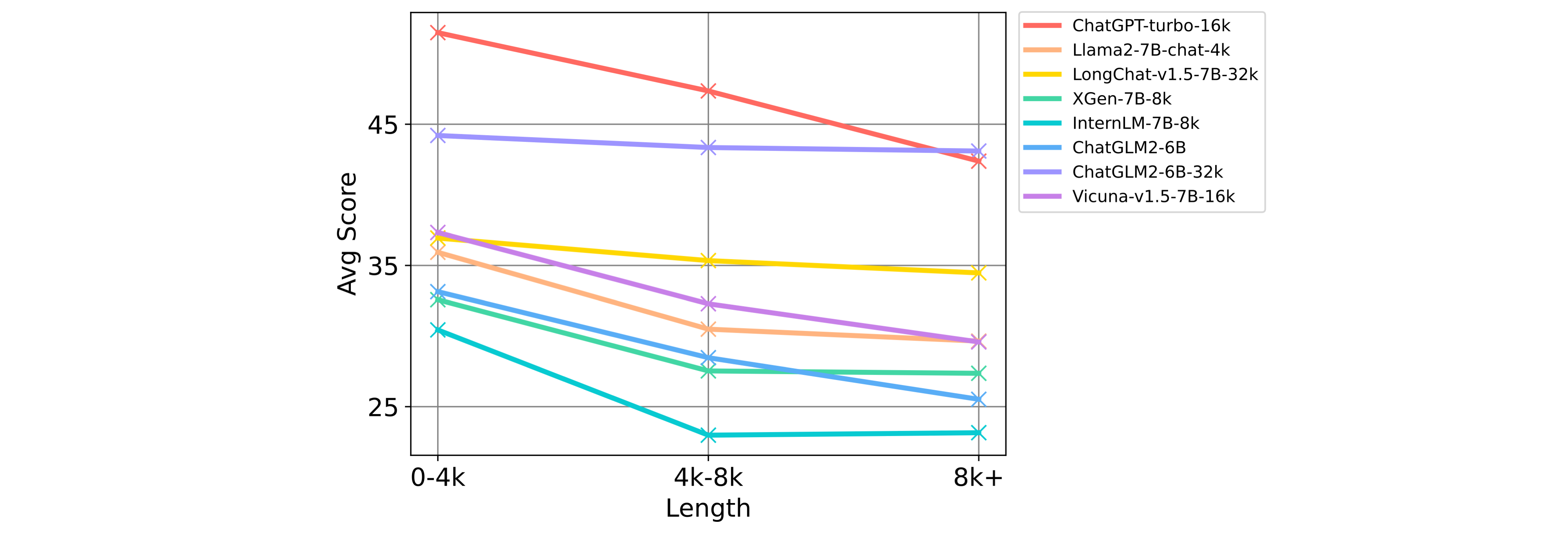

除了标准的LongBench,研究团队还提供了LongBench-E。这是一个通过均匀采样构建的测试集,在0-4k、4k-8k和8k+这三个长度区间内有大致相同数量的测试数据。这种设计使得LongBench-E更适合分析模型在不同输入长度下的性能变化。

LongBench的评估结果

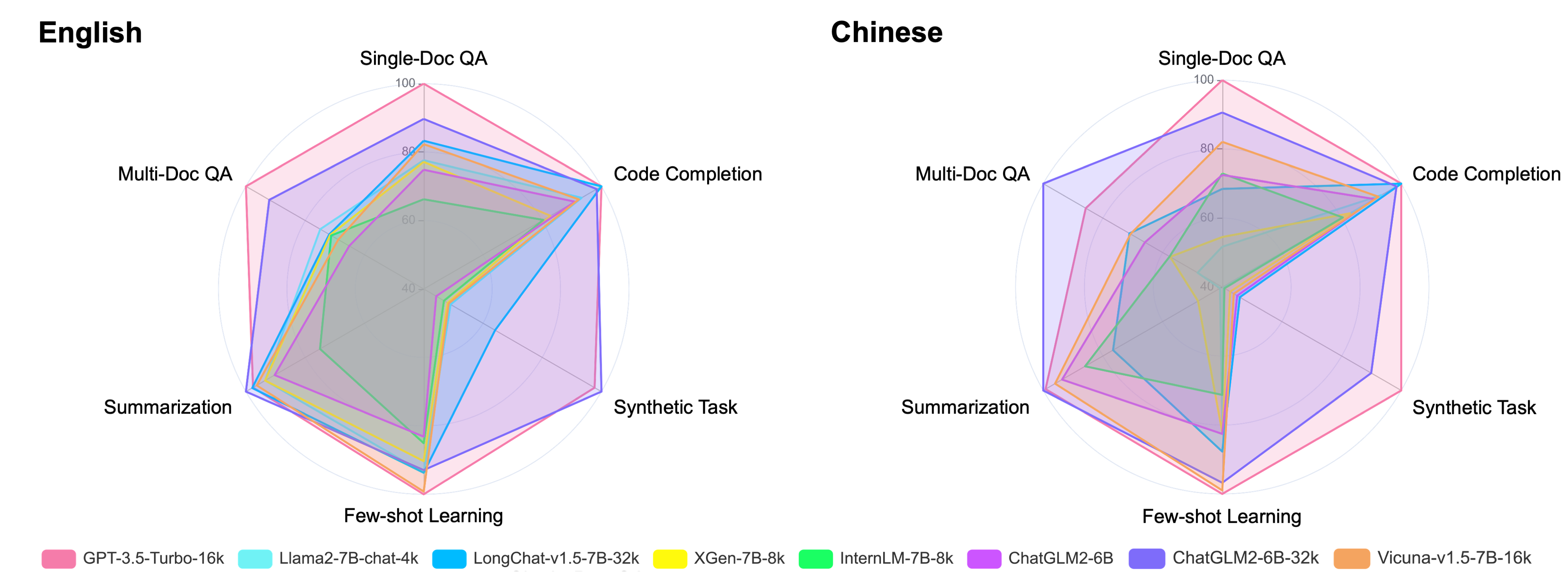

LongBench对多个主流大语言模型进行了全面评估,包括GPT-3.5-Turbo-16k、Llama2-7B-chat-4k、LongChat-v1.5-7B-32k、XGen-7B-8k、InternLM-7B-8k、ChatGLM2-6B-32k、Vicuna-v1.5-7B-16k和ChatGLM3-6B-32k等。评估采用零样本(Zero-shot)场景,结果显示了不同模型在长文本理解方面的优劣。

英文任务评估结果

在英文任务中,ChatGLM3-6B-32k表现最为出色,平均得分达到48.5%。GPT-3.5-Turbo-16k紧随其后,得分为44.0%。这两个模型在各个任务类别中都展现出了较强的长文本处理能力。值得注意的是,尽管Llama2-7B-chat-4k的上下文窗口较小,但在某些任务中仍然表现不俗,特别是在少样本学习任务中。

中文任务评估结果

在中文任务上,ChatGLM3-6B-32k再次领先,平均得分高达52.8%。GPT-3.5-Turbo-16k和ChatGLM2-6B-32k分别以44.5%和41.7%的得分位列第二和第三。这些结果表明,一些模型在处理中文长文本时具有很强的能力,但与英文相比,中文长文本理解仍有提升空间。

不同长度下的性能变化

为了深入分析模型在不同文本长度下的表现,研究团队使用LongBench-E进行了详细评估。结果显示,大多数模型的性能随着文本长度的增加而下降,但下降幅度因模型而异。一些专门针对长文本优化的模型,如ChatGLM3-6B-32k,在较长文本上保持了相对稳定的性能。

LongBench的应用与影响

LongBench的发布对自然语言处理领域产生了深远影响:

-

推动长文本处理技术进步: 通过提供全面的评估基准,LongBench激励研究人员和开发者改进现有模型,提高它们处理长文本的能力。

-

揭示现有模型的局限性: 评估结果清晰地展示了当前模型在处理超长文本时的不足,为未来研究指明了方向。

-

促进多语言长文本处理: 通过同时评估中英文任务,LongBench推动了多语言长文本处理技术的发展。

-

标准化长文本评估: LongBench为长文本理解能力的评估提供了一个标准化的框架,便于不同模型间的横向比较。

-

启发新的应用场景: 通过展示长文本处理的可能性,LongBench为开发新的长文本应用提供了灵感。

如何使用LongBench

对于研究人员和开发者而言,LongBench提供了便捷的使用方式:

-

数据获取: 可以通过Hugging Face数据集直接下载和加载LongBench数据。

-

评估流程: LongBench团队提供了完整的评估代码,包括模型预测(pred.py)和结果评估(eval.py)。

-

自定义评估: 用户可以根据需要修改配置文件,以适应不同模型的输入格式和输出长度限制。

-

扩展评估: 除了标准评估,LongBench还提供了基于检索和摘要的长文本压缩评估代码。

LongBench的未来展望

随着自然语言处理技术的不断进步,LongBench也在持续更新和扩展:

-

新模型评估: 随着新的长文本处理模型不断涌现,LongBench将继续对它们进行评估和比较。

-

任务扩展: 未来可能会加入更多类型的长文本处理任务,以覆盖更广泛的应用场景。

-

多语言扩展: 虽然目前主要关注中英文,但未来可能会扩展到更多语言,以评估模型的多语言长文本处理能力。

-

实时排行榜: 建立一个动态更新的排行榜系统,实时反映不同模型在LongBench上的表现。

-

社区贡献: 鼓励研究社区参与LongBench的改进和扩展,使其成为一个持续演进的开放平台。

结语

LongBench的出现标志着长文本理解研究进入了一个新的阶段。它不仅为评估现有模型提供了全面的工具,也为未来的研究和开发指明了方向。随着人工智能技术的不断进步,我们有理由相信,在LongBench等基准的推动下,大语言模型将在不久的将来突破长文本处理的瓶颈,为更广泛的应用场景提供强大支持。

对于研究人员、开发者和AI爱好者来说,LongBench无疑是一个值得关注和深入研究的项目。它不仅提供了宝贵的评估数据和工具,也为我们思考AI的未来发展方向提供了新的视角。让我们共同期待LongBench带来的更多突破和创新!