MatMul-Free LLM入门学习资料 - 无矩阵乘法的革命性语言模型

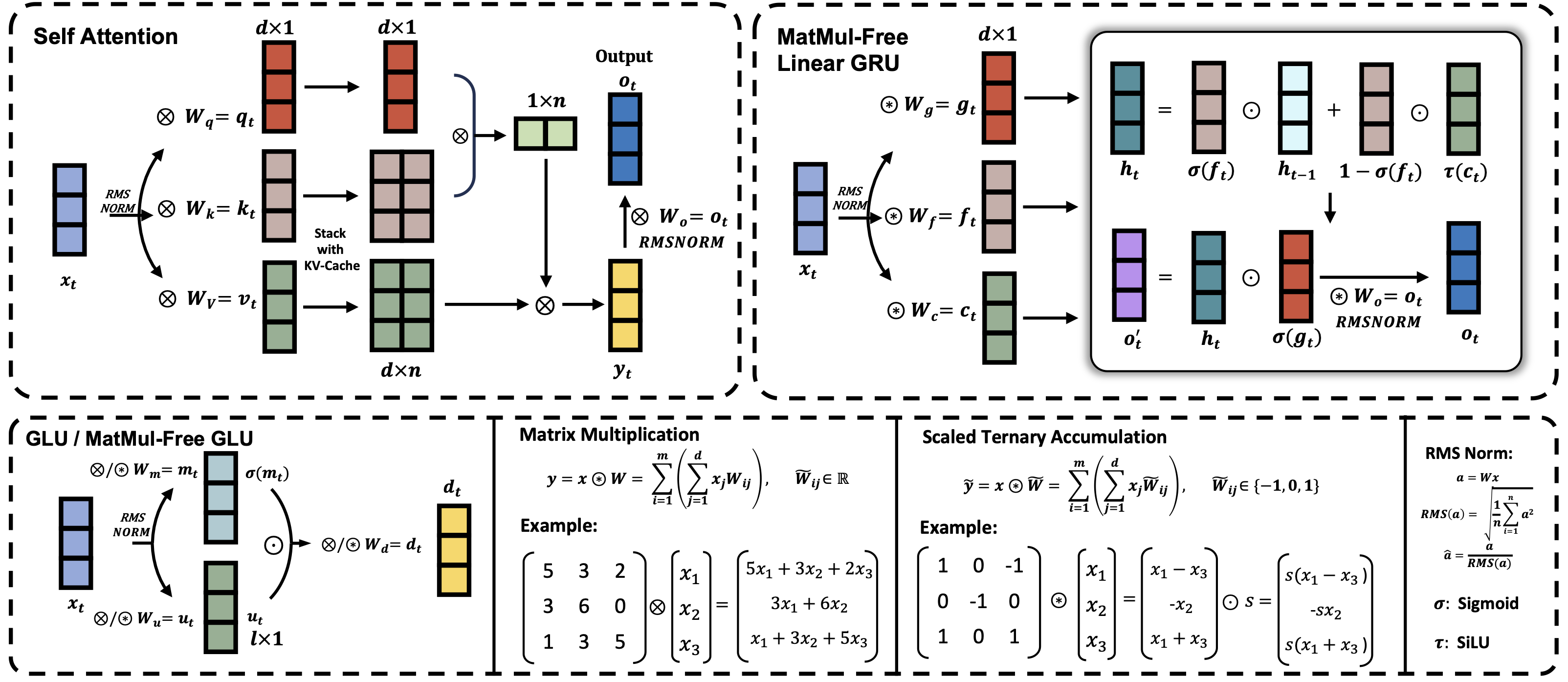

MatMul-Free LLM是一种创新的大规模语言模型架构,它通过消除传统语言模型中的矩阵乘法(MatMul)运算,显著降低了计算和内存需求。本文将为您介绍这一前沿技术的关键资源和入门指南。

项目概述

MatMul-Free LLM由加州大学圣克鲁兹分校的研究团队开发,旨在解决大型语言模型日益增长的计算成本问题。通过使用三元权重和简化的数学运算,该模型在保持竞争性能的同时,大大减少了资源消耗。

核心资源

-

GitHub仓库: https://github.com/ridgerchu/matmulfreellm 这是项目的官方代码库,包含了模型实现和使用说明。

-

研究论文: Scalable MatMul-free Language Modeling 详细介绍了MatMul-Free LLM的技术原理和实验结果。

-

预训练模型: HuggingFace Model Hub 提供了多个规模的预训练MatMul-Free LLM模型,可直接使用。

安装和使用

要开始使用MatMul-Free LLM,请按照以下步骤操作:

-

安装依赖:

pip install torch>=2.0 triton>=2.2 einops pip install -U git+https://github.com/ridgerchu/matmulfreellm -

加载预训练模型:

from transformers import AutoModelForCausalLM, AutoTokenizer model_name = "ridger/MMfreeLM-370M" # 可选其他规模模型 tokenizer = AutoTokenizer.from_pretrained(model_name) model = AutoModelForCausalLM.from_pretrained(model_name).cuda() -

生成文本:

input_prompt = "In a shocking finding, scientist discovered a herd of unicorns living in a remote, " input_ids = tokenizer(input_prompt, return_tensors="pt").input_ids.cuda() outputs = model.generate(input_ids, max_length=32, do_sample=True, top_p=0.4, temperature=0.6) print(tokenizer.batch_decode(outputs, skip_special_tokens=True)[0])

性能对比

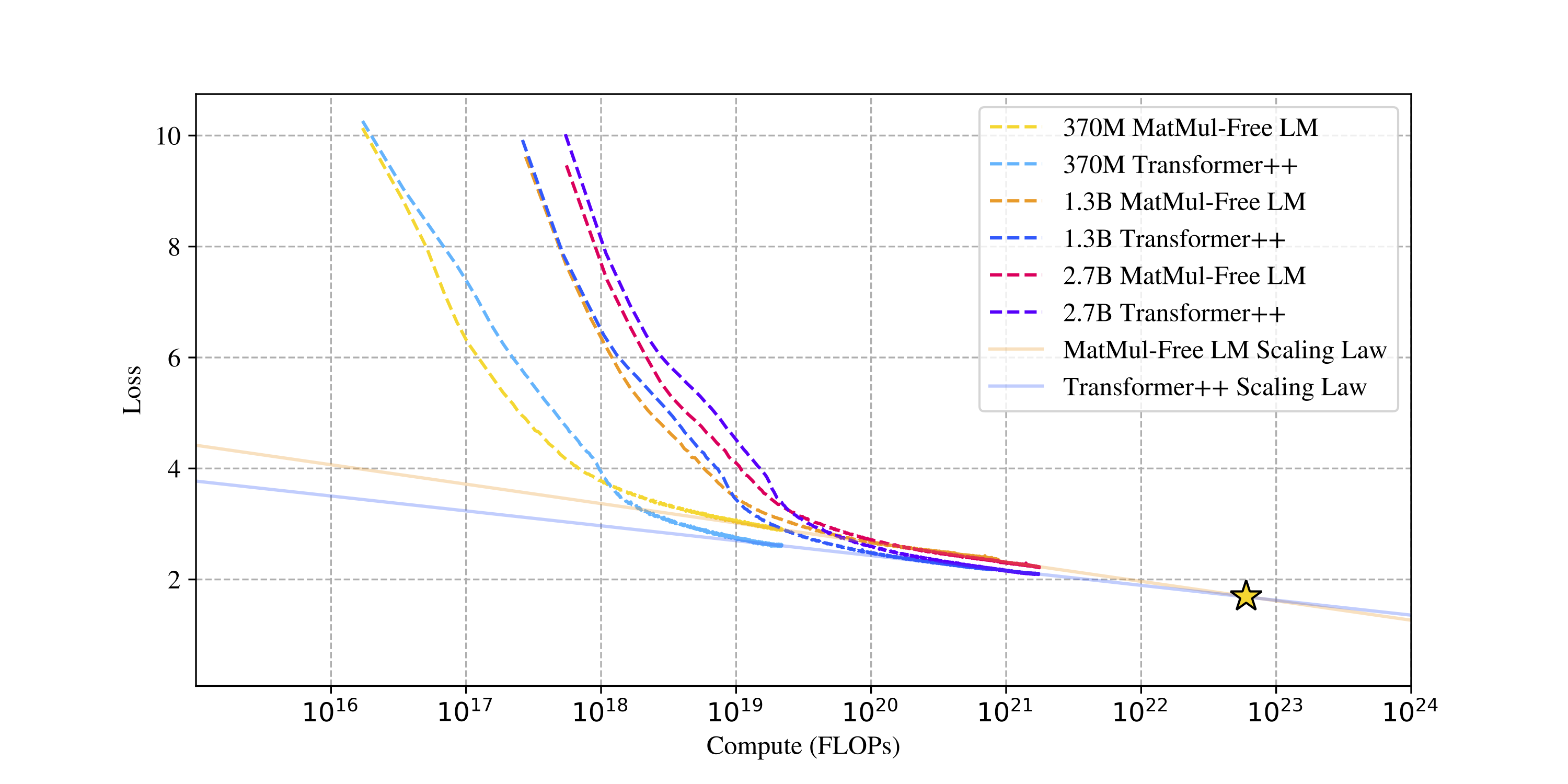

研究表明,MatMul-Free LLM在多项任务上的表现与传统Transformer模型相当,甚至在某些方面更胜一筹。以下是模型在不同参数规模下的性能对比:

未来展望

MatMul-Free LLM的出现为大规模语言模型的发展开辟了新的方向。它不仅大幅降低了计算成本,还为在资源受限的设备上部署强大的语言模型提供了可能性。随着研究的深入,我们可以期待看到更多基于这一技术的创新应用。

结语

MatMul-Free LLM代表了语言模型技术的一次重要突破。通过本文介绍的资源,相信读者能够快速入门并开始探索这一激动人心的新技术。无论您是研究人员、开发者还是AI爱好者,MatMul-Free LLM都值得您深入了解和尝试。

要了解更多信息,请访问项目GitHub页面或阅读原始研究论文。让我们一起期待MatMul-Free LLM为AI领域带来的更多可能性!