MatMul-Free LLM:重新定义大型语言模型的计算范式

在人工智能和自然语言处理领域,大型语言模型(LLMs)一直是研究和应用的热点。然而,随着模型规模的不断扩大,其计算成本也呈指数级增长,这给模型的训练和部署带来了巨大挑战。近期,一项名为MatMul-Free LLM的创新技术引起了学术界和产业界的广泛关注,它通过消除传统LLMs中最耗费计算资源的矩阵乘法(MatMul)操作,为大型语言模型的发展开辟了一条全新的道路。

MatMul-Free LLM的核心理念

MatMul-Free LLM的核心思想是用更简单、更高效的运算来替代传统LLMs中的矩阵乘法操作。这种方法不仅大幅降低了计算复杂度,还保持了模型的性能水平。根据GitHub上的MatMul-Free LLM项目介绍,该技术与🤗 Transformers库兼容,这意味着它可以无缝集成到现有的深度学习框架中。

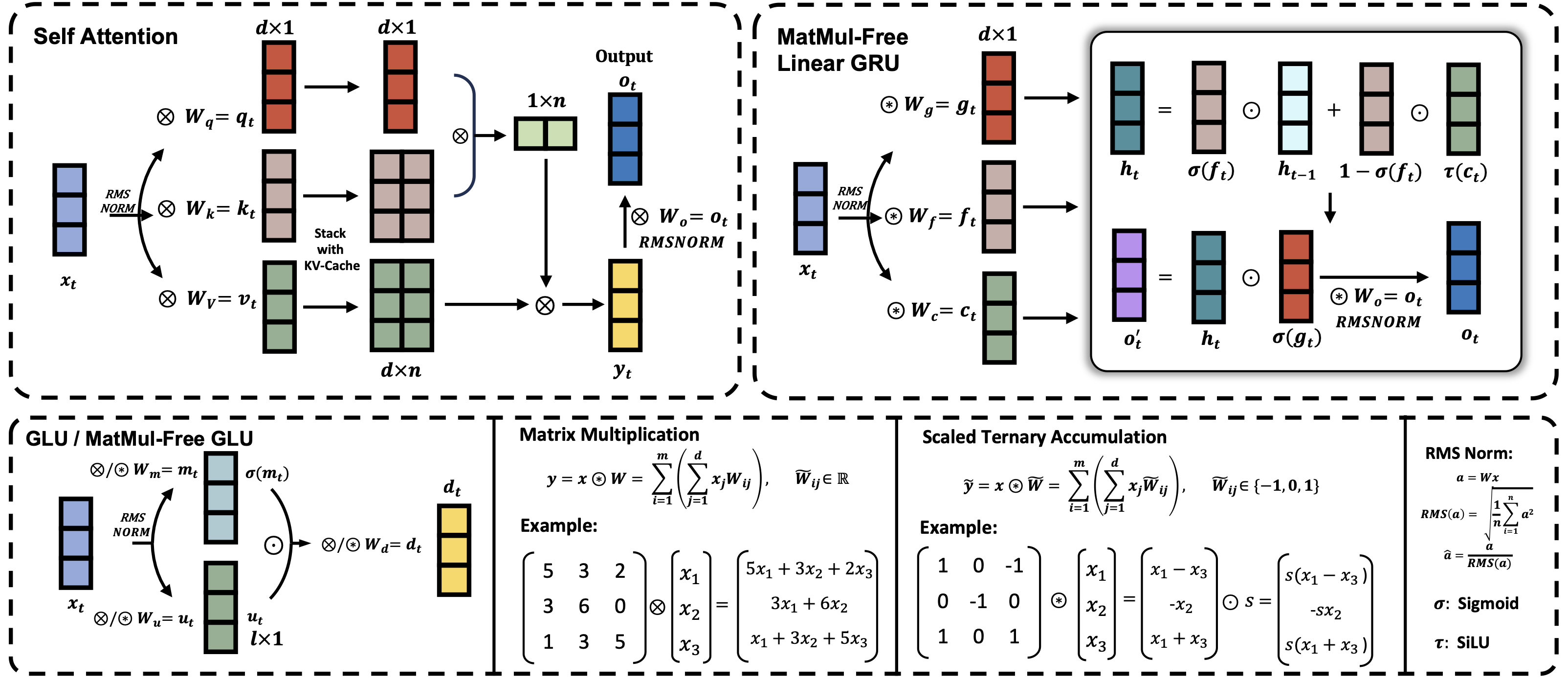

上图展示了MatMul-Free LLM的基本架构,它通过创新的设计消除了传统LLMs中的矩阵乘法操作,从而实现了更高效的计算。

技术优势与性能表现

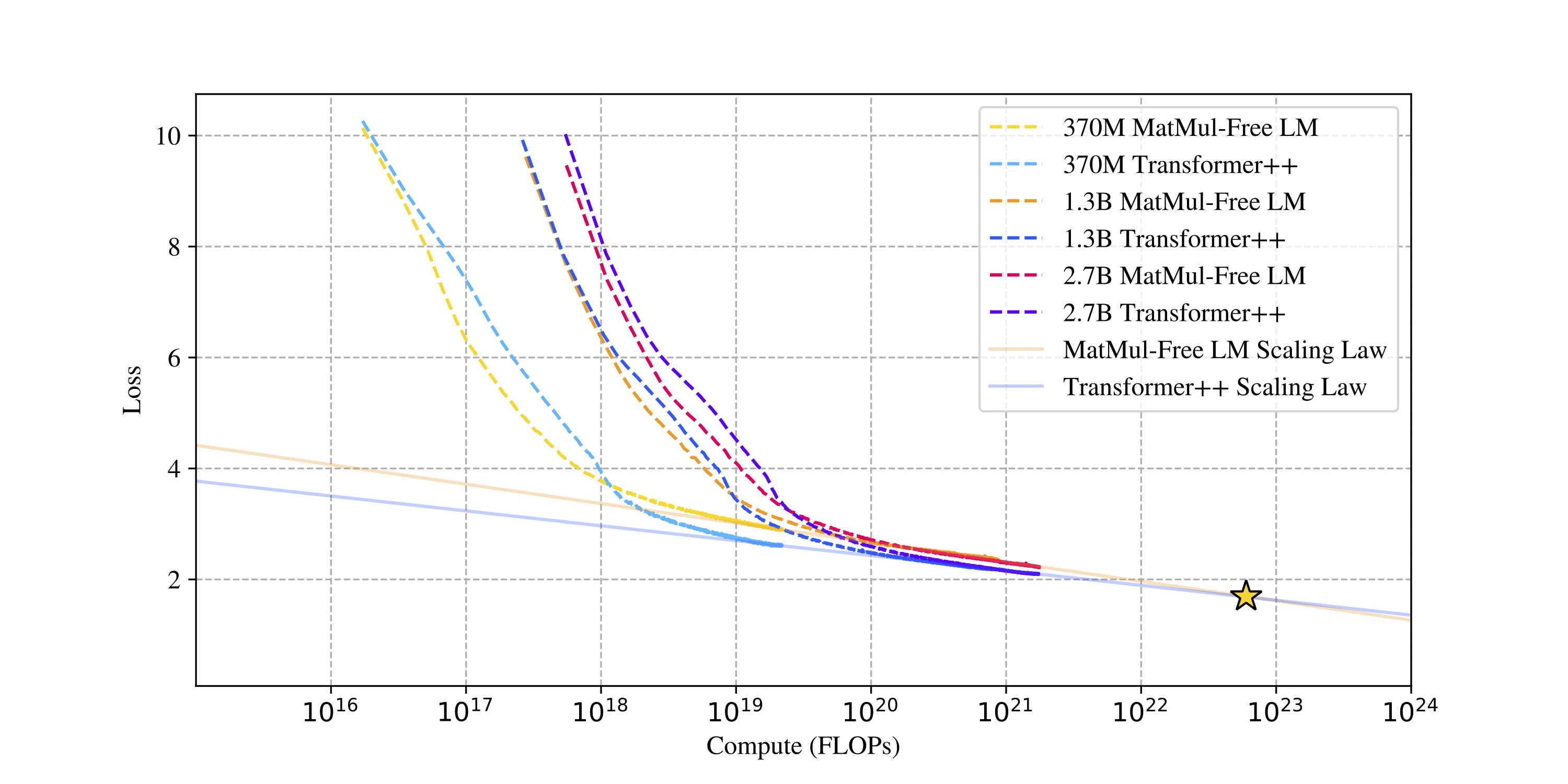

MatMul-Free LLM的一个显著优势是其出色的扩展性。研究人员对370M、1.3B和2.7B参数规模的模型进行了评估,结果表明MatMul-Free LLM在利用额外计算资源提升性能方面比传统Transformer++模型更为高效。

上图清晰地展示了MatMul-Free LLM相比传统模型在扩展性上的优势。随着模型规模的增加,MatMul-Free LLM的性能提升曲线更为陡峭,这意味着它能更有效地利用增加的计算资源。

实现与部署

MatMul-Free LLM的实现依赖于几个关键的技术组件:

- PyTorch(版本 >= 2.0)

- Triton(版本 >= 2.2)

- einops库

这些依赖项确保了MatMul-Free LLM能够高效运行,并与现有的深度学习生态系统兼容。项目提供了简单的安装指令:

pip install -U git+https://github.com/ridgerchu/matmulfreellm

预训练模型与应用

MatMul-Free LLM项目提供了多个预训练模型,包括370M、1.3B和2.7B参数规模的版本。这些模型在不同规模的数据集上进行了训练,为研究人员和开发者提供了丰富的选择。

这些预训练模型可以直接用于各种自然语言处理任务,或作为特定任务的基础模型进行微调。

文本生成示例

MatMul-Free LLM不仅在理论上展现了优势,在实际应用中也表现出色。以下是一个使用MatMul-Free LLM进行文本生成的简单示例:

import os

os.environ["TOKENIZERS_PARALLELISM"] = "false"

import mmfreelm

from transformers import AutoModelForCausalLM, AutoTokenizer

name = 'ridger/MMfreeLM-1.3B' # 使用1.3B参数模型

tokenizer = AutoTokenizer.from_pretrained(name)

model = AutoModelForCausalLM.from_pretrained(name).cuda().half()

input_prompt = "In a shocking finding, scientist discovered a herd of unicorns living in a remote, "

input_ids = tokenizer(input_prompt, return_tensors="pt").input_ids.cuda()

outputs = model.generate(input_ids, max_length=32, do_sample=True, top_p=0.4, temperature=0.6)

print(tokenizer.batch_decode(outputs, skip_special_tokens=True)[0])

这个例子展示了如何使用MatMul-Free LLM模型生成创意文本,充分体现了该技术在实际应用中的潜力。

MatMul-Free LLM的潜在影响

MatMul-Free LLM技术的出现可能对AI领域产生深远影响:

-

降低计算成本:通过消除矩阵乘法,大幅减少了模型训练和推理的计算需求,这可能导致AI应用的成本显著降低。

-

扩大应用范围:较低的计算需求意味着MatMul-Free LLM可以在更多设备上运行,包括资源受限的边缘设备,从而扩大了LLMs的应用场景。

-

促进绿色AI发展:减少计算需求直接转化为能源消耗的降低,有助于推动更环保的AI技术发展。

-

加速AI创新:更高效的计算方式可能激发新的算法和模型架构的创新,推动整个AI领域的发展。

-

改变硬件设计方向:MatMul-Free的计算范式可能影响未来AI芯片的设计方向,促进更专门化、更高效的AI硬件的出现。

结语

MatMul-Free LLM代表了大型语言模型发展的一个重要里程碑。通过创新的计算方法,它不仅提高了模型的效率,还为AI的可持续发展提供了新的可能性。随着这项技术的不断完善和广泛应用,我们有理由期待它将为自然语言处理和人工智能领域带来更多突破性的进展。

MatMul-Free LLM的出现,标志着AI研究正在向更高效、更可持续的方向发展。它不仅是技术上的创新,更是一种思维方式的转变,鼓励研究者们跳出传统框架,探索AI发展的新途径。未来,随着更多研究的深入和实际应用的拓展,MatMul-Free LLM技术有望在推动AI民主化、提高AI可访问性方面发挥重要作用,为构建更智能、更高效的未来贡献力量。