ML-Bench项目简介

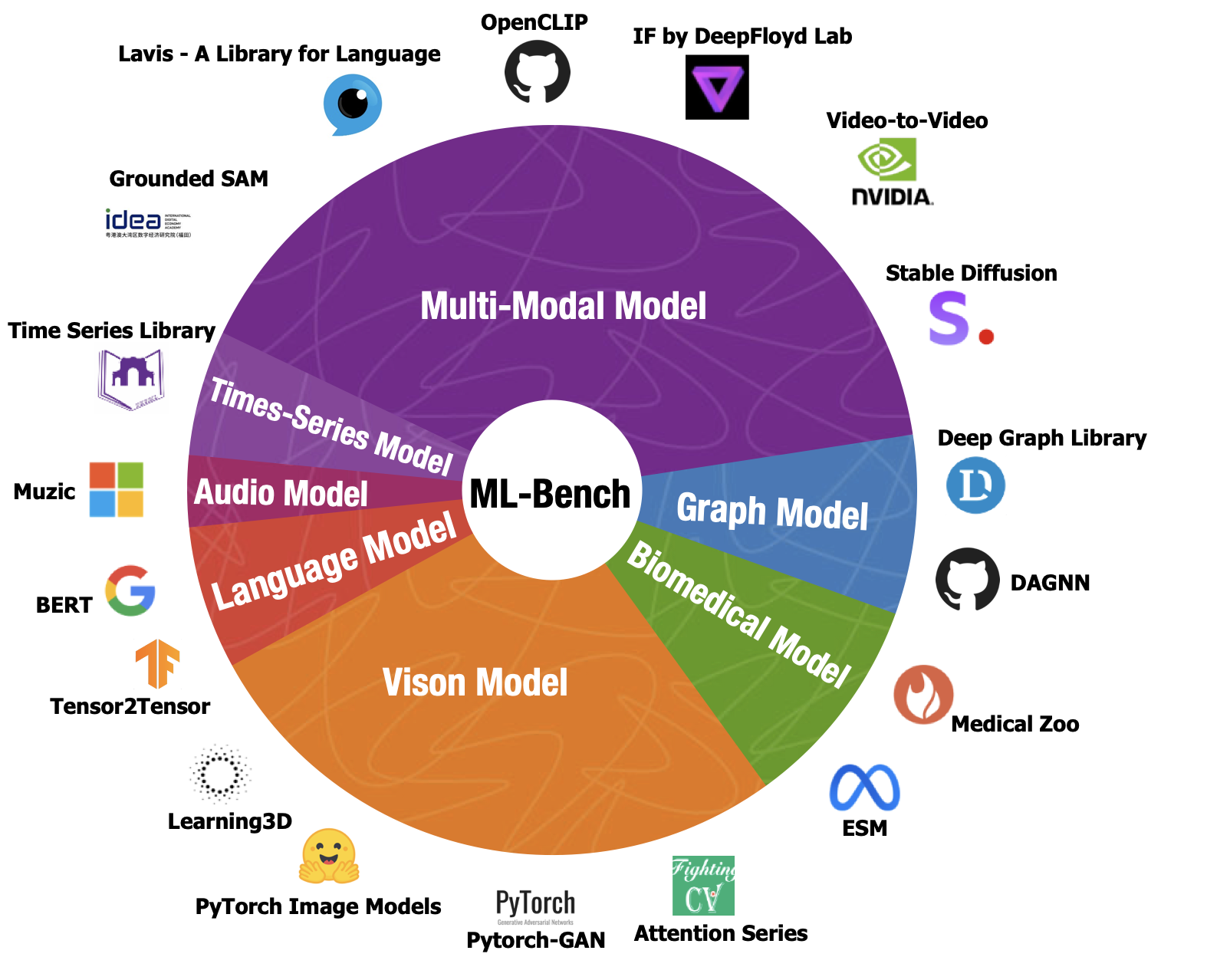

ML-Bench是一个用于评估大型语言模型和代理在仓库级代码机器学习任务中性能的基准测试套件。它提供了一个公开可复现的参考实现和基准测试集合,用于分布式机器学习算法、框架和系统。

主要特点:

- 专注于标准监督式机器学习,包括深度学习和经典线性模型

- 为每种算法提供参考实现,便于移植到新框架

- 旨在对当前主流分布式执行框架进行基准测试

- 提供精确定义的任务和数据集,实现公平精确的比较

- 提供通用评估代码,可比较不同求解器和框架的结果指标

- 可轻松在公有云上运行基准代码

相关资源

官方资源

文档

子项目

- ML-LLM-Bench: 评估大语言模型

- ML-Agent-Bench: 评估AI代理

教程

入门指南

- 克隆仓库:

git clone --recurse-submodules https://github.com/gersteinlab/ML-Bench.git

cd ML-Bench

- 安装依赖:

pip install -r requirements.txt

- 准备数据集:

from datasets import load_dataset

ml_bench = load_dataset("super-dainiu/ml-bench")

- 运行基准测试:

bash scripts/post_process/prepare.sh

bash exec.sh

- 查看结果:

结果保存在

eval_total_user.jsonl和eval_result_user.jsonl文件中。

深入学习

希望这份学习资料汇总能帮助您快速入门ML-Bench项目。如果您在学习过程中有任何问题,欢迎查阅官方文档或在GitHub上提出issue。祝您学习愉快!