onnx-tool: 为ONNX模型开发而生的瑞士军刀

在深度学习模型部署的过程中,ONNX(Open Neural Network Exchange)作为一种通用的模型交换格式扮演着越来越重要的角色。然而,在实际工作中,开发者们经常需要对ONNX模型进行各种分析和处理操作。为了简化这一过程,GitHub用户ThanatosShinji开发了onnx-tool这一强大工具,它可以被视为ONNX模型开发中的"瑞士军刀"。

🔧 onnx-tool的主要功能

onnx-tool提供了丰富的功能来帮助开发者更高效地处理ONNX模型:

-

形状推理: 通过shape_inference功能,onnx-tool可以自动推断模型中各层的输入输出形状,这对于理解模型结构和调试非常有帮助。

-

模型分析: onnx-tool可以统计模型的MACs(乘加操作数)、FLOPs(浮点运算数)、内存使用量和参数数量等关键指标,帮助开发者评估模型的复杂度和资源需求。

-

子图提取: 使用extract功能,开发者可以方便地从原始模型中提取出感兴趣的子图,便于针对性分析和优化。

-

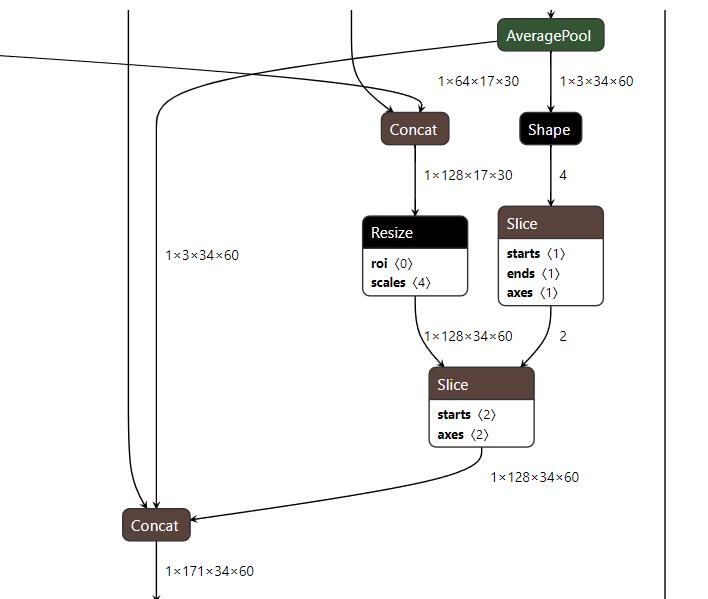

可视化: onnx-tool支持将模型结构导出为dot、svg、png等格式,方便开发者直观地查看模型拓扑结构。

-

模型编辑: 开发者可以使用onnx-tool对模型进行各种编辑操作,如修改输入输出、删除无用节点等。

-

性能分析: 通过profile功能,onnx-tool可以对模型的每一层进行详细的性能分析,帮助开发者找出模型中的性能瓶颈。

🚀 快速上手onnx-tool

安装onnx-tool非常简单,只需要一行命令:

pip install onnx-tool

安装完成后,就可以通过命令行或Python API来使用onnx-tool的各种功能了。例如,要对一个ONNX模型进行形状推理,可以使用以下命令:

onnx infershape /path/to/input/model.onnx /path/to/output/model.onnx

如果想要提取模型的子图,可以使用:

onnx extract /path/to/input/model.onnx /path/to/output/model.onnx --inputs input_1 input_2 --outputs output_1 output_2

💡 onnx-tool的应用场景

-

模型调试: 当模型出现问题时,开发者可以使用onnx-tool快速查看每一层的输入输出形状,帮助定位问题。

-

性能优化: 通过分析模型的MACs和内存使用情况,开发者可以找出性能瓶颈,有针对性地进行优化。

-

模型裁剪: 使用子图提取功能,可以方便地裁剪出模型中的特定部分,用于特定任务或轻量化部署。

-

可视化分析: onnx-tool生成的可视化图表可以帮助开发者更直观地理解复杂模型的结构。

-

模型转换: 在进行模型格式转换时,onnx-tool可以帮助验证转换前后模型的一致性。

📊 onnx-tool的性能展示

onnx-tool不仅功能强大,而且性能优异。以下是一些常见模型的分析结果:

| 模型 | 参数量(M) | MACs(M) |

|---|---|---|

| MobileNet v2-1.0 | 3.3 | 300 |

| ResNet50 | 25 | 3868 |

| BERT-Squad | 113.61 | 22767 |

| YOLOv4 | 64.33 | 33019 |

这些数据可以帮助开发者快速了解模型的复杂度,为后续的优化和部署提供参考。

🌟 onnx-tool的优势

-

全面性: onnx-tool集成了模型分析、编辑、可视化等多种功能,是一站式ONNX模型处理解决方案。

-

易用性: 无论是命令行接口还是Python API,onnx-tool都提供了简洁直观的使用方式。

-

高效性: onnx-tool经过优化,可以快速处理大型复杂模型。

-

可扩展性: 开源的特性使得社区可以不断为onnx-tool贡献新功能。

-

与生态系统集成: onnx-tool可以与其他深度学习工具链无缝集成,提升开发效率。

🔍 深入了解onnx-tool

为了更好地使用onnx-tool,开发者可以参考以下资源:

- onnx-tool GitHub仓库: 包含最新的源码和文档。

- PyPI页面: 查看发布的版本和安装指南。

- 使用示例: 提供了丰富的使用示例,帮助快速上手。

🤝 参与贡献

onnx-tool是一个开源项目,欢迎社区成员参与贡献。无论是报告问题、提出新功能建议,还是直接提交代码,都可以为onnx-tool的发展贡献力量。项目使用MIT许可证,保证了使用的自由性。

📈 未来展望

随着深度学习技术的不断发展,ONNX模型的应用场景将会越来越广泛。onnx-tool作为一个强大的辅助工具,有望在以下方面继续发力:

- 支持更多ONNX算子和模型结构。

- 提供更深入的模型分析功能,如量化分析、稀疏性分析等。

- 增强与其他深度学习框架的互操作性。

- 优化大规模模型的处理性能。

- 提供更丰富的可视化和报告功能。

总结

onnx-tool为ONNX模型开发者提供了一个强大而灵活的工具集,极大地提高了模型分析、调试和优化的效率。无论是在研究还是生产环境中,onnx-tool都是一个不可或缺的助手。随着项目的不断发展和社区的积极参与,我们有理由相信onnx-tool将在ONNX生态系统中发挥越来越重要的作用,为深度学习模型的开发和部署提供更强有力的支持。