引言

随着自动驾驶技术的快速发展,准确可靠的多目标跟踪算法对于实现安全高效的自动驾驶至关重要。近年来,基于深度学习的3D目标检测算法取得了显著进展,为多目标跟踪提供了更加精确的输入。然而,如何有效地关联不同时刻的检测结果,并处理遮挡、出现和消失等复杂场景,仍然是一个具有挑战性的问题。

本文介绍了一种基于马氏距离的概率性3D多目标跟踪算法,该算法在2019年NeurIPS大会AI驾驶奥林匹克研讨会举办的NuScenes跟踪挑战赛中获得第一名。我们将详细阐述该算法的核心思想、实现细节以及在自动驾驶场景中的应用效果,并对相关工作进行全面的回顾与展望。

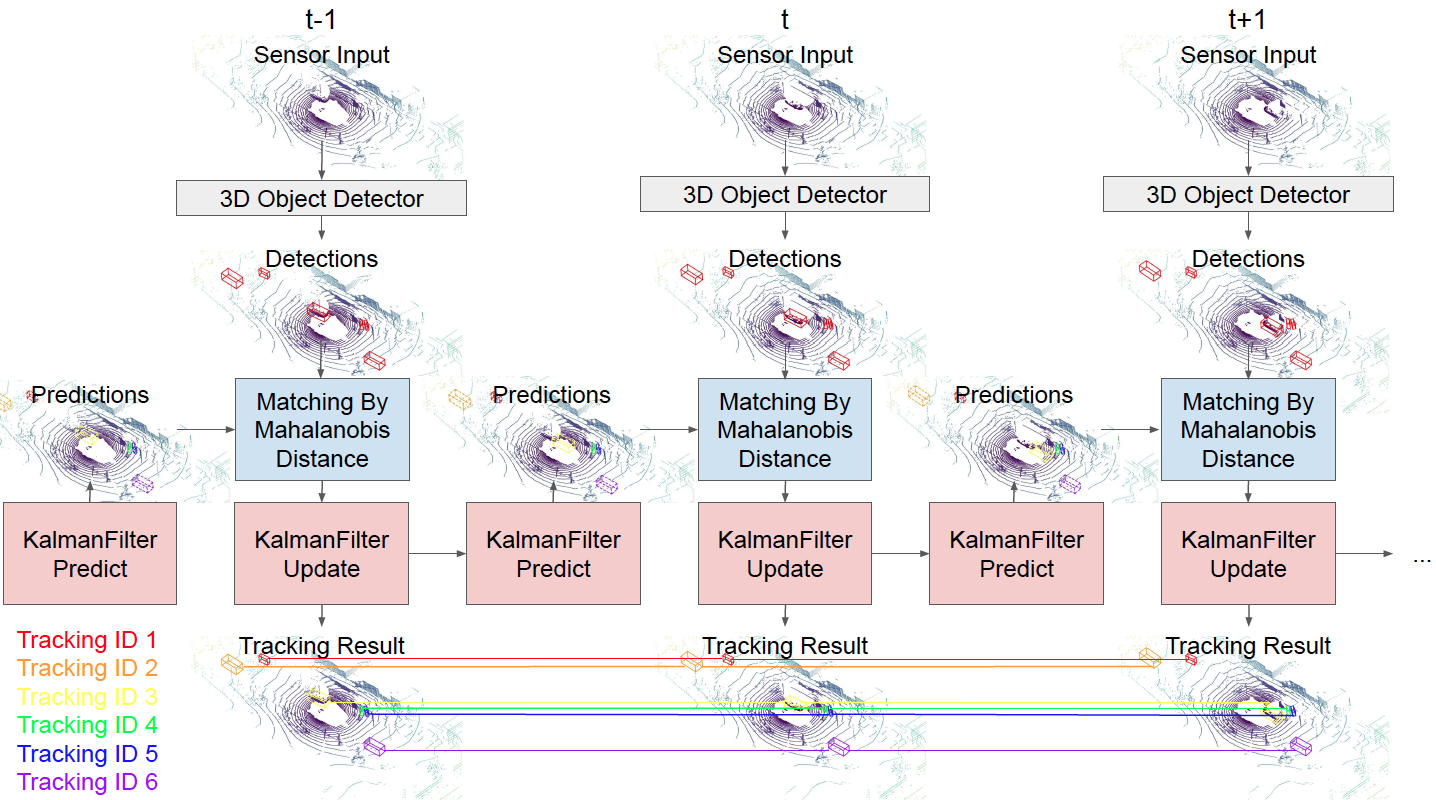

算法概述

我们提出的算法主要包括以下几个关键步骤:

- 使用卡尔曼滤波器对目标状态进行预测

- 基于马氏距离计算检测结果与预测轨迹之间的相似度

- 采用贪婪策略进行数据关联

- 根据关联结果更新现有轨迹或初始化新轨迹

与传统的基于IoU (Intersection over Union)的方法相比,马氏距离考虑了目标状态的不确定性,能够更好地处理遮挡和噪声等复杂情况。此外,我们还引入了一些创新点,如自适应门限、多步预测等,进一步提高了算法的鲁棒性和准确性。

实验结果

我们在NuScenes数据集上进行了大量实验,验证了所提出算法的有效性。下表展示了我们的方法与基线方法AB3DMOT在NuScenes验证集上的性能对比:

| 方法 | 总体AMOTA | 自行车 | 公交车 | 汽车 | 摩托车 | 行人 | 拖车 | 卡车 |

|---|---|---|---|---|---|---|---|---|

| AB3DMOT | 17.9 | 0.9 | 48.9 | 36.0 | 5.1 | 9.1 | 11.1 | 14.2 |

| 我们的方法 | 56.1 | 27.2 | 74.1 | 73.5 | 50.6 | 75.5 | 33.7 | 58.0 |

可以看出,我们的方法在各个类别上都显著优于基线方法,尤其是在行人等小目标的跟踪上取得了巨大提升。这充分说明了基于马氏距离的概率性跟踪方法在处理复杂场景时的优势。

在NuScenes测试集上,我们的方法也取得了最佳成绩,总体AMOTA达到55.0,远超其他参赛队伍。下面是测试集上前三名的成绩对比:

| 排名 | 队伍名称 | 总体AMOTA |

|---|---|---|

| 1 | StanfordIPRL-TRI (我们的方法) | 55.0 |

| 2 | VV_team | 37.1 |

| 3 | CenterTrack | 10.8 |

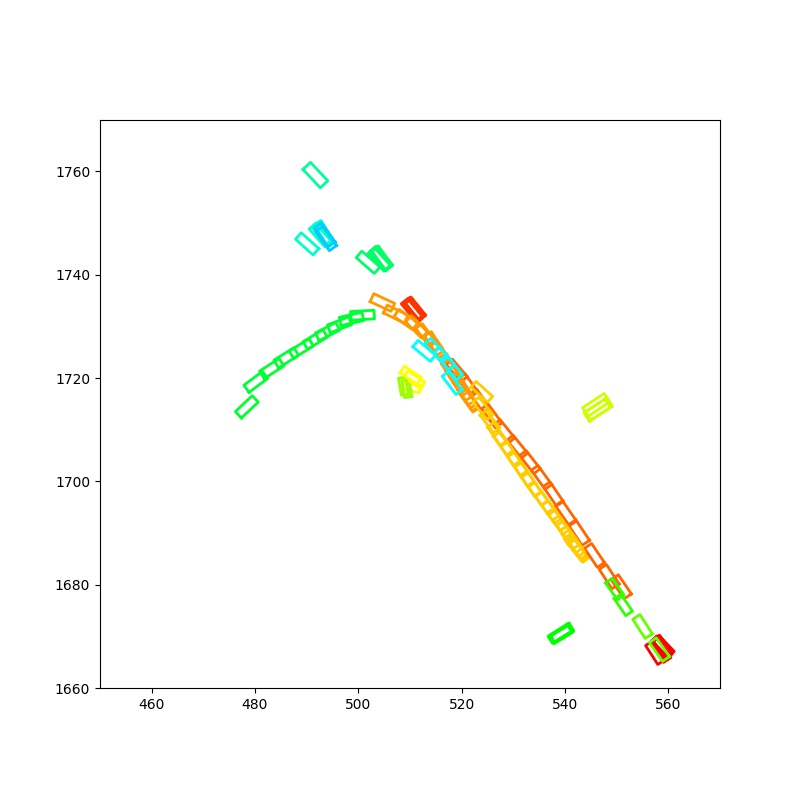

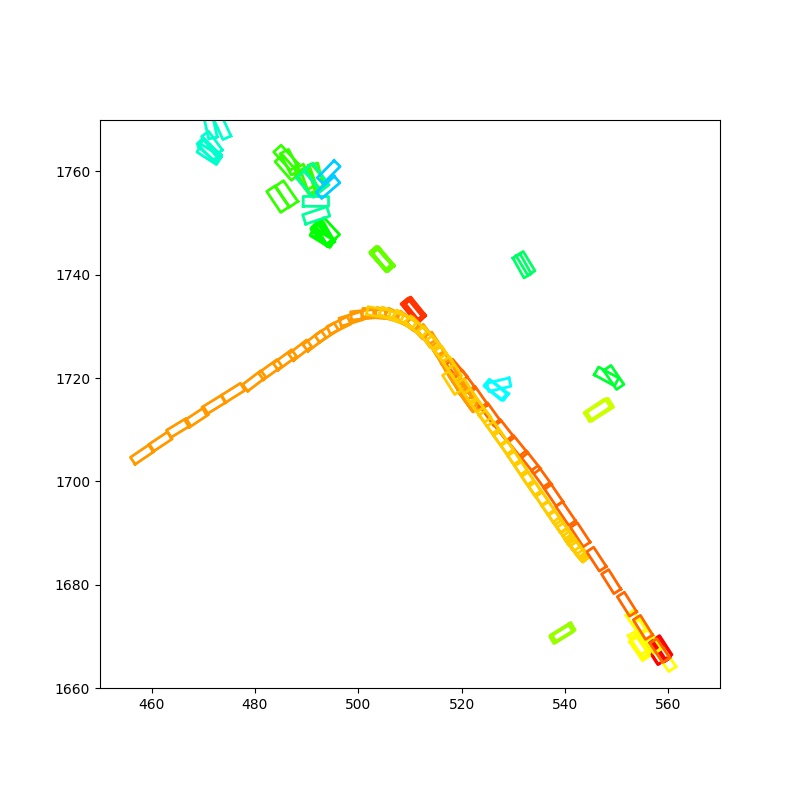

定性分析

为了更直观地展示算法效果,我们对比了基线方法AB3DMOT与我们的方法在典型场景下的跟踪结果。下图展示了一个包含急转弯的复杂场景,不同颜色代表不同的跟踪ID:

| AB3DMOT | 我们的方法 |

|---|---|

|  |

可以看出,我们的方法能够更好地处理目标急转弯的情况,保持了连贯的跟踪ID。这得益于马氏距离考虑了目标状态的不确定性,以及我们引入的多步预测策略。

算法实现与复现

为了方便研究人员复现我们的结果,我们开源了完整的代码实现。以下是运行代码的主要步骤:

- 克隆代码仓库并安装依赖:

git clone https://github.com/eddyhkchiu/mahalanobis_3d_multi_object_tracking

cd mahalanobis_3d_multi_object_tracking

pip install -r requirements.txt

-

下载并设置NuScenes数据集

-

运行跟踪算法:

python main.py val 2 m 11 greedy true nuscenes results/000008

- 评估跟踪结果:

python evaluate_nuscenes.py --output_dir results/000008 results/000008/val/results_val_probabilistic_tracking.json > results/000008/output.txt

我们还提供了复现基线方法AB3DMOT结果的脚本,方便进行对比实验。

相关工作

传统多目标跟踪方法

早期的多目标跟踪方法主要基于卡尔曼滤波和匈牙利算法。这类方法计算简单,实时性好,但难以处理复杂的遮挡和交互情况。典型的工作包括:

- SORT (Simple Online and Realtime Tracking): 结合卡尔曼滤波和匈牙利算法的简单在线跟踪方法

- Deep SORT: 在SORT的基础上引入深度学习特征,提高了跟踪的鲁棒性

基于深度学习的端到端方法

近年来,随着深度学习的发展,一些研究者尝试设计端到端的跟踪网络,同时完成检测和跟踪任务。代表性工作包括:

- JDE (Joint Detection and Embedding): 设计多任务网络,同时输出检测框、ReID特征和目标中心点

- CenterTrack: 基于CenterNet检测器,利用点跟踪的思想实现目标跟踪

这类方法能够充分利用图像特征,但计算开销较大,难以满足自动驾驶的实时性要求。

基于图模型的方法

一些研究者尝试将多目标跟踪问题建模为图优化问题,通过求解图的最小费用流等方式得到全局最优的跟踪结果。代表性工作包括:

- MHT (Multiple Hypothesis Tracking): 维护多个假设,通过剪枝策略保持计算效率

- JPDAF (Joint Probabilistic Data Association Filter): 考虑多个检测结果与轨迹的关联概率

这类方法能够得到全局最优解,但通常需要离线处理,难以应用于在线场景。

概率性跟踪方法

我们提出的基于马氏距离的概率性跟踪方法,可以看作是对传统卡尔曼滤波方法的扩展和改进。类似的工作还包括:

- UKF (Unscented Kalman Filter): 使用无迹变换来处理非线性系统

- PHD (Probability Hypothesis Density) Filter: 基于随机有限集理论的多目标跟踪方法

这类方法能够有效地建模目标状态的不确定性,在保持计算效率的同时提高了跟踪的鲁棒性。

未来工作

尽管我们的方法在NuScenes数据集上取得了优秀的性能,但仍有一些值得进一步研究的方向:

-

融合多模态信息: 目前的算法主要基于3D点云数据,如何有效地结合图像、雷达等多模态信息是一个重要的研究方向。

-

处理长时间遮挡: 在城市环境中,目标可能被遮挡较长时间。如何在保持高召回率的同时避免ID切换是一个挑战。

-

考虑目标间交互: 目前的方法独立地跟踪每个目标,没有考虑目标间的交互关系。引入社会力模型等方法可能有助于提高跟踪精度。

-

提高实时性: 虽然我们的方法已经能够满足自动驾驶的基本需求,但进一步提高算法效率,使其能够在嵌入式设备上运行仍有重要意义。

-

迁移到其他场景: 验证算法在其他数据集(如KITTI, Waymo Open Dataset等)上的性能,并探索跨数据集的迁移学习方法。

总结

本文介绍了一种基于马氏距离的概率性3D多目标跟踪算法,该算法在NuScenes跟踪挑战赛中取得了第一名的成绩。我们详细阐述了算法的核心思想、实现细节以及在自动驾驶场景中的应用效果。实验结果表明,我们的方法在各种复杂场景下都能取得优秀的跟踪性能,特别是在处理小目标和急转弯等困难情况时表现出色。

我们开源的代码实现为研究人员提供了一个可靠的基线方法,便于进行进一步的改进和扩展。未来,我们将继续探索多模态融合、长时间遮挡处理等方向,进一步提升算法的性能和鲁棒性,为实现安全可靠的自动驾驶系统做出贡献。

参考文献

-

Caesar, H., et al. (2019). nuScenes: A multimodal dataset for autonomous driving. arXiv preprint arXiv:1903.11027.

-

Weng, X., & Kitani, K. (2019). A Baseline for 3D Multi-Object Tracking. arXiv preprint arXiv:1907.03961.

-

Zhu, B., et al. (2019). Class-balanced Grouping and Sampling for Point Cloud 3D Object Detection. arXiv preprint arXiv:1908.09492.

-

Chiu, H. K., et al. (2020). Probabilistic 3D Multi-Object Tracking for Autonomous Driving. arXiv preprint arXiv:2001.05673.

-

Chiu, H. K., et al. (2021). Probabilistic 3D Multi-Modal, Multi-Object Tracking for Autonomous Driving. IEEE International Conference on Robotics and Automation (ICRA).

-

Chiu, H. K., et al. (2024). Probabilistic 3D Multi-Object Cooperative Tracking for Autonomous Driving via Differentiable Multi-Sensor Kalman Filter. IEEE International Conference on Robotics and Automation (ICRA).