Riffusion简介

Riffusion是一款创新的音乐生成应用,它利用稳定扩散(Stable Diffusion)技术将文本提示转化为实时音乐。这个项目由Seth Forsgren和Hayk Martiros开发,旨在探索人工智能在音乐创作领域的潜力。Riffusion的核心理念是通过简单的文字描述,让用户能够快速生成符合预期的音乐片段。

技术原理

Riffusion的技术基础是稳定扩散模型,这是一种强大的生成式AI技术。该模型经过大量音乐数据的训练,学会了将文本描述与音乐特征之间建立联系。当用户输入一段文本提示时,Riffusion会将其转化为频谱图,然后通过稳定扩散模型生成对应的音频。

主要技术特点包括:

- 实时生成:Riffusion能够在几秒钟内生成音乐片段,支持实时交互。

- 文本到音频的转换:将自然语言描述直接转化为音乐,无需专业音乐知识。

- 频谱图处理:利用频谱图作为中间表示,实现文本、图像和音频之间的转换。

- 模型优化:针对音乐生成任务对稳定扩散模型进行了特殊优化。

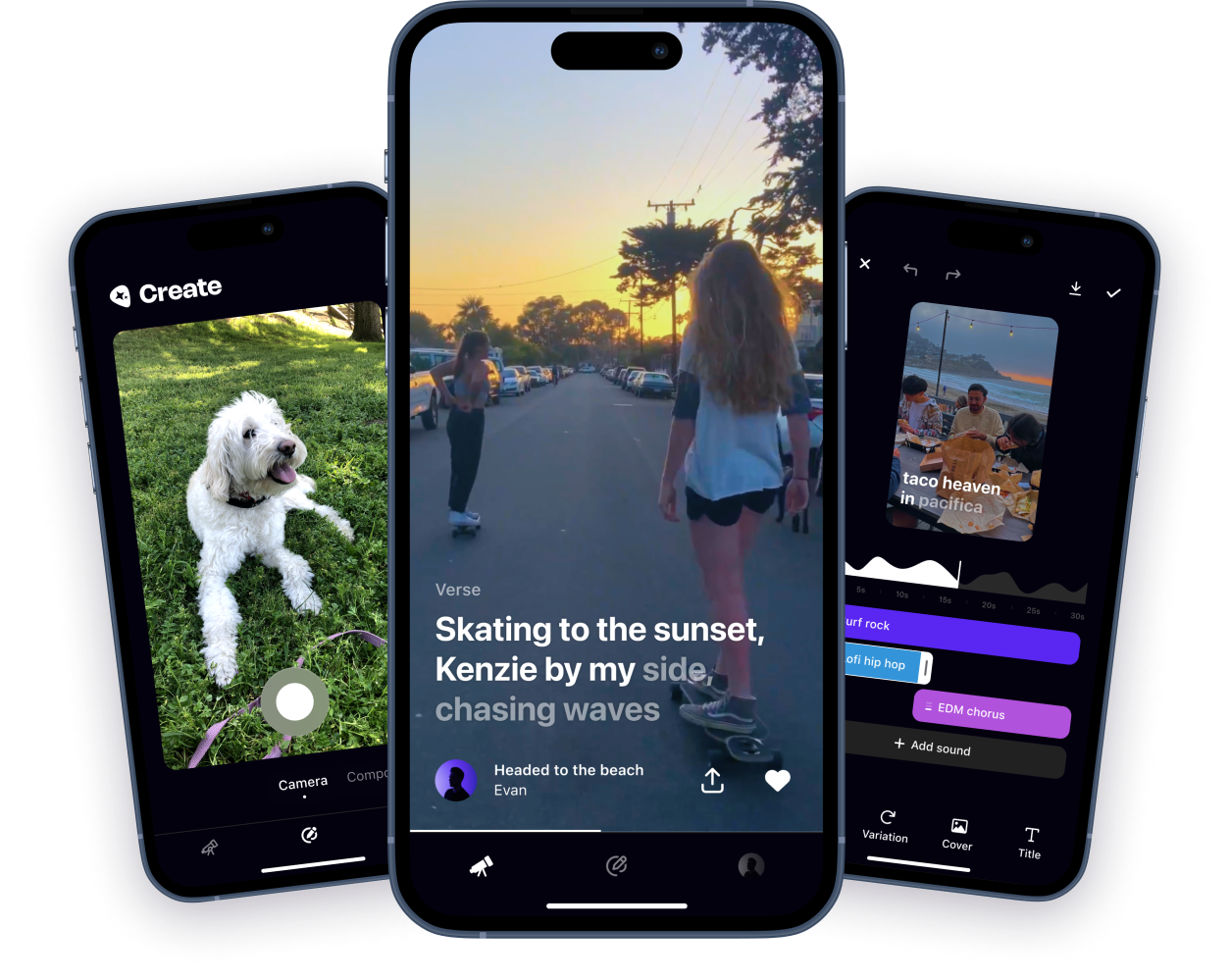

功能特点

Riffusion提供了多种有趣的功能,让用户能够轻松创作音乐:

-

文本提示生成:用户可以输入简单的文字描述,如"欢快的爵士乐"或"忧郁的钢琴曲",Riffusion就会生成相应风格的音乐片段。

-

实时调整:用户可以在生成过程中实时调整参数,如音乐风格、情绪、乐器等,立即听到效果变化。

-

音乐过渡:支持在不同音乐风格之间平滑过渡,创造出独特的混合效果。

-

可视化界面:提供直观的频谱图可视化,帮助用户理解音乐生成过程。

-

导出分享:生成的音乐片段可以轻松导出和分享,方便用户进一步创作或分享成果。

应用场景

Riffusion的应用前景广阔,可以在多个领域发挥作用:

- 音乐创作:为音乐人提供灵感和素材,加速创作过程。

- 游戏开发:快速生成游戏背景音乐和音效。

- 视频制作:为视频内容创作者提供定制化的配乐解决方案。

- 教育:作为音乐教育的辅助工具,帮助学生理解不同音乐风格的特征。

- 娱乐:为普通用户提供有趣的音乐创作体验。

开发者社区

Riffusion项目在GitHub上开源,吸引了众多开发者的关注。项目仓库(https://github.com/riffusion/riffusion-app-hobby)已获得2.6k星标,185次分叉,显示出社区对这一创新技术的浓厚兴趣。

开发者可以通过以下方式参与项目:

- 贡献代码:修复bug,添加新功能,优化性能等。

- 提出建议:在Issues中提出改进意见或功能请求。

- 分享经验:在Discussions中与其他开发者交流使用心得。

安装与使用

要在本地运行Riffusion,需要按照以下步骤操作:

- 确保安装了Node.js v18或更高版本。

- 克隆项目仓库:

git clone https://github.com/riffusion/riffusion-app-hobby.git - 安装依赖:

npm install - 运行开发服务器:

npm run dev - 在浏览器中访问 http://localhost:3000 即可使用Riffusion应用。

注意:要生成实际的音乐输出,还需要配置推理服务器。详细说明可以在项目README中找到。

未来展望

虽然Riffusion项目目前已停止积极维护,但它为AI音乐生成领域开辟了新的方向。未来,我们可以期待看到:

- 模型性能的进一步提升,生成更高质量、更长时间的音乐片段。

- 与其他AI技术的结合,如自然语言处理,实现更智能的音乐生成。

- 在专业音乐制作工具中的集成,为音乐人提供更强大的创作辅助。

- 针对特定音乐风格或乐器的专门化模型。

结语

Riffusion代表了AI音乐生成技术的一个重要里程碑。它不仅展示了稳定扩散技术在音频领域的潜力,也为音乐创作提供了全新的可能性。虽然目前还存在一些限制,但Riffusion无疑为未来的AI音乐技术发展指明了方向。无论你是音乐爱好者、开发者还是研究人员,都值得关注这个有趣的项目,探索AI与音乐创作的无限可能。