Riffusion: 开启AI音乐创作新纪元

在人工智能快速发展的今天,AI正在各个领域展现出惊人的创造力。音乐创作作为人类最具艺术性的活动之一,也正在被AI的浪潮所改变。今天要为大家介绍的Riffusion项目,就是一个非常有趣的AI音乐生成工具,它利用稳定扩散(Stable Diffusion)模型来实现实时音乐创作。

Riffusion项目简介

Riffusion是由Seth Forsgren和Hayk Martiros开发的一个开源项目,旨在利用稳定扩散模型进行实时音乐生成。该项目的核心思想是将音频信号转换为频谱图图像,然后使用经过微调的稳定扩散模型来生成新的频谱图,最后再将频谱图转换回音频信号。这种创新的方法使得AI能够以一种全新的方式来创作音乐。

核心技术与工作原理

Riffusion的核心是一个经过微调的稳定扩散模型。这个模型是在Stable Diffusion v1.5的基础上,使用大量音乐频谱图数据进行了进一步训练。其工作流程如下:

- 将输入的音频转换为频谱图图像

- 使用稳定扩散模型对频谱图进行处理和生成

- 将生成的频谱图转换回音频信号

这个过程允许模型学习音乐的结构和模式,从而能够生成连贯和有意义的音乐片段。

Riffusion的主要特性

-

实时音乐生成: Riffusion能够在几秒钟内生成音乐片段,支持实时交互和创作。

-

文本引导生成: 用户可以通过文本提示词来引导音乐的风格和内容。

-

音乐风格插值: 可以在不同音乐风格之间平滑过渡,创造出独特的混合效果。

-

开源与可扩展: 项目完全开源,鼓励社区贡献和二次开发。

-

多平台支持: 提供了Web应用、Python库以及API接口,方便不同场景的使用。

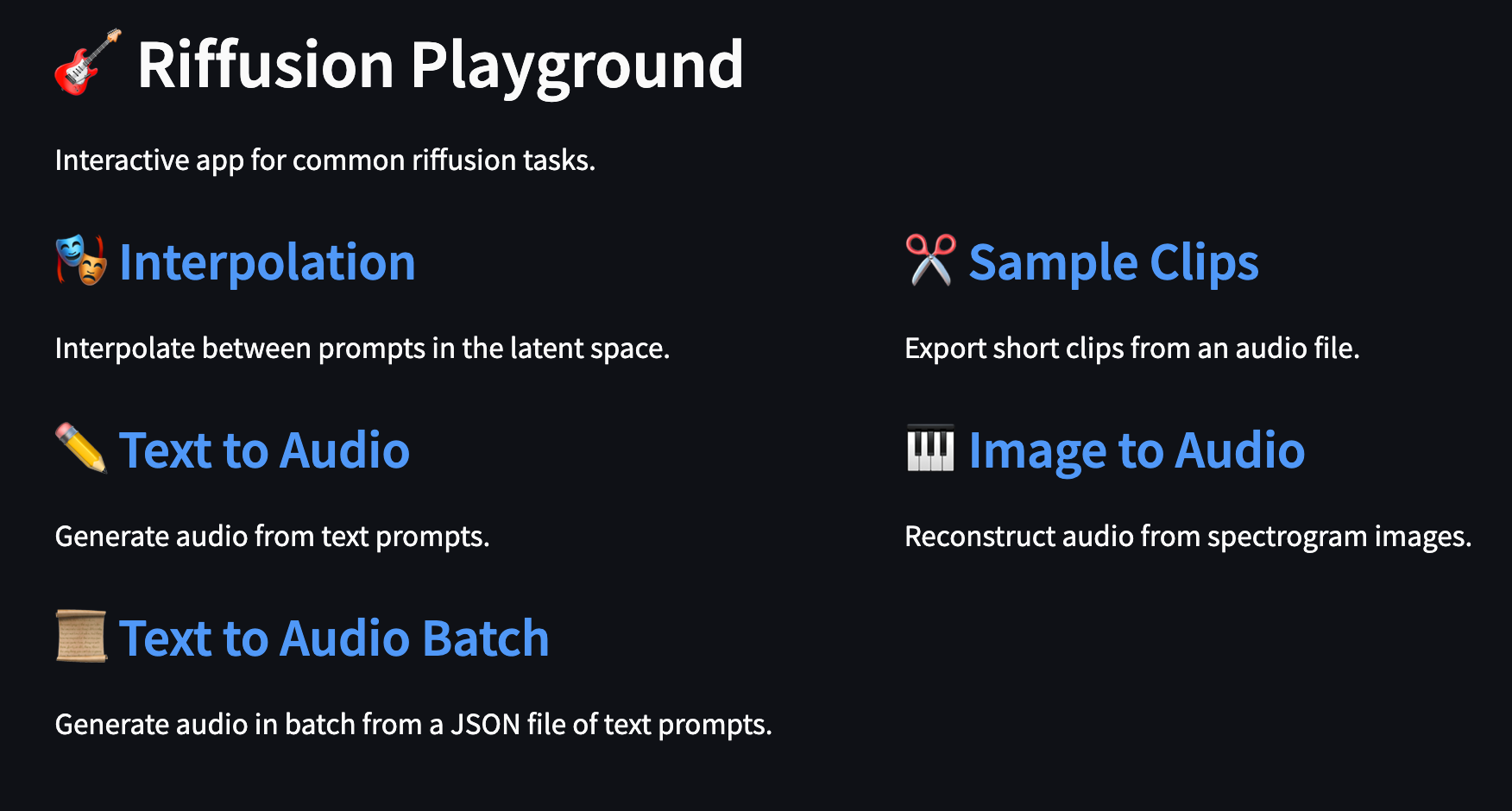

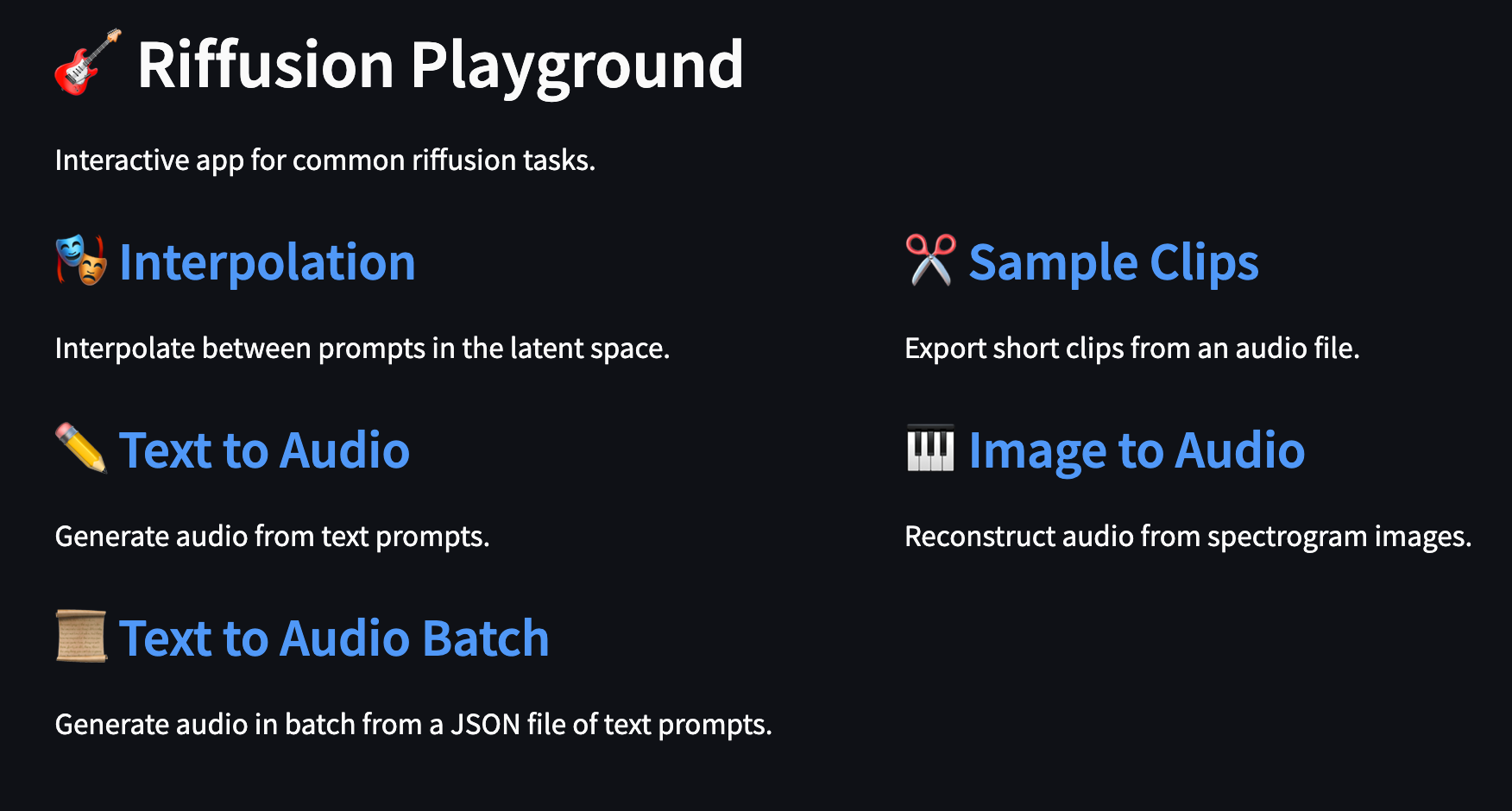

如何使用Riffusion

要开始使用Riffusion,你有几种选择:

-

在线体验: 访问Riffusion官网即可在线试用。

-

本地部署:

- 克隆GitHub仓库:

git clone https://github.com/riffusion/riffusion-hobby.git - 安装依赖:

pip install -r requirements.txt - 运行Web应用:

python -m riffusion.streamlit.playground

- 克隆GitHub仓库:

-

API调用: Riffusion提供了Flask服务器,可以通过API进行音乐生成。

import requests

url = "http://localhost:3013/run_inference"

data = {

"prompt": "jazz piano solo",

"seed": 42,

"denoising": 0.75,

"guidance": 7.0

}

response = requests.post(url, json=data)

audio = response.json()["audio"]

Riffusion的应用前景

Riffusion为音乐创作开辟了新的可能性。它可以应用于:

- 音乐制作辅助工具

- 游戏和影视配乐生成

- 个性化音乐推荐系统

- 音乐教育和创作培训

项目的局限性与未来发展

尽管Riffusion展现出了巨大的潜力,但它仍然存在一些局限性:

- 生成的音乐片段较短,难以创作完整曲目

- 音乐结构的控制还不够精细

- 对特定乐器和音色的模拟还有提升空间

未来,开发团队计划从以下几个方面改进项目:

- 提高模型的音乐理解能力,生成更长、更结构化的音乐

- 增加对乐器和音色的精确控制

- 引入更多音乐理论知识,提升生成音乐的质量

- 优化模型性能,实现更快速的音乐生成

结语

Riffusion作为一个创新的AI音乐生成项目,展示了人工智能在音乐创作领域的巨大潜力。它不仅为音乐爱好者和专业音乐人提供了一个有趣的创作工具,也为AI音乐生成技术的发展指明了新的方向。随着技术的不断进步,我们可以期待在不久的将来,AI与人类创作者能够更好地协作,共同创造出更加丰富多彩的音乐世界。

如果你对AI音乐生成感兴趣,不妨亲自尝试一下Riffusion,探索AI音乐创作的无限可能!