什么是selfhostedAI?

selfhostedAI是一个开源项目,旨在为用户提供简单易用的自托管AI解决方案。该项目集成了多种流行的开源AI模型和工具,让用户可以在自己的硬件上一键部署和运行AI助手,而无需依赖云服务。

selfhostedAI的主要特点包括:

- 提供多种AI模型选择,包括聊天、绘画等功能

- 一键安装部署,操作简单

- 完全离线运行,保护用户隐私

- 兼容OpenAI API,可与众多开源项目集成

- 持续更新维护,跟进最新AI技术

主要功能

selfhostedAI目前支持以下几类主要功能:

1. 聊天对话

selfhostedAI集成了多个开源聊天模型,包括:

- RWKV:轻量级模型,仅需8MB即可在线安装使用

- ChatGLM-6B:清华大学开源的中文对话模型

- LLaMA:Meta开源的大语言模型

用户可以根据自己的硬件条件和需求选择合适的模型。这些模型都可以在本地运行,无需联网,保护用户隐私。

2. AI绘画

selfhostedAI集成了流行的Stable Diffusion Web UI,可以在本地运行AI绘画功能。用户只需下载安装包并运行,即可在浏览器中使用强大的AI绘画工具。

支持的主要功能包括:

- 文本生成图像

- 图像编辑和修复

- 风格迁移

- 多种模型和VAE选择

3. 文本生成

除了对话和绘画外,selfhostedAI还集成了text-generation-webui项目,可用于各种文本生成任务,如:

- 故事创作

- 代码生成

- 文案写作

- 问答系统

如何使用

使用selfhostedAI非常简单,主要步骤如下:

-

前往项目的Release页面下载打包好的安装文件

-

解压后双击相应的启动脚本,如

llama.bat或chatglm.bat -

等待模型加载完成后,即可在浏览器中使用AI助手

-

如需更新,运行

update.bat即可 -

高级用户可以通过设置

ngrok_token环境变量来将API暴露到公网

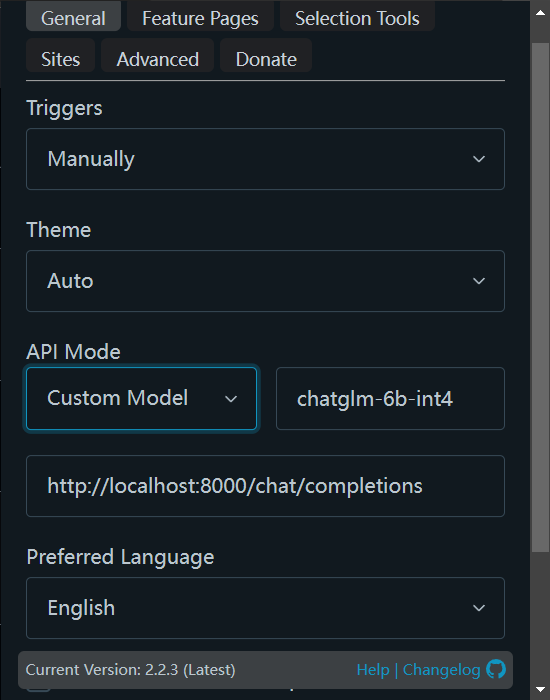

selfhostedAI的API接口兼容OpenAI,因此可以方便地与其他开源项目集成使用。例如,可以配合chatGPTBox浏览器插件使用。

系统要求

selfhostedAI的硬件要求因选用的模型而异。一般来说:

- 最小配置:8GB内存,支持AVX2指令集的CPU

- 推荐配置:16GB以上内存,NVIDIA GPU(用于加速)

软件方面,Windows/Linux/MacOS均可运行。Windows用户可以直接使用打包好的程序,其他系统可参考项目文档进行安装。

结语

selfhostedAI为用户提供了一种简单可靠的方式来在本地部署和使用AI助手。通过开源社区的努力,越来越多强大的AI能力正变得唾手可得。selfhostedAI将继续跟进最新的AI技术进展,为用户带来更多实用的自托管AI工具。无论是个人用户还是企业,都可以借助selfhostedAI来探索AI的无限可能。

如果您对selfhostedAI感兴趣,欢迎访问项目主页了解更多信息,也可以通过Star来支持这个项目。让我们一起推动AI技术的民主化,让每个人都能便捷地使用和掌控AI!