SenseVoice:开启多语言语音理解新纪元

在人工智能和语音技术飞速发展的今天,一个革命性的多语言语音理解模型——SenseVoice应运而生,为人机交互带来前所未有的体验。这款由FunAudioLLM团队开发的开源模型,不仅在语音识别方面表现卓越,还集成了语种识别、情感识别和音频事件检测等多项功能,堪称语音理解领域的瑞士军刀。

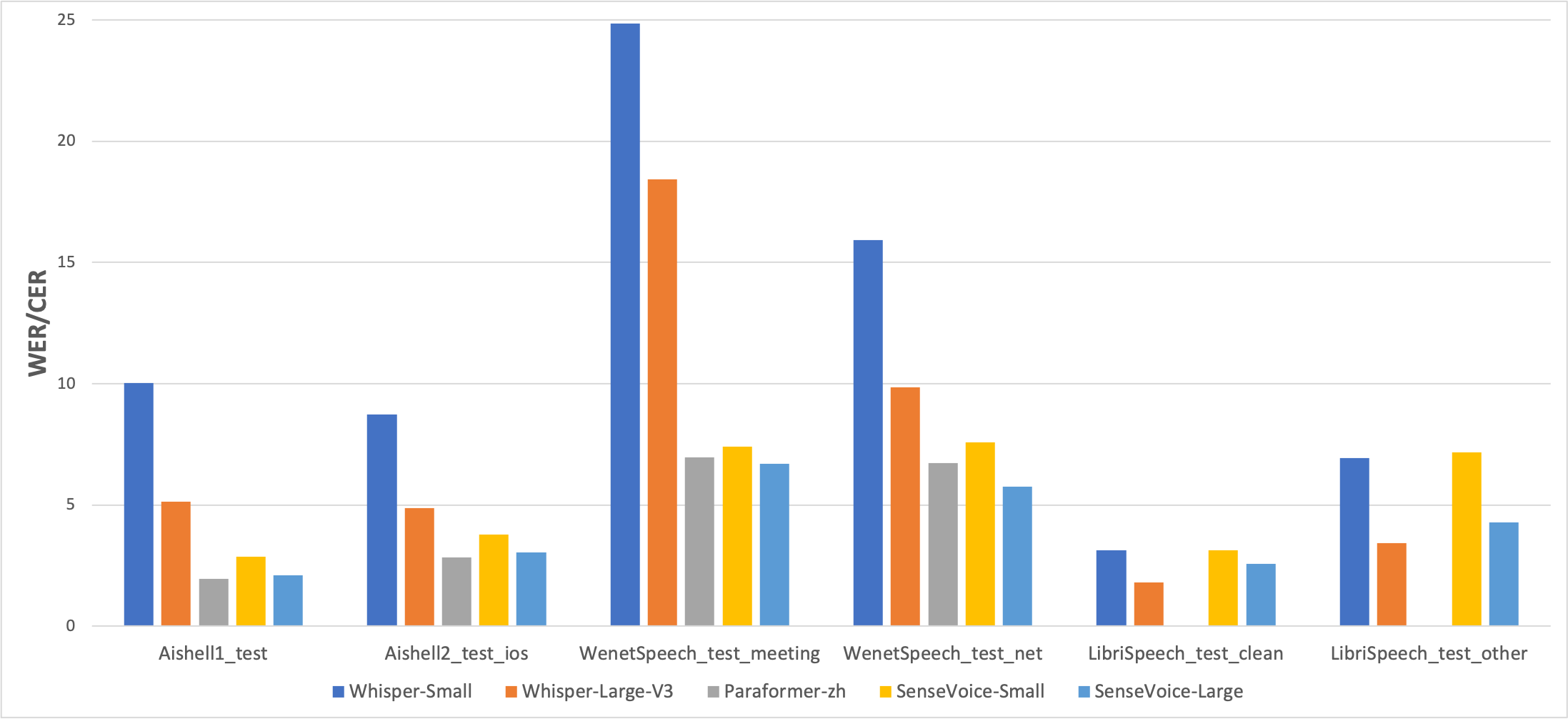

多语言识别:超越Whisper的卓越表现

SenseVoice的核心优势之一就是其强大的多语言识别能力。通过对超过40万小时的数据进行训练,SenseVoice支持50多种语言的识别,其性能甚至超越了著名的Whisper模型。这一突破性成就使得SenseVoice成为跨语言交流和全球化应用的理想选择。

在中文和粤语识别方面,SenseVoice-Small模型展现出明显的优势。通过在AISHELL-1、AISHELL-2、Wenetspeech等多个开源基准数据集上的测试,SenseVoice consistently outperforms Whisper,尤其是在处理这些语言时。这一卓越表现不仅证明了SenseVoice在语音识别领域的实力,也为其在中文语音市场的应用奠定了坚实基础。

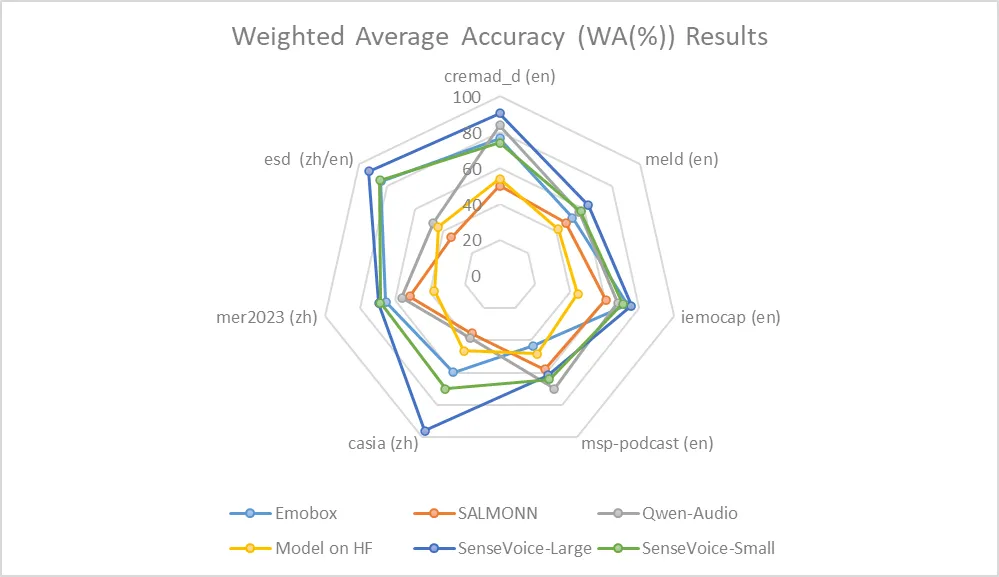

情感识别:洞悉语音中的情感世界

除了准确的语音转文字能力,SenseVoice还具备出色的情感识别功能。在缺乏广泛使用的情感识别测试基准的情况下,研发团队在多个测试集上进行了全面评估,结果表明SenseVoice能够达到甚至超越当前最佳情感识别模型的效果。

值得注意的是,SenseVoice在不进行目标数据微调的前提下,就能在包含中文、英文以及表演、影视剧、自然对话等多种风格的数据上取得优异成绩。这种"零样本"学习能力充分展示了SenseVoice模型的强大泛化性和适应性。

音频事件检测:超越语音的听觉感知

尽管SenseVoice主要针对语音数据进行训练,但其在音频事件检测方面同样表现不俗。在环境音分类ESC-50数据集上,SenseVoice与业内广泛使用的BEATS和PANN模型进行了对比,取得了令人瞩目的成绩。

虽然受限于训练数据和方法,SenseVoice在事件分类方面与专业的事件检测模型相比仍有一定差距,但其多功能性和潜力是毋庸置疑的。这种全面的音频理解能力为SenseVoice在更广泛的应用场景中发挥作用提供了可能。

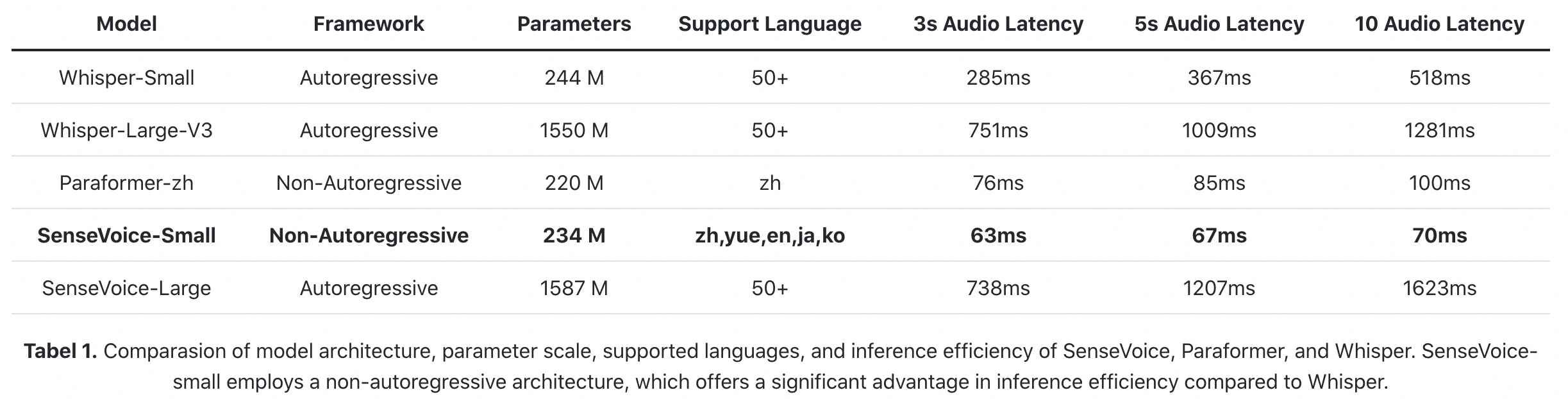

高效推理:速度与精度的完美平衡

SenseVoice-Small模型采用非自回归端到端架构,实现了极低的推理延迟。在参数量与Whisper-Small模型相当的情况下,SenseVoice-Small的推理速度比Whisper-Small快5倍,比Whisper-Large快15倍。这种高效性使得SenseVoice特别适合需要实时处理的应用场景。

更令人印象深刻的是,SenseVoice-Small模型在处理长音频时,推理耗时并无明显增加。这一特性为处理长时间音频或流式音频提供了极大便利,使得SenseVoice在诸如实时翻译、长时间会议记录等应用中具有显著优势。

便捷使用:从安装到部署的全流程支持

SenseVoice不仅性能卓越,其使用也十分便捷。通过简单的pip安装命令,用户就能轻松搭建SenseVoice的运行环境:

pip install -r requirements.txt

SenseVoice支持多种推理方式,包括使用funasr进行推理和直接推理。以下是使用funasr进行推理的示例代码:

from funasr import AutoModel

from funasr.utils.postprocess_utils import rich_transcription_postprocess

model_dir = "iic/SenseVoiceSmall"

model = AutoModel(

model=model_dir,

trust_remote_code=True,

remote_code="./model.py",

vad_model="fsmn-vad",

vad_kwargs={"max_single_segment_time": 30000},

device="cuda:0",

)

# en

res = model.generate(

input=f"{model.model_path}/example/en.mp3",

cache={},

language="auto", # "zh", "en", "yue", "ja", "ko", "nospeech"

use_itn=True,

batch_size_s=60,

merge_vad=True,

merge_length_s=15,

)

text = rich_transcription_postprocess(res[0]["text"])

print(text)

此外,SenseVoice还提供了便捷的微调脚本和策略,允许用户根据特定业务场景轻松调整模型。这种灵活性使得SenseVoice能够适应各种不同的应用需求,从而在实际使用中发挥最大效用。

开源共享:推动语音技术的共同进步

作为一个开源项目,SenseVoice不仅为用户提供了强大的语音理解工具,还为整个语音技术社区贡献了宝贵的资源。通过GitHub平台,开发者可以自由访问SenseVoice的源代码、文档和示例,这极大地促进了技术交流和创新。

SenseVoice项目的开放性还体现在其对第三方工作的支持上。例如,已有开发者基于Triton和TensorRT实现了SenseVoice的GPU加速部署,在V100 GPU上实现了526倍的加速比。另外,sherpa-onnx项目则支持在10种编程语言中使用SenseVoice,并能在iOS、Android和树莓派等平台上部署。这些第三方工作大大拓展了SenseVoice的应用范围和可能性。

未来展望:语音交互的无限可能

随着SenseVoice的不断发展和完善,我们可以期待它在更多领域发挥重要作用。从智能家居到自动驾驶,从教育辅助到医疗诊断,SenseVoice的多语言、多功能特性将为各行各业带来革命性的变革。

特别值得一提的是,SenseVoice作为FunAudioLLM项目的一部分,与CosyVoice等其他语音模型共同构建了一个完整的语音交互生态系统。这种协同效应将进一步推动人机交互向更自然、更智能的方向发展。

总的来说,SenseVoice的出现标志着多语言语音理解技术迈入了一个新的阶段。它不仅提高了语音识别的准确度和效率,还通过情感识别和事件检测等功能,为机器赋予了"理解"人类语音的能力。随着技术的不断进步和应用场景的不断拓展,SenseVoice必将在人工智能和语音交互领域发挥越来越重要的作用,为人类社会带来更多便利和可能性。