sk2torch:机器学习模型转换的桥梁

在机器学习和深度学习的世界里,不同的框架和库各有特色,为数据科学家和研究人员提供了丰富的工具选择。然而,这种多样性有时也会带来一些挑战,尤其是在不同框架之间转换模型时。为了解决这个问题,一个名为sk2torch的创新项目应运而生,它巧妙地搭建了scikit-learn和PyTorch之间的桥梁。

sk2torch的核心功能

sk2torch是一个开源项目,其主要功能是将scikit-learn训练的模型转换为PyTorch模块。这个看似简单的转换过程,实际上为机器学习工作流程带来了诸多优势:

-

GPU加速: scikit-learn模型通常在CPU上运行,而通过转换为PyTorch模块,模型可以轻松地在GPU上进行推理,大大提高了处理速度。这对于支持向量机(SVM)等计算密集型模型尤其有利。

-

模型序列化: 虽然scikit-learn支持通过pickle进行模型序列化,但这种方法在不同版本的库之间可能存在兼容性问题。相比之下,sk2torch转换后的模型可以使用TorchScript保存,确保了更好的可移植性和可重现性。

-

梯度计算: 对于某些理论上可微分的模型(如SVM和线性分类器),scikit-learn并不提供计算梯度的机制。而PyTorch天生支持自动微分,使得这些模型可以进行端到端的梯度计算和反向传播。

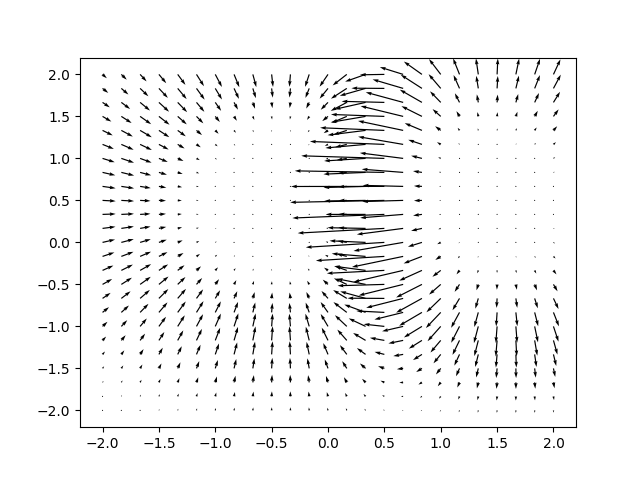

图1: 使用sk2torch转换的SVM模型生成的概率预测向量场

使用sk2torch的简单步骤

使用sk2torch转换模型非常简单,只需几个步骤即可完成:

- 首先,按照常规方式使用scikit-learn训练模型:

from sklearn.linear_model import SGDClassifier

from sklearn.pipeline import Pipeline

from sklearn.preprocessing import StandardScaler

x, y = create_some_dataset()

model = Pipeline([

("center", StandardScaler(with_std=False)),

("classify", SGDClassifier()),

])

model.fit(x, y)

- 然后,使用sk2torch.wrap函数将模型转换为PyTorch等效模型:

import sk2torch

import torch

torch_model = sk2torch.wrap(model)

print(torch_model.predict(torch.tensor([[1., 2., 3.]]).double()))

- 最后,可以使用TorchScript保存转换后的模型:

import torch.jit

torch.jit.script(torch_model).save("path.pt")

# 加载模型时不需要安装sk2torch

loaded_model = torch.jit.load("path.pt")

sk2torch的工作原理

sk2torch的核心是对支持的scikit-learn模型进行PyTorch重新实现。对于每个支持的估计器X,sk2torch中都有一个对应的TorchX类。这个类能够读取X的属性,并将它们转换为torch.Tensor或简单的Python类型。TorchX继承自torch.nn.Module,并为X的每个推理API(如predict、decision_function等)提供相应的方法。

目前,sk2torch支持多种常用的scikit-learn模型,包括决策树、随机森林、SVM、线性模型等。用户可以通过supported_classes()函数获取最新的支持列表:

>>> import sk2torch

>>> sk2torch.supported_classes()

[<class 'sklearn.tree._classes.DecisionTreeClassifier'>,

<class 'sklearn.tree._classes.DecisionTreeRegressor'>,

<class 'sklearn.dummy.DummyClassifier'>,

<class 'sklearn.ensemble._gb.GradientBoostingClassifier'>,

<class 'sklearn.preprocessing._label.LabelBinarizer'>,

<class 'sklearn.svm._classes.LinearSVC'>,

<class 'sklearn.svm._classes.LinearSVR'>,

<class 'sklearn.neural_network._multilayer_perceptron.MLPClassifier'>,

<class 'sklearn.kernel_approximation.Nystroem'>,

<class 'sklearn.pipeline.Pipeline'>,

<class 'sklearn.linear_model._stochastic_gradient.SGDClassifier'>,

<class 'sklearn.preprocessing._data.StandardScaler'>,

<class 'sklearn.svm._classes.SVC'>,

<class 'sklearn.svm._classes.NuSVC'>,

<class 'sklearn.svm._classes.SVR'>,

<class 'sklearn.svm._classes.NuSVR'>,

<class 'sklearn.compose._target.TransformedTargetRegressor'>]

sk2torch vs sklearn-onnx

在讨论sk2torch时,不得不提到另一个类似的项目 - sklearn-onnx。sklearn-onnx是一个开源包,用于将训练好的scikit-learn模型转换为ONNX格式。两者都致力于解决模型转换的问题,但有一些关键区别:

-

输出格式: sk2torch输出的是PyTorch模块,而sklearn-onnx输出ONNX格式的模型。

-

功能支持: 由于手动移植的限制,两个库支持的模型和方法集合有所不同。例如,sk2torch支持SVC模型的

predict_proba和predict_log_prob方法,而sklearn-onnx则不支持。 -

灵活性: sk2torch生成的PyTorch模型可以进一步微调、进行梯度反向传播,并以用户友好的方式序列化。相比之下,ONNX格式更侧重于模型部署和跨平台运行。

-

通用性: PyTorch比ONNX更通用,因为PyTorch模型可以在需要时转换为ONNX格式。

图2: PyTorch logo

sk2torch的应用场景

sk2torch在多个领域都有潜在的应用价值:

-

模型优化: 将scikit-learn模型转换为PyTorch模块后,可以利用PyTorch的优化器进行进一步的微调,potentially提升模型性能。

-

迁移学习: 可以将scikit-learn训练的基础模型转换为PyTorch模块,然后在此基础上添加新的层或进行fine-tuning,实现迁移学习。

-

模型集成: 可以将不同的scikit-learn模型转换为PyTorch模块,然后在PyTorch中构建更复杂的集成模型。

-

性能提升: 对于大规模数据集,将模型转换到GPU上运行可以显著提高推理速度。

-

模型部署: 利用TorchScript,可以更方便地将模型部署到生产环境,而无需依赖sk2torch库。

未来展望

sk2torch为机器学习工作流程带来了新的可能性,但仍有改进的空间:

-

扩大支持范围: 继续增加对更多scikit-learn模型和方法的支持。

-

性能优化: 进一步优化转换后模型的性能,使其更接近或超过原生PyTorch实现。

-

自动化测试: 开发更全面的自动化测试suite,确保转换的正确性和一致性。

-

文档和示例: 提供更多详细的文档和实际应用示例,帮助用户更好地理解和使用sk2torch。

-

社区合作: 鼓励更多的开发者参与项目,共同推动sk2torch的发展。

总的来说,sk2torch为机器学习实践者提供了一个强大的工具,使得在scikit-learn和PyTorch之间切换变得更加容易。随着项目的不断发展和完善,我们可以期待看到更多创新的应用案例和工作流程的出现。无论您是数据科学家、研究人员还是机器学习工程师,sk2torch都值得一试,它可能会为您的项目带来意想不到的便利和性能提升。