引言

在线购物的蓬勃发展催生了对虚拟试穿技术的迫切需求。消费者希望能够在购买前直观地看到自己穿着特定服装的效果,这不仅能提高购物体验,还能减少退货率。然而,实现高质量的虚拟试穿并非易事,需要解决诸如服装细节保留、人体姿态适应、光影效果自然等一系列技术挑战。

近日,来自韩国科学技术院(KAIST)的研究团队提出了一种名为StableVITON的创新方法,通过在预训练扩散模型的潜在空间中学习服装和人体之间的语义对应关系,实现了高质量的虚拟试穿效果。该研究成果已被计算机视觉顶级会议CVPR 2024接收,展现了其在学术界和工业界的重要价值。

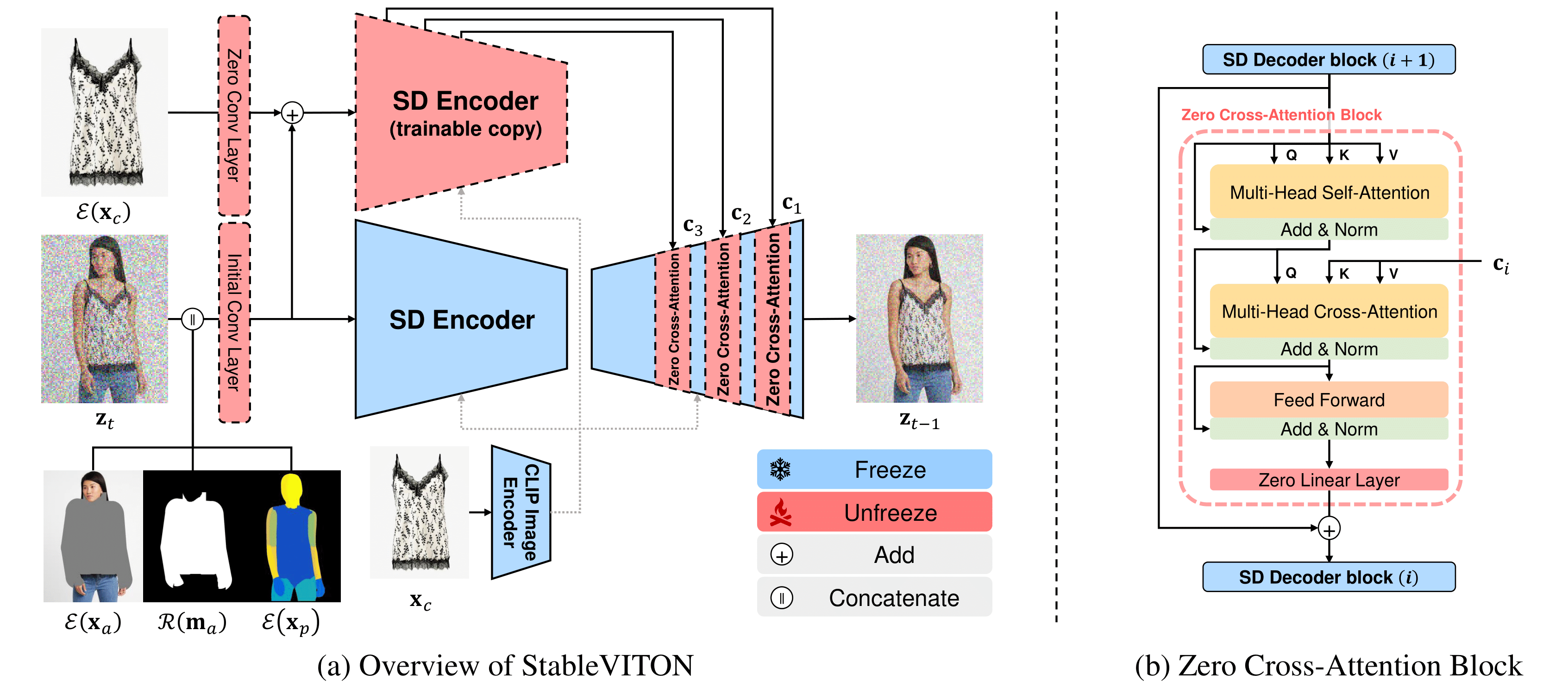

StableVITON的核心思想

StableVITON的核心思想在于充分利用预训练扩散模型的强大生成能力,同时保留服装的细节特征。研究团队提出了以下关键创新:

-

零交叉注意力模块: 通过学习服装和人体之间的语义对应关系,该模块不仅能保留服装细节,还能在变形过程中利用预训练模型的内在知识生成高保真图像。

-

注意力全变分损失: 这种新颖的损失函数能够生成清晰的注意力图,从而更精确地表现服装细节。

-

数据增强策略: 通过应用适当的数据增强技术,进一步提高了模型的泛化能力和鲁棒性。

这些创新使得StableVITON能够在保留服装细节的同时,生成自然逼真的试穿图像,即使面对复杂背景的图像输入也能取得良好效果。

技术实现

StableVITON的实现基于预训练的潜在扩散模型。在虚拟试穿任务中,模型接收三个额外的条件输入:无关人体图、无关人体遮罩和密集姿态图。这些输入作为预训练U-Net的查询(Q),而服装特征图则用作交叉注意力的键(K)和值(V)。

潜在空间中的注意力机制通过激活与服装对齐相对应的每个标记,实现了基于补丁的变形。此外,为了进一步锐化注意力图,研究团队提出了创新的注意力全变分损失,并应用了数据增强技术,这些措施显著改善了服装细节的保留效果。

通过不损害预训练扩散模型的方式,StableVITON能够仅使用现有的虚拟试穿数据集,就能生成高质量的图像,即使在处理复杂背景的图像时也能取得出色效果。

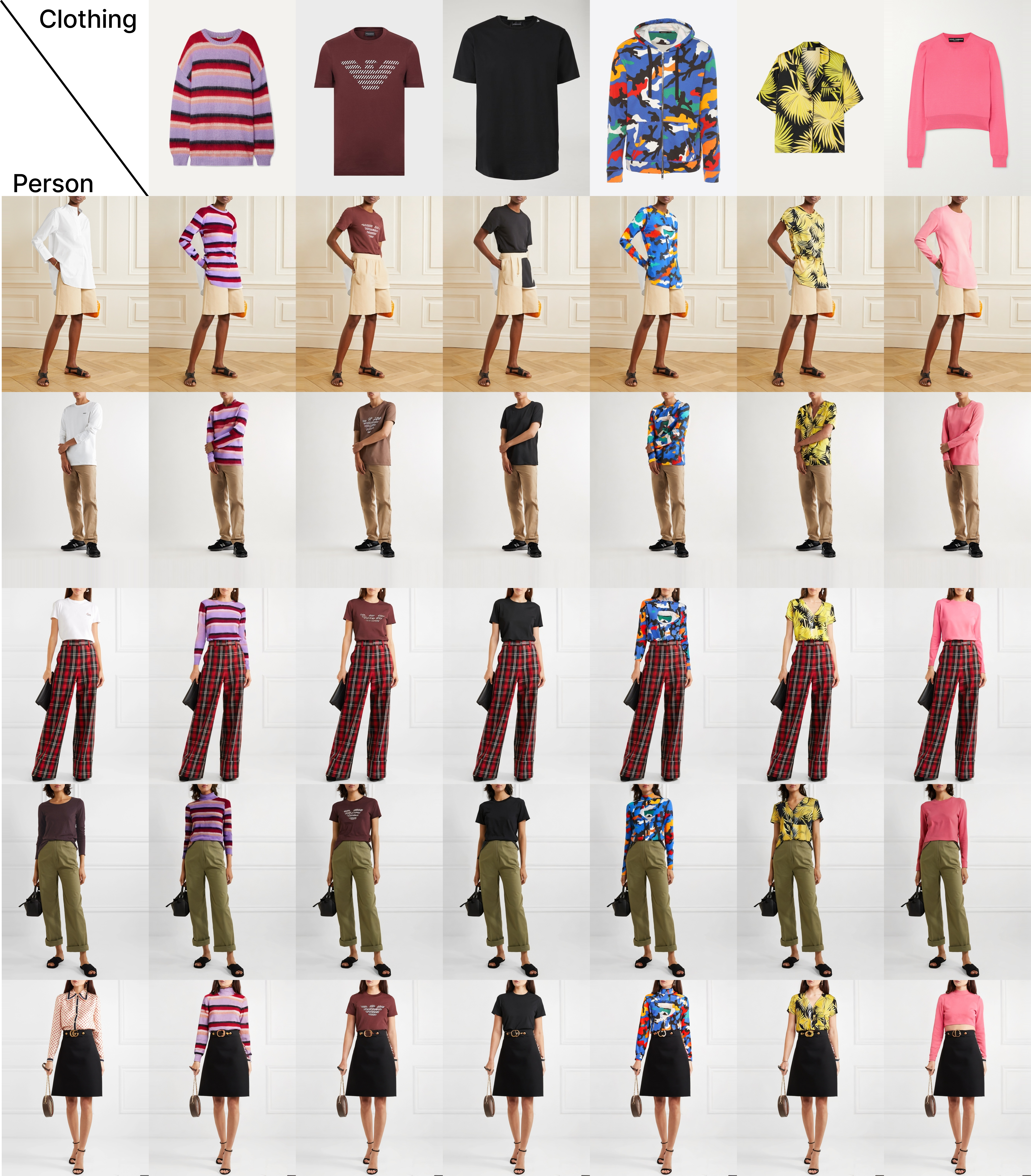

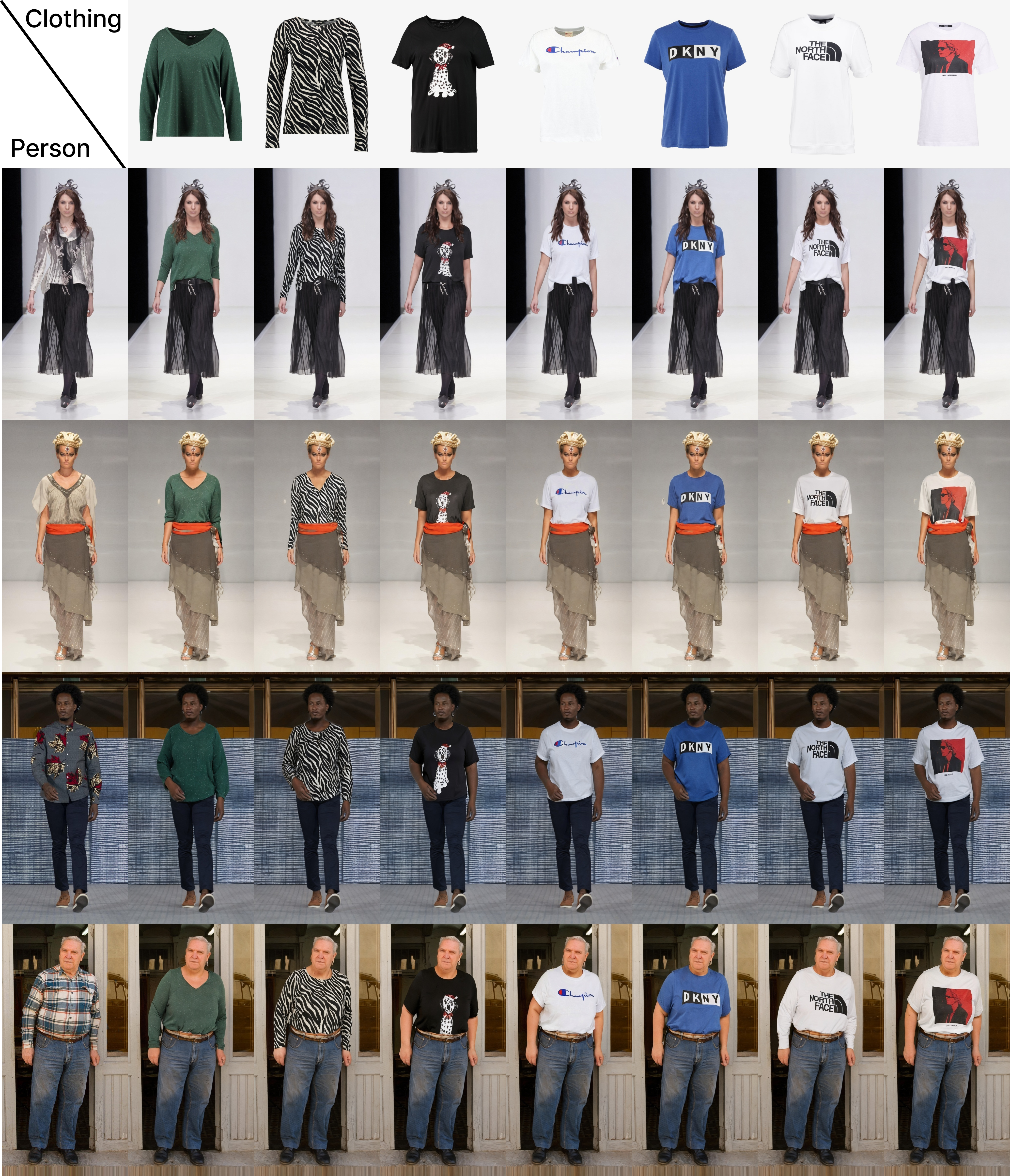

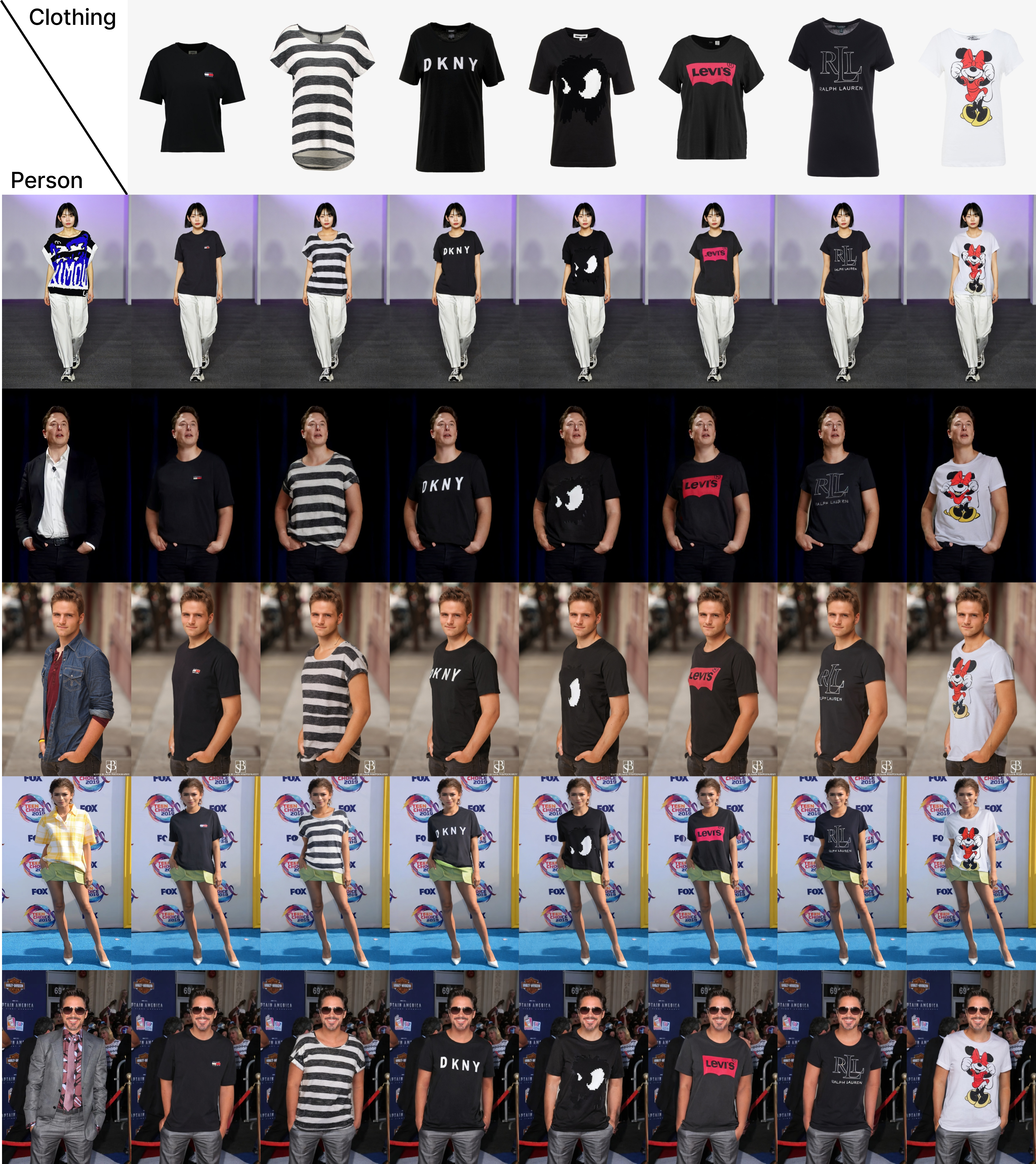

实验结果

研究团队在多个数据集上进行了广泛的实验,包括VITON-HD、DressCode、SHHQ-1.0以及网络爬取的图像。所有生成的结果均使用在VITON-HD训练集上训练的StableVITON模型产生。实验结果展示了StableVITON在不同场景下的优秀表现:

-

VITON-HD数据集:

-

DressCode数据集:

-

SHHQ-1.0数据集:

-

网络爬取图像:

这些结果充分展示了StableVITON在各种场景下的卓越性能,无论是标准数据集还是真实世界的图像,都能生成高质量、自然逼真的虚拟试穿结果。

技术细节与实现

环境配置

StableVITON的实现基于Python环境,主要依赖包括PyTorch、pytorch-lightning、einops、opencv-python等。研究团队提供了详细的环境配置指南,确保其他研究者和开发者能够轻松复现实验结果。

数据预处理

虽然VITON-HD数据集提供了基准和无关人体遮罩,但StableVITON的设计允许在任意图像上进行虚拟试穿。研究团队建议使用诸如SAM(Segment Anything Model)等分割工具来处理自定义图像,以生成所需的无关人体遮罩和密集姿态图。

模型训练

StableVITON的训练过程分为两个阶段:

-

基础模型训练:

CUDA_VISIBLE_DEVICES=3,4 python train.py \ --config_name VITONHD \ --transform_size shiftscale3 hflip \ --transform_color hsv bright_contrast \ --save_name Base_test -

ATV损失微调:

CUDA_VISIBLE_DEVICES=5,6 python train.py \ --config_name VITONHD \ --transform_size shiftscale3 hflip \ --transform_color hsv bright_contrast \ --use_atv_loss \ --resume_path <first stage model path> \ --save_name ATVloss_test

这种两阶段训练策略能够有效提高模型性能,尤其是在保留服装细节方面。

推理过程

StableVITON支持多种推理模式,包括配对、非配对、重绘等:

# 配对推理

CUDA_VISIBLE_DEVICES=4 python inference.py \

--config_path ./configs/VITONHD.yaml \

--batch_size 4 \

--model_load_path <model weight path> \

--save_dir <save directory>

# 非配对推理

CUDA_VISIBLE_DEVICES=4 python inference.py \

--config_path ./configs/VITONHD.yaml \

--batch_size 4 \

--model_load_path <model weight path> \

--unpair \

--save_dir <save directory>

这种灵活的推理机制使StableVITON能够适应各种实际应用场景。

应用前景

StableVITON的出现为虚拟试穿技术带来了新的可能性,其潜在应用领域广泛:

-

在线购物平台: 电商网站可以集成StableVITON,为用户提供更真实的虚拟试穿体验,提高购物转化率。

-

时尚设计: 设计师可以快速visualize其设计在不同体型、肤色的模特身上的效果,加速创作过程。

-

个人造型顾问: 结合AI技术,StableVITON可以成为智能造型顾问系统的核心,为用户推荐最适合的服装搭配。

-

增强现实(AR)应用: 将StableVITON与AR技术结合,可以创造出更加沉浸式的虚拟试衣间体验。

-

社交媒体滤镜: 社交平台可以基于StableVITON开发有趣的虚拟换装滤镜,增加用户互动。

未来展望

尽管StableVITON在虚拟试穿领域取得了显著进展,但仍有一些值得探索的方向:

-

实时性能优化: 进一步提高模型的推理速度,以满足实时应用的需求。

-

多视角生成: 扩展模型能力,支持从不同角度生成试穿效果。

-

动态姿势适应: 增强模型对复杂人体姿势的适应能力,生成更自然的试穿效果。

-

个性化定制: 融入用户偏好学习,实现更个性化的虚拟试穿推荐。

-

跨模态集成: 结合文本描述、语音指令等多模态输入,提供更丰富的交互方式。

结语

StableVITON作为一种创新的虚拟试穿技术,通过巧妙利用预训练扩散模型的潜在空间,实现了高质量、自然逼真的虚拟试穿效果。它不仅在学术界展现了重要价值,也为电商、时尚、AR等多个行业带来了新的机遇。随着技术的不断优化和应用场景的拓展,StableVITON有望成为推动虚拟试穿技术发展的重要力量,为消费者带来更便捷、更个性化的购物体验。

研究团队已开源了StableVITON的代码实现,欢迎感兴趣的研究者和开发者访问GitHub仓库进行探索和贡献。让我们共同期待StableVITON在未来带来更多激动人心的应用和突破!