Xinference:强大而灵活的推理服务框架

Xinference是一个功能强大、用途广泛的库,旨在为语言、语音识别和多模态模型提供服务。它允许用户只需一个命令就能轻松部署和服务最先进的内置模型或自定义模型,为研究人员、开发人员和数据科学家提供了充分发挥尖端AI模型潜力的能力。

主要特性

🌟 简化模型服务: Xinference极大地简化了大型语言模型、语音识别模型和多模态模型的服务过程。用户只需一个命令即可设置和部署模型,无论是用于实验还是生产环境。

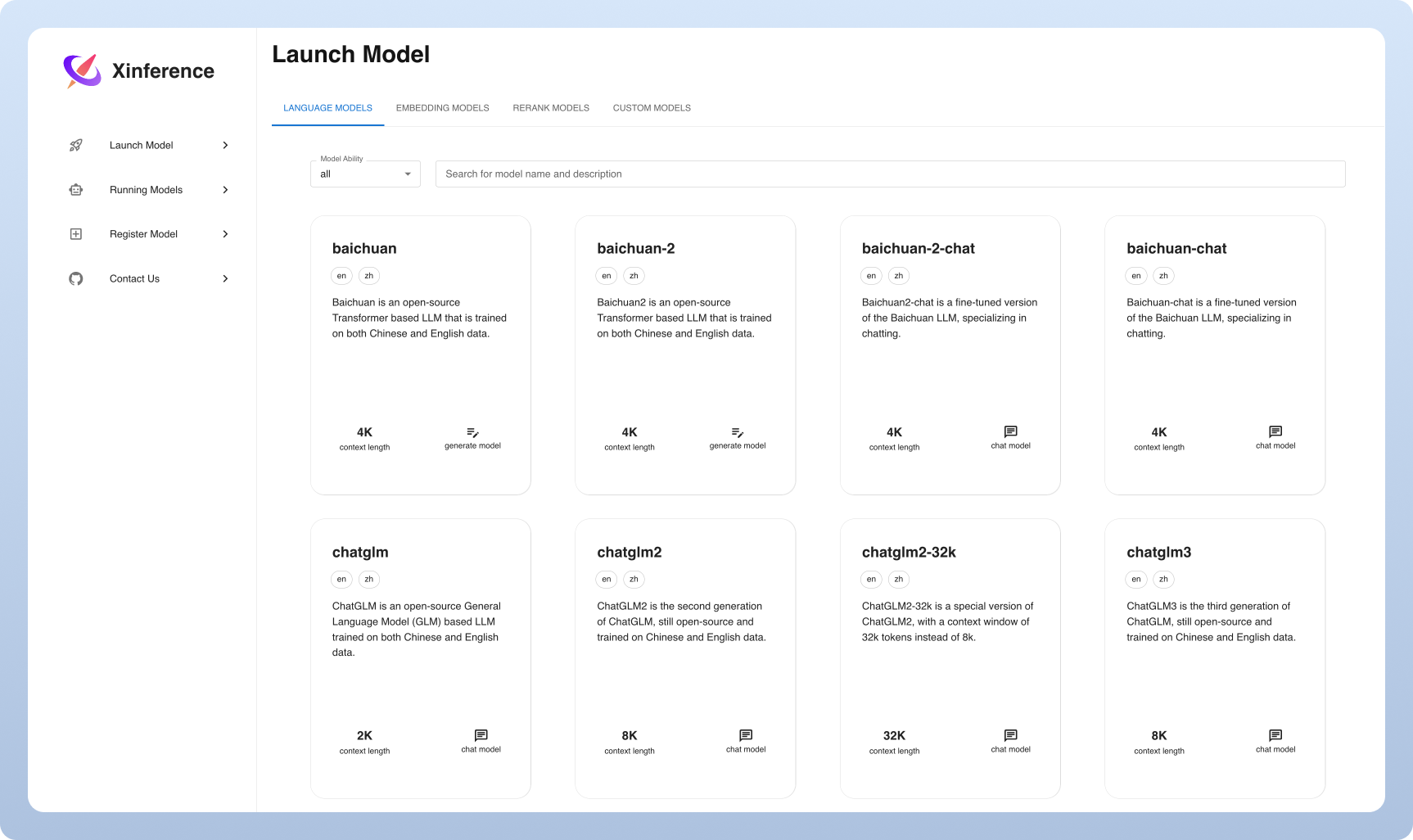

⚡️ 最先进的内置模型: Xinference提供了对最新开源模型的访问,用户可以通过单个命令轻松尝试这些尖端模型。

🖥 异构硬件利用: 借助ggml技术,Xinference能够智能地利用GPU和CPU等异构硬件资源,加速模型推理任务。

⚙️ 灵活的API和接口: Xinference提供了多种与模型交互的接口,包括兼容OpenAI的RESTful API(支持函数调用)、RPC、命令行界面和Web UI,实现了无缝的模型管理和交互。

🌐 分布式部署: Xinference在分布式部署场景中表现出色,允许跨多个设备或机器无缝分配模型推理任务。

🔌 内置第三方库集成: Xinference无缝集成了流行的第三方库,包括LangChain、LlamaIndex、Dify和Chatbox。

为什么选择Xinference?

Xinference相比其他类似框架如FastChat、OpenLLM和RayLLM,具有以下优势:

- 支持更多推理引擎(如GGML、TensorRT)

- 支持更多平台(包括CPU和Apple Metal)

- 支持多节点集群部署

- 支持图像生成模型

- 支持文本嵌入模型

- 支持多模态模型

- 支持音频模型

- 支持更多OpenAI功能(如函数调用)

快速开始

- 通过pip安装Xinference:

pip install "xinference[all]"

- 启动本地Xinference实例:

xinference-local

- 通过Web UI、cURL、命令行或Python客户端与Xinference交互。

参与贡献

- 在GitHub Issues报告bug或提出功能请求

- 加入Slack社区与其他Xinference用户交流

- 关注Twitter获取最新功能更新

Xinference为AI模型服务提供了一个强大而灵活的框架,无论是个人开发者还是大型组织,都能从中受益。它简化了模型部署和服务的过程,同时提供了丰富的功能和广泛的模型支持。随着AI技术的不断发展,Xinference将继续evolve,为用户提供最先进的模型服务能力。