DLPack简介

DLPack是一个开放的内存张量结构标准,旨在实现深度学习框架之间的张量共享和互操作。它为深度学习生态系统提供了一个通用的桥梁,使得不同框架可以更轻松地共享操作和后端实现。

DLPack的主要目标包括:

- 简化深度学习框架之间操作符的共享

- 便于封装供应商级别的算子实现,促进新设备/算子引入时的合作

- 快速切换后端实现,如不同版本的BLAS

- 为最终用户带来更多可用的算子,并实现框架间的混合使用

值得注意的是,DLPack本身并不实现张量和操作,而是作为一个共同的桥梁来跨框架重用张量和操作。

DLPack的核心功能

1. 统一的内存张量表示

DLPack定义了一个统一的内存张量结构,包括:

- 数据类型(如float32, int64等)

- 设备信息(CPU, GPU等)

- 形状和步长

- 数据指针

这种统一的表示使得不同框架可以无缝地共享张量数据,而无需进行昂贵的数据复制。

2. 跨框架数据交换

DLPack提供了一种标准化的方法来在不同的深度学习框架之间交换张量数据。这通常通过以下步骤实现:

- 导出框架将张量打包成DLPack格式

- 将DLPack数据传递给导入框架

- 导入框架从DLPack格式创建自己的张量对象

这个过程通常是零拷贝的,意味着不需要额外的内存分配或数据移动。

3. 设备无关性

DLPack设计为设备无关的,支持多种计算设备,包括:

- CPU

- CUDA GPU

- OpenCL设备

- ROCm (AMD GPU)

- Vulkan

- Metal (Apple GPU)

- OneAPI (Intel GPU)

这种灵活性使得DLPack能够在各种硬件平台上实现框架间的互操作。

DLPack的实现细节

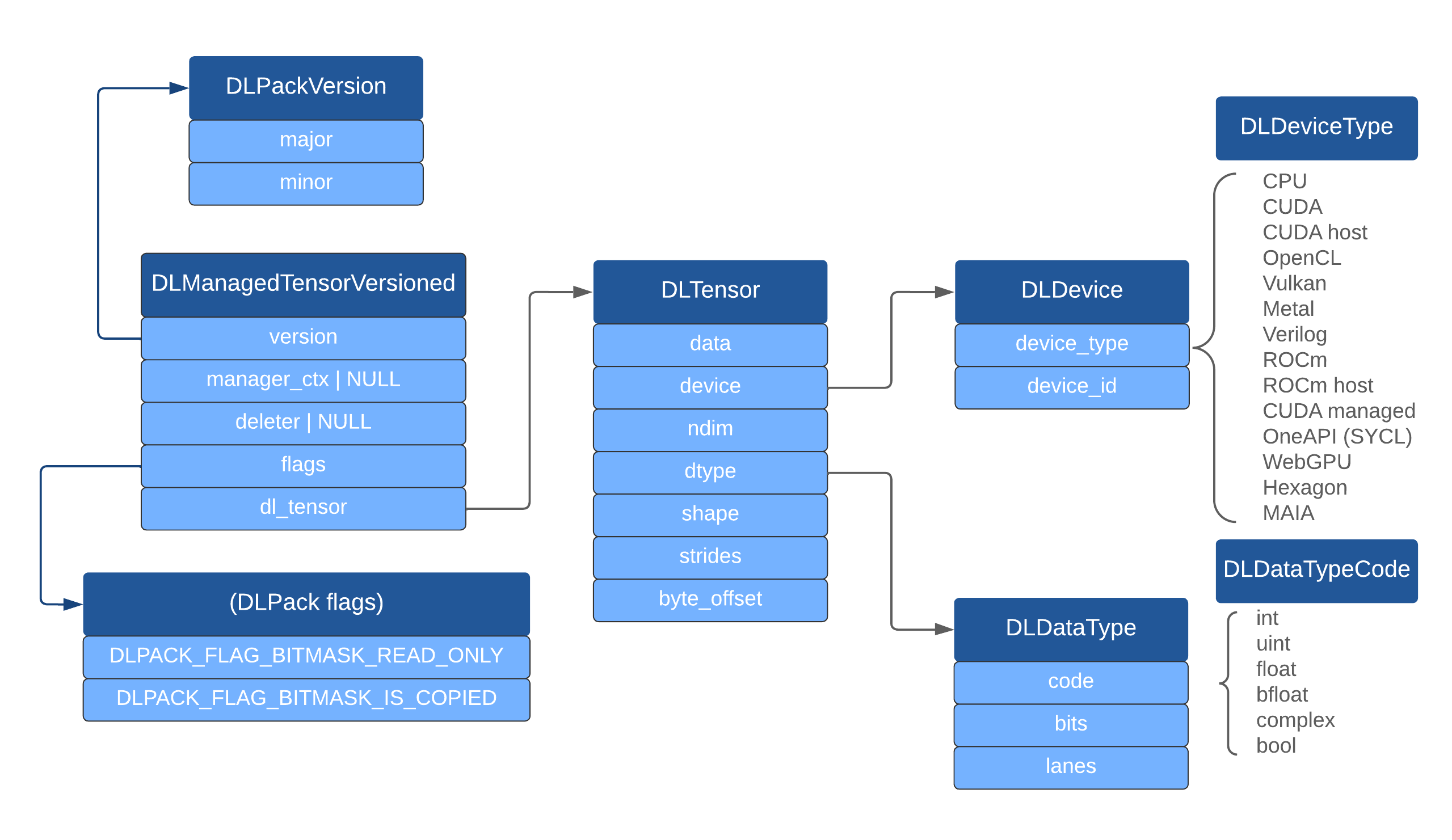

DLPack的核心是一组C语言结构体和枚举类型,定义在dlpack.h头文件中。主要的结构包括:

DLDataType: 描述张量的数据类型DLDevice: 指定张量所在的设备DLTensor: 表示张量的主要结构,包含数据指针、形状、步长等信息DLManagedTensor: 包装DLTensor,并添加额外的内存管理信息

使用这些结构,框架可以轻松地将自己的张量表示转换为DLPack格式,或从DLPack格式创建张量。

Python接口

为了方便Python用户使用DLPack,许多框架都实现了Python绑定。典型的用法如下:

import torch

import numpy as np

# 创建一个PyTorch张量

torch_tensor = torch.arange(4)

# 将PyTorch张量转换为NumPy数组,使用DLPack

numpy_array = np.from_dlpack(torch_tensor)

print(numpy_array) # 输出: [0 1 2 3]

# 修改NumPy数组

numpy_array[0] = 100

# 查看PyTorch张量,可以看到数据已经被修改

print(torch_tensor) # 输出: tensor([100, 1, 2, 3])

这个例子展示了如何使用DLPack在PyTorch和NumPy之间无缝传递数据,而不需要进行数据复制。

DLPack的优势

-

性能提升: 通过避免不必要的数据复制,DLPack可以显著提高跨框架操作的性能。

-

内存效率: 零拷贝数据交换意味着更低的内存使用。

-

灵活性: 开发者可以更容易地混合使用不同框架的功能。

-

生态系统协作: DLPack促进了深度学习生态系统的协作,使得不同框架可以更好地互操作。

-

硬件支持: 广泛的设备支持使得DLPack在各种硬件平台上都能发挥作用。

DLPack的采用情况

目前,许多主流的深度学习框架和科学计算库都已经支持DLPack,包括:

- PyTorch

- TensorFlow

- MXNet

- NumPy

- CuPy

- JAX

- ONNX Runtime

这广泛的采用使得DLPack成为了深度学习生态系统中事实上的标准接口。

未来展望

随着深度学习领域的不断发展,DLPack也在持续演进。一些未来的发展方向包括:

- 支持更多的数据类型和设备

- 改进内存管理和同步机制

- 扩展对更复杂张量结构的支持(如稀疏张量)

- 进一步优化性能和减少开销

结论

DLPack作为一个开放的内存张量结构标准,正在为深度学习生态系统带来更好的互操作性和效率。通过提供一个统一的接口,它使得不同框架之间的数据交换变得简单和高效。随着越来越多的框架采用DLPack,我们可以期待看到更多创新的跨框架应用和工具的出现,进一步推动深度学习技术的发展。

对于研究人员和开发者来说,了解和使用DLPack可以带来更大的灵活性,允许他们充分利用不同框架的优势,而不必被单一框架所限制。随着DLPack的不断发展和完善,它将继续在深度学习生态系统中发挥重要作用,促进框架间的协作和创新。