LLM-Guard简介

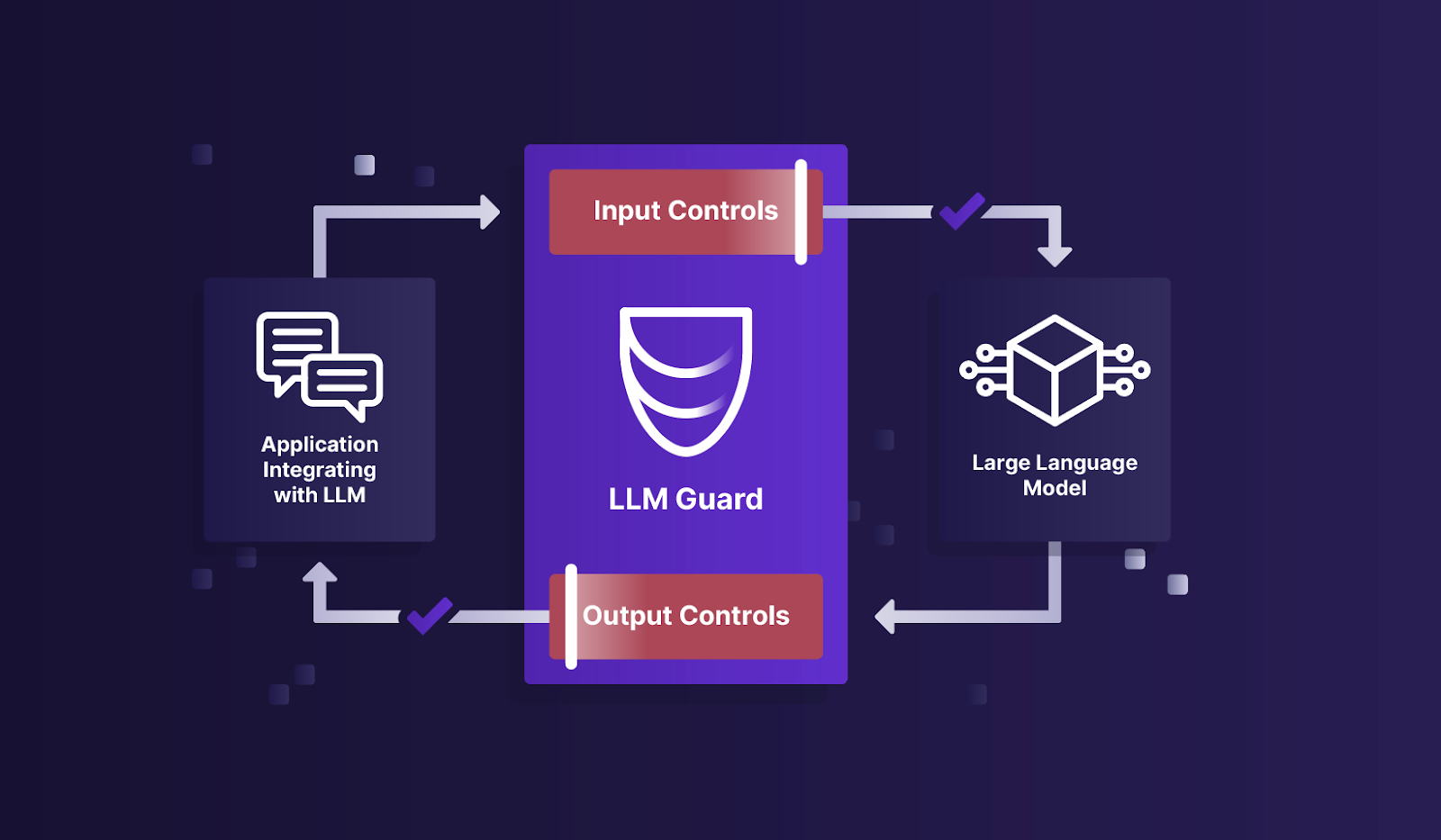

LLM-Guard是由Protect AI开发的一个开源工具,旨在增强大型语言模型(LLM)的安全性。它提供了一系列功能,包括:

- 输入净化

- 有害语言检测

- 数据泄露防护

- 抵御提示注入攻击

通过这些措施,LLM-Guard确保了与LLM的交互更加安全可靠。

快速开始

- 安装LLM-Guard:

pip install llm-guard

- 基本使用示例:

from llm_guard.input_scanners import PromptInjection

from llm_guard.input_scanners.prompt_injection import MatchType

scanner = PromptInjection(threshold=0.5, match_type=MatchType.FULL)

sanitized_prompt, is_valid, risk_score = scanner.scan(prompt)

主要功能

LLM-Guard提供了多种扫描器,分为输入扫描器和输出扫描器两大类:

输入扫描器

- Anonymize - 匿名化

- BanCode - 禁止代码

- PromptInjection - 提示注入检测

- Secrets - 敏感信息检测

- Toxicity - 有害内容检测

- 等

输出扫描器

- Deanonymize - 去匿名化

- FactualConsistency - 事实一致性检查

- MaliciousURLs - 恶意URL检测

- Relevance - 相关性检查

- Sensitive - 敏感信息检测

- 等

学习资源

- 官方文档 - 详细了解LLM-Guard的使用方法和各个功能

- GitHub仓库 - 源代码和最新更新

- 在线演示 - 体验LLM-Guard的功能

- ChatGPT集成示例 - 学习如何将LLM-Guard与ChatGPT结合使用

- API部署指南 - 了解如何将LLM-Guard部署为API服务

社区支持

LLM-Guard是一个开源项目,欢迎社区贡献:

- 在GitHub Issues提交bug或功能建议

- 查看贡献指南参与项目开发

- 加入Slack社区讨论LLM安全相关话题

总结

LLM-Guard为开发者提供了一套全面的工具,以增强LLM应用的安全性。通过本文提供的学习资源,读者可以快速上手LLM-Guard,并将其应用到自己的LLM项目中,提高模型交互的安全性和可靠性。

无论你是刚接触LLM安全,还是已经有相关经验的开发者,LLM-Guard都是一个值得深入学习和使用的开源工具。开始你的LLM安全之旅吧! 🛡️🤖