Depth Anything V2简介

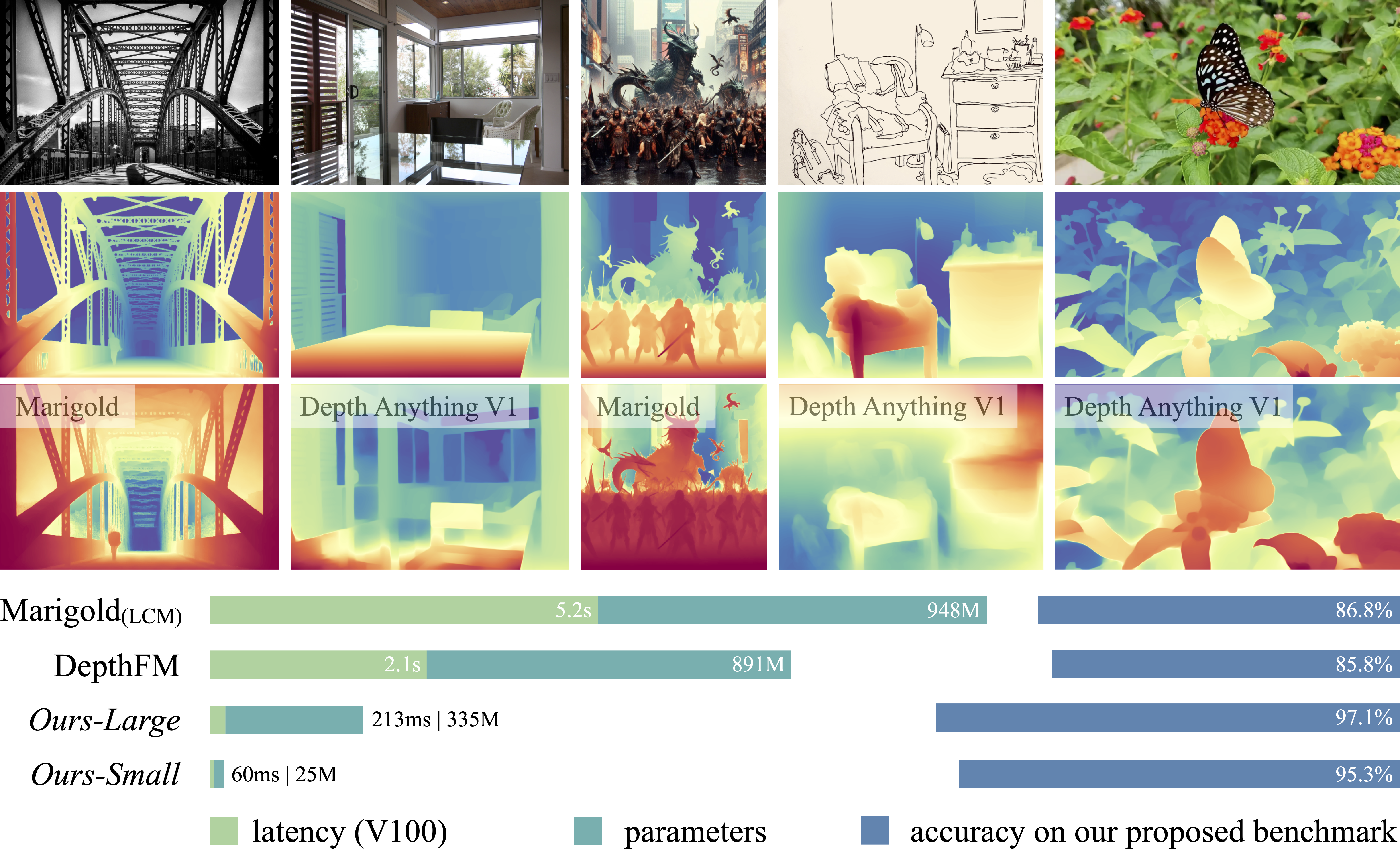

Depth Anything V2是一个用于单目深度估计的最新基础模型。它是Depth Anything系列的第二个版本,在细节表现和鲁棒性方面都有显著提升。与基于稳定扩散(SD)的模型相比,Depth Anything V2具有更快的推理速度、更少的参数量和更高的深度精度。

这个模型由来自多所知名大学和研究机构的研究人员共同开发,包括杨立和、康炳义、黄子龙、赵臻、徐晓刚、冯佳时和赵恒双等。他们的目标是打造一个强大而实用的单目深度估计解决方案。

主要特点和优势

Depth Anything V2相比前一个版本有以下几个显著的改进:

-

细节表现更出色:能够捕捉到更精细的场景深度信息。

-

鲁棒性更强:对各种复杂场景都有良好的适应性。

-

推理速度更快:相比基于SD的模型,推理速度有明显提升。

-

参数量更少:模型更加轻量化,便于部署。

-

深度精度更高:估计结果更加准确可靠。

这些优势使得Depth Anything V2在实际应用中具有很大的潜力。无论是在计算机视觉研究还是工业应用中,它都可以发挥重要作用。

模型版本和使用

Depth Anything V2提供了4种不同规模的预训练模型,以适应不同的应用需求:

- Depth-Anything-V2-Small: 24.8M参数

- Depth-Anything-V2-Base: 97.5M参数

- Depth-Anything-V2-Large: 335.3M参数

- Depth-Anything-V2-Giant: 1.3B参数(即将推出)

用户可以根据自己的需求选择合适的模型版本。较小的模型适合资源受限的场景,而较大的模型则可以提供更高的精度。

使用Depth Anything V2非常简单,只需几行代码就可以完成深度估计:

from transformers import pipeline

from PIL import Image

pipe = pipeline(task="depth-estimation", model="depth-anything/Depth-Anything-V2-Small-hf")

image = Image.open('your/image/path')

depth = pipe(image)["depth"]

这种简单的使用方式使得Depth Anything V2可以被广泛应用于各种项目中。

应用场景

Depth Anything V2在多个领域都有潜在的应用价值:

-

自动驾驶:准确的深度信息对自动驾驶系统至关重要。

-

增强现实(AR):可以帮助AR应用更好地理解真实世界的深度结构。

-

机器人视觉:使机器人能够更准确地感知环境中物体的距离。

-

3D重建:可以从单张2D图像中重建3D场景。

-

计算摄影:用于实现各种深度相关的图像效果。

-

视频制作:辅助实现景深效果、3D转换等。

这些应用场景都体现了Depth Anything V2作为一个强大基础模型的价值。

社区支持和扩展

Depth Anything系列得到了广泛的社区支持,已经被集成到多个流行的机器学习框架和工具中:

- 已集成到Apple Core ML Models中

- 支持在Transformers库中使用

- 提供TensorRT和ONNX版本以加速推理

- 可在ComfyUI中使用

- 支持在网页中实时估计深度

- 提供Android版本

这种广泛的支持使得Depth Anything V2可以在各种平台和设备上运行,极大地扩展了它的应用范围。

未来展望

Depth Anything V2的发布标志着单目深度估计技术又向前迈进了一大步。随着模型的进一步优化和应用的不断拓展,我们可以期待看到:

- 更高精度的深度估计结果

- 在更多领域的实际应用

- 与其他AI技术的结合,产生新的创新

- 在边缘设备上的高效运行

深度估计技术的进步将为计算机视觉和人工智能带来更多可能性,Depth Anything V2无疑是这一进程中的重要里程碑。

结语

Depth Anything V2作为一个强大的单目深度估计基础模型,展现了深度学习在计算机视觉领域的latest进展。它不仅在技术上有显著突破,更重要的是为众多应用场景提供了可能性。随着这项技术的不断发展和应用,我们可以期待看到更多令人兴奋的创新出现。

无论你是研究人员、开发者还是对计算机视觉感兴趣的爱好者,都值得关注Depth Anything V2的发展。它代表了视觉AI的未来方向,也为我们理解和重建3D世界提供了强大工具。让我们共同期待Depth Anything系列在未来带来更多惊喜!