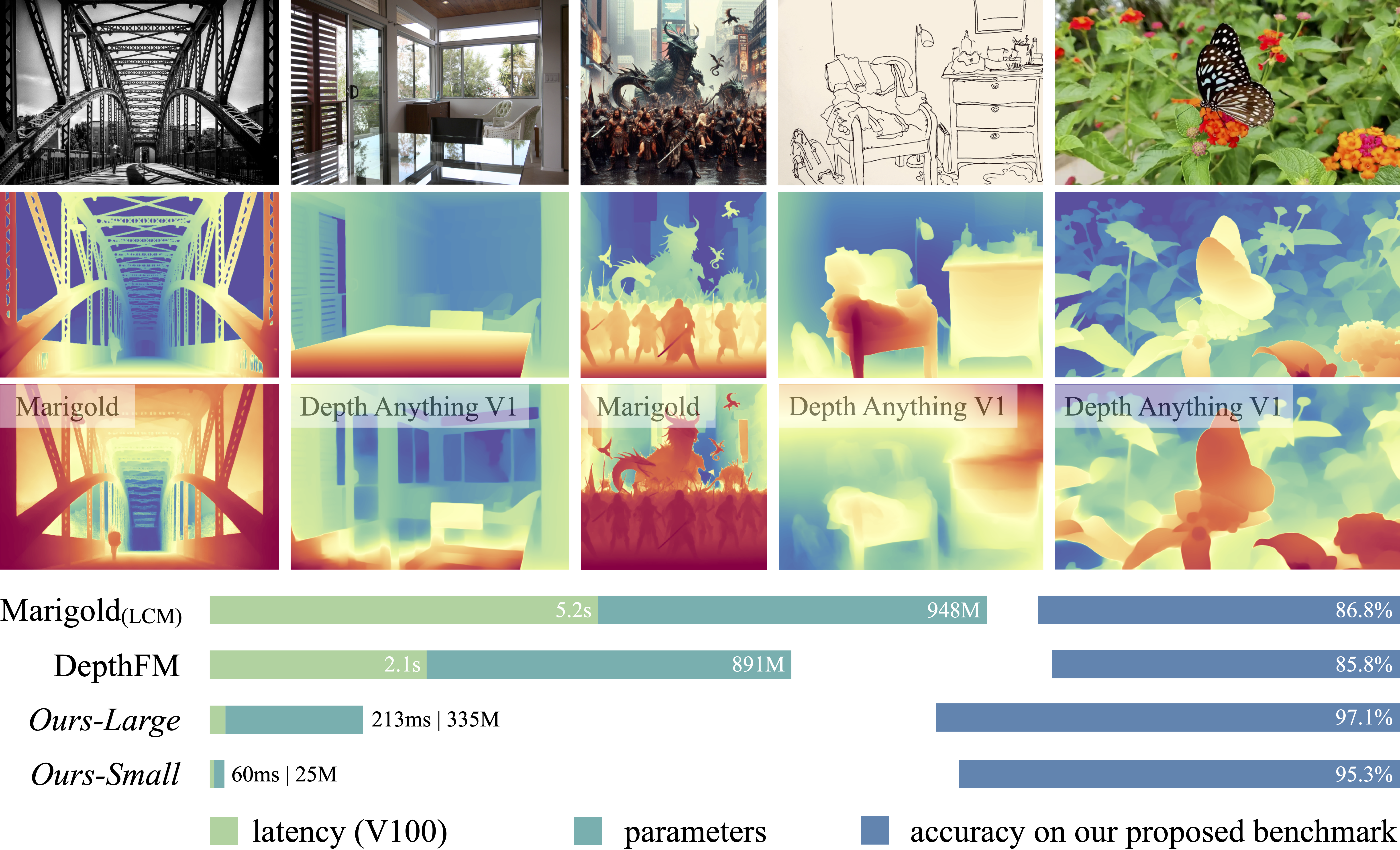

本文介绍了Depth Anything V2。与V1相比,它在细节处理和鲁棒性方面有显著提升。相比于基于SD的模型,它具有更快的推理速度、更少的参数量和更高的深度精度。

新闻

- 2024年7月6日: Depth Anything V2已在Transformers中得到支持。请参阅使用说明以方便使用。

- 2024年6月25日: Depth Anything已集成到Apple Core ML Models中。请参阅使用说明(V1,V2)。

- 2024年6月22日: 我们发布了基于Depth-Anything-V2-Small和Base的较小的度量深度模型。

- 2024年6月20日: 我们的仓库和项目页面被GitHub标记并从公众视野中移除了6天。对此造成的不便我们深表歉意。

- 2024年6月14日: 论文、项目页面、代码、模型、演示和基准测试全部发布。

预训练模型

我们提供了四个不同规模的模型用于稳健的相对深度估计:

| 模型 | 参数量 | 检查点 |

|---|---|---|

| Depth-Anything-V2-Small | 24.8M | 下载 |

| Depth-Anything-V2-Base | 97.5M | 下载 |

| Depth-Anything-V2-Large | 335.3M | 下载 |

| Depth-Anything-V2-Giant | 1.3B | 即将推出 |

使用方法

准备工作

git clone https://github.com/DepthAnything/Depth-Anything-V2

cd Depth-Anything-V2

pip install -r requirements.txt

下载这里列出的检查点并将它们放在checkpoints目录下。

使用我们的模型

import cv2

import torch

from depth_anything_v2.dpt import DepthAnythingV2

DEVICE = 'cuda' if torch.cuda.is_available() else 'mps' if torch.backends.mps.is_available() else 'cpu'

model_configs = {

'vits': {'encoder': 'vits', 'features': 64, 'out_channels': [48, 96, 192, 384]},

'vitb': {'encoder': 'vitb', 'features': 128, 'out_channels': [96, 192, 384, 768]},

'vitl': {'encoder': 'vitl', 'features': 256, 'out_channels': [256, 512, 1024, 1024]},

'vitg': {'encoder': 'vitg', 'features': 384, 'out_channels': [1536, 1536, 1536, 1536]}

}

encoder = 'vitl' # 或 'vits', 'vitb', 'vitg'

model = DepthAnythingV2(**model_configs[encoder])

model.load_state_dict(torch.load(f'checkpoints/depth_anything_v2_{encoder}.pth', map_location='cpu'))

model = model.to(DEVICE).eval()

raw_img = cv2.imread('你的图像路径')

depth = model.infer_image(raw_img) # HxW 原始深度图(numpy格式)

如果你不想克隆这个仓库,你也可以通过Transformers加载我们的模型。以下是一个简单的代码片段。更多详情请参考官方页面。

- 注意1:确保你能连接到Hugging Face并已安装最新版的Transformers。

- 注意2:由于OpenCV(我们使用的)和Pillow(HF使用的)之间的上采样差异,预测结果可能会略有不同。因此,我们更推荐你通过上面介绍的方式使用我们的模型。

from transformers import pipeline

from PIL import Image

pipe = pipeline(task="depth-estimation", model="depth-anything/Depth-Anything-V2-Small-hf")

image = Image.open('你的图像路径')

depth = pipe(image)["depth"]

在图像上运行脚本

python run.py \

--encoder <vits | vitb | vitl | vitg> \

--img-path <路径> --outdir <输出目录> \

[--input-size <大小>] [--pred-only] [--grayscale]

选项:

--img-path: 你可以1)指向存储所有感兴趣图像的目录,2)指向单张图像,或3)指向存储所有图像路径的文本文件。--input-size(可选):默认情况下,我们使用输入大小518进行模型推理。你可以增加大小以获得更加精细的结果。--pred-only(可选):仅保存预测的深度图,不保存原始图像。--grayscale(可选):保存灰度深度图,不应用色彩调色板。

例如:

python run.py --encoder vitl --img-path assets/examples --outdir depth_vis

在视频上运行脚本

python run_video.py \

--encoder <vits | vitb | vitl | vitg> \

--video-path assets/examples_video --outdir video_depth_vis \

[--input-size <大小>] [--pred-only] [--grayscale]

我们的更大模型在视频上有更好的时间一致性。

Gradio演示

要在本地使用我们的Gradio演示:

python app.py

你也可以尝试我们的在线演示。

注意:相比V1,我们对DINOv2-DPT架构做了一个小修改(源自这个问题)。 在V1中,我们无意中使用了DINOv2最后四层的特征进行解码。在V2中,我们改为使用中间特征。尽管这个修改并未改善细节或准确性,但我们决定遵循这一常见做法。

微调到度量深度估计

请参考度量深度估计。

DA-2K评估基准

请参考DA-2K基准。

社区支持

我们衷心感谢社区对我们Depth Anything系列的所有支持。非常感谢!

- Apple Core ML:

- Transformers:

- TensorRT:

- ONNX: https://github.com/fabio-sim/Depth-Anything-ONNX

- ComfyUI: https://github.com/kijai/ComfyUI-DepthAnythingV2

- Transformers.js(网页实时深度): https://huggingface.co/spaces/Xenova/webgpu-realtime-depth-estimation

- Android:

致谢

我们衷心感谢出色的Hugging Face团队(@Pedro Cuenca、@Niels Rogge、@Merve Noyan、@Amy Roberts等)在Transformers和Apple Core ML中支持我们模型的巨大努力。

我们还要感谢DINOv2团队为我们的社区贡献了如此令人印象深刻的模型。

许可证

Depth-Anything-V2-Small模型使用Apache-2.0许可证。Depth-Anything-V2-Base/Large/Giant模型使用CC-BY-NC-4.0许可证。

引用

如果您发现这个项目有用,请考虑引用:

@article{depth_anything_v2,

title={Depth Anything V2},

author={Yang, Lihe and Kang, Bingyi and Huang, Zilong and Zhao, Zhen and Xu, Xiaogang and Feng, Jiashi and Zhao, Hengshuang},

journal={arXiv:2406.09414},

year={2024}

}

@inproceedings{depth_anything_v1,

title={Depth Anything: Unleashing the Power of Large-Scale Unlabeled Data},

author={Yang, Lihe and Kang, Bingyi and Huang, Zilong and Xu, Xiaogang and Feng, Jiashi and Zhao, Hengshuang},

booktitle={CVPR},

year={2024}

}

访问官网

访问官网 Github

Github Huggingface

Huggingface 文档

文档 论文

论文